Karpathy最新四小时视频教程:从零复现GPT-2,通宵运行即搞定

Karpathy最新四小时视频教程:从零复现GPT-2,通宵运行即搞定AI 大牛 Andrej Karpathy 又「上新」了,这次一口气放出了长达四个小时的视频。

AI 大牛 Andrej Karpathy 又「上新」了,这次一口气放出了长达四个小时的视频。

大神Karpathy已经不满足于用C语言造Llama了! 他给自己的最新挑战:复现OpenAI经典成果,从基础版GPT-2开始。

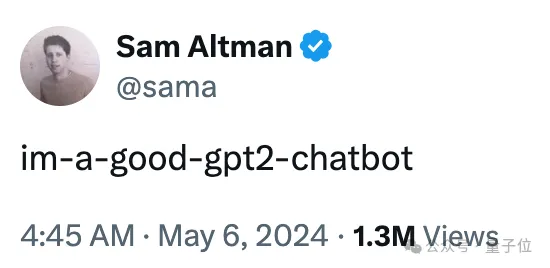

OpenAI正在秘密A/B测试下一代模型,实力超强被怀疑是GPT-4.5或GPT-5。

答案揭晓了! 「神秘gpt2-chatbot不是GPT-4.5」。

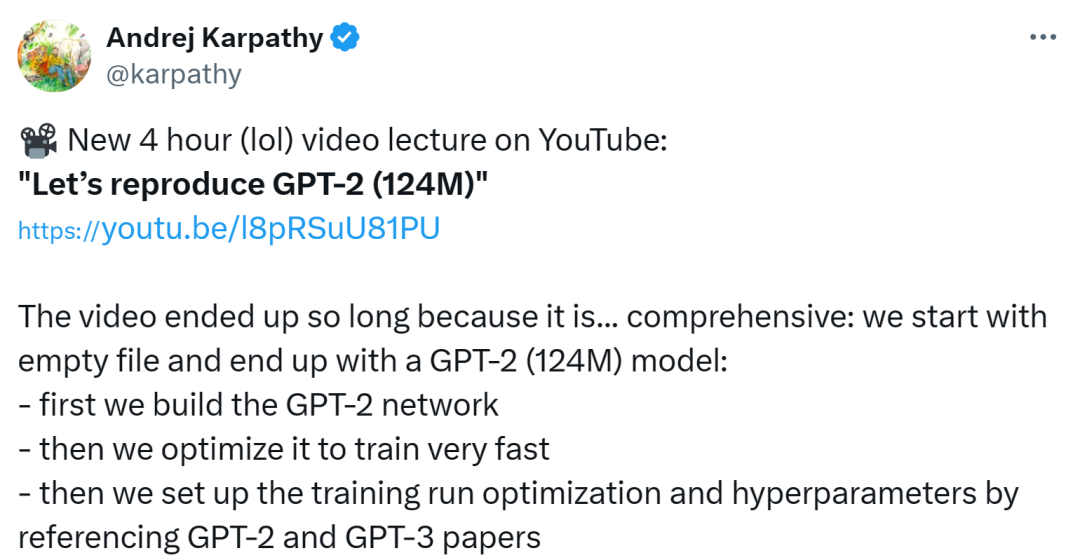

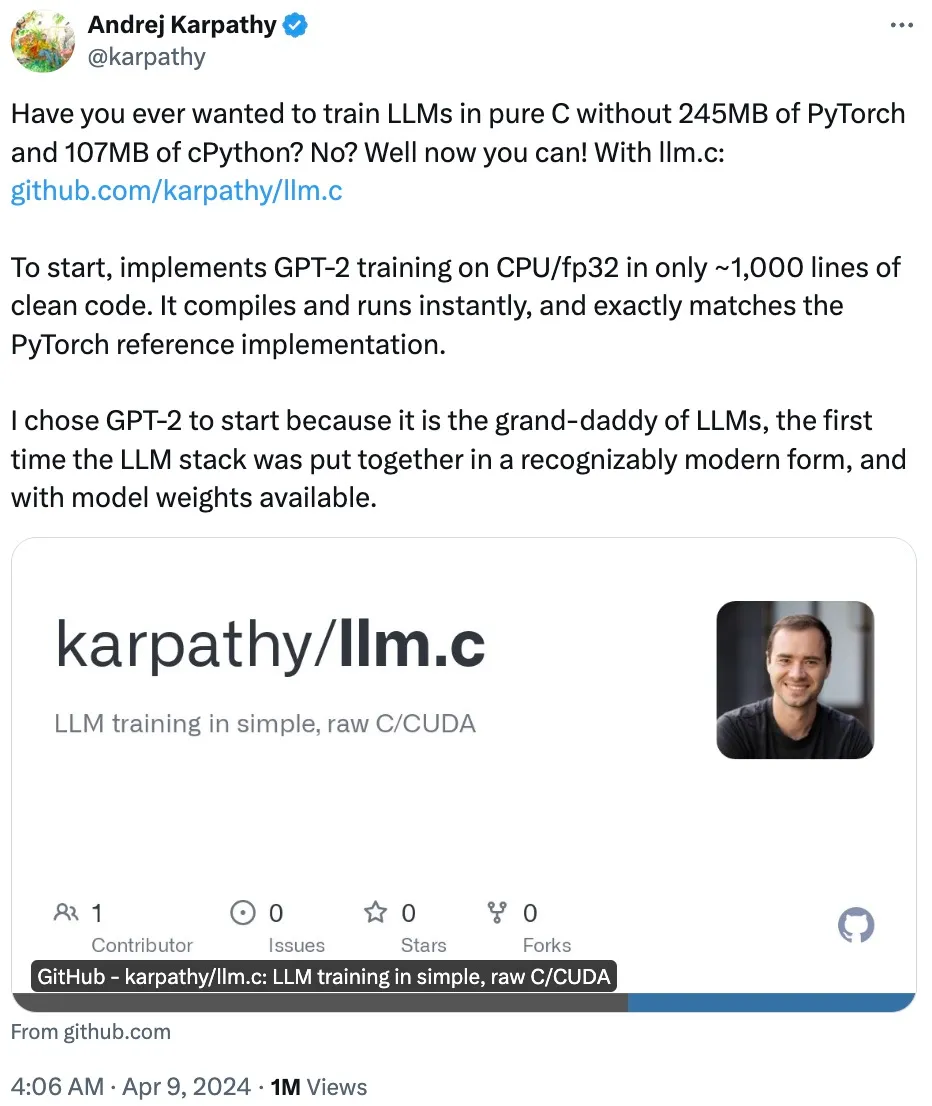

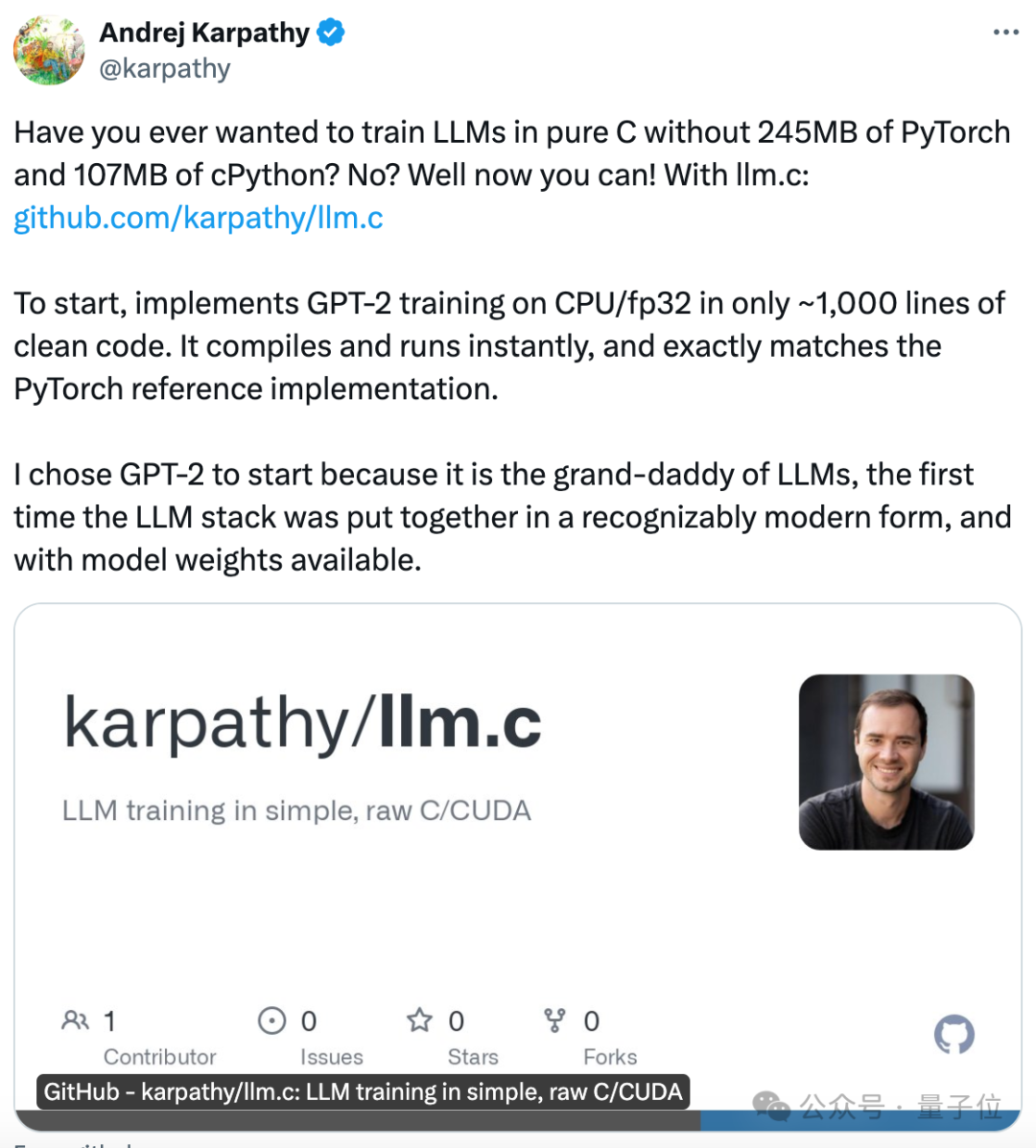

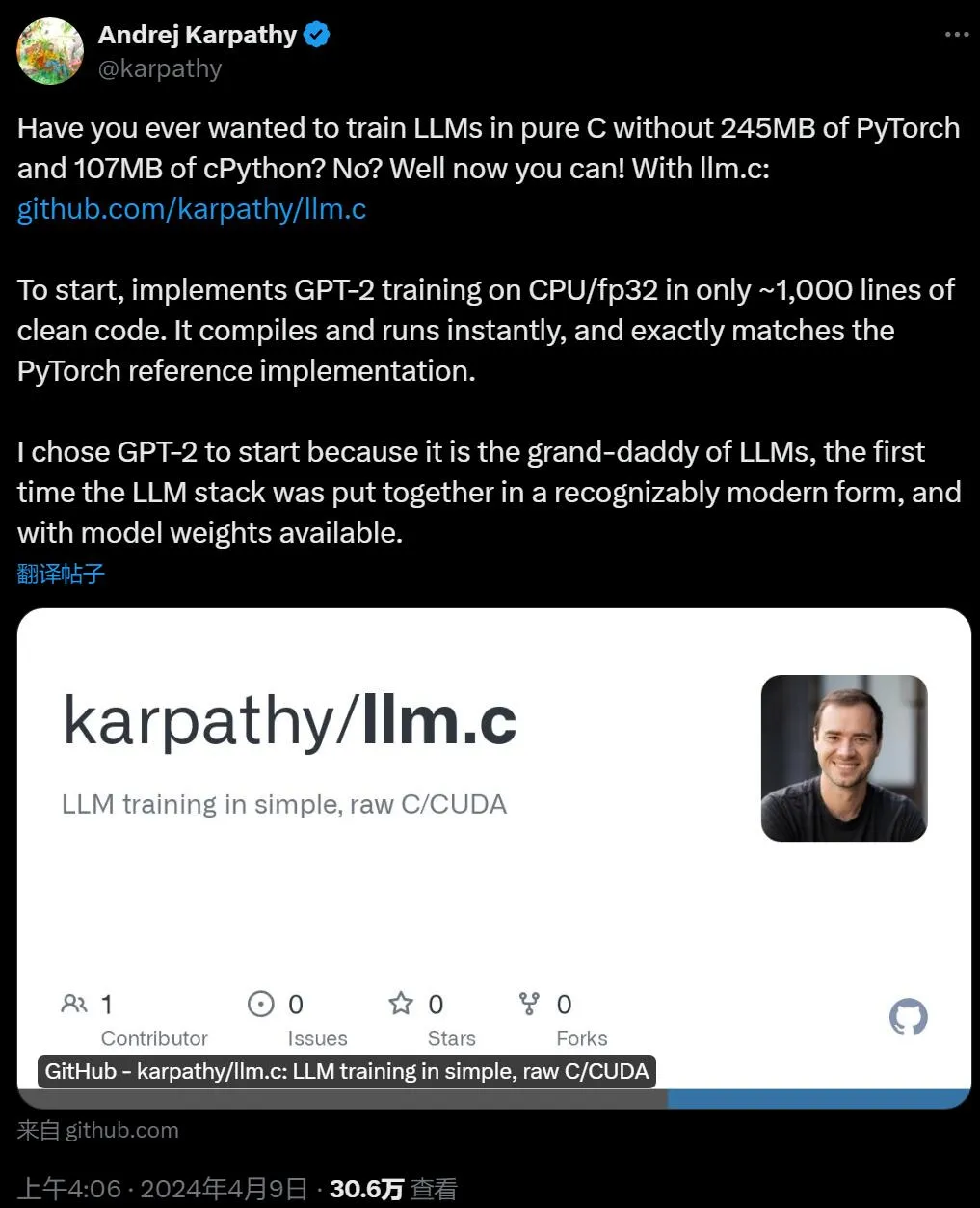

一个仅用 1000 行代码即可在 CPU/fp32 上实现 GPT-2 训练的项目「llm.c」

纯C语言训练GPT,1000行代码搞定!,不用现成的深度学习框架,纯手搓。 发布仅几个小时,已经揽星2.3k。

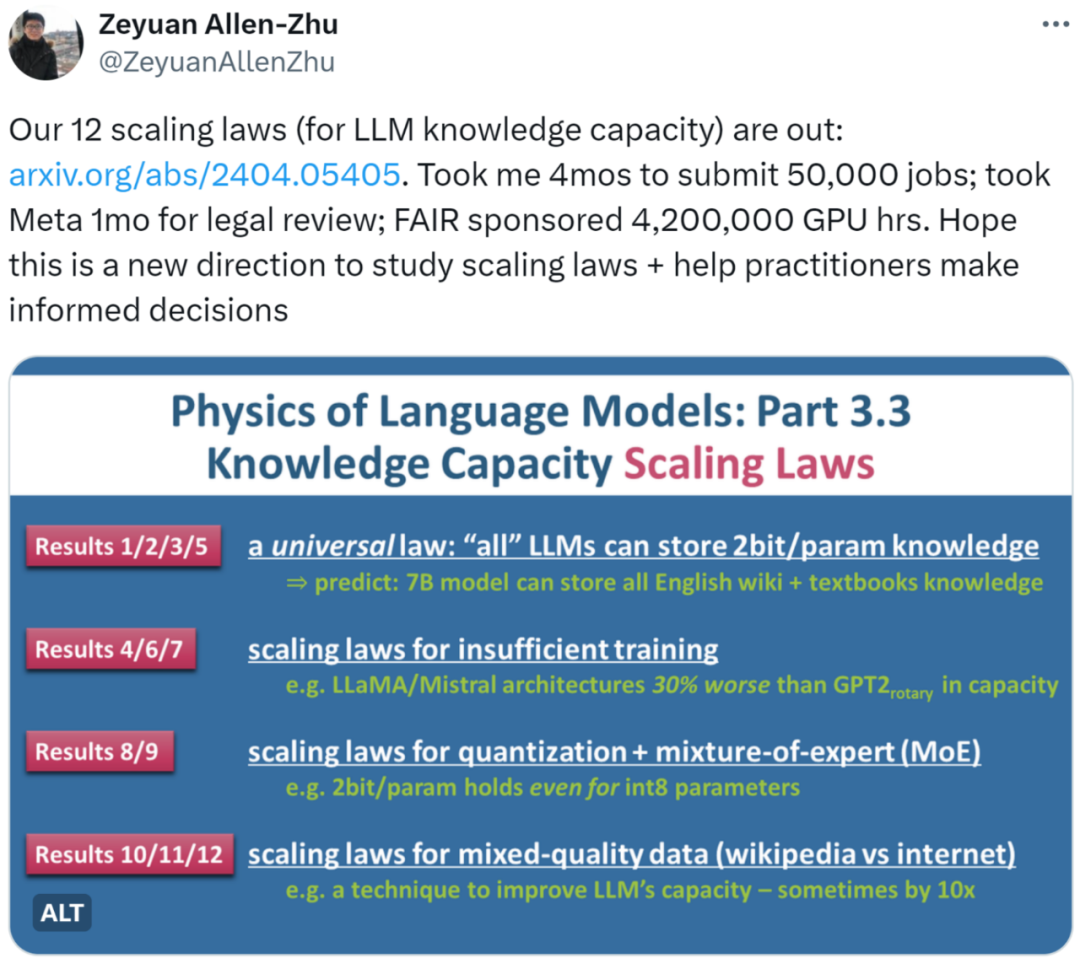

近日,朱泽园 (Meta AI) 和李远志 (MBZUAI) 的最新研究《语言模型物理学 Part 3.3:知识的 Scaling Laws》用海量实验(50,000 条任务,总计 4,200,000 GPU 小时)总结了 12 条定律,为 LLM 在不同条件下的知识容量提供了较为精确的计量方法。

「Real men program in C.」 众所周知,大语言模型还在快速发展,应该有很多可以优化的地方。我用纯 C 语言来写,是不是能优化一大截? 也许很多人开过这样的脑洞,现在有大佬实现了。

训大模型的方法可能要被革新了!AI大神Karpathy发布的新项目仅用1000行的C语言训完GPT-2,而不再依赖庞大的GPT-2库。他本人预告,即将上线新课。

自曝996作息的OpenAI研究员Jason Wei表示,Sora代表着视频生成的GPT-2时刻。竞争的关键,就是算力和数据了。国内有可能成功「复刻」Sora吗?华人团队的这份37页技术报告,或许能给我们一些启发。