大模型时代的ASR就是不一样!豆包“听力”水平现场评测,方言&小朋友口音直接拿捏!

大模型时代的ASR就是不一样!豆包“听力”水平现场评测,方言&小朋友口音直接拿捏!8 月 21 日,2024 火山引擎 AI 创新巡展﹒上海站带来了豆包大模型最新进展。

8 月 21 日,2024 火山引擎 AI 创新巡展﹒上海站带来了豆包大模型最新进展。

Emory大学的研究团队提出了一种创新的方法,将大语言模型(LLM)在文本图(Text-Attributed Graph, 缩写为TAG)学习中的强大能力蒸馏到本地模型中,以应对文本图学习中的数据稀缺、隐私保护和成本问题。通过训练一个解释器模型来理解LLM的推理过程,并对学生模型进行对齐优化,在多个数据集上实现了显著的性能提升,平均提高了6.2%。

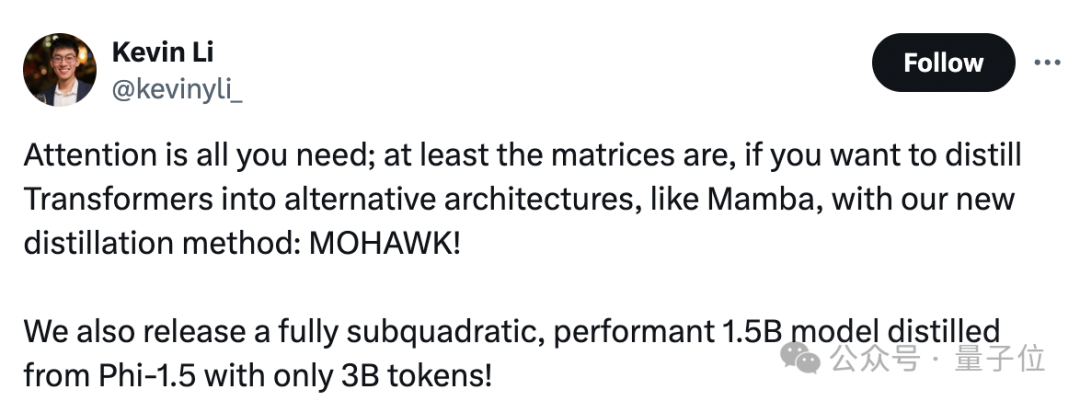

Attention is all you need.

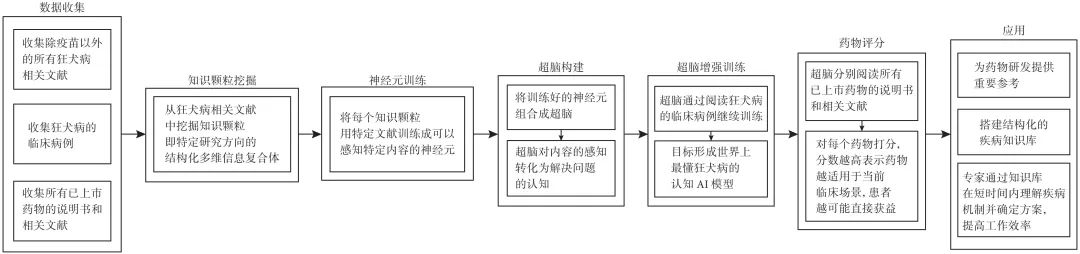

在当今数字化时代,人工智能(artificial intelligence,AI)技术迅猛发展,尤其是生成式技术,如ChatGPT(chat generative pre-trained transformer),对人类生活的影响日益深远。

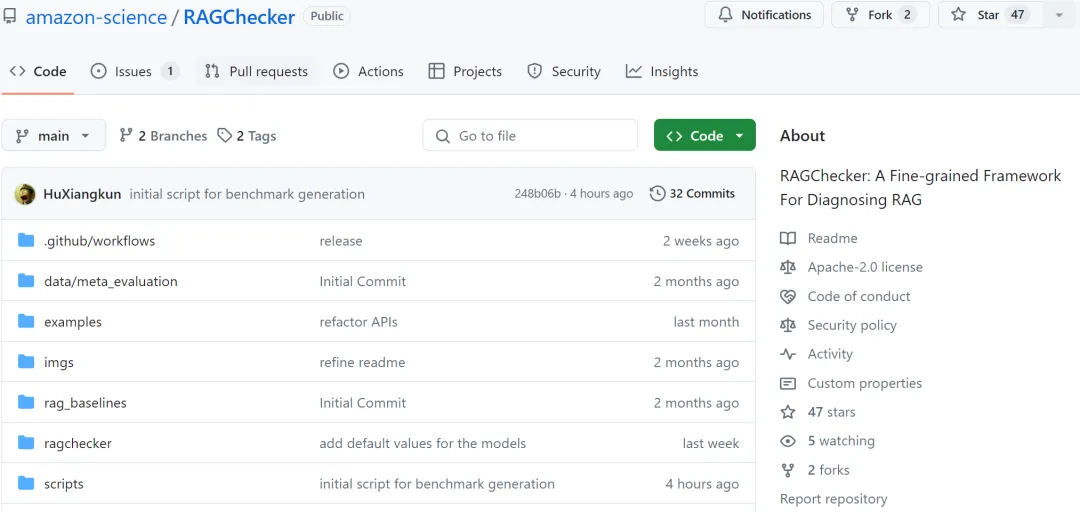

检索增强生成(Retrieval-Augmented Generation, RAG)技术正在彻底革新 AI 应用领域,通过将外部知识库和 LLM 内部知识的无缝整合,大幅提升了 AI 系统的准确性和可靠性。然而,随着 RAG 系统在各行各业的广泛部署,其评估和优化面临着重大挑战

AI的尽头是玄学?

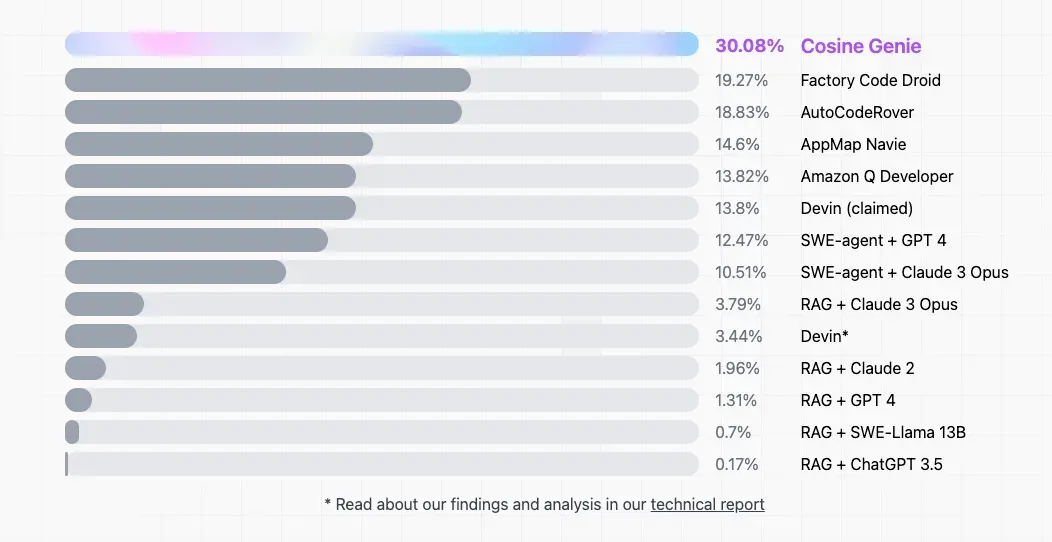

一直以来,大模型的编程能力都备受关注,超强 AI 程序员 Devin 的问世更是将「AI 能否替代程序员」这一话题推上了风口浪尖。最近,Devin 也迎来了新对手 —— 初创公司 Cosine 推出的自主 AI 程序员 Genie。该公司表示,Genie 的表现轻松超越了 Devin,在第三方基准测试 SWE-bench 上的得分为 30%,而 Devin 的得分仅为 13.8%。

自 2024 年 GPT-4o 出现以来,业内各公司纷纷投入巨大的资源进行 TTS 大模型的研发。近几个月内,中文语音合成大模型如雨后春笋般涌现,如 chattts、seedtts、cosyvoice 等。

今年 3 月份,英伟达 CEO 黄仁勋举办了一个非常特别的活动。他邀请开创性论文《Attention Is All You Need》的作者们齐聚 GTC,畅谈生成式 AI 的未来发展方向。

芯片物理布局,有了直指性能指标的新测评标准!