DanceGRPO:首个统一视觉生成的强化学习框架

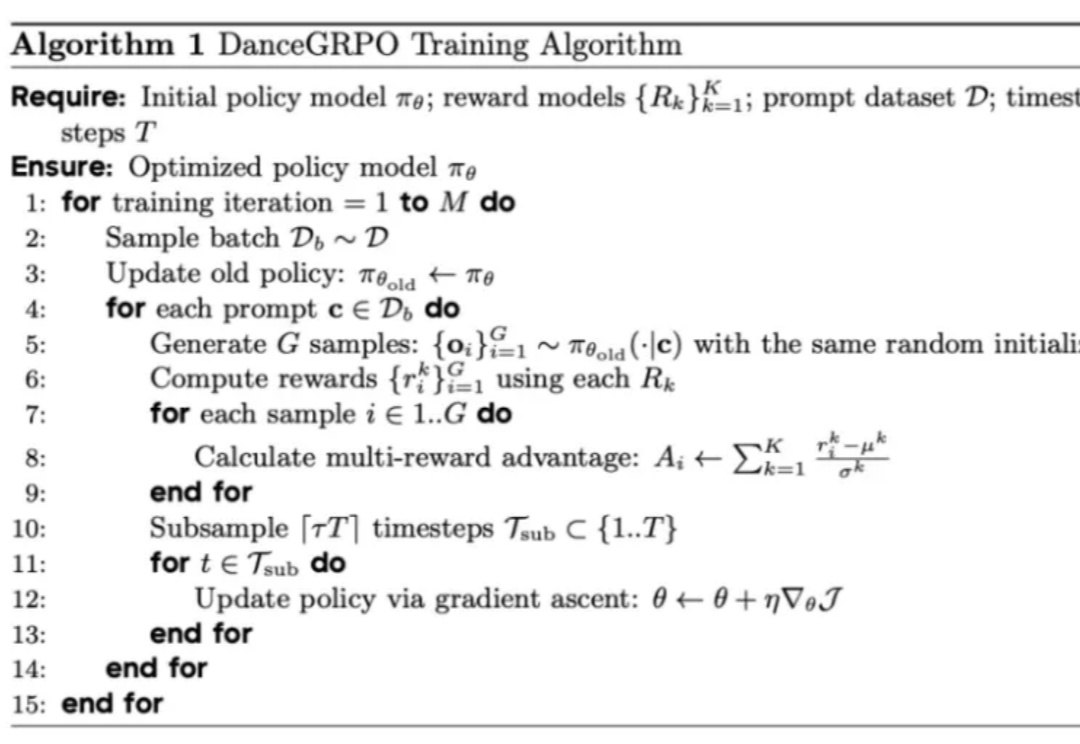

DanceGRPO:首个统一视觉生成的强化学习框架R1 横空出世,带火了 GRPO 算法,RL 也随之成为 2025 年的热门技术探索方向,近期,字节 Seed 团队就在图像生成方向进行了相关探索。

R1 横空出世,带火了 GRPO 算法,RL 也随之成为 2025 年的热门技术探索方向,近期,字节 Seed 团队就在图像生成方向进行了相关探索。

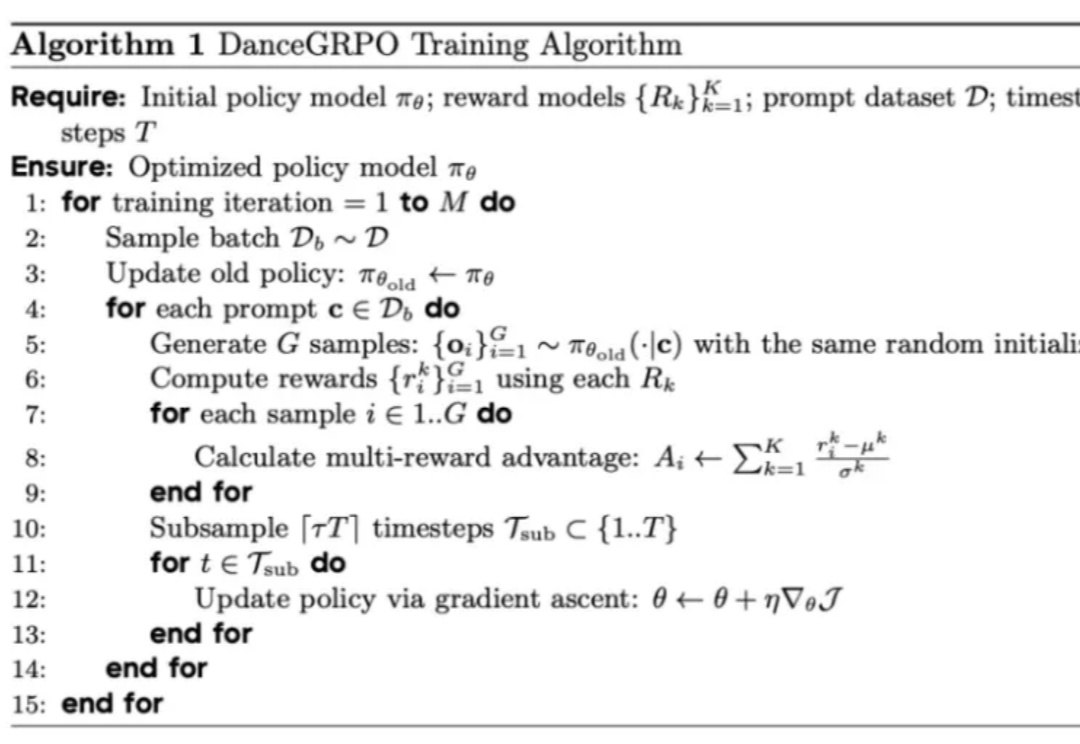

字节拿出了国际顶尖水平的视觉–语言多模态大模型。

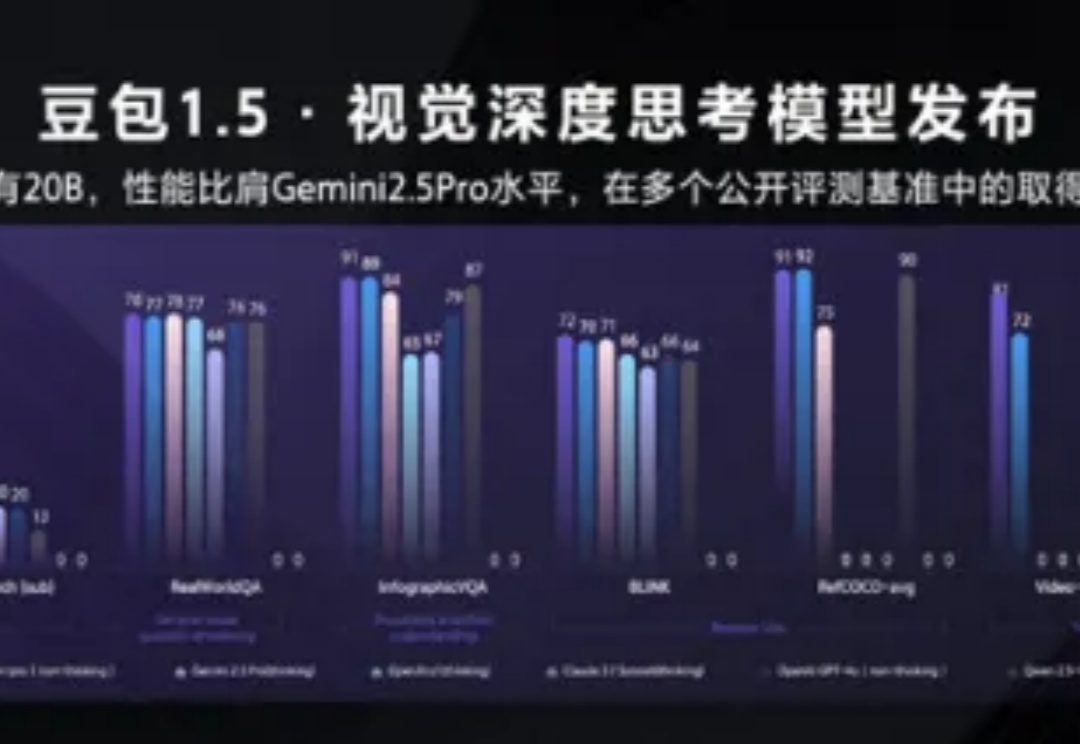

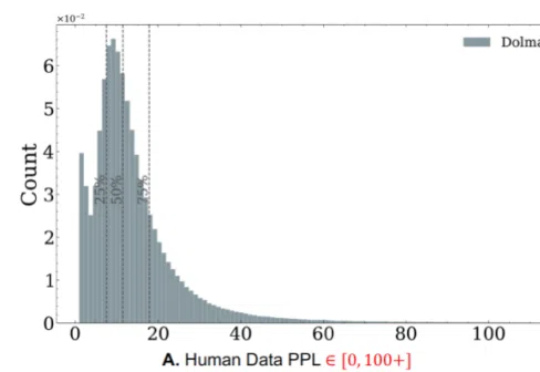

随着生成式人工智能技术的飞速发展,合成数据正日益成为大模型训练的重要组成部分。未来的 GPT 系列语言模型不可避免地将依赖于由人工数据和合成数据混合构成的大规模语料。

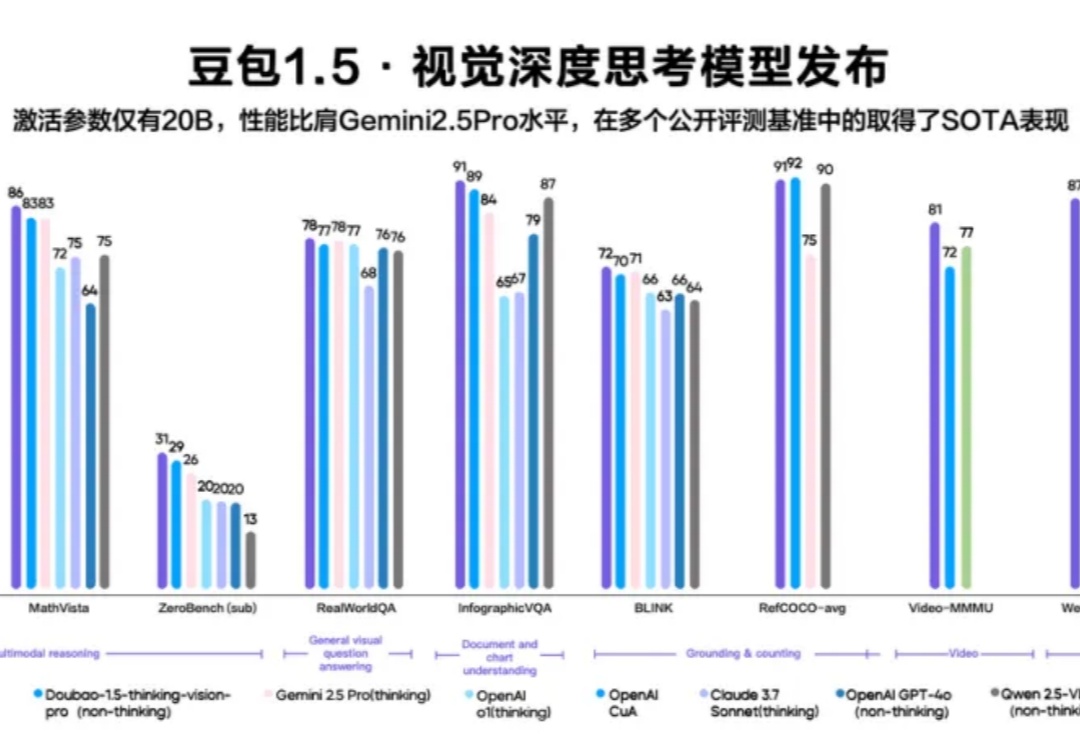

5月13日,在 FORCE LINK AI 创新巡展·上海站,火山引擎发布豆包·视频生成模型 Seedance 1.0 lite、豆包1.5·视觉深度思考模型,升级豆包·音乐模型。同时,Data Agent 正式亮相、Trae 接入豆包深度思考模型并全新升级。火山引擎正在以更强大的模型矩阵、更丰富的智能体工具,帮助企业打通从业务到智能体的应用链路。

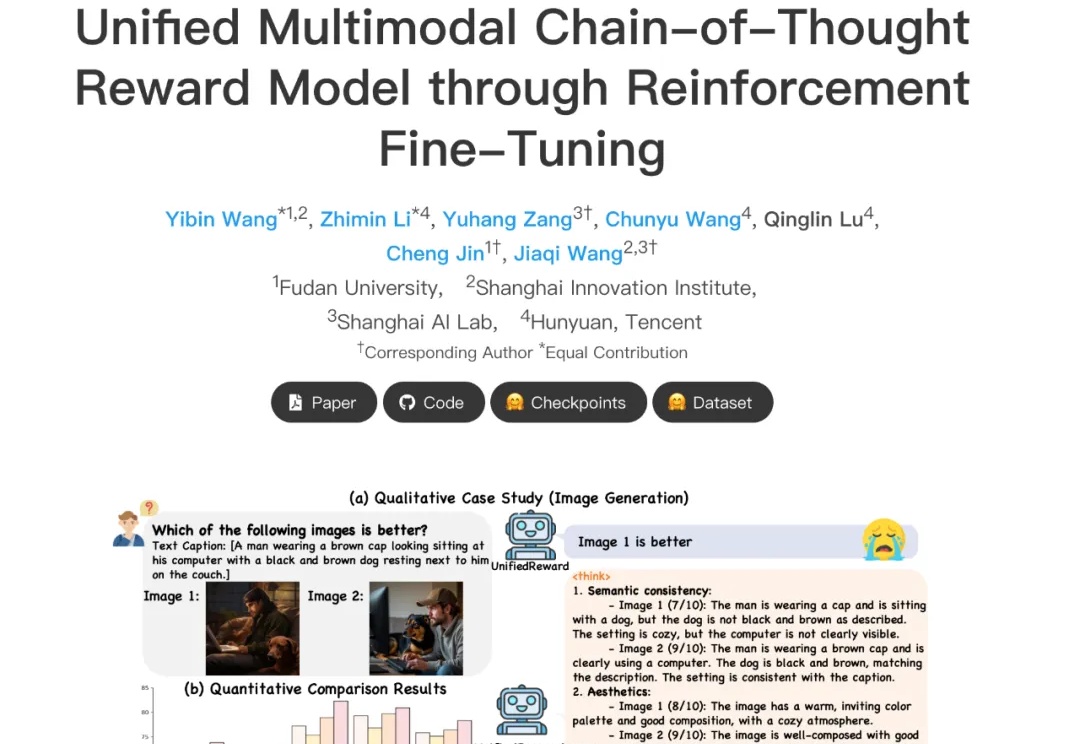

在多模态大模型快速发展的当下,如何精准评估其生成内容的质量,正成为多模态大模型与人类偏好对齐的核心挑战。然而,当前主流多模态奖励模型往往只能直接给出评分决策,或仅具备浅层推理能力,缺乏对复杂奖励任务的深入理解与解释能力,在高复杂度场景中常出现 “失真失准”。

Redis 最近推出向量集合(Vector Set) 功能,这是一种专为向量相似性设计的数据类型,也是 Redis 针对人工智能应用的一个新的选项。这是 Redis 创始人 Salvatore Sanfilippo(“antirez”)自 重新加入 公司以来的第一个重大贡献。

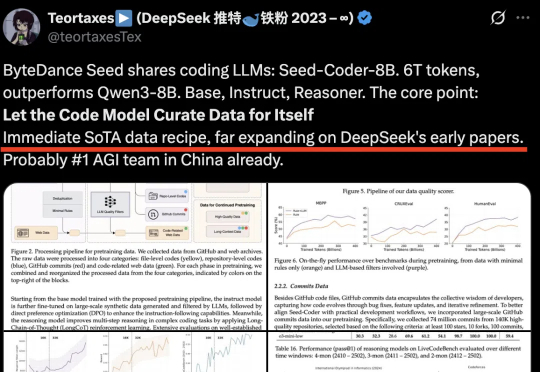

字节Seed首次开源代码模型!Seed-Coder,8B规模,超越Qwen3,拿下多个SOTA。它证明“只需极少人工参与,LLM就能自行管理代码训练数据”。通过自身生成和筛选高质量训练数据,可大幅提升模型代码生成能力。

本周三,Zed 宣布推出全新的 Agentic Editor 功能,并声称其为目前市场上速度最快的 AI 代码编辑器。此举无疑将加剧开发者在选择代码编辑器时的考量,使得原本就备受关注的编辑器之争更趋激烈。

日本AI产业呈现封闭生态,头部公司Preferred Networks和PKSHA依赖本土大企业定制化服务,缺乏国际化突破。前者技术强但转向本土合作,后者侧重应用型AI盈利。产业链由大企业、政府、大学形成闭环,政策推动项目制需求,抑制通用型AI创新,导致日本错失全球AI竞争机遇。

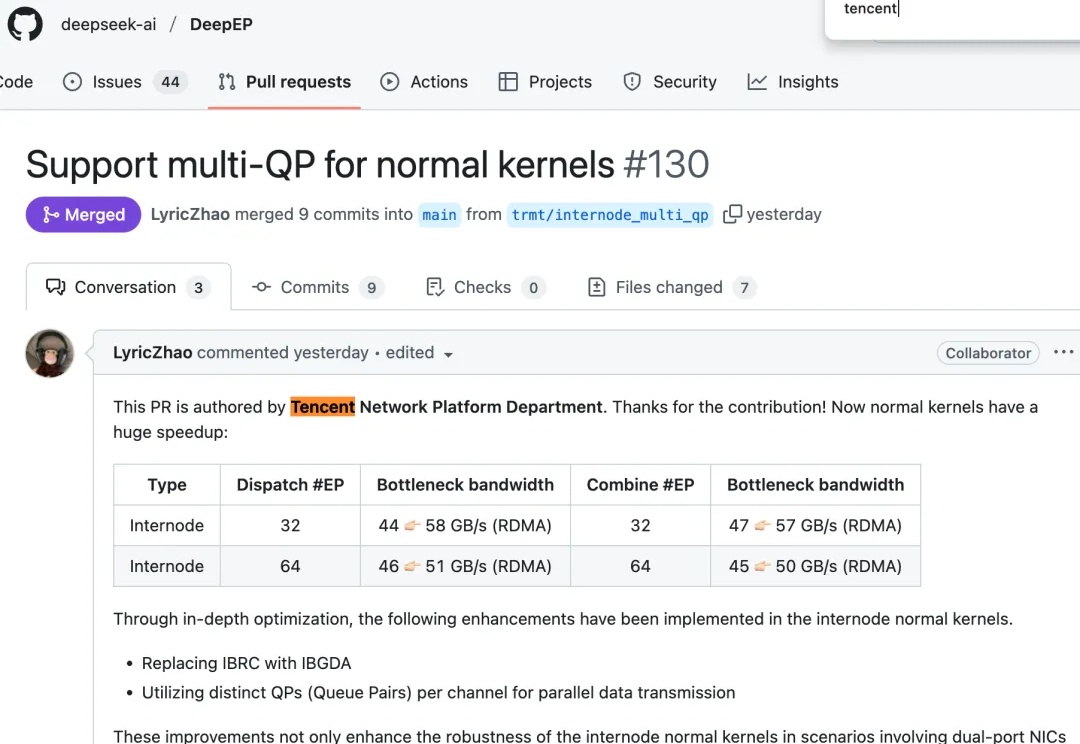

最近,DeepSeek工程师在GitHub上高亮了来自腾讯的代码贡献,并用“huge speedup”介绍了这次性能提升。