月烧4万元,两工程师用Claude Code 跑出15人团队效率:值不值全网吵翻了!

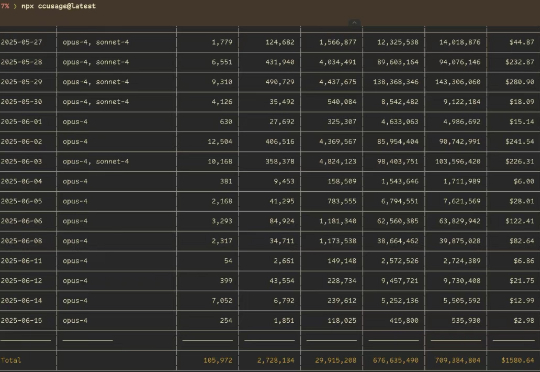

月烧4万元,两工程师用Claude Code 跑出15人团队效率:值不值全网吵翻了!近日,初创公司 Every 总经理 Kieran Klaassen 在 x 上表示自己用 Claude Code 编程时平均每天花 250 美元,也就是说一个月花费 6000 美元(约合 4.3 万人民币)。

近日,初创公司 Every 总经理 Kieran Klaassen 在 x 上表示自己用 Claude Code 编程时平均每天花 250 美元,也就是说一个月花费 6000 美元(约合 4.3 万人民币)。

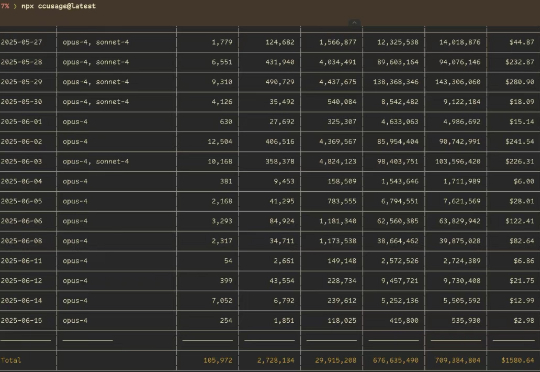

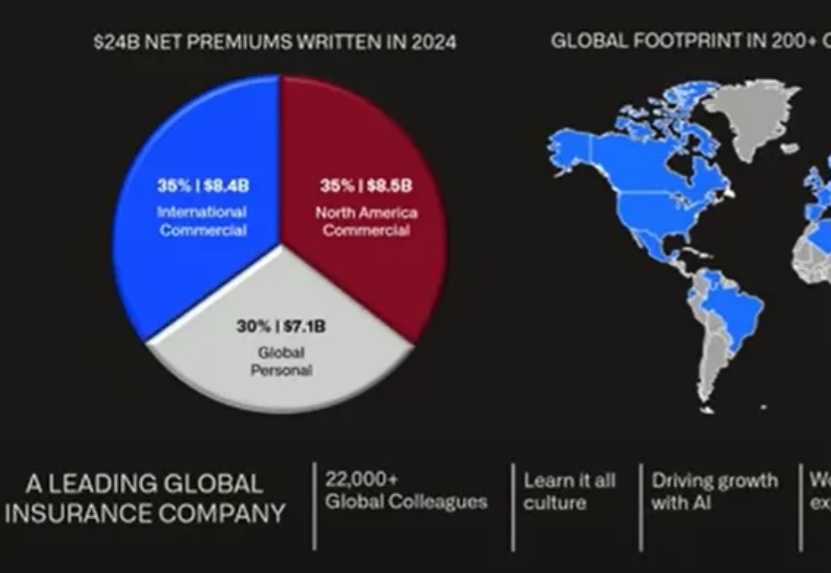

AI应用股王Palantir在6月举办的7thAIP Conference公布了最新一批Agent用例,Palantir公布Agent新用例,不止于next level|AIPCon7介绍了3家医疗客户用例,今天介绍的金融Agent,客户实践出来的企业AI落地原则非常有意义。

6月举办的AIPCon7,又有7家Palantir的客户详细介绍并演示了Agent用例,这次有3家医疗,2家金融,1家电商,1家汽车客户。

沉寂一年多,消失的Ilya Sutskever终于出现了!

我们很多语音生成工作,正是通过加入这些不完美的“人性化特征”,让合成声音显得更加真实和有情感,这也成为ElevenLabs的声音技术与众不同之处。当然,并不是所有场景都适合这种风格。但总体而言,“人性”中的不完美,恰恰是人愿意互动的关键。

Ilya 去哪了? 作为 OpenAI 联合创始人,Ilya Sutskever 一直是最靠近 AI 技术核心的人。如今他不再出现在 OpenAI 的发布会现场,而是选择重新开始。

本文内容整理自 ProtonBase CEO 王绍翾在 AICon 的主题演讲《Data Warebase: Instant Ingest-Transform-Explore-Retrieve for AI Applications》。

AI文本转语音已经进化到这种程度了吗?(⊙ˍ⊙)莎士比亚戏剧腔、体育赛事激情解说、沉浸式有声书等诸多玩法简直轻松拿捏,而且听起来确实人机傻傻分不清楚~

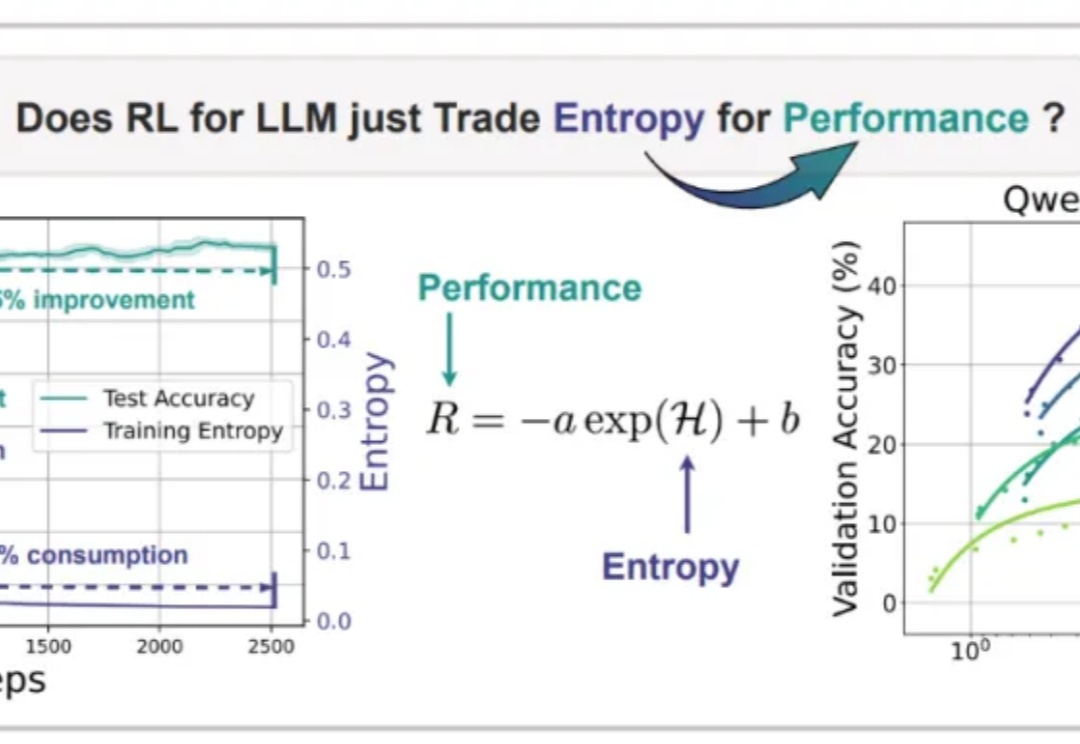

Nature never undertakes any change unless her interests are served by an increase in entropy. 自然界的任何变化,唯有在熵增符合其利益时方会发生——Max Planck

MedGemma是谷歌 “健康人工智能开发者基础”(Health AI Developer Foundations)计划的核心项目。基于 Gemma 3 架构, MedGemma提供多模态和纯文本两种模型变体,旨在降低医疗 AI 开发门槛。