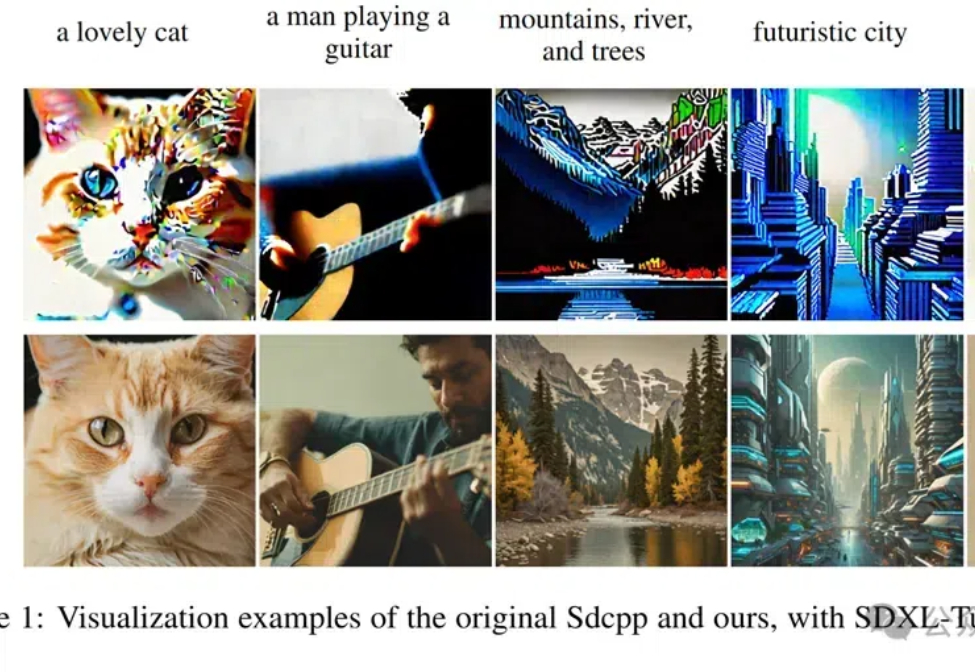

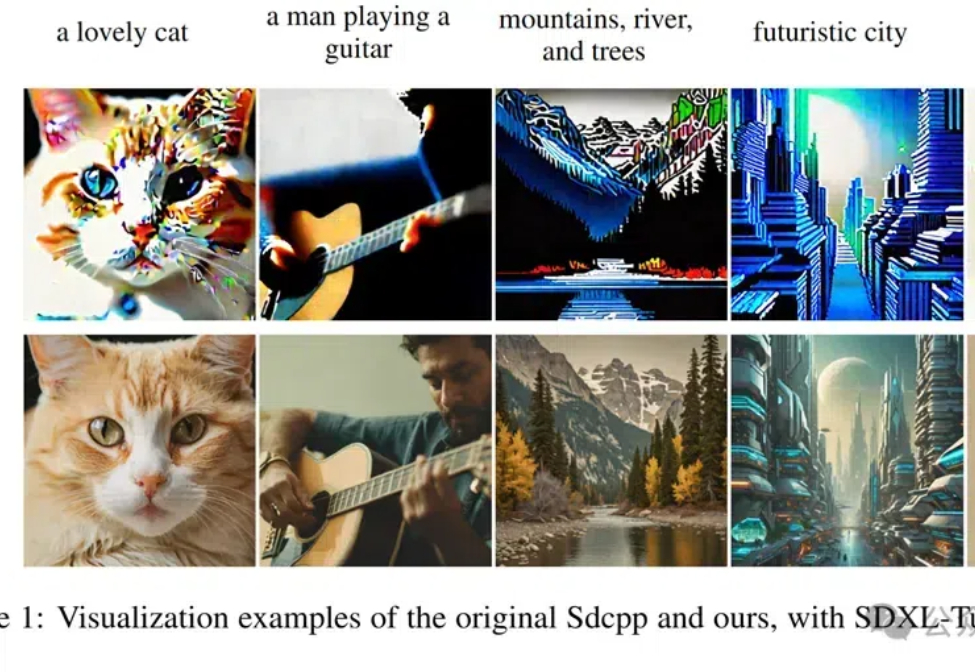

抽卡效率提升4.8倍!东北大学等开源优化版Stable-Diffusion.cpp:分辨率越高越快,生成质量更好

抽卡效率提升4.8倍!东北大学等开源优化版Stable-Diffusion.cpp:分辨率越高越快,生成质量更好北京大学等研究团队优化了Sdcpp框架,通过引入Winograd算法和多项策略,显著提升了图像生成速度和内存效率,最高可提速4.79倍。

北京大学等研究团队优化了Sdcpp框架,通过引入Winograd算法和多项策略,显著提升了图像生成速度和内存效率,最高可提速4.79倍。

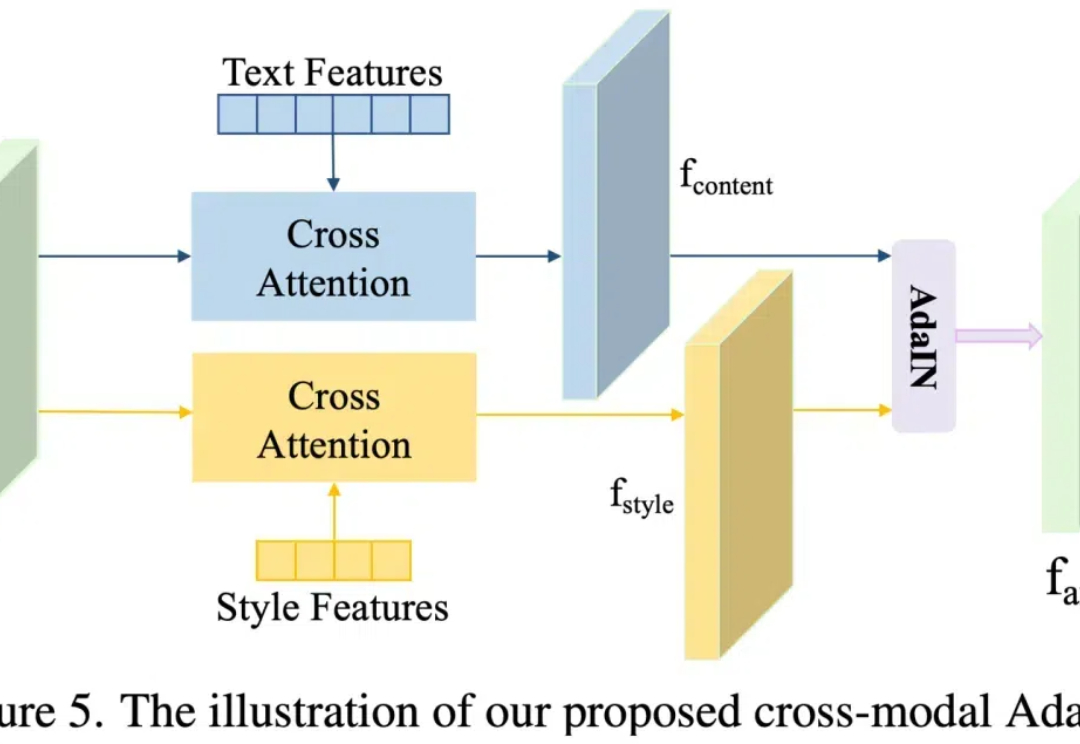

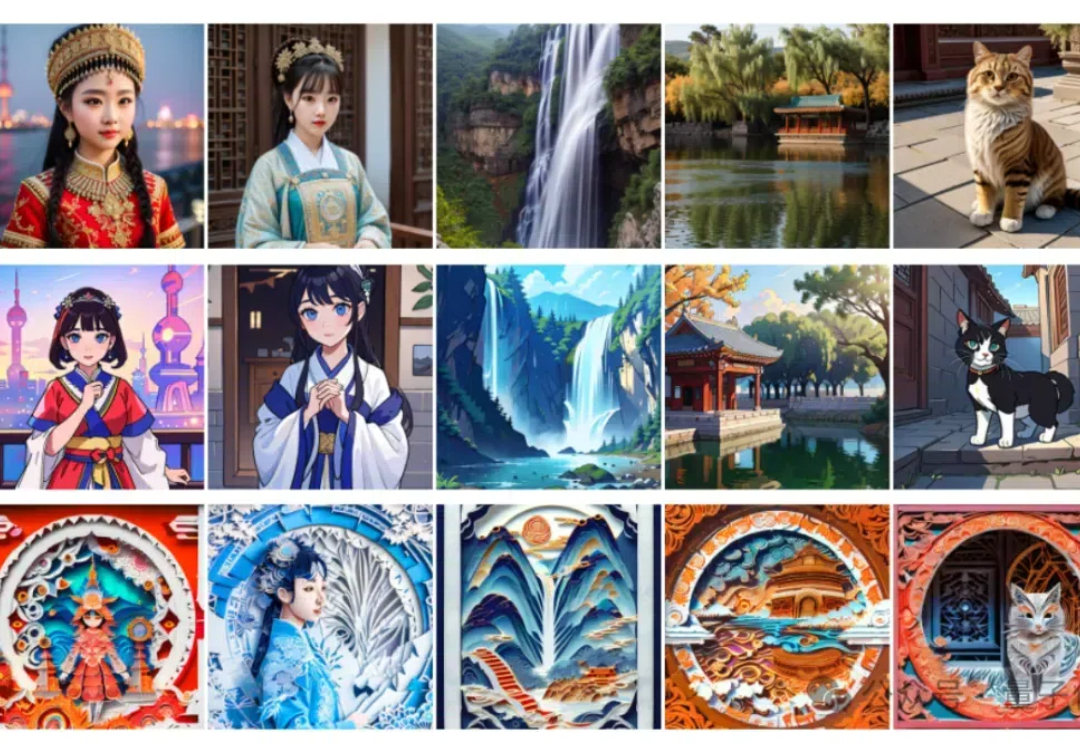

近年来,随着 Stable Diffusion 等文本到图像生成模型的发展,这些技术使得在保留内容准确性的同时,实现出色的风格转换成为可能。这项技术在数字绘画、广告和游戏设计等领域具有重要的应用价值。

具备原生中文理解能力,还兼容Stable Diffusion生态。 最新模型结构Bridge Diffusion Model来了。 与Dreambooth模型结合,它生成的穿中式婚礼礼服的歪国明星长这样。

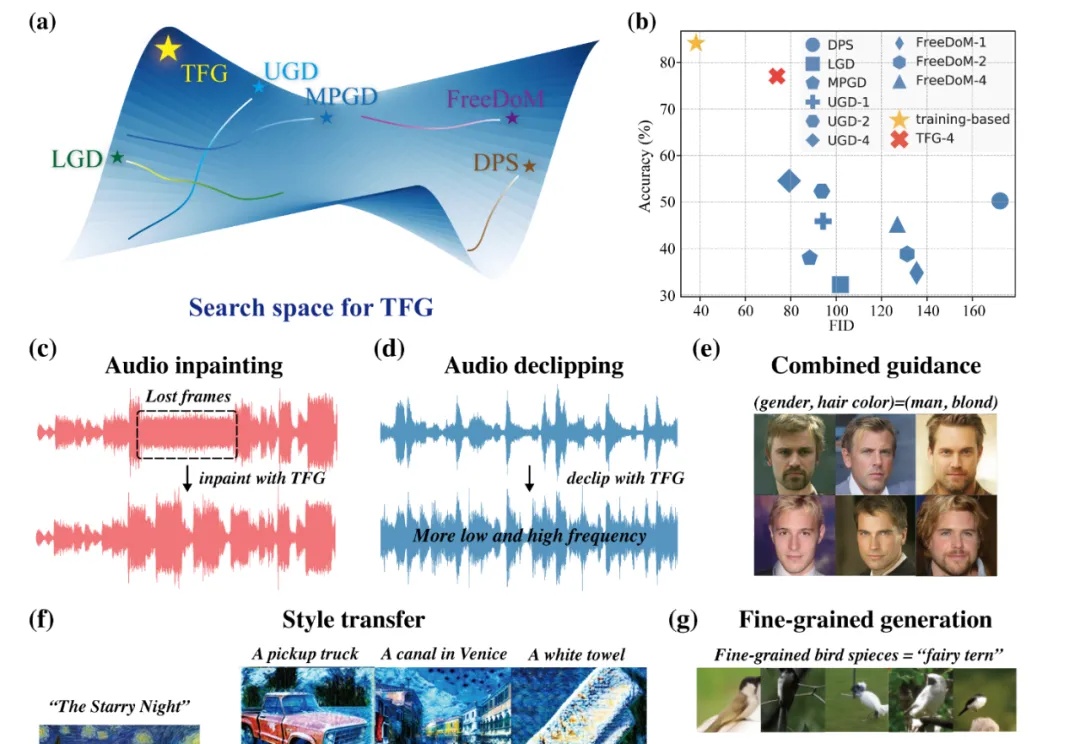

近年来,扩散模型(Diffusion Models)已成为生成模型领域的研究前沿,它们在图像生成、视频生成、分子设计、音频生成等众多领域展现出强大的能力。

2年前——2022年12月1日,凌晨2点02分,标志着AI行业的一次新生。

新手使用 ComfyUI 最大的问题终于被官方解决了!Comfy推出跨平台的 ComfyUI 安装包,你现在可以一键安装 ComfyUI 了。ComfyUI 是一个强大的、基于节点的、用于 Stable Diffusion 的图形用户界面 (GUI)。它允许用户以高度可定制和灵活的方式创建和执行复杂的图像生成工作流程。

Jiaming Song详细介绍了Diffusion模型在视觉生成领域的前沿研究,强调其在提升生成视觉模型质量中的关键作用。他分享了自己从斯坦福大学的博士研究到加入NVIDIA和Luma AI的历程,展示了如何将贝叶斯非参数模型的知识应用到生成式AI中,推动了视觉模型在生成质量和速度上的显著提升。

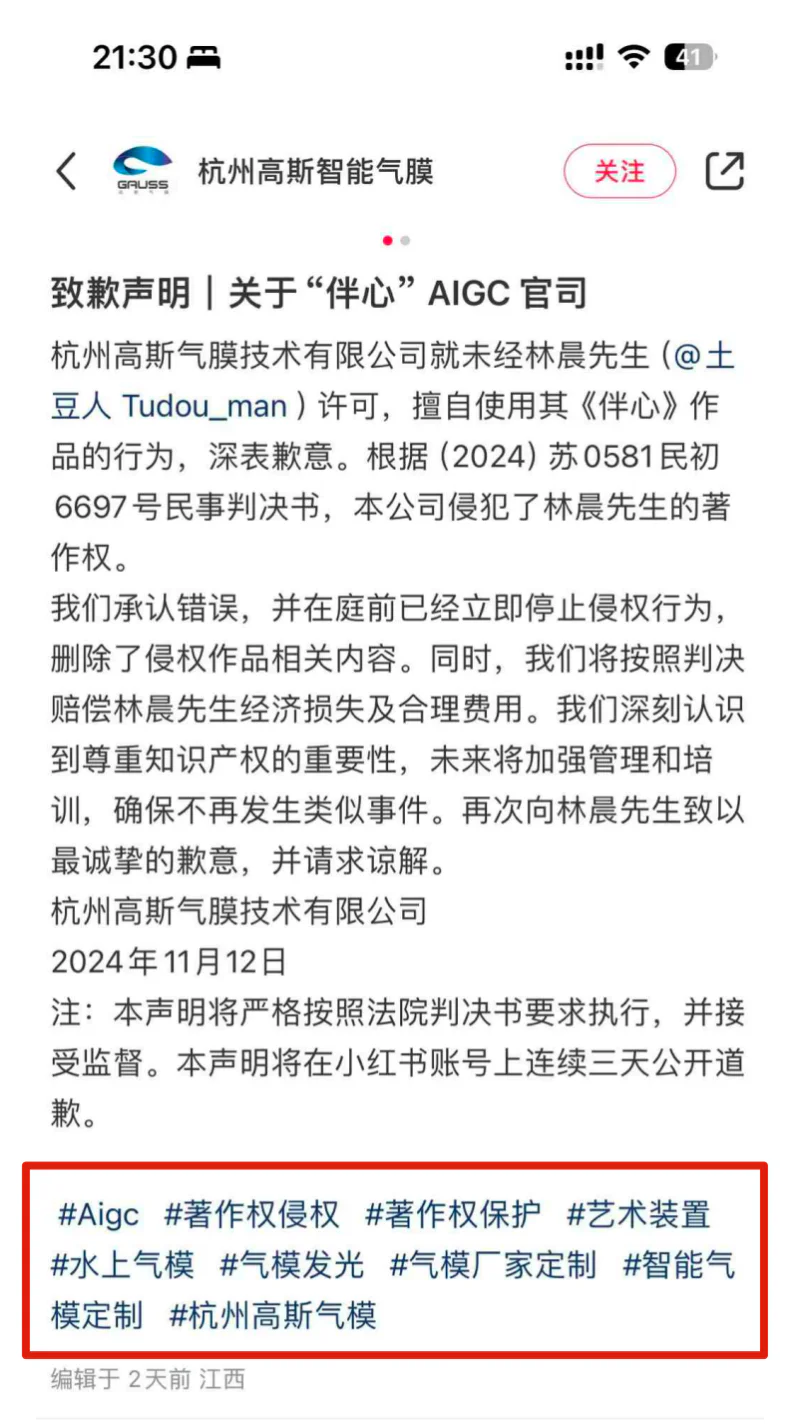

还记得北互SD(Stable Diffusion,一种AI绘画生成工具)第一案吗? 现在第二案来了。

如今,机器人学习最大的瓶颈是缺乏数据。与图片和文字相比,机器人的学习数据非常稀少。目前机器人学科的主流方向是通过扩大真实世界中的数据收集来尝试实现通用具身智能,但是和其他的基础模型,比如初版的 StableDiffusion 相比,即使是 pi 的数据都会少七八个数量级。

今日凌晨,Stability AI 发布了 Stable Diffusion 3.5 的提示指南。该指南提供了 Stable Diffusion 3.5 的实用提示技巧,让使用者能够快速准确地完善图像概念,更好地使用 Stable Diffusion 3.5 这一在可定制性、高效性能、多样化输出和多功能风格方面均表现出色的模型。