真·打字P图!字节发布新模型SeedEdit,一句话爆改世界名画,可免费体验

真·打字P图!字节发布新模型SeedEdit,一句话爆改世界名画,可免费体验11 月 11 日,字节跳动豆包大模型团队推出了最新图像编辑模型 SeedEdit,主打一句话轻松 P 图。

11 月 11 日,字节跳动豆包大模型团队推出了最新图像编辑模型 SeedEdit,主打一句话轻松 P 图。

现在,视频生成模型无需训练即可加速了?! Meta提出了一种新方法AdaCache,能够加速DiT模型,而且是无需额外训练的那种(即插即用)。

就在刚刚,CEO奥特曼携4大高管集体亮相reddit有问必答活动(AMA ),挨个回复了大家对OpenAI主要产品、AGI路线规划等提问。

在 Reddit AMA中,OpenAI 首席执行官萨姆·奥特曼承认,计算能力不足是阻碍公司频繁推出产品的一个主要因素。

Open-Sora-Plan迎来又一次升级。新的Open-Sora-Plan v1.3.0版本引入了五个新特性:性能更强、成本更低的WFVAE;Prompt refiner;高质量数据清洗策略;全新稀疏注意力的DiT,以及动态分辨率、动态时长的支持。

过去 24 小时内发布或更新的 AI 服务包括但不限于 Stable Diffusion 3.5 最强模型全家桶、能操作用户电脑的 Claude 3.5 Sonnet、Genmo 开源的可商用的 Mochi 1 DiT、Runway 推出的一款生成式角色表演工具…… 以及我们这里要介绍 Ideogram Canvas,一款基于 AI 的无限创意画板服务,可用于组织、生成、编辑和组合图像。

在NLP领域,研究者们已经充分认识并认可了表征学习的重要性,那么视觉领域的生成模型呢?最近,谢赛宁团队发表的一篇研究就拿出了非常有力的证据:Representation matters!

性能不输SOTA模型,计算开销却更低了——

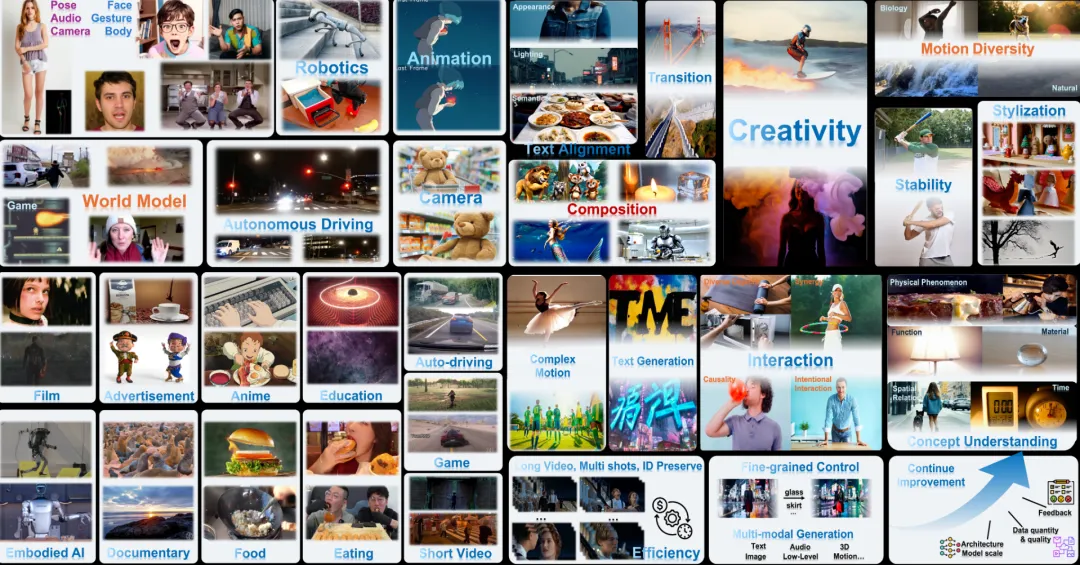

腾讯 AI Lab 联合中科大发布了一份针对类 SORA 视频生成模型的测评报告,重点聚焦目前最前沿的类 SORA DiT 架构的高质量视频生成闭源模型

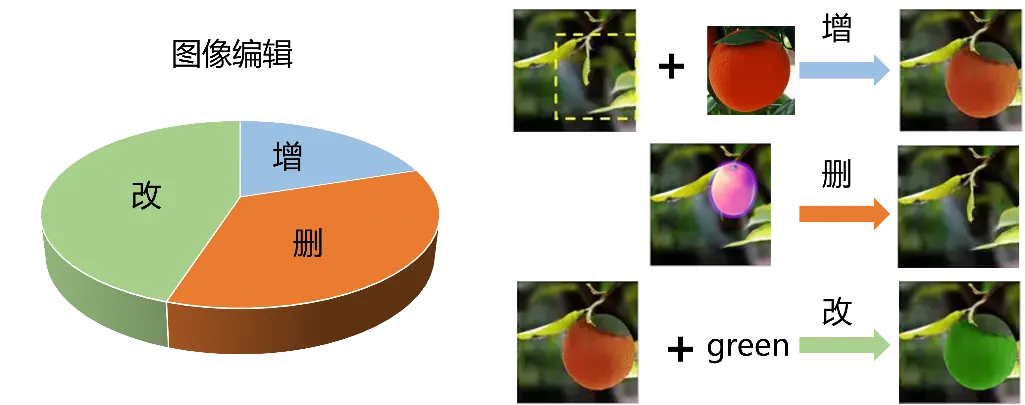

在AIGC 的浪潮中,对已有图片做编辑的图像编辑(image editing)技术受到了越来越多的关注。图像编辑(image editing)的原子操作包括增、删、改。