对谈闵可锐、方汉和吴翼:DeepSeek-R1 之后,AI 应用更好做了吗?

对谈闵可锐、方汉和吴翼:DeepSeek-R1 之后,AI 应用更好做了吗?应用内接入 DeepSeek-R1 已经成了一种潮流。

应用内接入 DeepSeek-R1 已经成了一种潮流。

用代码训练大模型思考,其他方面的推理能力也能提升。

基于三家企业、127 页文字访谈实录总结的产业观察

接入DeepSeek,不等于All in DeepSeek

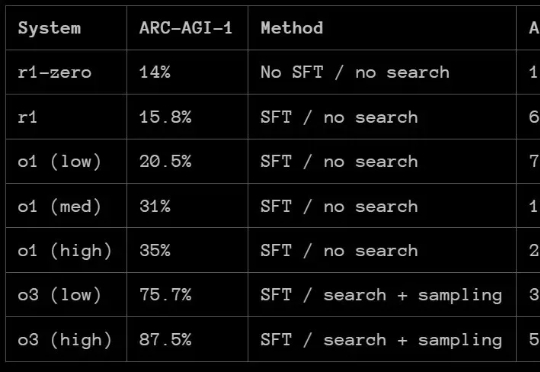

那么,DeepSeek-R1 的 ARC-AGI 成绩如何呢?根据 ARC Prize 发布的报告,R1 在 ARC-AGI-1 上的表现还赶不上 OpenAI 的 o1 系列模型,更别说 o3 系列了。但 DeepSeek-R1 也有自己的特有优势:成本低。

GPT-4o悄悄更新版本,在大模型竞技场超越DeepSeek-R1登上并列第一。

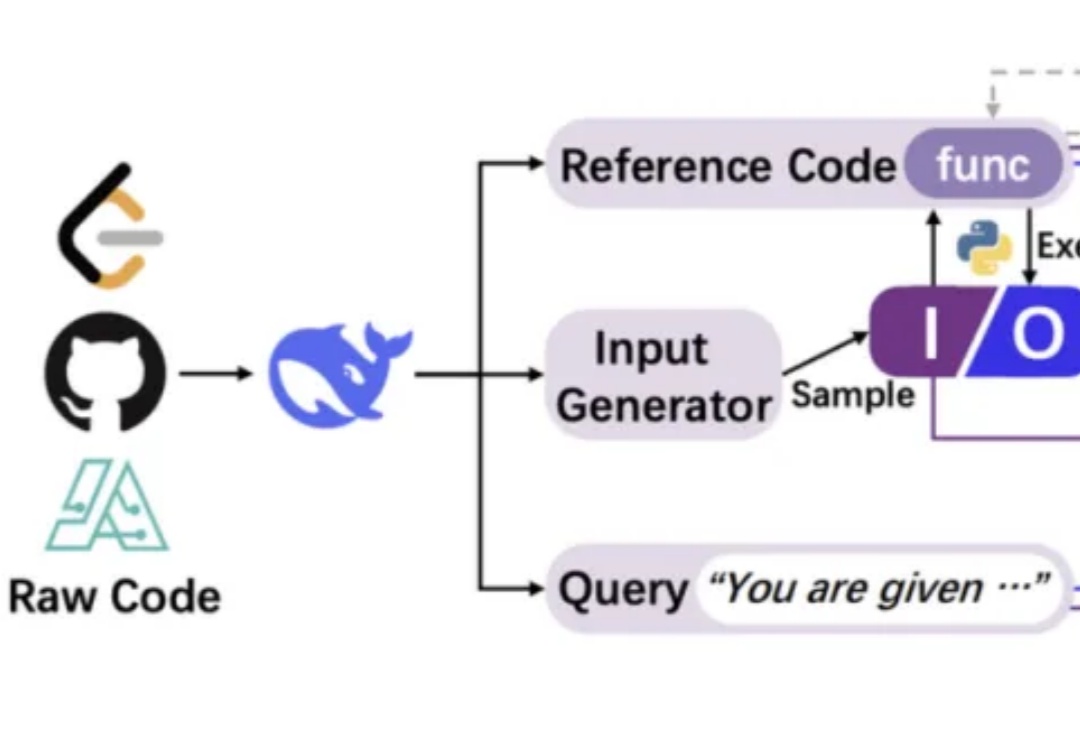

DeepSeek团队最新力作一上线,就获得Ai2研究所大牛推荐,和DeepSeek铁粉们的热情研读!他们提出的CodeI/O全新方法,通过代码提取了LLM推理模式,在逻辑、数学等推理任务上得到显著改进。

2025年,中国大模型迎来最高光时刻。DeepSeek凭借深度推理、低成本强势崛起,中科院系AI企业祭出的YAYI-Ultra大模型在代码能力上超越GPT-4o,成功跻身OpenCompas榜单全球前十,高精度和低能耗兼而有之。

“已接入DeepSeek”,这句话的含金量还在持续上升。

广东打响了第一枪。深圳龙岗区的政务系统悄悄上线了DeepSeek-R1全尺寸模型,群众办事时面对的不再是机械的问答机器人,而是一个能理解“我想办落户,但社保断了3个月怎么办”这类复杂问题的AI公务员。东莞紧随其后,把DeepSeek塞进了人工智能大模型中心,号称要让“企业办证速度跑赢奶茶外卖”。更狠的是广州,直接祭出DeepSeek-R1和V3 671B双模型组合