全球头部AI应用公司,现状如何?

全球头部AI应用公司,现状如何?随着DeepSeek的横空出世,行业竞争加剧,无论是AI原生企业还是转型中的互联网巨头,都面临战略路径的重新校准。这一现象引发了行业的连锁反应:一方面,头部企业加速产品迭代和推广;另一方面,部分企业由于战略失误和反应缓慢开始面临用户流失风险。在这样的竞争环境下,企业的战略选择显得尤为关键。成功的AI公司通常具备三大核心能力:精准的战略定位、快速的调整能力以及高效的执行落地。

随着DeepSeek的横空出世,行业竞争加剧,无论是AI原生企业还是转型中的互联网巨头,都面临战略路径的重新校准。这一现象引发了行业的连锁反应:一方面,头部企业加速产品迭代和推广;另一方面,部分企业由于战略失误和反应缓慢开始面临用户流失风险。在这样的竞争环境下,企业的战略选择显得尤为关键。成功的AI公司通常具备三大核心能力:精准的战略定位、快速的调整能力以及高效的执行落地。

国产大模型进步的速度早已大大超出了人们的预期。年初 DeepSeek-R1 爆火,以超低的成本实现了部分超越 OpenAI o1 的表现,一定程度上让人不再过度「迷信」国外大模型。

在春节和五一尝试使用DeepSeek做旅行规划后,Wendy还是决定重新用回Excel。今年春节带父母去北京的她,按照DeepSeek给出的旅行规划,从上午到晚上制定了精确到小时的行程。 但令Wendy没想到的是,最终她和父母仅完成了规划中的两个景点,原因在于不确定的路况、游览人数过多以及父母的疲惫,让DeepSeek错误预测了时间。

今天凌晨,全球著名大模型整合应用平台Poe发布了,2025年春季AI模型使用趋势报告。

DeepSeek最新论文深入剖析了V3/R1的开发历程,揭示了硬件与大语言模型架构协同设计的核心奥秘。论文展示了如何突破内存、计算和通信瓶颈,实现低成本、高效率的大规模AI训练与推理。不仅总结了实践经验,还为未来AI硬件与模型协同设计提出了建议。

中国基础大模型市场,彻底变天了!如今牌桌上的玩家已经变成了「基模五强」——字节、阿里、阶跃星辰、智谱和DeepSeek。接下来的巅峰之战,关键制胜点又会在哪里?

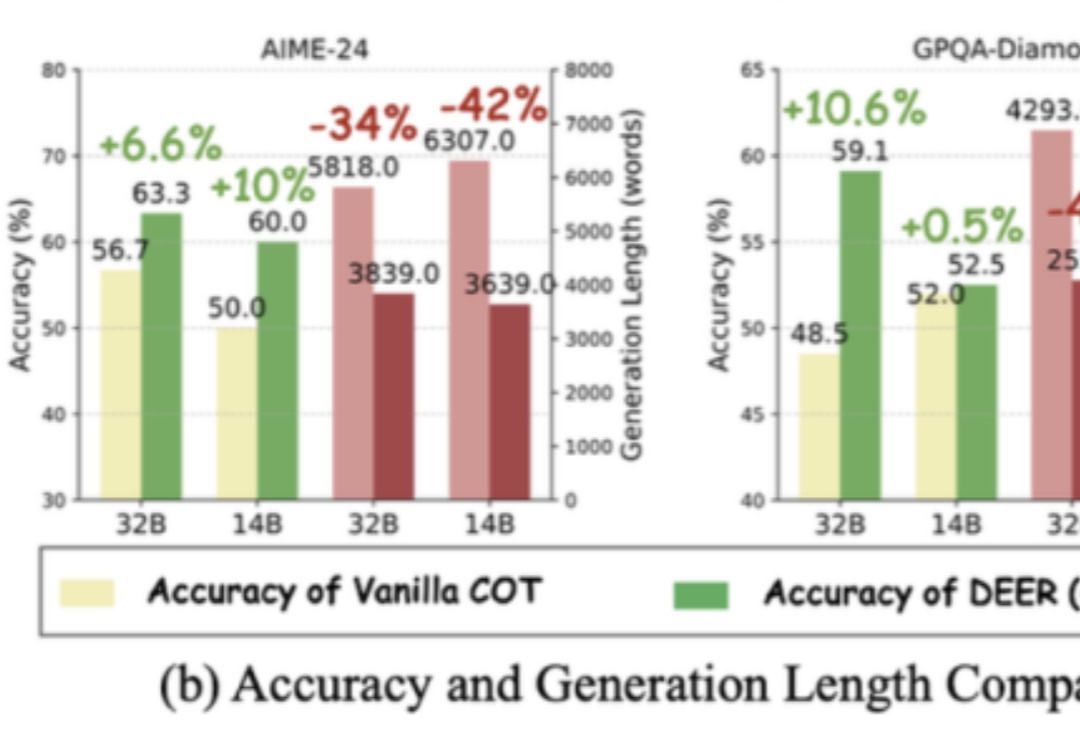

长思维链让大模型具备了推理能力,但如果过度思考,就有可能成为负担。

今年3月,DeepSeek迅速席卷全国医疗机构。据不完全统计,短短一个月内全国已经有 超300家 医院完成DeepSeek的本地部署,遍布北京、上海、安徽、四川、广东、河北、湖南、江苏等二十多个省市和自治区。

“DeepSeek告诉我们,投流的逻辑是不成立的。”5月8日,久不露面的阶跃星辰CEO姜大昕,出现在北京的一场媒体沟通会上“在多模态领域,如果任何一个方面有短板,都会延缓探索AGI进程。”姜大昕给出了一个鲜明的判断。过去一年中,他在不同场合都在反复提及:多模态是实现AGI的必经之路

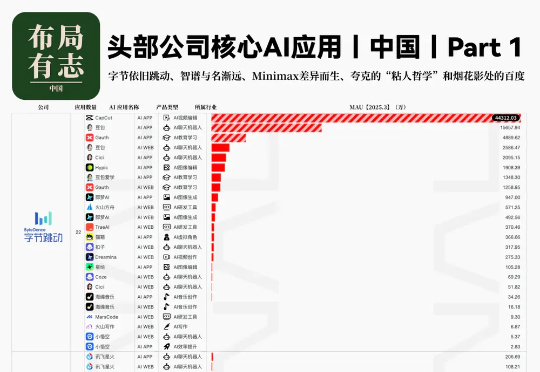

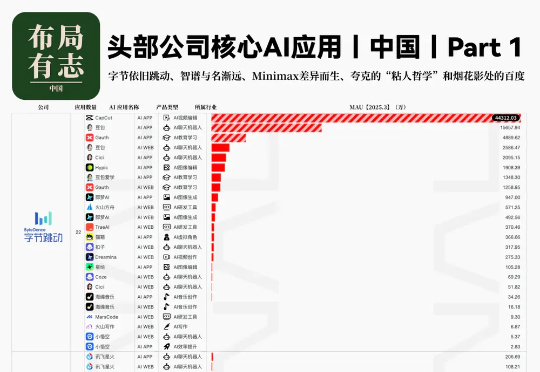

2025年一季度全球AI应用市场呈现爆发式增长,海外MAU达9.8亿(环比增15%),中国MAU达4.62亿(环比增101%)。DeepSeek以低成本开源策略颠覆行业,推动中国AI普及。Agent形态应用主导全球,AI聊天机器人、视频创作等赛道高速增长,虚拟角色和教育学习粘性突出。字节、腾讯等头部公司多端布局,中国AI应用出海聚焦视频、图像等赛道,OpenAI商业化表现强劲。