实测美团 LongCat:快到极致,但是别说追平 DeepSeek

实测美团 LongCat:快到极致,但是别说追平 DeepSeek用过才知道,「快」不是万能药。

用过才知道,「快」不是万能药。

起猛了,美团这下真的开始明牌干AI了。

国内外开发者:亲测,美团新开源的模型速度超快!

没想到啊,最新SOTA的开源大模型…… 来自一个送外卖(Waimai)的——有两个AI,确实不一样。 这个最新开源模型叫:Longcat-Flash-Chat,美团第一个开源大模型,发布即开源,已经在海内外的技术圈子里火爆热议了。

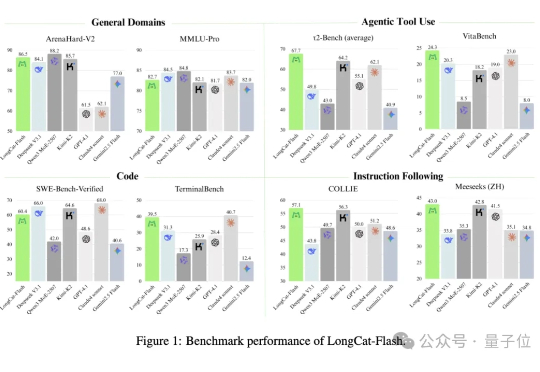

昨天,美团低调地开源了其560B参数的混合专家(MoE)模型——LongCat-Flash。 一时间,大家的目光都被吸引了过去,行业内的讨论大多围绕着它在公开基准测试中媲美顶尖模型的性能数据,以及其精巧的MoE架构设计。

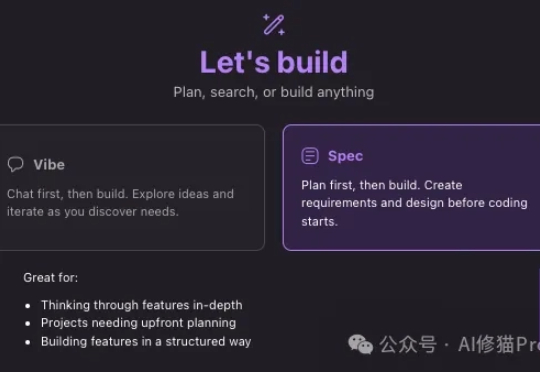

10天前Amazon发布了他们自己的开发平台,Kiro IDE,其中有一个很厉害的交互功能“Spec(Specification)”,强调的是规范的文档,说明书,以一套非常结构化的方法确保开发过程的系统性、可控性和质量,堪称现代软件工程的最佳实践。让vibe coding有一个规范的范式。

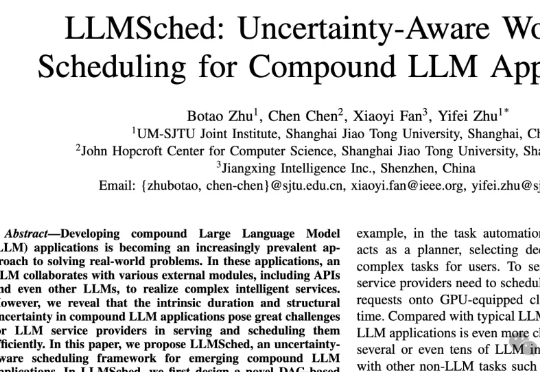

复合LLM应用 (compound LLM applications) 是一种结合大语言模型(LLM)与外部工具、API、或其他LLM的高效多阶段工作流应用。

本月初,据 The Information 报道,Anthropic Claude Code 的两位负责人 Boris Cherny 和 Cat Wu 被 AI 编程应用 Cursor 的开发商 Anysphere 挖走。详见机器之心报道:《从亲密伙伴抢人,Cursor挖走Claude Code两位核心人物》

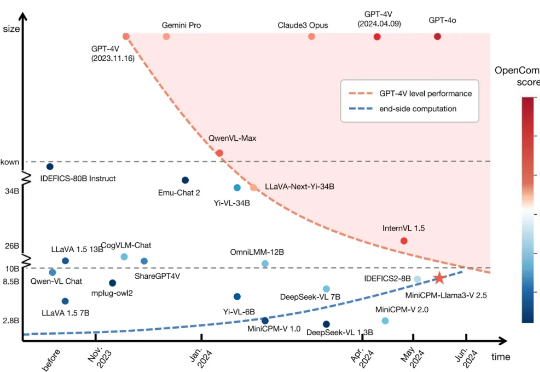

7 月 1 日,国际顶级学术期刊《Nature》旗下子刊《Nature Communications》正式刊登了来自清华、面壁等研究团队联合研发的高效端侧多模态大模型MiniCPM-V 核心研究成果。

大模型数学能力骤降,“罪魁祸首”是猫猫?只需在问题后加一句:有趣的事实是,猫一生绝大多数时间都在睡觉。