大致没差的AI判断,和大佬说的不怎么一样

大致没差的AI判断,和大佬说的不怎么一样AI对计算栈的改变远超过去50年各种变化的总和。

AI对计算栈的改变远超过去50年各种变化的总和。

今日,英特尔推出英特尔® 至强® 6能效核处理器,每个 CPU 拥有多达 144 个内核,机架密度提高达3倍1,以高性能、高密度、高能效和低TCO,满足多样的云级工作负载,是数据中心高效能之选。

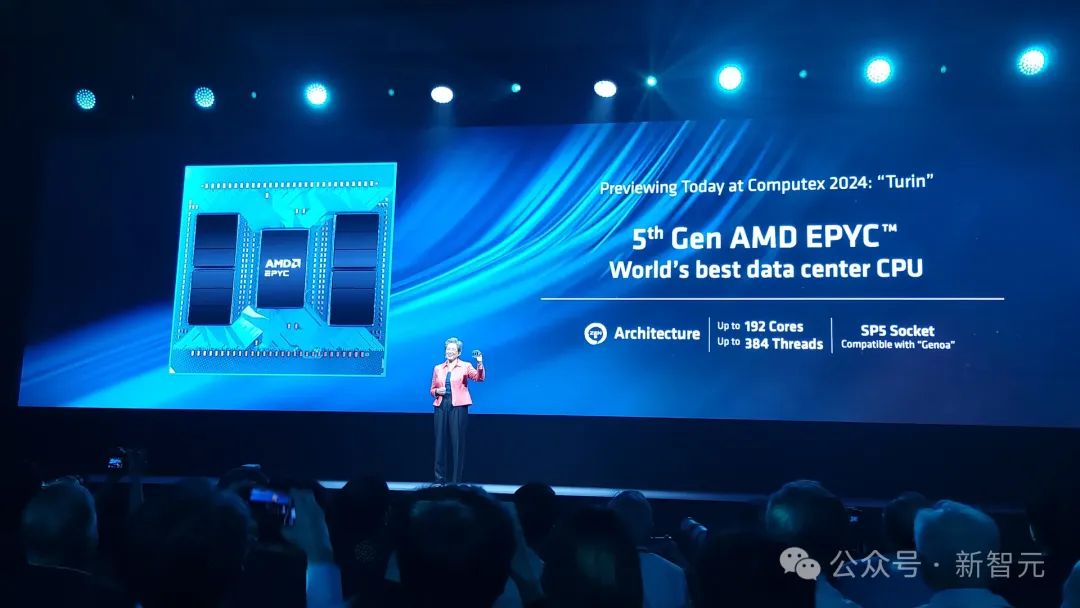

AMD在Computex主题演讲上大出风头,推出了首批Zen 5处理器,包括台式机用Ryzen 9000 CPU和笔记本电脑用Ryzen AI 300「Strix Point 」APU。除此之外,AMD还宣布了芯片年更计划以及备受期待的第五代EPYC Turin处理器。

医学影像,越来越需要AI的帮助了。

那个号称40年来最大技术架构变革的英特尔® 酷睿™ Ultra处理器,用起来到底怎样?

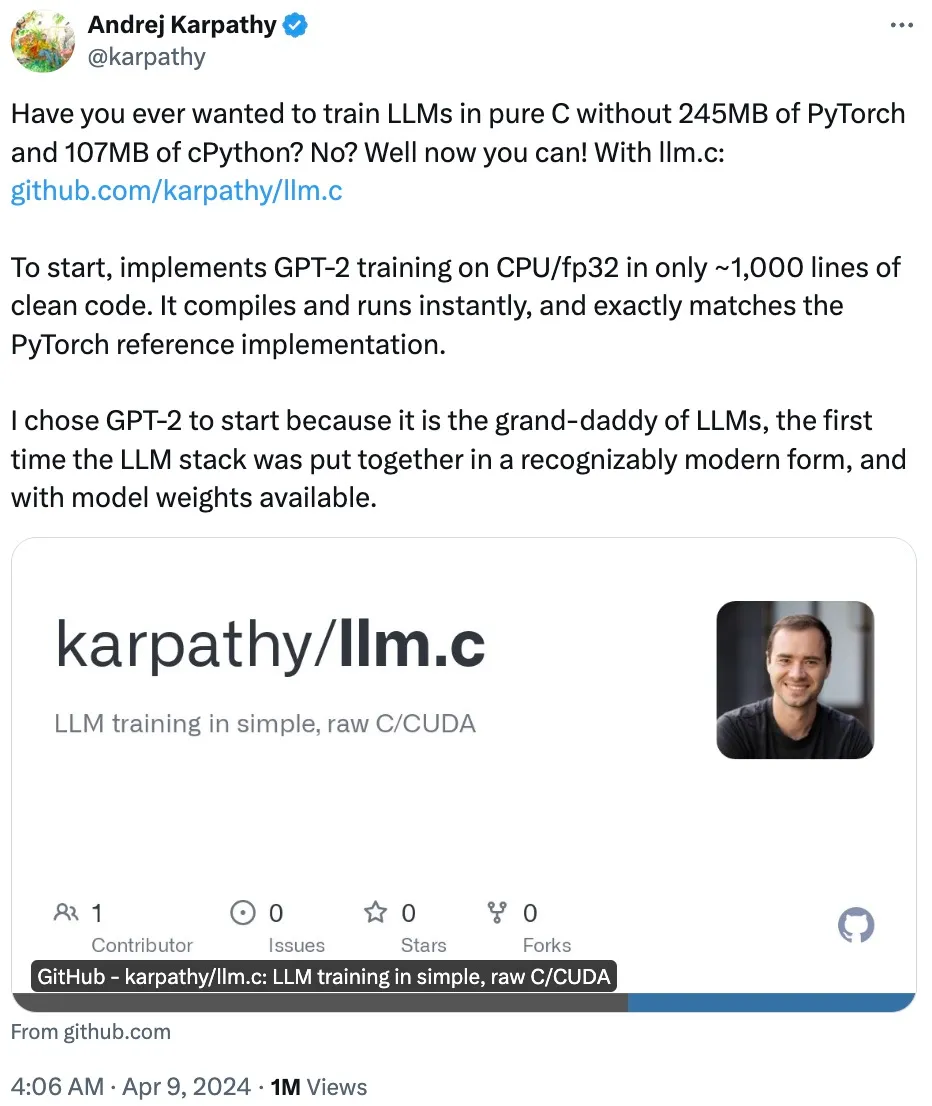

一个仅用 1000 行代码即可在 CPU/fp32 上实现 GPT-2 训练的项目「llm.c」

昨天的谷歌Next大会可是太精彩了,谷歌一连放出不少炸弹。 - 升级「视频版」Imagen 2.0,下场AI视频模型大混战 - 发布时被Sora光环掩盖的Gemini 1.5 Pro,正式开放 - 首款Arm架构CPU发布,全面对垒微软/亚马逊/英伟达/英特尔

近日,天才程序员Justine Tunney发推表示自己更新了Llamafile的代码,通过手搓84个新的矩阵乘法内核,将Llama的推理速度提高了500%!

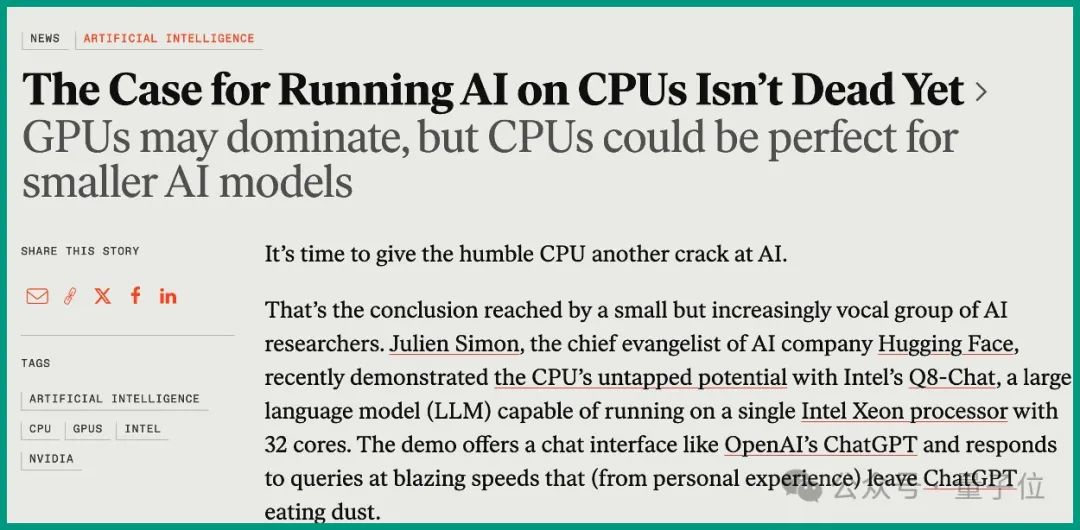

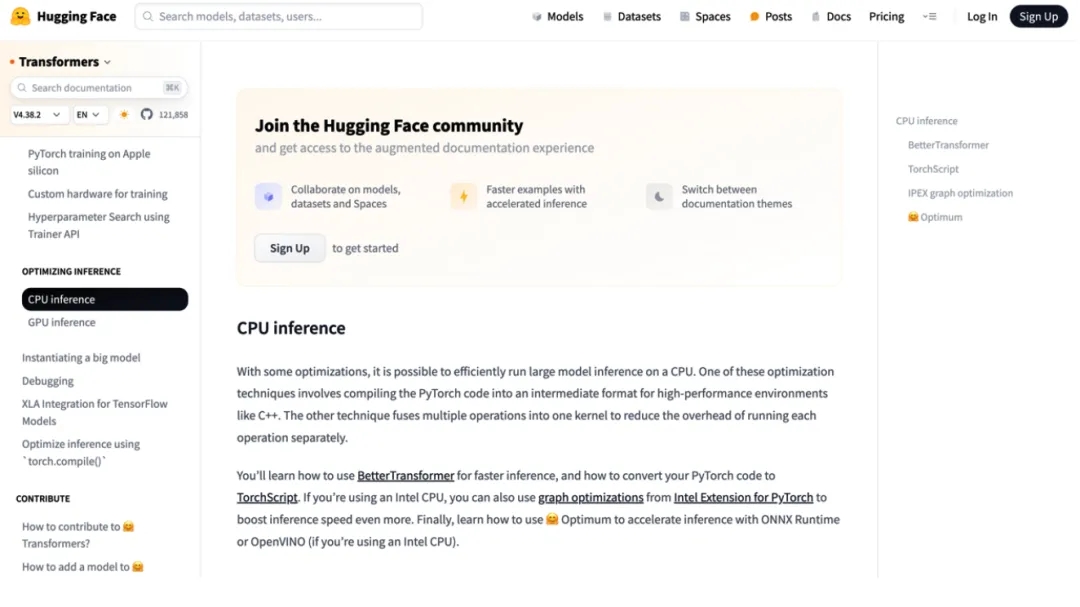

是时候让CPU在AI应用上 “支棱”起来了。

大模型的训练阶段我们选择GPU,但到了推理阶段,我们果断把CPU加到了菜单上。