深度 | OpenAI新董事兼CMU机器学习系主任:虽然数据有限,但AI性能不会停滞不前;LLM行业很可能会整合

深度 | OpenAI新董事兼CMU机器学习系主任:虽然数据有限,但AI性能不会停滞不前;LLM行业很可能会整合虽然数据有限,但AI性能不会停滞不前,我们当前的算法还没有从我们拥有的数据中最大限度地提取信息,还有更多的推论、推断和其他过程我们可以应用到我们当前的数据上,以提供更多的价值。

虽然数据有限,但AI性能不会停滞不前,我们当前的算法还没有从我们拥有的数据中最大限度地提取信息,还有更多的推论、推断和其他过程我们可以应用到我们当前的数据上,以提供更多的价值。

「多智能体系统」是人工智能领域最热门的流行词之一,也是开源框架 MetaGPT 、 Autogen 等研究的焦点。 但是,多智能体系统就一定是完美的吗 近日,来自卡内基梅隆大学的副教授 Graham Neubig 在文章《Don't Sleep on Single-agent Systems》中强调了单智能体系统也不可忽视。

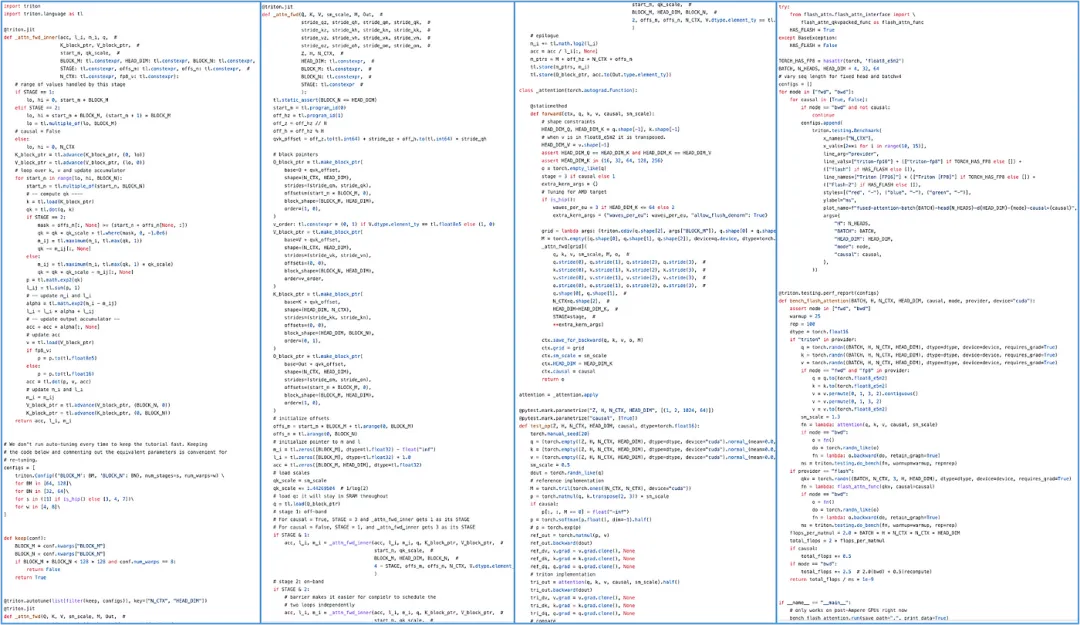

近日,来自 CMU 的 Catalyst Group 团队发布了一款 PyTorch 算子编译器 Mirage,用户无需编写任何 CUDA 和 Triton 代码就可以自动生成 GPU 内核,并取得更佳的性能。

Skild AI 是一家位于匹兹堡的初创公司,由两位前 CMU 教授创立,旨在打造具身智能的通用大脑。Skild 宣称其模型展示了无与伦比的泛化和涌现能力,并且有多于竞争对手 1000 倍的训练数据。

LLM数学水平不及小学生怎么办?CMU清华团队提出了Lean-STaR训练框架,在语言模型进行推理的每一步中都植入CoT,提升了模型的定理证明能力,成为miniF2F上的新SOTA。

就在刚刚,CMU教授Zico Kolter正式宣布加入OpenAI董事会,并成为安全与安保委员会成员。OpenAI这是终于要在安全上下功夫了?

为了解决这个问题,一些研究尝试通过强大的 Teacher Model 生成训练数据,来增强 Student Model 在特定任务上的性能。然而,这种方法在成本、可扩展性和法律合规性方面仍面临诸多挑战。在无法持续获得高质量人类监督信号的情况下,如何持续迭代模型的能力,成为了亟待解决的问题。

自回归训练方式已经成为了大语言模型(LLMs)训练的标准模式, 今天介绍一篇来自阿联酋世界第一所人工智能大学MBZUAI的VILA实验室和CMU计算机系合作的论文,题为《FBI-LLM: Scaling Up Fully Binarized LLMs from Scratch via Autoregressive Distillation》

Mamba模型由于匹敌Transformer的巨大潜力,在推出半年多的时间内引起了巨大关注。但在大规模预训练的场景下,这两个架构还未有「一较高低」的机会。最近,英伟达、CMU、普林斯顿等机构联合发表的实证研究论文填补了这个空白。

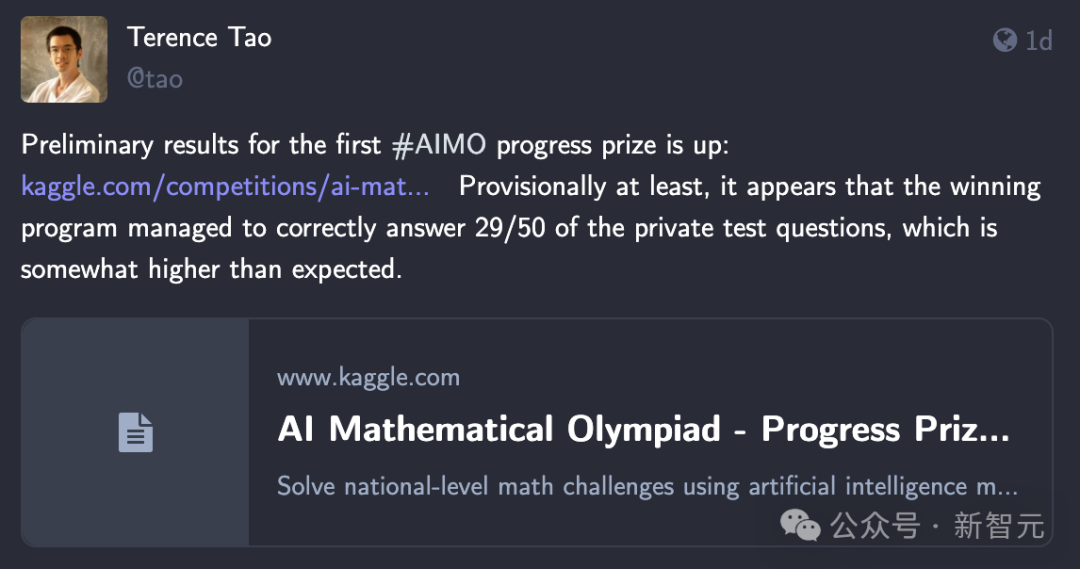

历经3个月,首届AI奥数竞赛终于公布最终结果了!Gemma 7B只能达到3/50正确率的题目中,第一名的Numina模型居然刷出了29/50的成绩。