苹果端侧AI两连发!模型体积减半、首字延迟降85倍,iPhone离线秒用

苹果端侧AI两连发!模型体积减半、首字延迟降85倍,iPhone离线秒用苹果在 Hugging Face上放大招了!这次直接甩出两条多模态主线:FastVLM主打「快」,字幕能做到秒回;MobileCLIP2主打「轻」,在 iPhone 上也能起飞。更妙的是,模型和Demo已经全开放,Safari网页就能体验。大模型,真·跑上手机了。

苹果在 Hugging Face上放大招了!这次直接甩出两条多模态主线:FastVLM主打「快」,字幕能做到秒回;MobileCLIP2主打「轻」,在 iPhone 上也能起飞。更妙的是,模型和Demo已经全开放,Safari网页就能体验。大模型,真·跑上手机了。

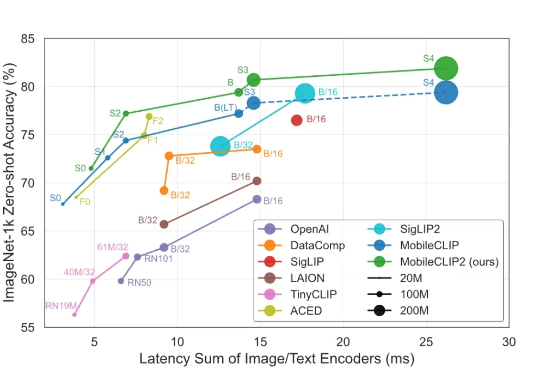

智东西9月1日消息,苹果又公布了大模型研发新进展! 8月28日,苹果在arXiv发布新论文,介绍新一代多模态基础模型MobileCLIP2及其背后的多模态强化训练机制,同天在GitHub、Hugging Face上开源了模型的预训练权重和数据生成代码。

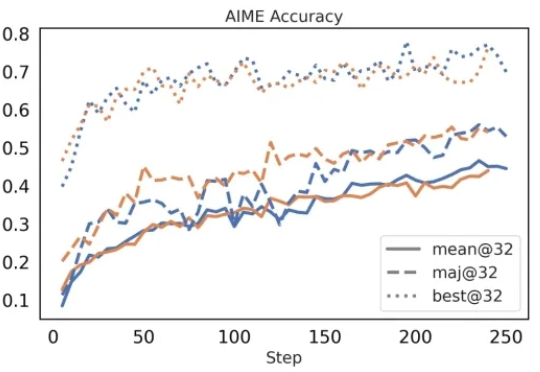

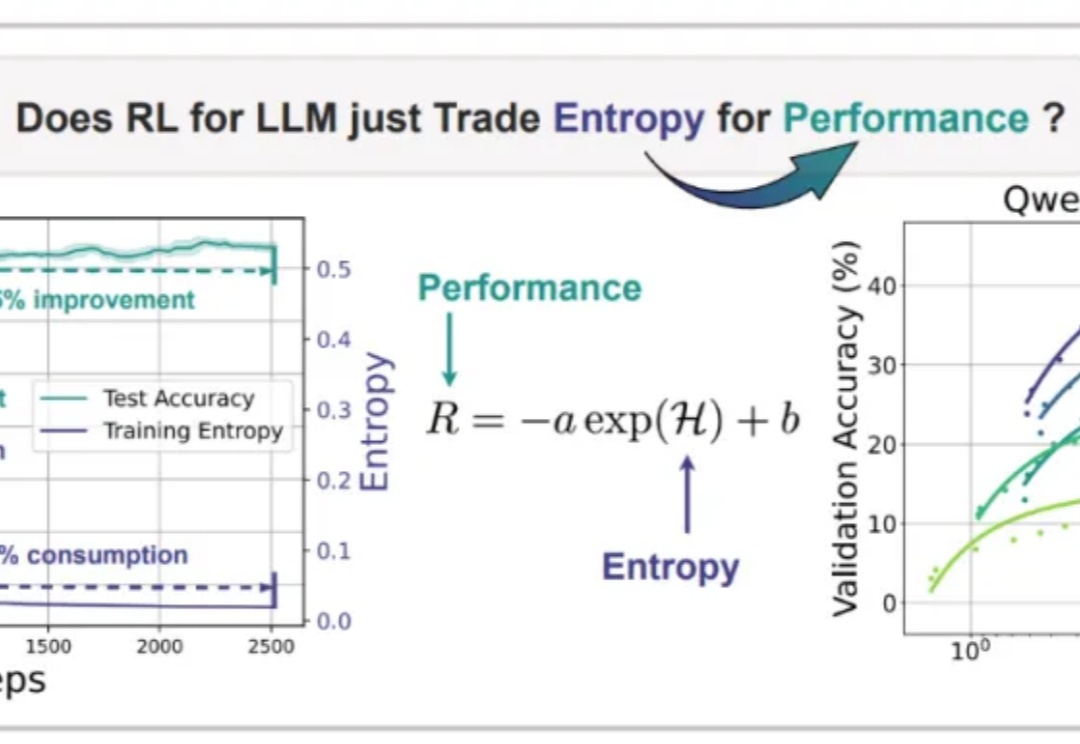

在今年三月份,清华 AIR 和字节联合 SIA Lab 发布了 DAPO,即 Decoupled Clip and Dynamic sAmpling Policy Optimization(解耦剪辑和动态采样策略优化)。

在人工智能领域,对比语言 - 图像预训练(CLIP) 是一种流行的基础模型,由 OpenAI 提出

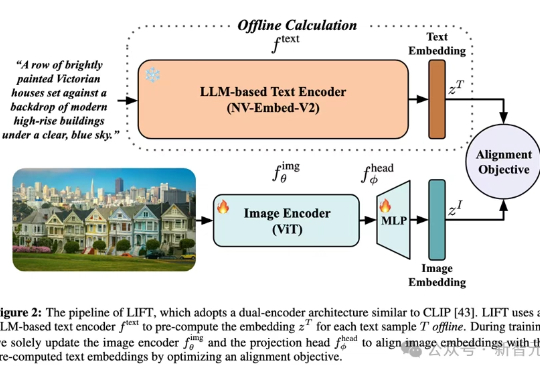

多模态对齐模型借助对比学习在检索与生成任务中大放异彩。最新趋势是用冻结的大语言模型替换自训文本编码器,从而在长文本与大数据场景中降低算力成本。LIFT首次系统性地剖析了此范式的优势来源、数据适配性、以及关键设计选择,在组合语义理解与长文本任务上观察到大幅提升。

最近,硅谷的一家新成立的名叫「Genesis AI」的公司吸引了我们的注意,他们在最近的种子轮融资中拿到了 1.05 亿美元。据外媒 TechCrunch 报道,这轮融资由美国顶级风投机构 Khosla Ventures、Eclipse 联合领投。前者是 OpenAI 的最早的机构投资者,后者是特斯拉产业背景团队机器人赛道的专业机构。

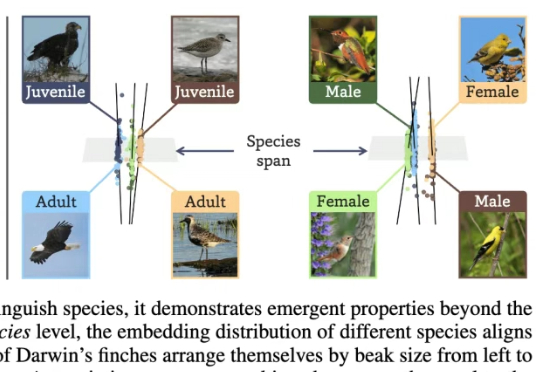

让AI看懂95万物种,并自己悟出生态关系与个体差异!俄亥俄州立大学研究团队在2亿生物图像数据上训练了BioCLIP 2模型。大规模的训练让BioCLIP 2取得了目前最优的物种识别性能。

Nature never undertakes any change unless her interests are served by an increase in entropy. 自然界的任何变化,唯有在熵增符合其利益时方会发生——Max Planck

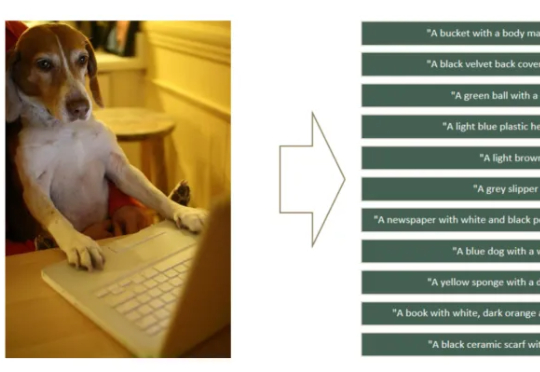

如何让CLIP模型更关注细粒度特征学习,避免“近视”?360人工智能研究团队提出了FG-CLIP,可以明显缓解CLIP的“视觉近视”问题。让模型能更关注于正确的细节描述,而不是更全局但是错误的描述。

在复杂、未知的现实环境中,传统导航方法往往依赖闭集语义或事先构建的地图,难以实现真正的“按需探索”。为打破这一瓶颈,本文提出了 FindAnything ——一套融合视觉语言模型的对象为中心、开放词汇三维建图与探索系统。