生成与理解相互促进!华科字节提出Liquid,揭示统一多模态模型尺度规律!

生成与理解相互促进!华科字节提出Liquid,揭示统一多模态模型尺度规律!近年来大语言模型(LLM)的迅猛发展正推动人工智能迈向多模态融合的新纪元。然而,现有主流多模态大模型(MLLM)依赖复杂的外部视觉模块(如 CLIP 或扩散模型),导致系统臃肿、扩展受限,成为跨模态智能进化的核心瓶颈。

近年来大语言模型(LLM)的迅猛发展正推动人工智能迈向多模态融合的新纪元。然而,现有主流多模态大模型(MLLM)依赖复杂的外部视觉模块(如 CLIP 或扩散模型),导致系统臃肿、扩展受限,成为跨模态智能进化的核心瓶颈。

AI 硬件——一个共识大于非共识的投资主题,尤其是 CES 之后。相比单纯的模型或者软件服务,硬件的确存在新的适合创业者发挥的空间和机会。

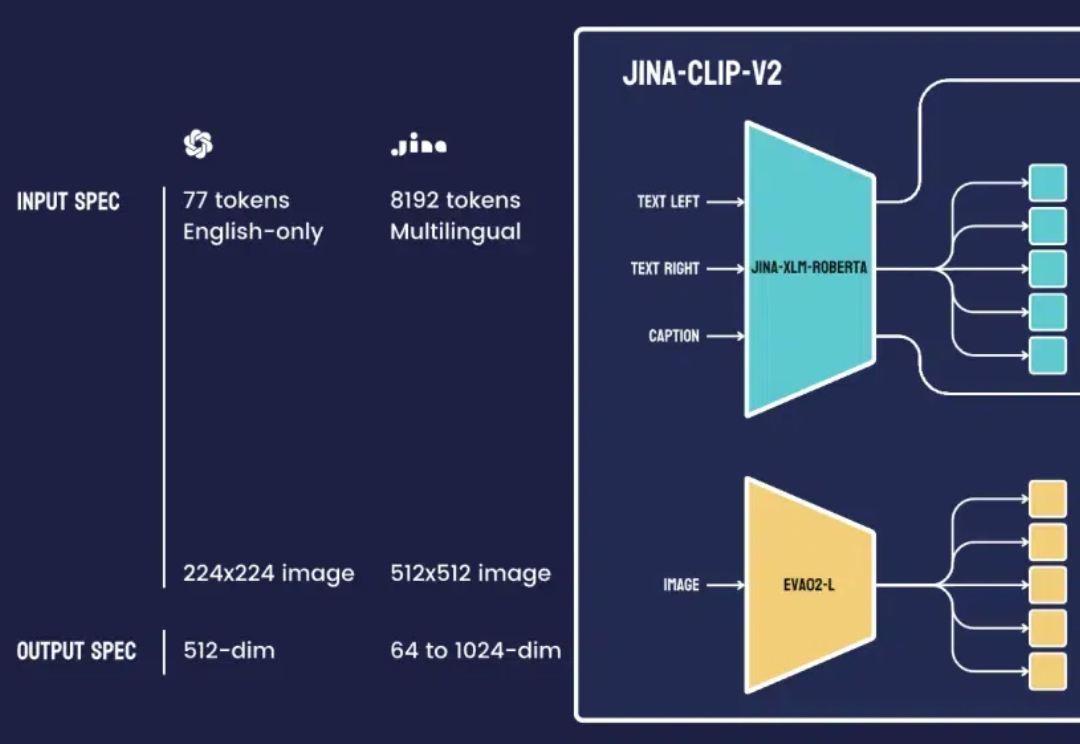

最近,我们团队的一位工程师在研究类 ColPali 模型时,受到启发,用新近发布的 jina-clip-v2 模型做了个颇具洞察力的可视化实验。

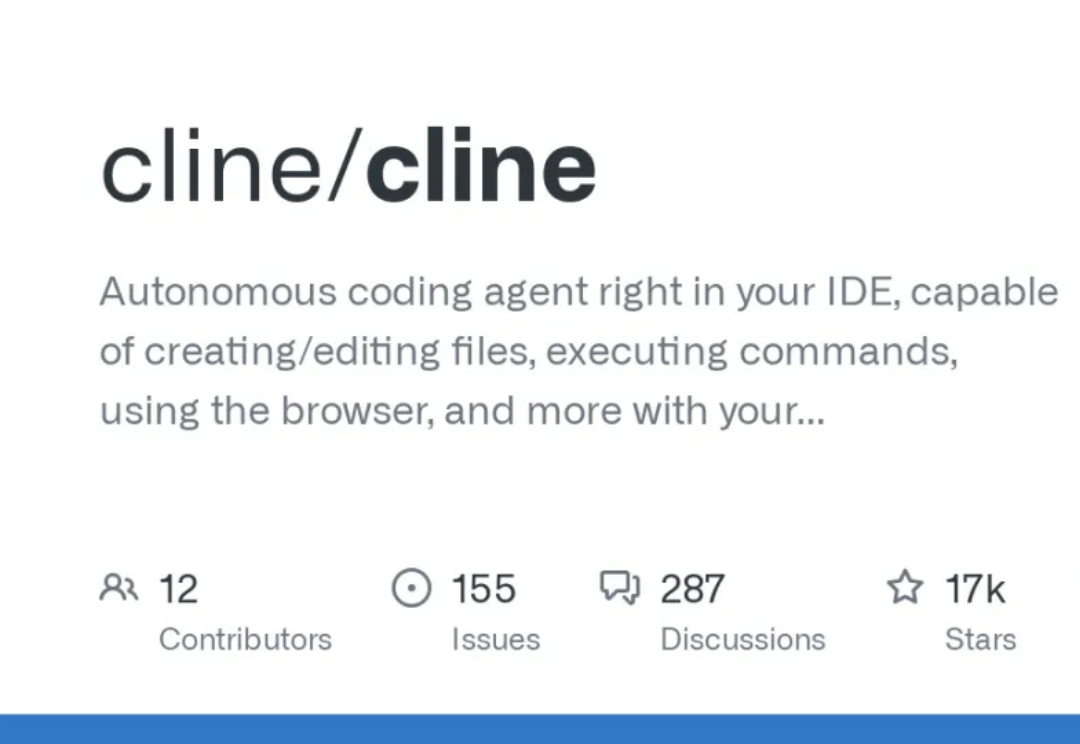

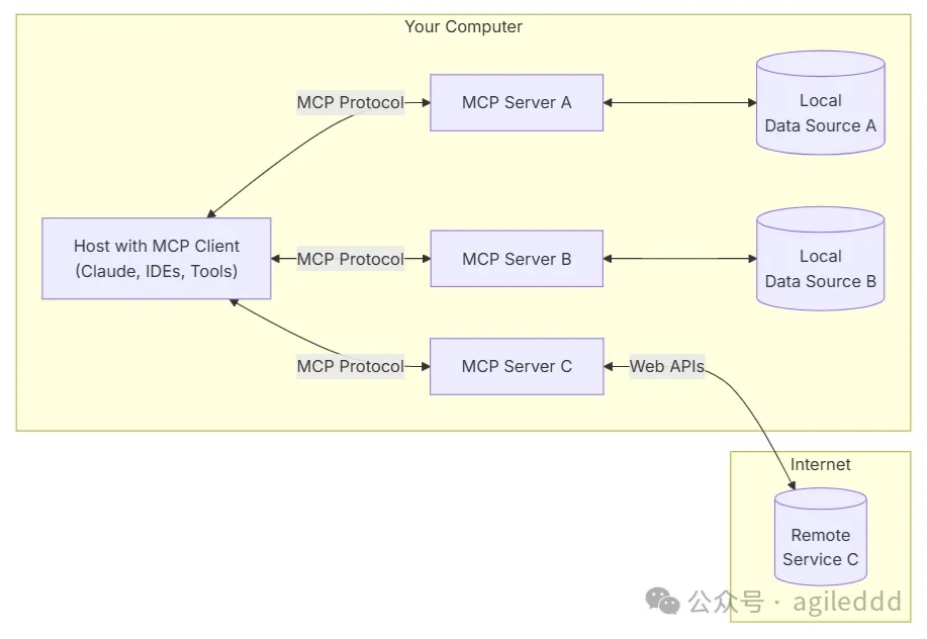

还在为每个月20美元的Cursor订阅费发愁吗?还在担心代码被上传到国外服务器?今天给大家介绍一个既省钱又安全的神器组合 - Cline+DeepSeek V3。

随着人工智能技术的不断进步,构建个性化智能体的需求日益增加。国内虽然已有一些智能体平台,如豆包扣子,但这些平台要求开发者将代码和数据上传到第三方服务器,对于一些商业信息敏感的客户来说,这种做法可能带来数据泄露的风险。

最引人注目四笔过亿(刀乐)投资,其中三家是依靠AI驱动业务,另外一家也是早就布局AI。还是要感谢生成式AI,2024年又开始有人愿意大笔投资法律科技了!

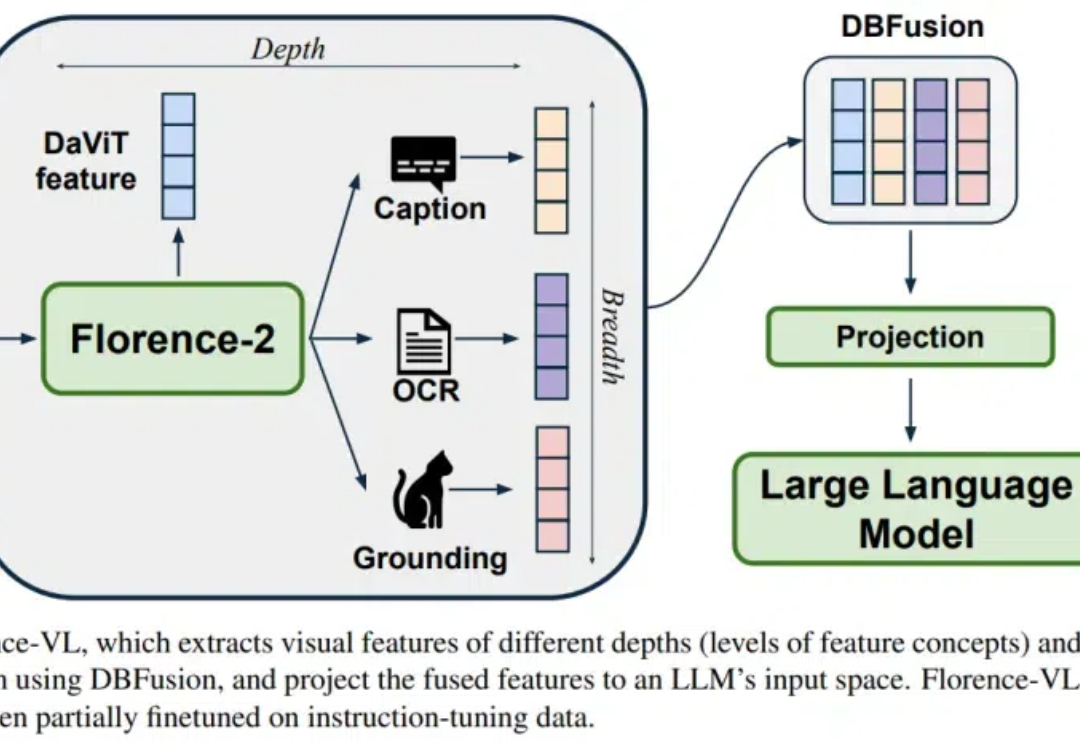

Florence-VL 提出了使用生成式视觉编码器 Florence-2 作为多模态模型的视觉信息输入,克服了传统视觉编码器(如 CLIP)仅提供单一视觉表征而往往忽略图片中关键的局部信息。

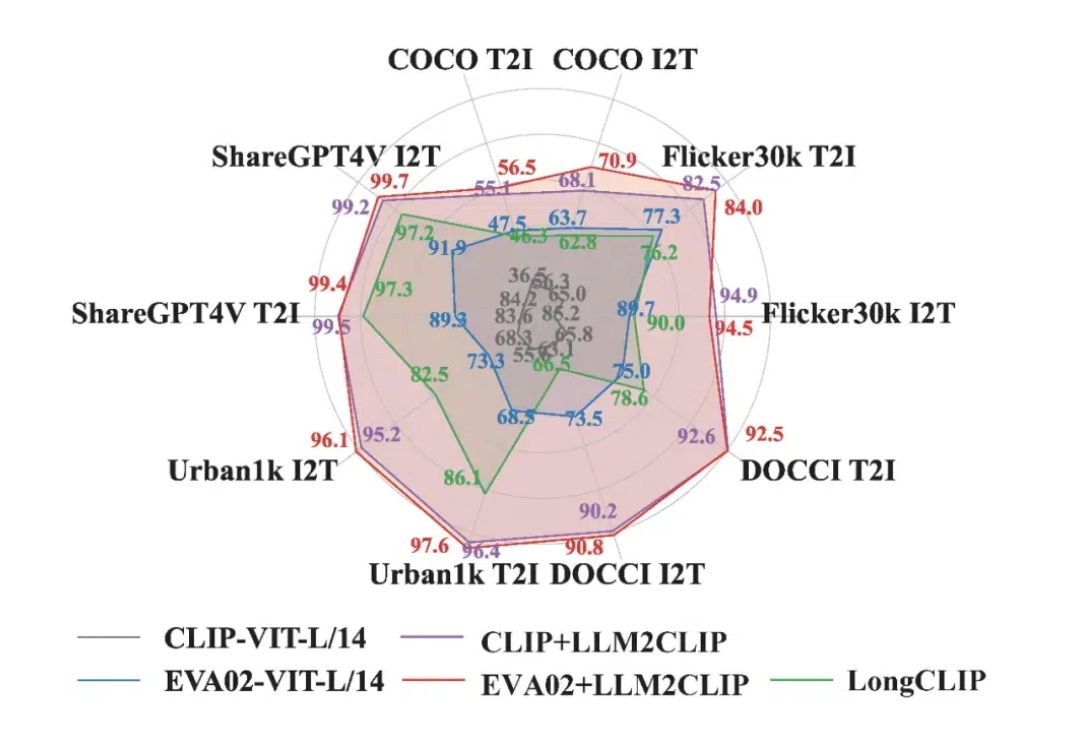

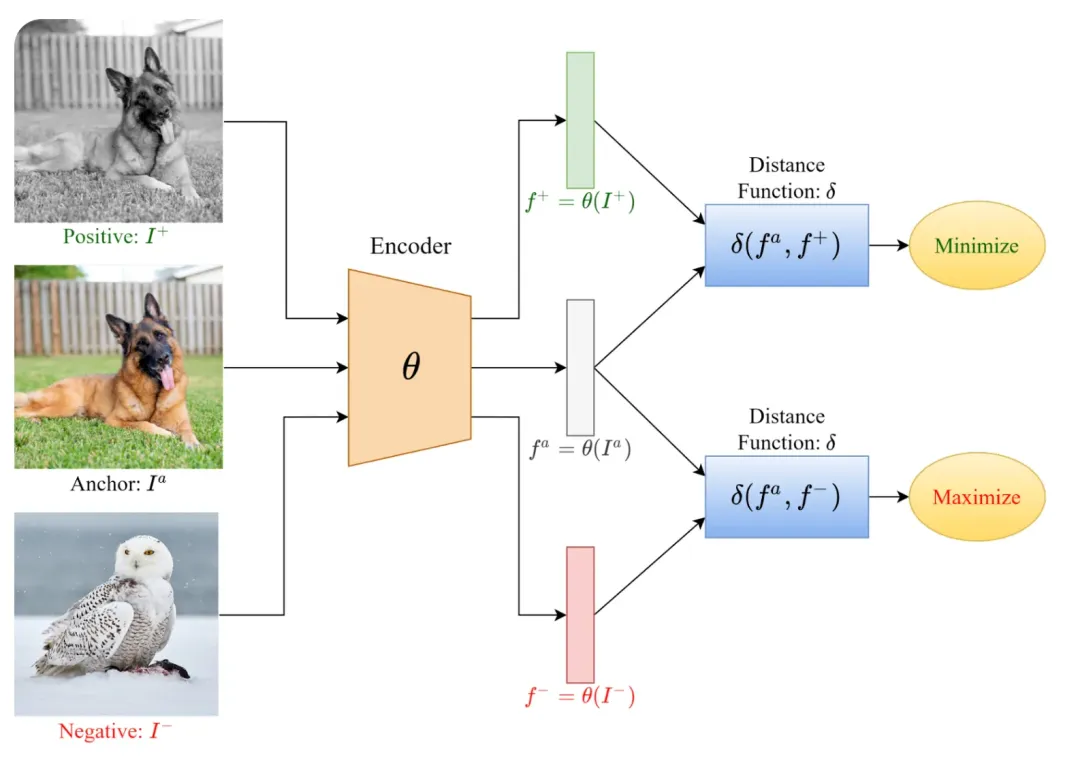

在当今多模态领域,CLIP 模型凭借其卓越的视觉与文本对齐能力,推动了视觉基础模型的发展。CLIP 通过对大规模图文对的对比学习,将视觉与语言信号嵌入到同一特征空间中,受到了广泛应用。

AI剪辑,一条闷声赚大钱的赛道。

「多模态」这个词,相信各位开发者已经比较熟悉了,多模态的含义是让 AI 同时理解包含如图像和文本在内的多种类型的数据。