7B小模型写好学术论文,新框架告别AI引用幻觉,实测100%学生认可引用质量

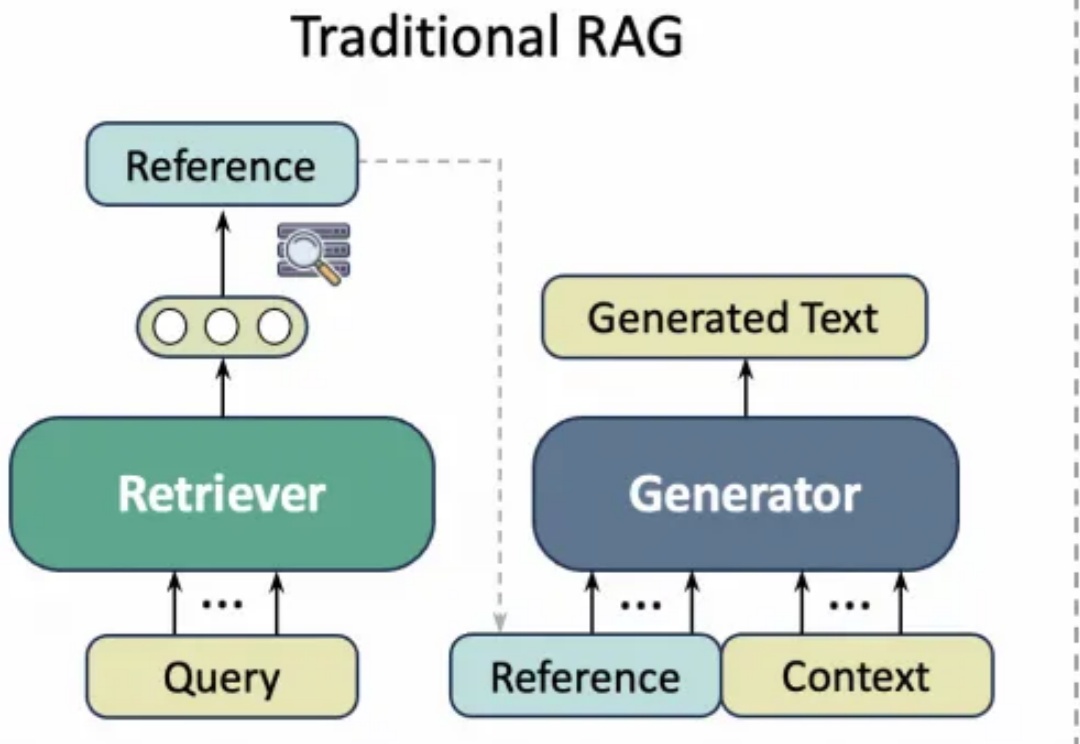

7B小模型写好学术论文,新框架告别AI引用幻觉,实测100%学生认可引用质量学术写作通常需要花费大量精力查询文献引用,而以ChatGPT、GPT-4等为代表的通用大语言模型(LLM)虽然能够生成流畅文本,但经常出现“引用幻觉”(Citation Hallucination),即模型凭空捏造文献引用。这种现象严重影响了学术论文的可信度与专业性。

学术写作通常需要花费大量精力查询文献引用,而以ChatGPT、GPT-4等为代表的通用大语言模型(LLM)虽然能够生成流畅文本,但经常出现“引用幻觉”(Citation Hallucination),即模型凭空捏造文献引用。这种现象严重影响了学术论文的可信度与专业性。

谷歌Deep Research重大升级,搭载全球顶尖Gemini 2.5 Pro模型。5分钟生成46页学术论文、复杂报告转为10分钟播客。性能超OpenAI DR 40%,价格仅为其1/10。

好消息,由谷歌最新的 Gemini 2.5 Pro 模型提供支持的 Deep Research(深度研究)正式发布!坏消息,目前仅 Gemini Advanced 付费会员可体验。

刚刚,alphaXiv 推出了新功能「Deep Research for arXiv」,该功能可协助研究人员更高效地在 arXiv 平台上进行学术论文的检索与阅读,显著提升文献检索及研究效率。

Agentic AI 的 3 要素是:tool use,memory 和 context,围绕这三个场景会出现 agent-native Infra 的机会。

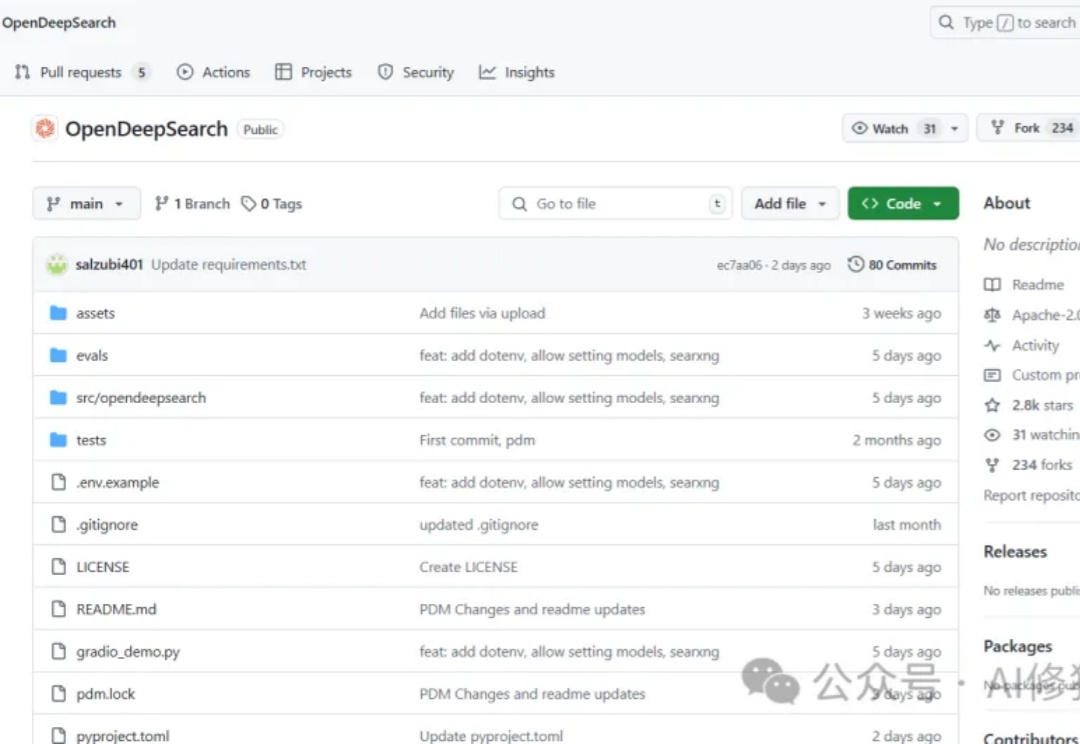

当前搜索AI市场面临着一个显著的断层:Perplexity的Sonar Reasoning Pro和OpenAI的GPT-4o Search Preview等专有解决方案与开源替代品之间存在巨大差距。这些封闭式系统虽然表现优异,但却限制了透明度、创新和创业自由。作为一名正在开发Agent产品的工程师,你是否曾经渴望拥有一个功能强大且完全开放的搜索框架?

在主流电商平台,Go2 目前起售价接近 1 万块,与一张普通显卡的价格相当,这个价位也让其更像是一款面向市场的、相对高端的消费电子产品。或许正是因为 Go2 价格相对「亲民」且定位贴近大众,知名维修网站 iFixit 也将目光投向了这款机器狗,并特别邀请了机器人专家 Marcel Stieber 对其进行了一次深入的拆解。

OpenAI o3推理成本从3000美元飙至3万美元,暴增10倍。o3-high靠暴力试错生成4300万字解题,却被ARC-AGI「除名」。

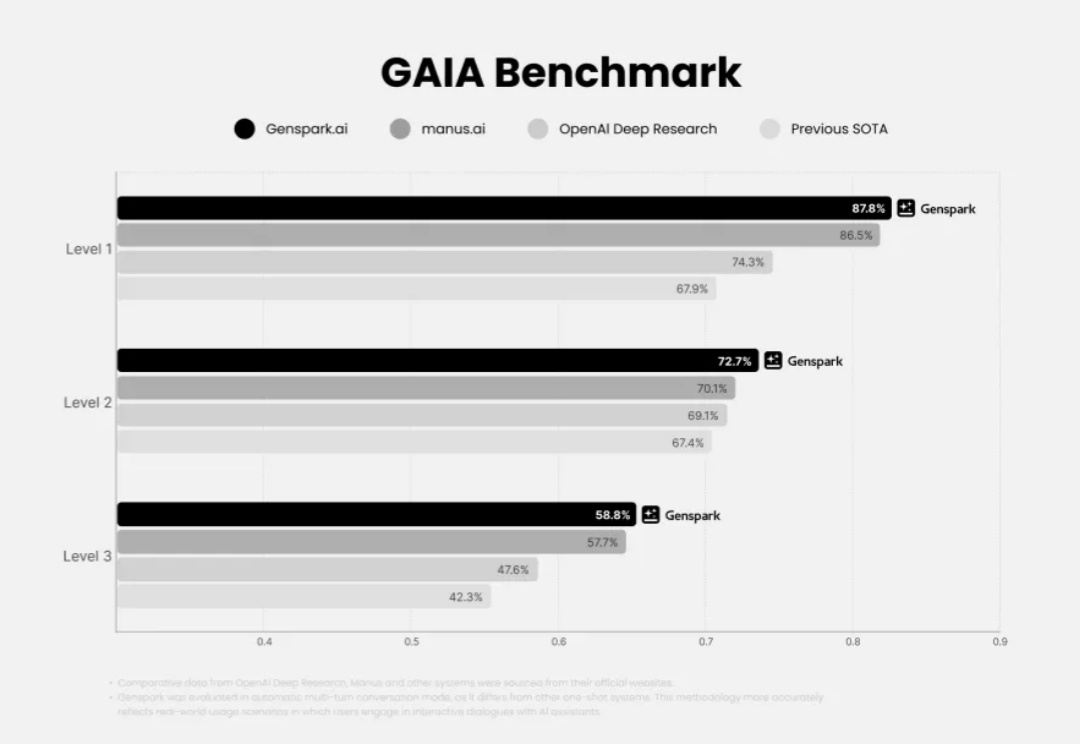

Genspark 是啥?我们在去年 6 月就有过介绍,Genspark 是由前百度小度的 CEO 景鲲和 CTO 朱凯华创业做的 Agent 产品,去年刚开始的定位还是 Agent Search Engine,到了今天升级了不少。并且在今年三月,官宣拿到了一亿美金的 A 轮融资。

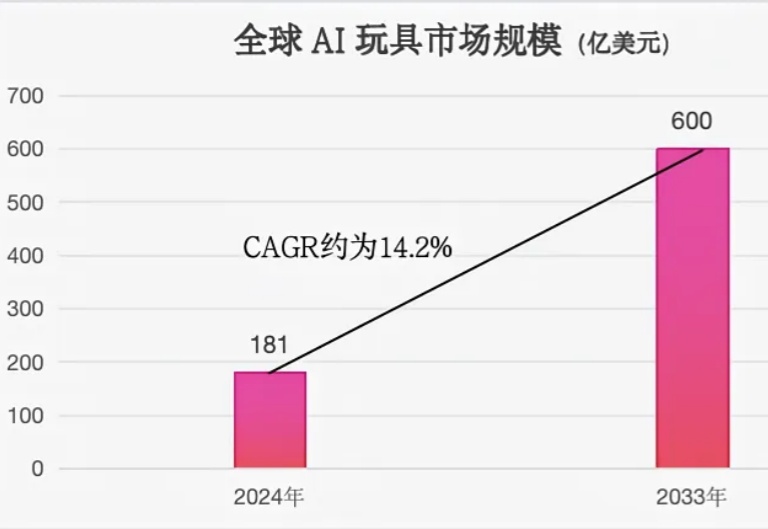

2025 年,DeepSeek 爆火带动传统产品的智能化升级,如传统玩具向 AI 玩具转型。央视新闻调查数据显示,2025 年 1 月,国内某电商平台面向 3-6 岁儿童的 AI 早教玩具销量环比增长 6 倍。咨询公司 IMARC 的预测数据显示,2024 年全球 AI 玩具市场规模已达 181 亿美元,预计到 2033 年将增长至 600 亿美元。