被冠上“最强图像AI”称号的FLUX,好像也就那样

被冠上“最强图像AI”称号的FLUX,好像也就那样大家还记得 Stable Diffusion嘛,就是那个曾经和 DALL·E 、 Midjourney 齐名的图像生成 AI 。

大家还记得 Stable Diffusion嘛,就是那个曾经和 DALL·E 、 Midjourney 齐名的图像生成 AI 。

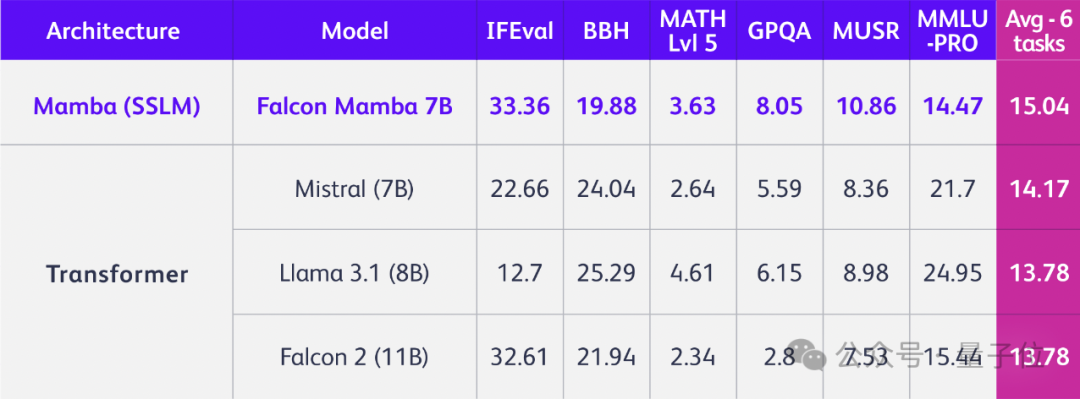

TII开源全球第一个通用的大型Mamba架构模型Falcon Mamba 7B,性能与Transformer架构模型相媲美,在多个基准测试上的均分超过了Llama 3.1 8B和Mistral 7B。

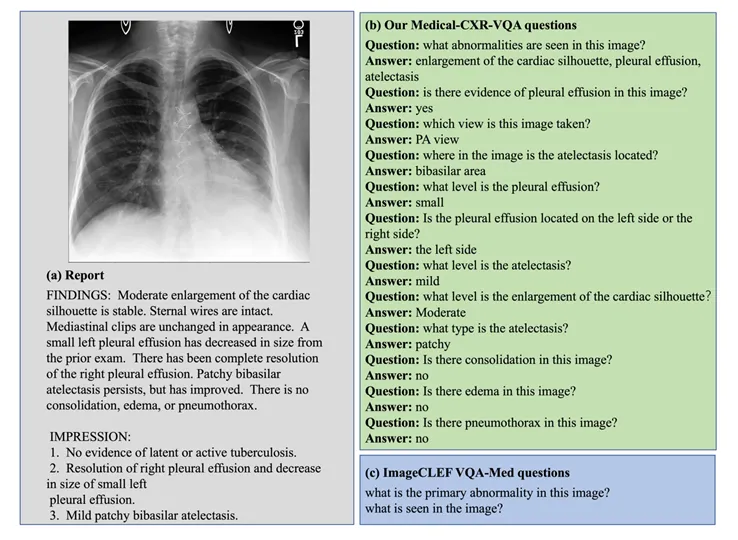

只用提示词,多模态大模型就能更懂场景中的人物关系了。

只是换掉Transformer架构,立马性能全方位提升,问鼎同规模开源模型!

今年 3 月份,英伟达 CEO 黄仁勋举办了一个非常特别的活动。他邀请开创性论文《Attention Is All You Need》的作者们齐聚 GTC,畅谈生成式 AI 的未来发展方向。

2017 年,谷歌在论文《Attention is all you need》中提出了 Transformer,成为了深度学习领域的重大突破。该论文的引用数已经将近 13 万,后来的 GPT 家族所有模型也都是基于 Transformer 架构,可见其影响之广。 作为一种神经网络架构,Transformer 在从文本到视觉的多样任务中广受欢迎,尤其是在当前火热的 AI 聊天机器人领域。

爆款AI应用开发者来晒收入了:

在过去的几年中,大型语言模型(Large Language Models, LLMs)在自然语言处理(NLP)领域取得了突破性的进展。这些模型不仅能够理解复杂的语境,还能够生成连贯且逻辑严谨的文本。

如果我们今天要谈论科技或风险投资,那么接下来的话题只会让我们想到 AI.

多模态大语言模型 (Multimodal Large Language Moodel, MLLM) 以其强大的语言理解能力和生成能力,在各个领域取得了巨大成功。