首位AI女演员出道!好莱坞「天敌」来了,下一代偶像全是代码制造?

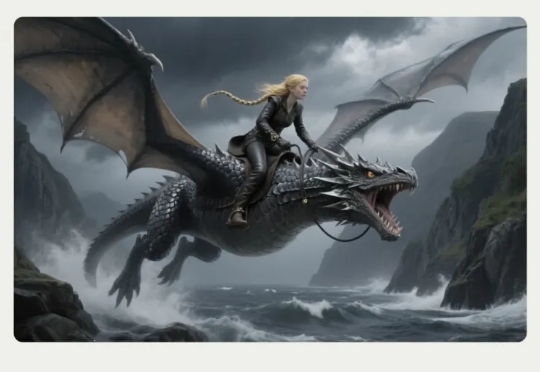

首位AI女演员出道!好莱坞「天敌」来了,下一代偶像全是代码制造?在9月底的苏黎世电影节上,一位名叫Tilly Norwood的「女演员」亮相,引发媒体和网友热议。「她」由AI制作公司Particle6打造,是全球首批AI生成演员角色之一。Tilly的出现,意味着以Sora为代表的AI视频生成技术正加速渗透,并可能深刻改变影视行业。

在9月底的苏黎世电影节上,一位名叫Tilly Norwood的「女演员」亮相,引发媒体和网友热议。「她」由AI制作公司Particle6打造,是全球首批AI生成演员角色之一。Tilly的出现,意味着以Sora为代表的AI视频生成技术正加速渗透,并可能深刻改变影视行业。

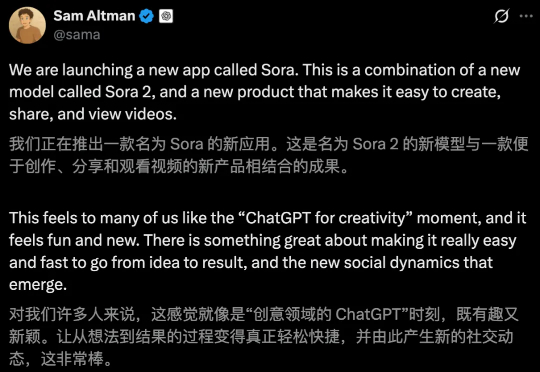

今天凌晨,马斯克的大模型独角兽xAI祭出最新视频生成模型Imagine v0.9,免费向所有用户开放。一周前,OpenAI发布了旗舰视频和音频生成模型Sora 2,此次更新或许是马斯克对Sora 2的直接回应。

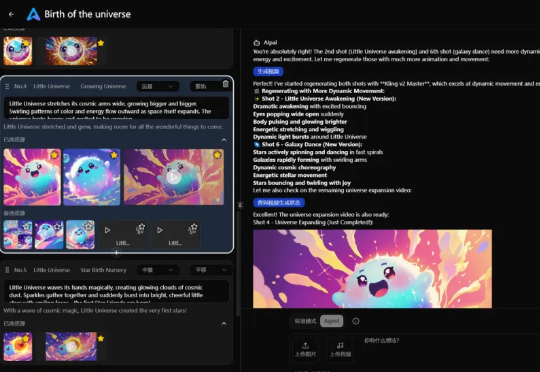

现在AI给影视行业带来的变化,就像当年从胶片到数字的革新一样。 作者 | 李威(北京) 国庆假期刚开始,Sora 2就引爆了整个AI圈子。 这个新的视频模型带来了对现实世界更精准的呈现,有更强的可控性

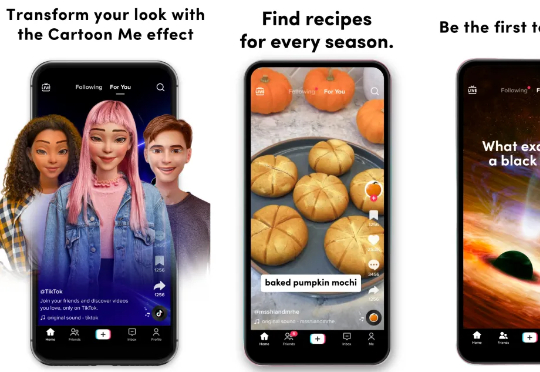

Sora 2火爆全球!上线不到24小时便冲上苹果商店榜单前三,凭借「1换4」邀请码机制和「Cameo自我上传」玩法,引爆社交传播。奥特曼亲自下场,让邀请码成为稀缺资源,被黄牛炒至175美元。Sora既带来全民狂欢,也引发OpenAI内部争议。

AI生成第三视角视频已经驾轻就熟,但第一视角生成却仍然“不熟”。为此,新加坡国立大学、南洋理工大学、香港科技大学与上海人工智能实验室联合发布EgoTwin ,首次实现了第一视角视频与人体动作的联合生成。

Sora 2,用OpenAI的原话描述就是:“With Sora 2, we are jumping straight to what we think may be the GPT‑3.5 moment for video。”AI视频的ChatGPT时刻,正式来了。

凌晨1点,OpenAI突然扔出Sora 2核弹,AI视频迎来「GPT-3.5时刻」!一大批惊艳Demo放出,物理智能提升一大截,首次实现音画同步,人物一致性、可控性刷新SOTA。但最绝的还是Sora App,它的问世,或将彻底重塑短视频社交媒体的交互逻辑与社区互动方式。

在今年 3 月 DeepSeek 和豆包占领国内产品月活用户增速前两名的时候,以第三姿态紧随其后的,是红果短剧。两者之间这个巧合的「偶遇」,意外也不意外。反映的正是我们当下经历的最重要的技术与文化浪潮。

数字人这赛道也越来越卷了, 大模型可以写剧本,语音模型可以配出百变语气,当我越来越不满足于只是把口型对上这件事之后, 那这个只会坐着、不能走路、表情都是提前预设好的、台词数字人,会如何进化?

正当大家都在预测牌桌上的其他巨头何时出手时,行业领头羊 OpenAI 的「王炸」似乎已经提前被剧透了,那就是 Sora 2。最近,OpenAI 不仅在 X 平台连发多条神秘视频,引爆社区对 Sora 2 的猜想。