Agent RL和智能体自我进化的关键一步: TaskCraft实现复杂智能体任务的自动生成

Agent RL和智能体自我进化的关键一步: TaskCraft实现复杂智能体任务的自动生成近年来,基于智能体的强化学习(Agent + RL)与智能体优化(Agent Optimization)在学术界引发了广泛关注。然而,实现具备工具调用能力的端到端智能体训练,首要瓶颈在于高质量任务数据的极度稀缺。

近年来,基于智能体的强化学习(Agent + RL)与智能体优化(Agent Optimization)在学术界引发了广泛关注。然而,实现具备工具调用能力的端到端智能体训练,首要瓶颈在于高质量任务数据的极度稀缺。

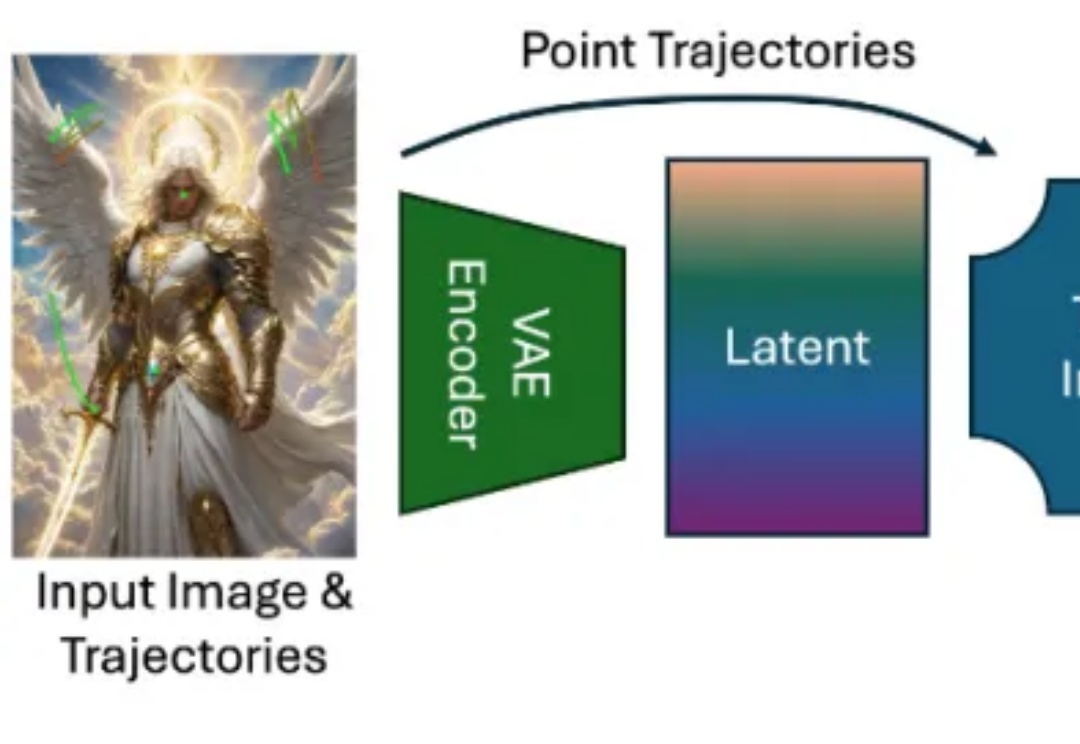

近年来,随着扩散模型(Diffusion Models)、Transformer 架构与高性能视觉理解模型的蓬勃发展,视频生成任务取得了令人瞩目的进展。从静态图像生成视频的任务(Image-to-Video generation)尤其受到关注,其关键优势在于:能够以最小的信息输入生成具有丰富时间连续性与空间一致性的动态内容。

AI 行业的挖人大戏仍在继续上演。 据 The Information 报道,Anthropic Claude Code 的两位负责人被 AI 编程应用 Cursor 的开发商 Anysphere 挖走了。

AI 会计初创公司 Campfire 于 6 月 30 日宣布完成 3500 万美元 A 轮融资,由 Accel 领投,Foundation Capital、Y Combinator、Capital 49 以及 Mercury 首席财务官 Dan Kang 等天使投资人跟投。

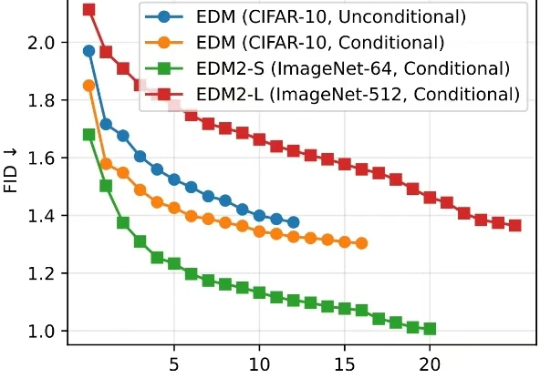

清华大学朱军教授团队与 NVIDIA Deep Imagination 研究组联合提出一种全新的视觉生成模型优化范式 —— 直接判别优化(DDO)。

随着2025年的时间推进,我身边很多人投入做AI产品的产品经理都会遇到各种各样的困难,跟他们沟通后,我发现主要就3点限制,如果你也打算做AI产品,这篇文章可以帮助你少走弯路,至少在产品定位上,你可以更好的决定是做native AI还是AI+产品。

这是我关于「AI Native 系列」的第二篇文章,主题是:行动闭环。在上一篇里,我讲了什么样的产品才算得上真正的 AI Native,分享了我对 MCP 协议、AI 架构原生性和任务闭环的理解。

再一次,Meta「搜刮」了 OpenAI 的成员。The Information 发布了文章,谈到 Meta 再聘四名 OpenAI 研究人员。这离上一次 OpenAI 苏黎世办公室被 Meta 一锅端只隔了短短几天时间。

又一家A股上市公司冲刺“A+H”!6月26日,上海AI产品公司合合信息递表港交所。招股书显示,合合信息是一家原生AI(AI-native)公司,已成为全球多模态大模型文本智能技术的领先者,业务已覆盖全球超过200个国家和地区,3款C端产品拥有数亿全球用户群,是少有的同时在中国和全球拥有成规模用户量的原生AI公司。

全网翘首以盼的DeepSeek-R2,再次被曝推迟!据The Information报道,由于DeepSeek CEO梁文锋始终对R2的表现不满意,因此R2迟迟未能发布。此外,他们还援引两位国内知情人士的消息称,R2研发进程缓慢可能是由于缺少英伟达H20芯片。