刚刚,蝉联Future X全球榜首的MiroMind发布全球最强搜索智能体模型

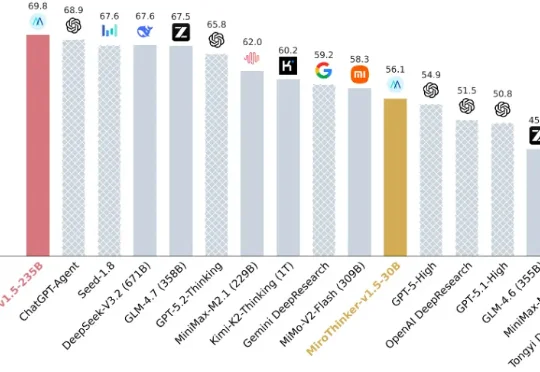

刚刚,蝉联Future X全球榜首的MiroMind发布全球最强搜索智能体模型凭借成功预测 Polymarket 题目,连续登顶 Future X 全球榜首的 MiroMind 团队,于今日(1 月 5 日)正式发布其自研旗舰搜索智能体模型 MiroThinker 1.5。MiroThinker-v1.5-30B 仅用 1/30 的参数规模跑出了比肩众多 1T 模型的性能表现,其 235B 的版本在多个搜索智能体基准测试中跻身全球第一梯队。