颤抖吧,Bug!OpenAI放出GPT-5「夜行神兽」,命中92%漏洞

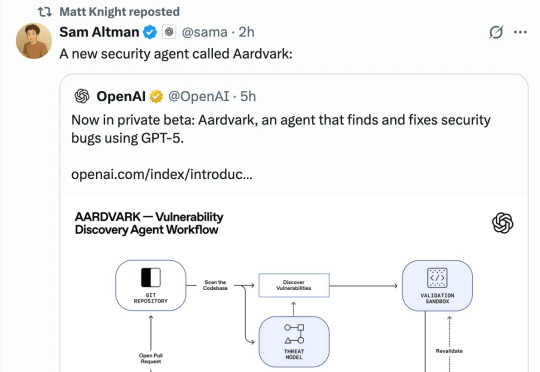

颤抖吧,Bug!OpenAI放出GPT-5「夜行神兽」,命中92%漏洞刚刚,OpenAI推出了使用GPT-5寻找和修复安全漏洞的智能体Aardvark。目前,Aardvark还处于beta测试阶段。OpenAI称,Aardvark开创了「防御者优先」的新范式:作为自主安全研究智能体,随代码不断演化,为团队提供持续保护(continuous protection)。

刚刚,OpenAI推出了使用GPT-5寻找和修复安全漏洞的智能体Aardvark。目前,Aardvark还处于beta测试阶段。OpenAI称,Aardvark开创了「防御者优先」的新范式:作为自主安全研究智能体,随代码不断演化,为团队提供持续保护(continuous protection)。

月之暗面在这一方向有所突破。在一篇新的技术报告中,他们提出了一种新的混合线性注意力架构 ——Kimi Linear。该架构在各种场景中都优于传统的全注意力方法,包括短文本、长文本以及强化学习的 scaling 机制。

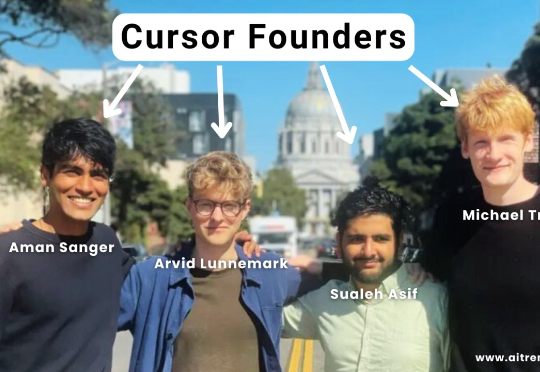

美国当地时间 10 月 29 日,据外媒消息,AI 编码工具 Cursor 背后的公司 Anysphere 的联合创始人 Arvid Lunnemark 已离职。Cursor 最初由四位联合创始人创立,除了 Lunnemark 之外,还有 Aman Sanger、Michael Truell 和 Sualeh Asif。

AI Coding火了大半年,AI Debugging也来了!刚刚,OpenAI发布由GPT-5驱动的“白帽”Agent——Aardvark(土豚)。这只“AI安全研究员”能帮助开发者和安全团队,在大规模代码库中自动发现并修复安全漏洞。

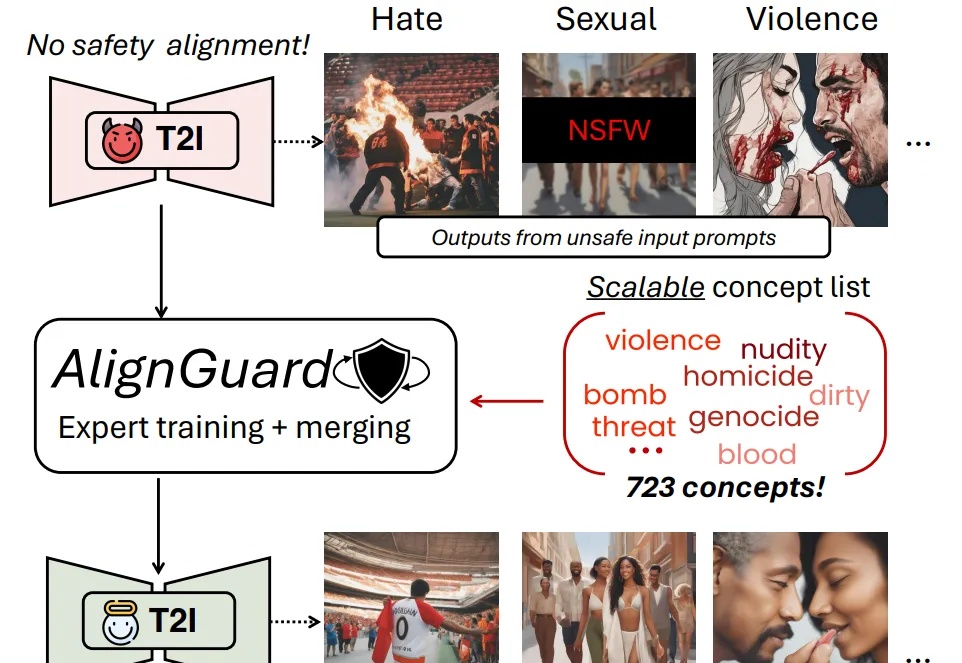

随着文图生成模型的广泛应用,模型本身有限的安全防护机制使得用户有机会无意或故意生成有害的图片内容,并且该内容有可能会被恶意使用。现有的安全措施主要依赖文本过滤或概念移除的策略,只能从文图生成模型的生成能力中移除少数几个概念。

AI风起云涌,数据隐私如履薄冰。华南理工大学联手深圳北理莫斯科大学,推出FedMSBA与FedMAR,筑成联邦学习的安全堡垒,守护个人隐私!

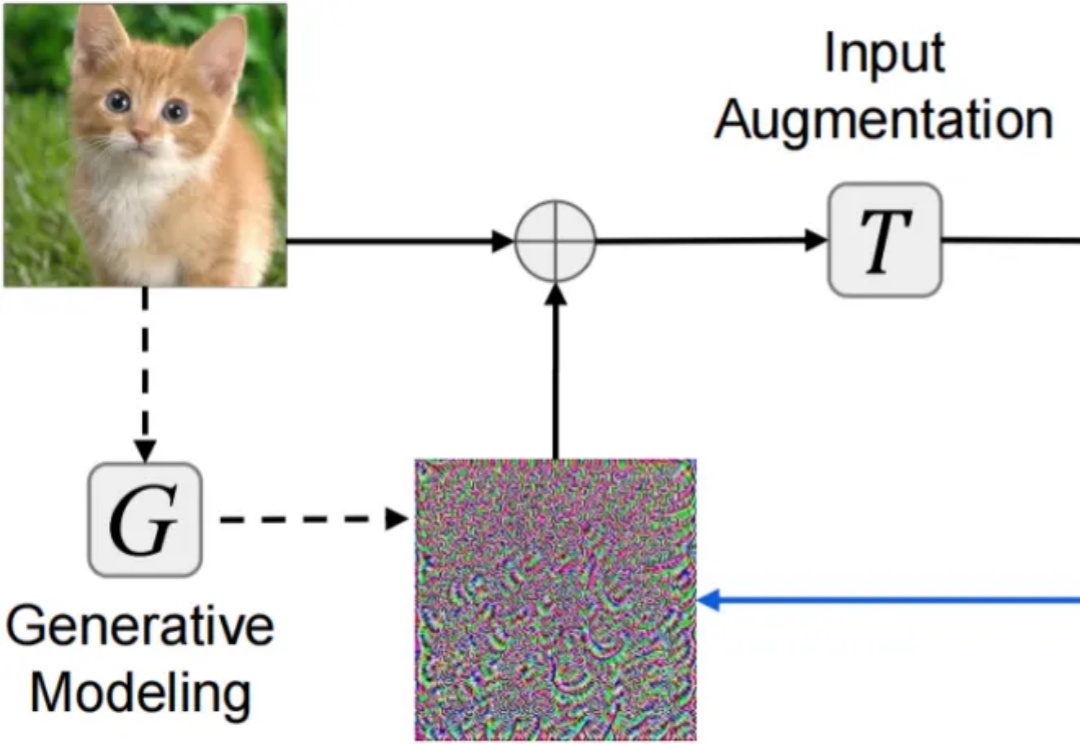

对抗样本(adversarial examples)的迁移性(transferability)—— 在某个模型上生成的对抗样本能够同样误导其他未知模型 —— 被认为是威胁现实黑盒深度学习系统安全的核心因素。尽管现有研究已提出复杂多样的迁移攻击方法,却仍缺乏系统且公平的方法对比分析:(1)针对攻击迁移性,未采用公平超参设置的同类攻击对比分析;(2)针对攻击隐蔽性,缺乏多样指标。

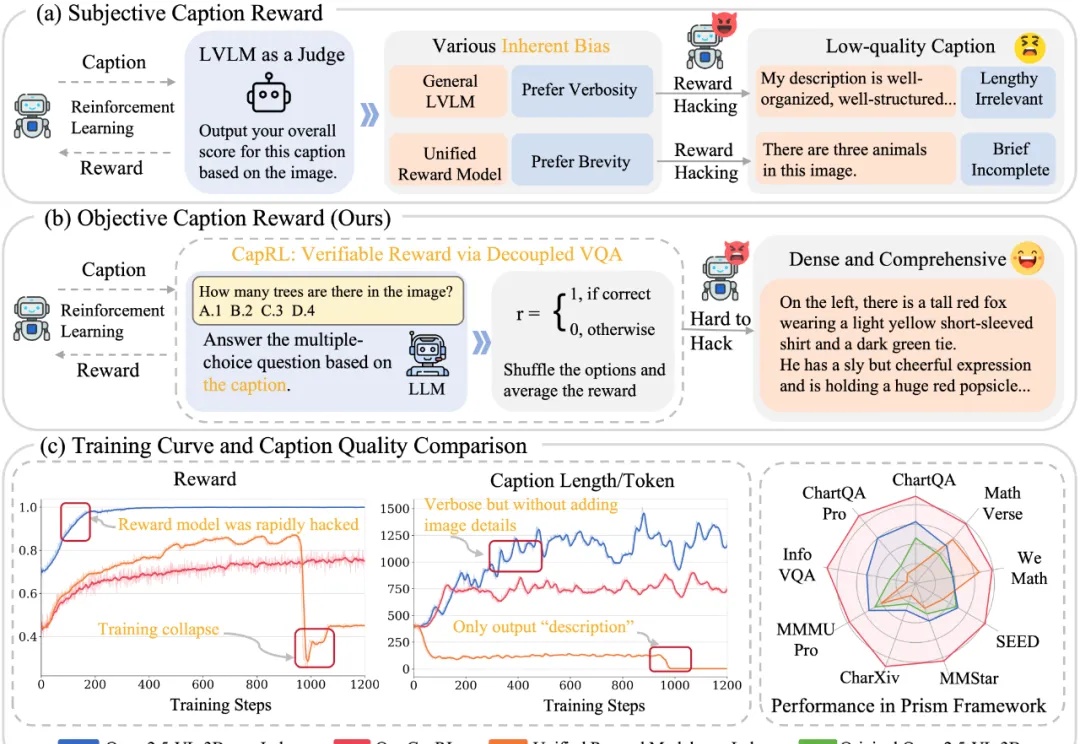

今天推荐一个 Dense Image Captioning 的最新技术 —— CapRL (Captioning Reinforcement Learning)。CapRL 首次成功将 DeepSeek-R1 的强化学习方法应用到 image captioning 这种开放视觉任务,创新的以实用性重新定义 image captioning 的 reward。

大语言模型(LLMs)推理能力近年来快速提升,但传统方法依赖大量昂贵的人工标注思维链。中国科学院计算所团队提出新框架PARO,通过让模型学习固定推理模式自动生成思维链,只需大模型标注1/10数据就能达到全量人工标注的性能。这种方法特别适合像金融、审计这样规则清晰的领域,为高效推理监督提供了全新思路。

蚂蚁集团这波操作大圈粉!智东西10月28日报道,10月25日,蚂蚁集团在arXiv上传了一篇技术报告,一股脑将自家2.0系列大模型训练的独家秘籍全盘公开。今年9月至今,蚂蚁集团百灵大模型Ling 2.0系列模型陆续亮相,其万亿参数通用语言模型Ling-1T多项指标位居开源模型的榜首