Transformer作者初创重磅发布Transformer²!AI模型活了,动态调整自己权重

Transformer作者初创重磅发布Transformer²!AI模型活了,动态调整自己权重Sakana AI发布了Transformer²新方法,通过奇异值微调和权重自适应策略,提高了LLM的泛化和自适应能力。新方法在文本任务上优于LoRA;即便是从未见过的任务,比如MATH、HumanEval和ARC-Challenge等,性能也都取得了提升。

Sakana AI发布了Transformer²新方法,通过奇异值微调和权重自适应策略,提高了LLM的泛化和自适应能力。新方法在文本任务上优于LoRA;即便是从未见过的任务,比如MATH、HumanEval和ARC-Challenge等,性能也都取得了提升。

Stability AI推出3D重建方法:2D图像秒变3D,还可以交互式实时编辑。新方法的原理、代码、权重、数据全公开,而且许可证宽松,可以商用。新方法采用点扩展模型生成稀疏点云,之后通过Transformer主干网络,同时处理生成的点云数据和输入图像生成网格。以后,人人都能轻松上手3D模型设计。

影眸科技持续突破技术边界

Video Ocean V2.0,刚刚火爆上线了!它孵化自超火的23k+ stars项目Open Sora,全面升级的视频质量让X网友集体上头了。自媒体、制片人、学生党纷纷惊呼:如此好用,居然还是免费!

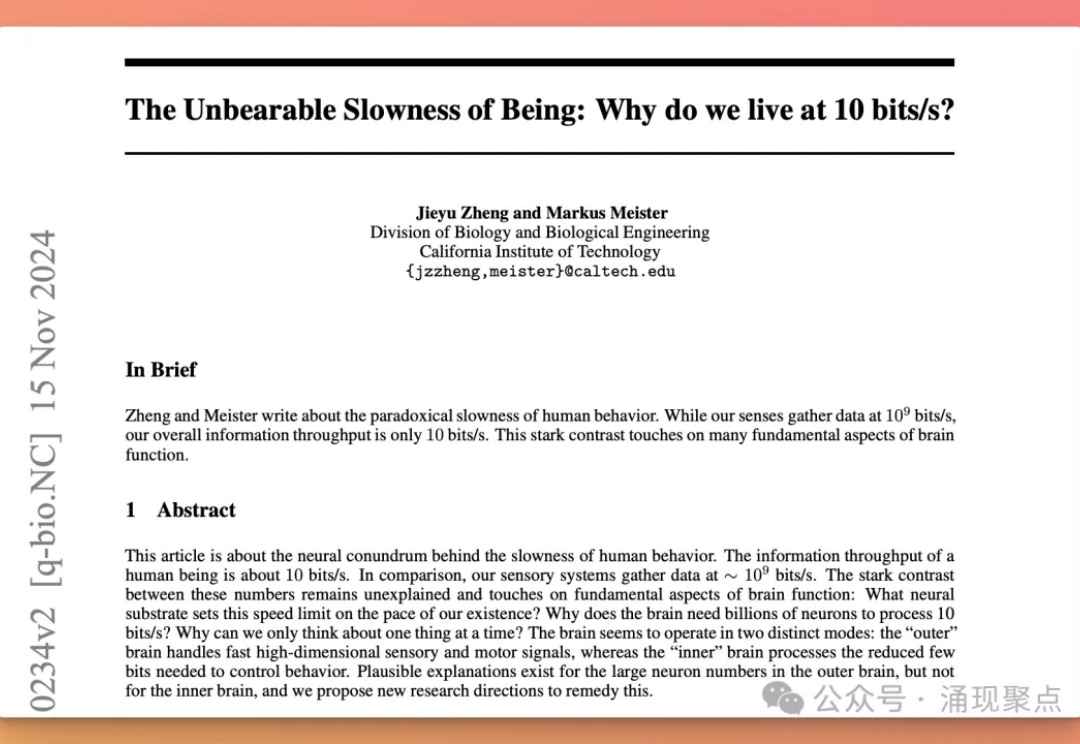

2024年11月15日,加州理工学院生物学和生物工程系的Jieyu Zheng和Markus Meister发表了一篇震撼学界的论文《The Unbearable Slowness of Being: Why do we live at 10 bit/s?》[1]。这项研究揭示了一个令人不安的事实:人类大脑每秒仅能处理大约10比特信息。

GANs are so back!?

在最初成立的时候,Marvell做得是SSD controller,这迄今也是该公司极具竞争力的产品之一。但初次以外,这家由戴伟立及其先生周秀文创立的芯片公司在很多市场以及积累了雄厚的实力。

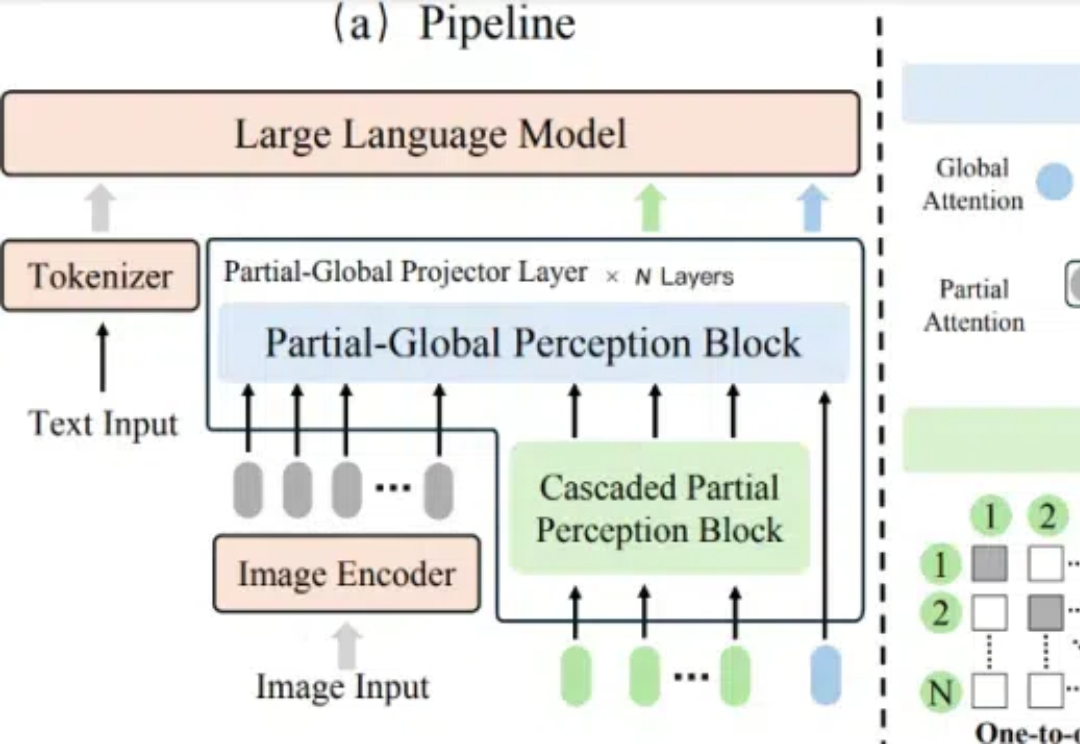

在多模态大语言模型(MLLMs)的发展中,视觉 - 语言连接器作为将视觉特征映射到 LLM 语言空间的关键组件,起到了桥梁作用。

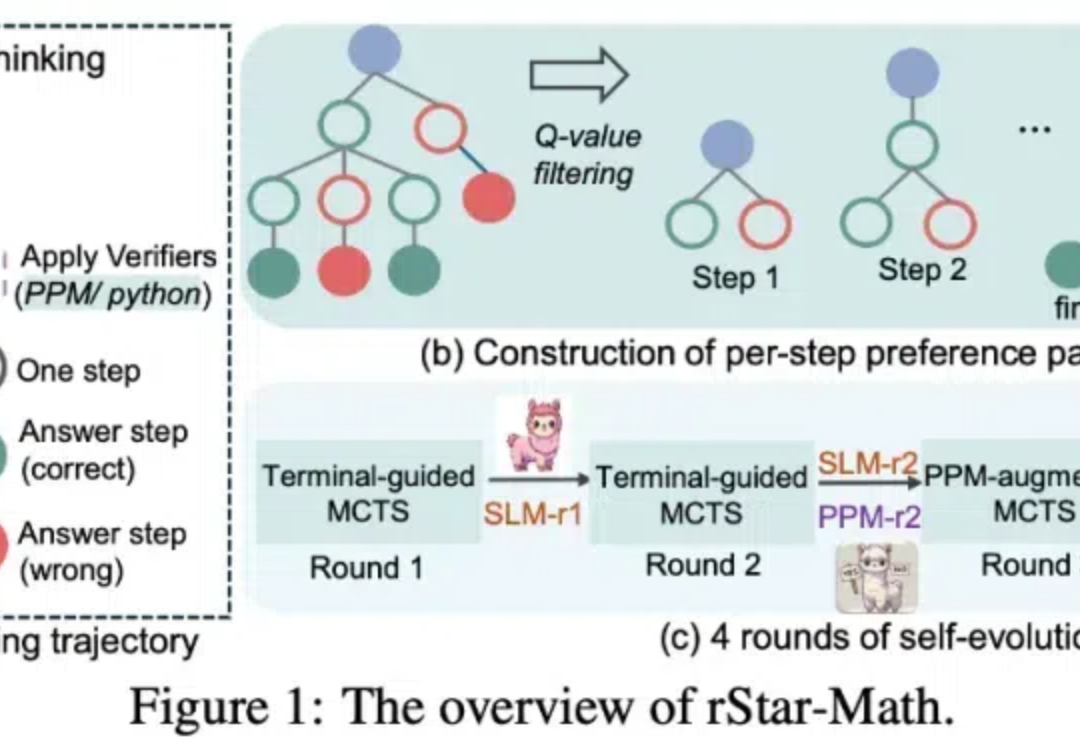

OpenAI o1 给大模型规模扩展 vs 性能的曲线带来了一次上翘。它在大模型领域重现了当年 AlphaGo 强化学习的成功 —— 给越多算力,就输出越多智能,一直到超越人类水平。

Level AI 创始人 Ashish Nagar 具有深厚的 AI 背景,曾在亚马逊 Alexa 团队工作。他观察到传统客服行业存在质量监控效率低、数据价值难以挖掘、实时支持能力不足等问题,因此创立 Level AI。