代码碾压一切!OpenAI神秘模型o3-alpha一夜刷屏,却遭41岁大神绝地反杀

代码碾压一切!OpenAI神秘模型o3-alpha一夜刷屏,却遭41岁大神绝地反杀OpenAI的神秘模型o3-alpha意外曝光,其强大的代码能力碾压众多AI。该模型疑似在东京AtCoder世界编程大赛2025中夺得亚军,最终不敌人类选手Psyho。

OpenAI的神秘模型o3-alpha意外曝光,其强大的代码能力碾压众多AI。该模型疑似在东京AtCoder世界编程大赛2025中夺得亚军,最终不敌人类选手Psyho。

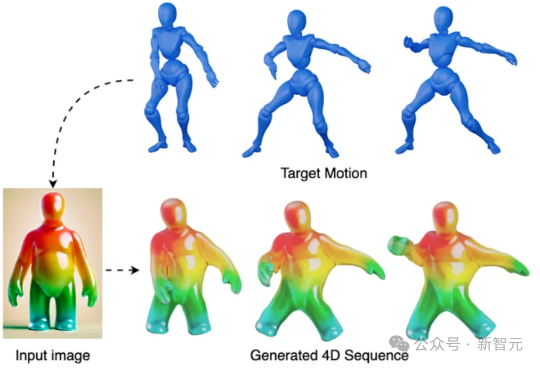

PhysRig是UIUC与Stability AI联合提出的首个面向角色动画的可微物理绑定框架。通过将刚性骨架嵌入弹性软体体积,并使用Material Point Method(MPM)进行可微分物理模拟,PhysRig能够自然还原皮肤、脂肪、尾巴等柔性结构的变形过程,显著提升角色动画的真实感,解决传统LBS无法克服的体积丢失与变形伪影问题。

还在为发了广告没人点击而烦恼吗?还在纠结为什么花费巨资投放的数字营销效果越来越差吗?现实是,传统的营销漏斗已经彻底坍塌了。今天的消费者,特别是Gen Z和Gen Alpha,他们发现产品的方式已经完全改变:不再通过搜索引擎或者广告,而是通过TikTok的滚动浏览、Reddit的搜索,或者网红的推荐。

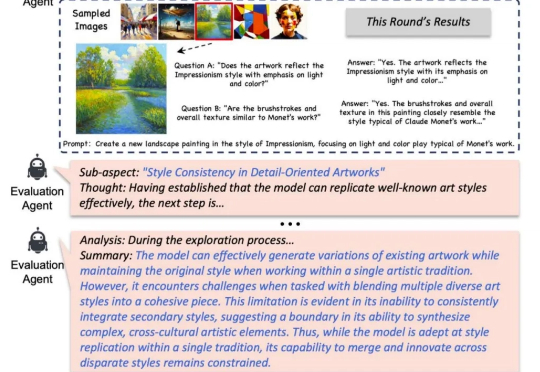

怎么快速判断一个生成模型好不好? 最直接的办法当然是 —— 去问一位做图像生成、视频生成、或者专门做评测的朋友。他们懂技术、有经验、眼光毒辣,能告诉你模型到底强在哪、弱在哪,适不适合你的需求。

最近几个月,由谷歌和 Meta 前研究人员建立的欧洲的 AI 初创公司 Mistral AI 有些躁动不安。他们将 Le Chat 再一次升级,引入了一些强大的新功能,使其更强大、更直观,也更有趣,在功能上几乎全方位对标 ChatGPT。

RAG(检索增强生成)作为解决大模型"幻觉"和知识时效性问题的关键技术,已成为企业AI应用的主流架构。Contextual AI由RAG技术的创始研究者组建,致力于开发能应对复杂知识密集型任务的专业智能体。

Meta 143亿美元收购Scale AI近一半的股份,竟便宜了其竞争对手!仅在达成协议后的48小时内,多家竞争对手们纷纷表示:泼天的富贵来了!「我们的服务器都快爆了!」

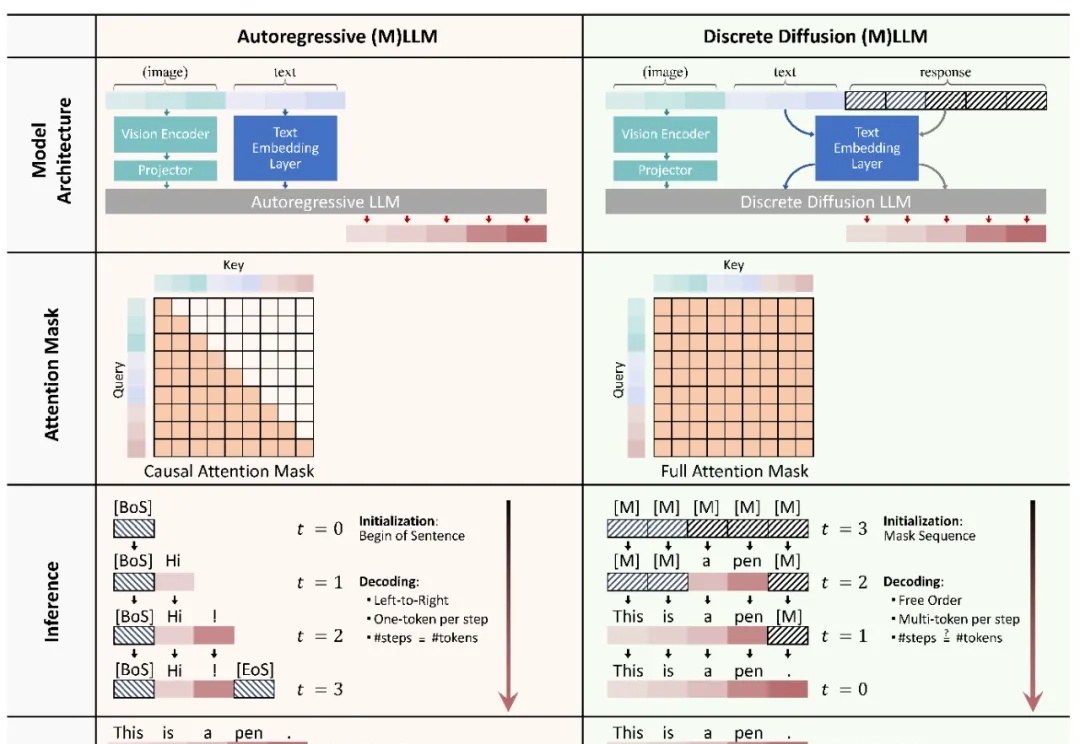

本文主要介绍 xML 团队的论文:Discrete Diffusion in Large Language and Multimodal Models: A Survey。

OpenAI如何以自下而上的文化和行动导向,推动大模型突破?从零到上线仅用7周,Calvin带你走进OpenAI编程智能体Codex的诞生过程,体验高强度冲刺的魔力。

随着 AI 系统越来越强大,人们与机器的交流方式也在发生变化。语音,正在迅速成为默认的交互入口。