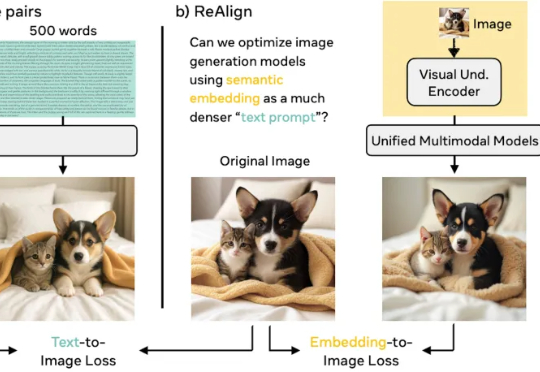

理解帮助生成?RecA自监督训练让统一多模态模型直升SOTA

理解帮助生成?RecA自监督训练让统一多模态模型直升SOTA谢集,浙江大学竺可桢学院大四学生,于加州大学伯克利分校(BAIR)进行访问,研究方向为统一多模态理解生成大模型。第二作者为加州大学伯克利分校的 Trevor Darrell,第三作者为华盛顿大学的 Luke Zettlemoyer,通讯作者是 XuDong Wang, Meta GenAl Research Scientist、

谢集,浙江大学竺可桢学院大四学生,于加州大学伯克利分校(BAIR)进行访问,研究方向为统一多模态理解生成大模型。第二作者为加州大学伯克利分校的 Trevor Darrell,第三作者为华盛顿大学的 Luke Zettlemoyer,通讯作者是 XuDong Wang, Meta GenAl Research Scientist、

昨天看到一条融资新闻,Meela 完成了350万美元种子轮融资,Bain Capital Ventures 领投。乍一看,这又是一家普通的AI创业公司,但当我深入了解后,发现他们在做一件让我意想不到的事:专门为养老院的老人打造AI电话伴侣。

Epoch AI 最近受 Google DeepMind 委托编写了一份分析报告,探讨这种规模扩张(Scaling)在计算、投资、数据、硬件和能源方面将带来哪些影响。在报告中,进一步探讨了这种规模扩张将赋予的未来 AI 能力,尤其是在科研领域,而这正是领先 AI 开发者关注的重点。

你知道目前一共有多少个大模型吗? Hugging Face 上已经有超过 70 万个大模型了。 即使抛去不好用的,被 Artificial Analysis 收录的大模型也有 269 个。不仅模型琳琅满目,供应商也是多得让人眼花缭乱。

就在最新的Nature新刊中,DeepSeek一举成为首家登上《Nature》封面的中国大模型公司,创始人梁文锋担任通讯作者。纵观全球,之前也只有极少数如DeepMind者,凭借AlphaGo、AlphaFold有过类似荣誉。

最新消息,C轮融资已拿到超10亿美元承诺资本,投后估值高达390亿美元,一举创下当前公开信息中具身智能赛道的最高估值纪录。本轮融资由Parkway Venture Capital领投,英伟达继续加注,Brookfield Asset Management、麦格理资本、英特尔资本、Align Ventures、

经过数月的外界猜测,CEO Sam Altman揭晓了一款远超预期的全新模型。用他的话来说,与前代的跃升可以这样形容——“GPT-4像是在和一位大学生对话,而GPT-5则是第一次让人真切地感觉在与一位博士级专家交流。”

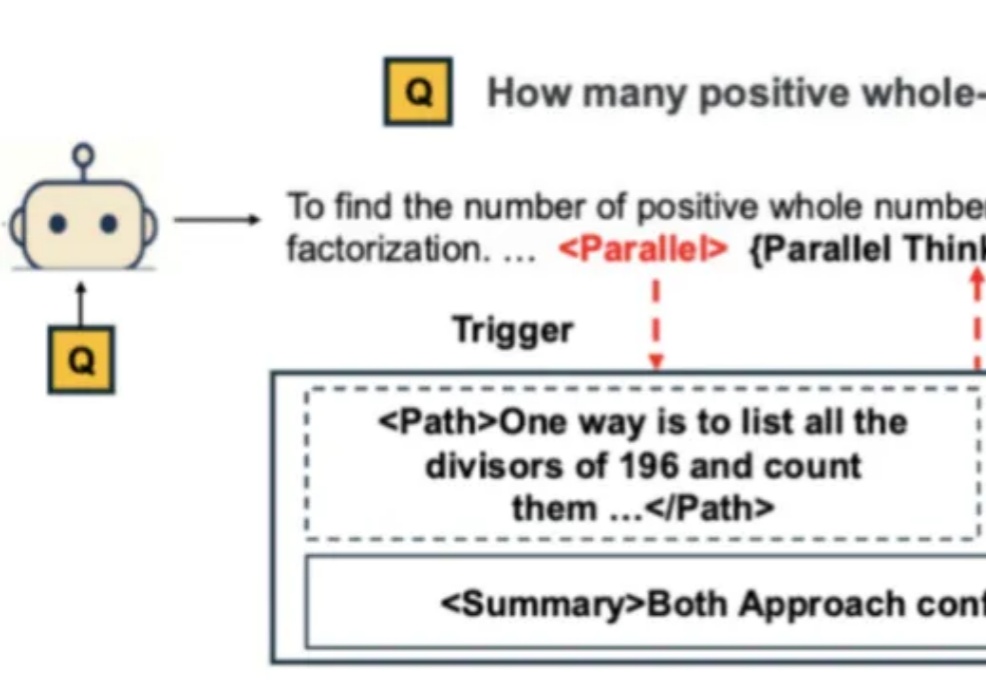

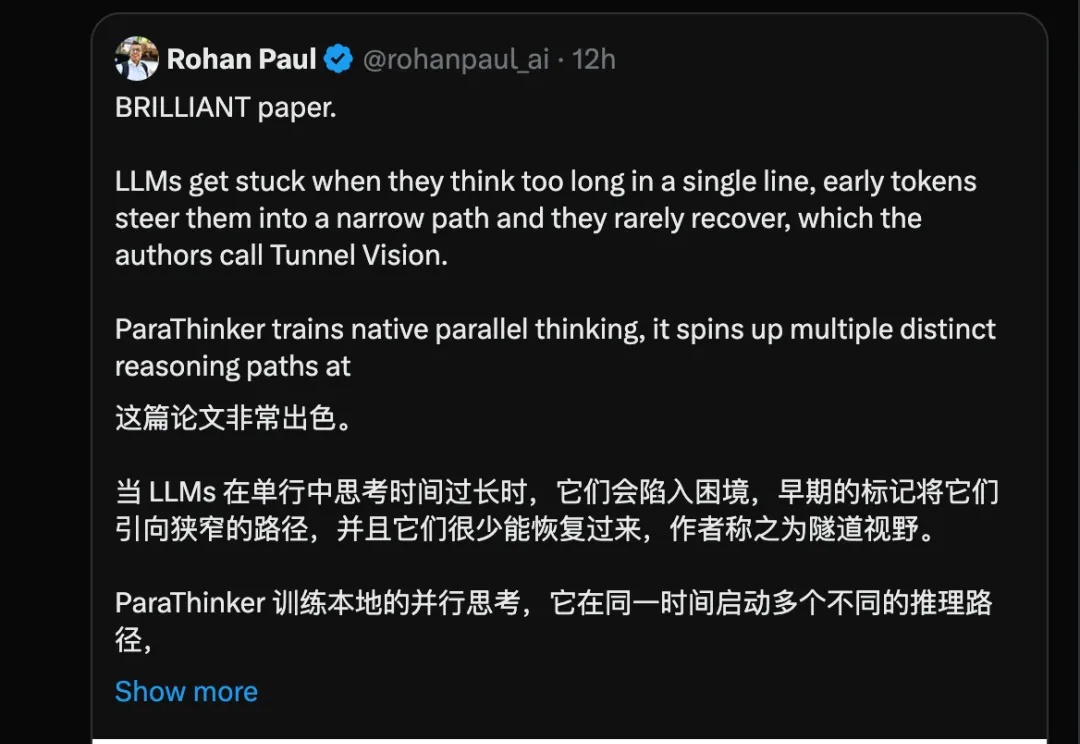

自从 Google Gemini 将数学奥赛的成功部分归功于「并行思维」后,如何让大模型掌握这种并行探索多种推理路径的能力,成为了学界关注的焦点。

近年来,大语言模型(LLMs)在复杂推理任务上的能力突飞猛进,这在很大程度上得益于深度思考的策略,即通过增加测试时(test-time)的计算量,让模型生成更长的思维链(Chain-of-Thought)。

人工智能初创公司Invisible Technologies 作为 Scale AI 的竞争对手,在新一轮融资中筹集 1 亿美元资金,这凸显了硅谷投资者对人工智能热潮基础构建模块的持续关注。