MiniMax在海外的AI陪聊产品,爆了

MiniMax在海外的AI陪聊产品,爆了公司旗下Talkie产品,已在Google Play下载排行榜上跻身前五。

公司旗下Talkie产品,已在Google Play下载排行榜上跻身前五。

AlphaFold3引起的浪潮下,一个新的抗体设计生成式AI大模型浮出水面。

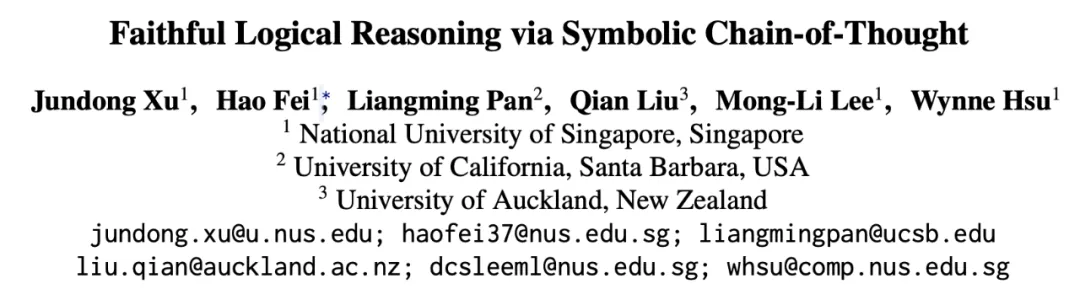

不使用外部工具也能让大语言模型(LLMs)实现严谨可信的推理,新国立提出 SymbCoT 推理框架:结合符号化逻辑(Symbolic Logical)表达式与思维链,极大提升推理质量,鲁棒性与可信度。

怎样才能将可爱又迷人的柯基与柴犬的图像进行区分?

过去十年间,基于随机梯度下降(SGD)的深度学习模型在许多领域都取得了极大的成功。与此同时各式各样的 SGD 替代品也如雨后春笋般涌现。在这些众多替代品中,Adam 及其变种最受追捧。无论是 SGD,还是 Adam,亦或是其他优化器,最核心的超参数非 Learning rate 莫属。因此如何调整好 Leanring rate 是炼丹师们从一开始就必学的技能。

OpenAI前员工Leopold Aschenbrenner,之前在超级对齐(Superalignment)部门,可是能和Ilya大佬共事的。

要怎么介绍李飞飞?

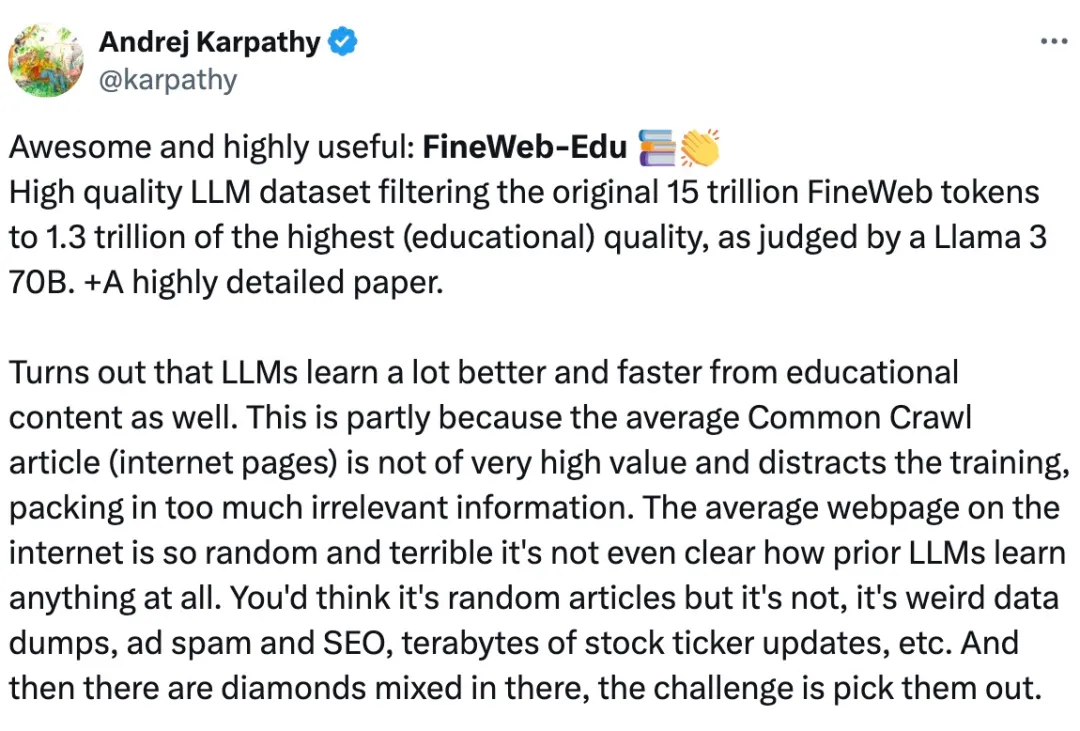

众所周知,对于 Llama3、GPT-4 或 Mixtral 等高性能大语言模型来说,构建高质量的网络规模数据集是非常重要的。然而,即使是最先进的开源 LLM 的预训练数据集也不公开,人们对其创建过程知之甚少。

一般而言,训练神经网络耗费的计算量越大,其性能就越好。在扩大计算规模时,必须要做个决定:是增多模型参数量还是提升数据集大小 —— 必须在固定的计算预算下权衡此两项因素。

Scaling law发展到最后,可能每个人都站在一个数据孤岛上。