零成本突破多模态大模型瓶颈!多所美国顶尖高校华人团队,联合推出自增强技术CSR

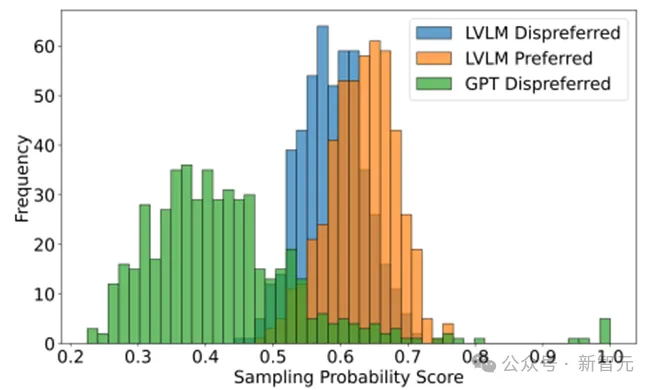

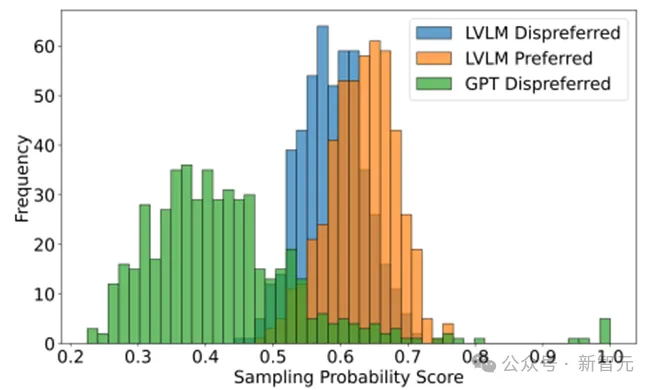

零成本突破多模态大模型瓶颈!多所美国顶尖高校华人团队,联合推出自增强技术CSR现有多模态大模型在对齐不同模态时面临幻觉和细粒度感知不足等问题,传统偏好学习方法依赖可能不适配的外源数据,存在成本和质量问题。Calibrated Self-Rewarding(CSR)框架通过自我增强学习,利用模型自身输出构造更可靠的偏好数据,结合视觉约束提高学习效率和准确性。

现有多模态大模型在对齐不同模态时面临幻觉和细粒度感知不足等问题,传统偏好学习方法依赖可能不适配的外源数据,存在成本和质量问题。Calibrated Self-Rewarding(CSR)框架通过自我增强学习,利用模型自身输出构造更可靠的偏好数据,结合视觉约束提高学习效率和准确性。

继Sora官宣之后,多模态大模型在视频生成方面的应用简直就像井喷一样涌现出来,LUMA、Gen-3 Alpha等视频生成模型展现了极佳质量的艺术风格和视频场景的细节雕刻能力,文生视频、图生视频的新前沿不断被扩展令大家惊喜不已,抱有期待。

水能载舟,亦能覆舟

Ilya去哪了?这个自去年年底OpenAI上演宫斗之后,所有关心AI的人都在问的问题,有了最终的答案。

OpenAI从非营利转向营利引发争议,奥尔特曼遭批评。

曾经的视频生成王者Runway,带着大招鲨~回来了——

AI圈这遍地开花的大好局面,让吃瓜群众们甚是惊喜。

潞晨 Open-Sora 团队在 720p 高清文生视频质量和生成时长上实现了突破性进展,支持无缝产出任意风格的高质量短片,令人惊喜的是,他们选择再给开源社区带来亿点点震撼,继续全部开源。

基于 Transformer架构的大型语言模型在各种基准测试中展现出优异性能,但数百亿、千亿乃至万亿量级的参数规模会带来高昂的服务成本。例如GPT-3有1750亿参数,采用FP16存储,模型大小约为350GB,而即使是英伟达最新的B200 GPU 内存也只有192GB ,更不用说其他GPU和边缘设备。

在现实世界的机器学习应用中,随时间变化的分布偏移是常见的问题。这种情况被构建为时变域泛化(EDG),目标是通过学习跨领域的潜在演变模式,并利用这些模式,使模型能够在时间变化系统中对未见目标域进行良好的泛化。然而,由于 EDG 数据集中时间戳的数量有限,现有方法在捕获演变动态和避免对稀疏时间戳的过拟合方面遇到了挑战,这限制了它们对新任务的泛化和适应性。