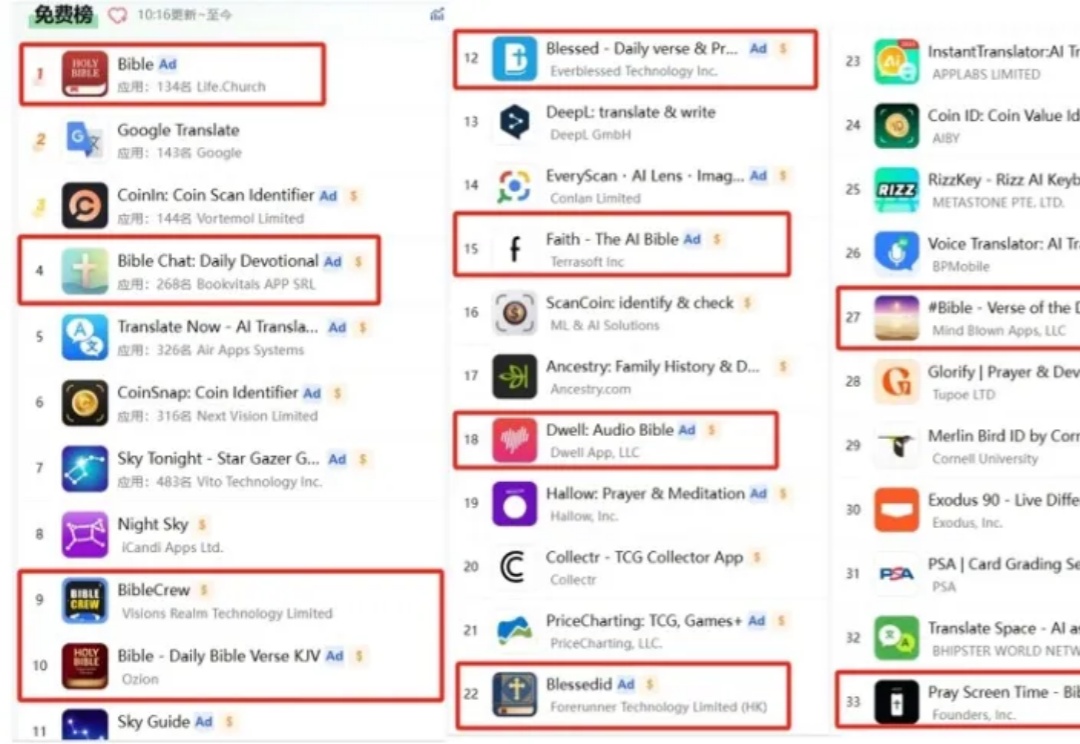

加了AI,这款产品下载量压过赛道No.1

加了AI,这款产品下载量压过赛道No.1不知道是不是因为今年是禧年(天主教圣年,会有重大宗教活动)的缘故,不少宗教类 App 近期频频出现在笔者视野中,既有白鲸出海之前关注过的 Hallow,也有不少新面孔。

不知道是不是因为今年是禧年(天主教圣年,会有重大宗教活动)的缘故,不少宗教类 App 近期频频出现在笔者视野中,既有白鲸出海之前关注过的 Hallow,也有不少新面孔。

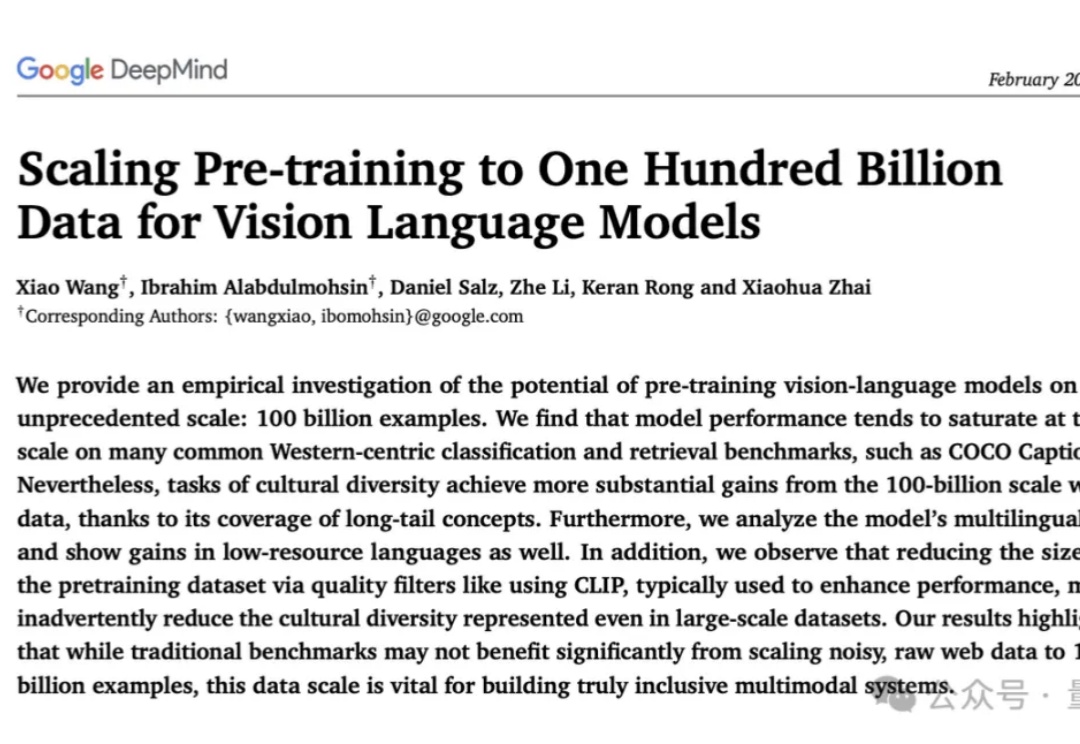

史上最大规模视觉语言数据集:1000亿图像-文本对!

脑机接口技术炙手可热,马斯克的Neuralink更是吸引了全球目光。然而其侵入式方案的风险不容忽视。Meta AI则另辟蹊径,近日推出了非侵入式的Brain2Qwerty深度学习模型,它能通过分析脑电图或脑磁图「读」出人们在键盘上输入的文字。

距离被替代还有一段距离。

【新智元导读】仅凭测试时Scaling,1B模型竟完胜405B!多机构联手巧妙应用计算最优TTS策略,不仅0.5B模型在数学任务上碾压GPT-4o,7B模型更是力压o1、DeepSeek R1这样的顶尖选手。

席卷全球的 DeepSeek 依然是科技圈最大的话题,连 San Altman 都承认每天醒来都会担忧。因此本周在巴黎举办的 AI 行动峰会聚光灯稍显黯淡,但这里依然汇聚了全球大量重要的头脑。

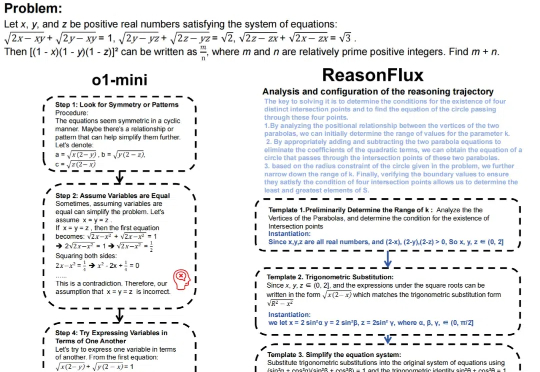

推理大语言模型(LLM),如 OpenAI 的 o1 系列、Google 的 Gemini、DeepSeek 和 Qwen-QwQ 等,通过模拟人类推理过程,在多个专业领域已超越人类专家,并通过延长推理时间提高准确性。推理模型的核心技术包括强化学习(Reinforcement Learning)和推理规模(Inference scaling)。

先是三星宣布智谱的Agentic GLM成为其新手机Galaxy S25的AI能力来源,紧接着The Information爆料,在经历了近一年的模型测试与合作伙伴探索后,苹果终于敲定了中国市场的合作伙伴:阿里巴巴。这意味着,中国iPhone用户很可能在今年迎来一个由国产大模型驱动的iPhone。

只用4500美元成本,就能成功复现DeepSeek?就在刚刚,UC伯克利团队只用简单的RL微调,就训出了DeepScaleR-1.5B-Preview,15亿参数模型直接吊打o1-preview,震撼业内。

刚刚,OpenAI奥特曼的最新AI观察出炉:Scaling Law将保持不变,短时间内没有理由停止对AI进行指数增长级的投资!1、AI能力与投入资源呈对数关系 2、AI使用成本每年降低约10倍 3、AI带来的社会经济价值呈超级指数增长