CC直接用,Manus核心Context技术被人做成了Skills

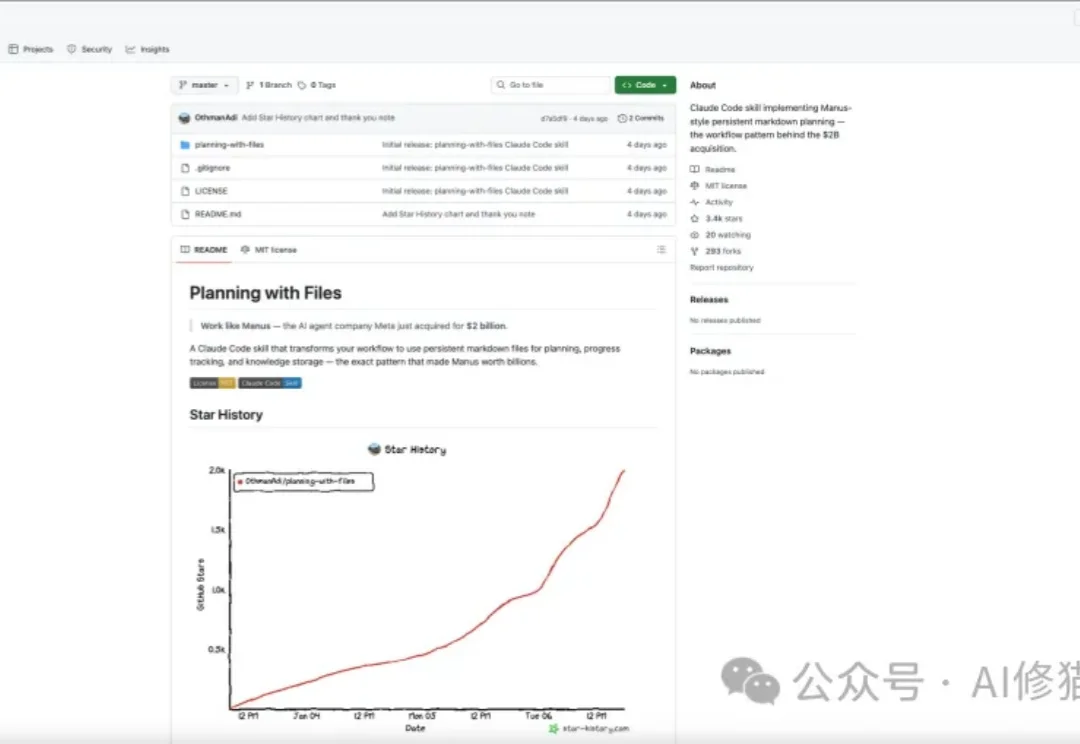

CC直接用,Manus核心Context技术被人做成了Skillsplanning-with-files是开源社区最近疯传的一个Skill,发布仅四天收获3.3k star。目前还在持续增长。

planning-with-files是开源社区最近疯传的一个Skill,发布仅四天收获3.3k star。目前还在持续增长。

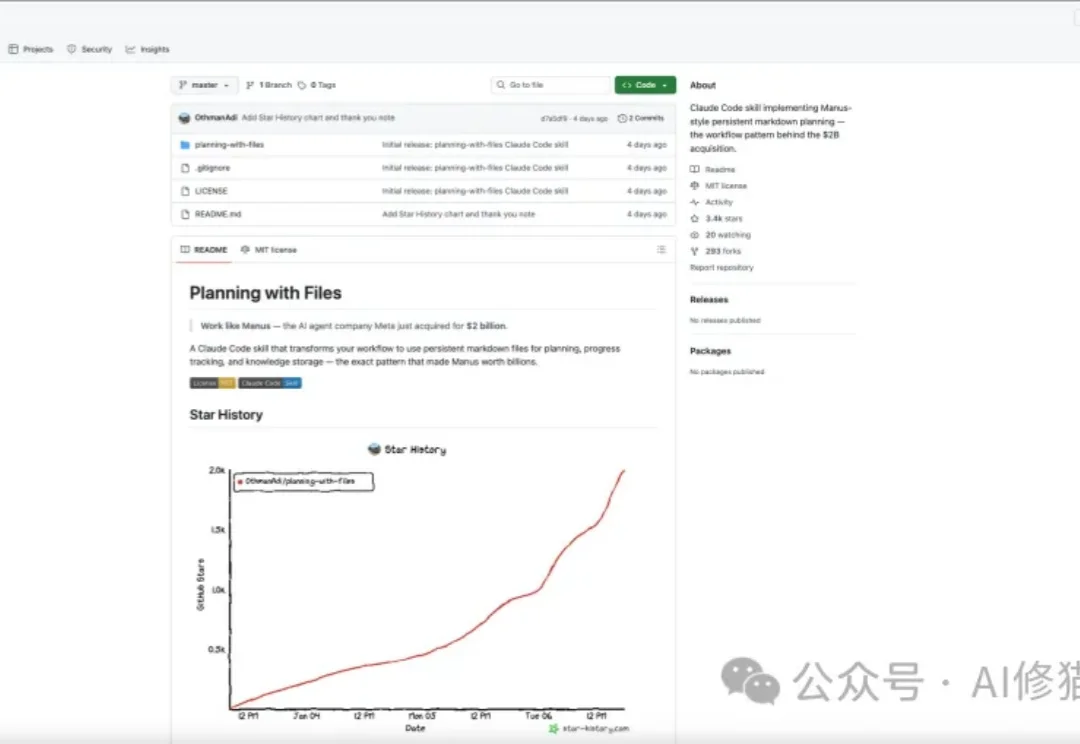

之前跟Tao博合作过很多次,从MindOS到Mebot,听说最近Second Me新版上线了,马上第一时间体验了一下,于是就有了这篇文章。Second Me 这次重点更新了 AI 社交玩法,体验是很有意思的。

一场AI界的《创造101》火了!LMArena让你盲投选出最强AI,三年从校园项目逆袭,刚刚融1.5亿美元,估值飙到17亿美元。众包投票挑战专家权威,争议四起,却已成行业标杆。你的票,就能决定下一个AI顶流!

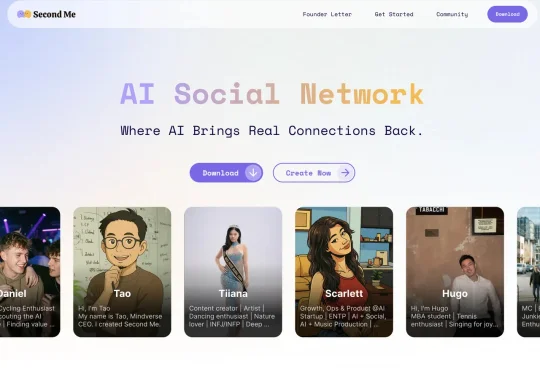

刚开年,马斯克就到账了200亿美金!(是谁听到了金币的声音~

当大模型竞争转向后训练,继续为闲置显卡烧钱无异于「慢性自杀」。如今,按Token计费的Serverless模式,彻底终结了算力租赁的暴利时代,让算法工程师真正拥有了定义物理世界的权利。

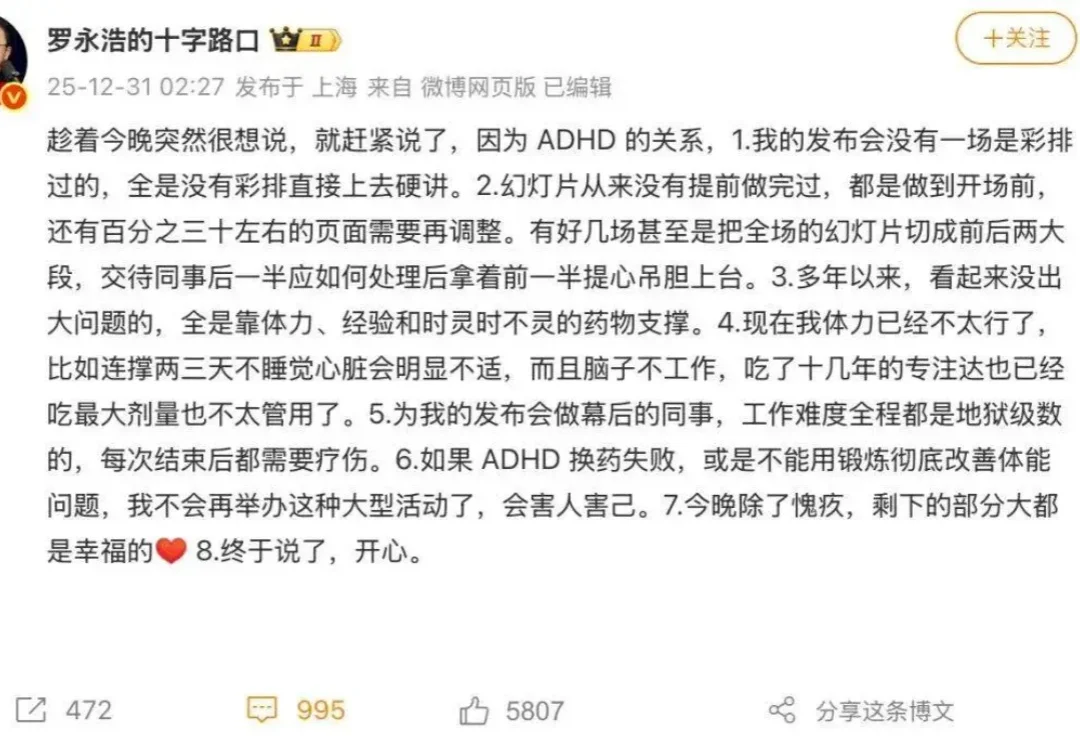

在迟到了 40 分钟之后,老罗终于在 2025 年的最后一天,站上了科技春晚的舞台。对那些枯等了许久的现场观众,他给到的除了免票,还有一个「理由」:ADHD。

央企第一家AI独角兽,诞生了。

昨天,Claude Code 的创造者 Boris Cherny 在 X 上发了一条长推,分享了他自己使用 CC 的 13 条私藏技巧,将近 400 万的阅读量,我昨天一睁眼几乎被刷屏了。

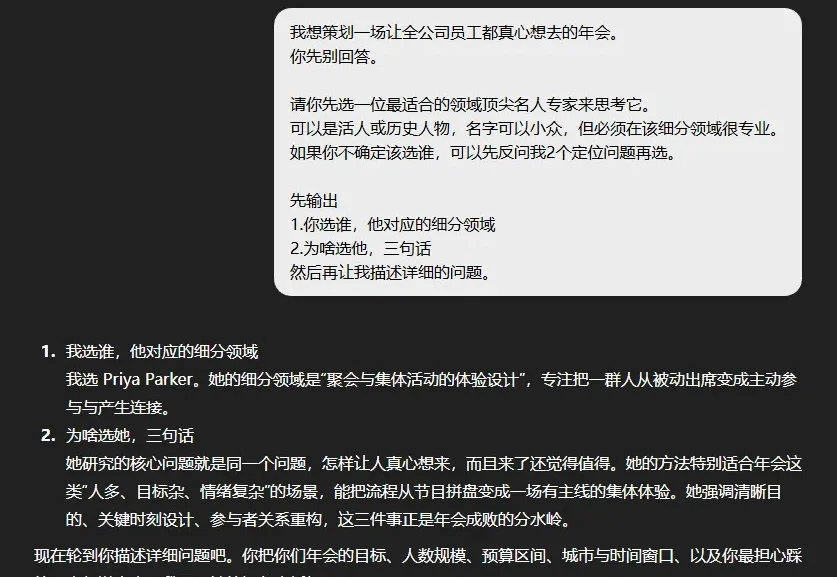

已经2026年了,其实还是看到很多朋友,说不知道怎么能更好的跟AI对话。

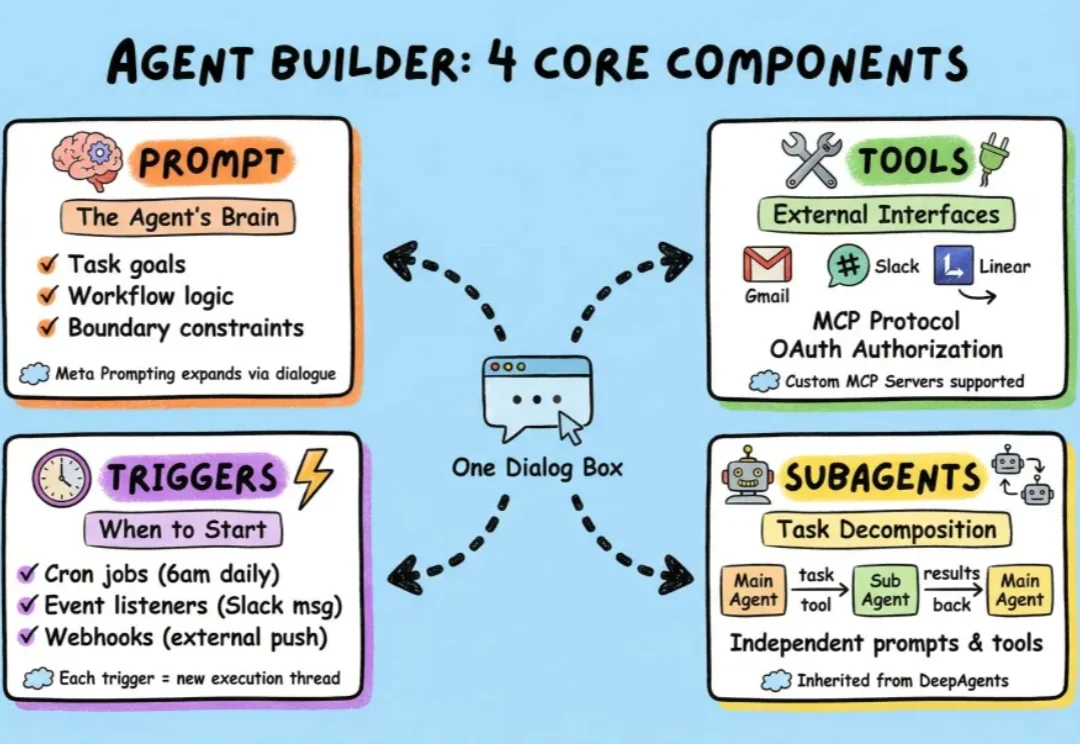

过去一段时间,我们介绍了很多小白入门级的agent框架,也介绍了包括langchain在内的很多专业级agent搭建框架。