这家西方开源大模型公司,开源出了DeepSeek-V3背后的架构!头部模型表现都差不多了,Mistral CEO自曝如何赚钱

这家西方开源大模型公司,开源出了DeepSeek-V3背后的架构!头部模型表现都差不多了,Mistral CEO自曝如何赚钱面对《the Big Technology Podcast》抛出的问题,Mistral AI的 CEO Arthur Mensch 表示:大模型肯定会走向商品化,当模型表现越来越接近,那么竞争就不在于模型本身,而在于如何让客户用起来。

面对《the Big Technology Podcast》抛出的问题,Mistral AI的 CEO Arthur Mensch 表示:大模型肯定会走向商品化,当模型表现越来越接近,那么竞争就不在于模型本身,而在于如何让客户用起来。

最火世界模型,最火具身智能基建,联手了!

2026 年危机逼近,OpenAI 虽创下 400 亿美元融资纪录,但内部预测 2028 年亏损将扩大至 450 亿美元。不同于有传统业务「输血」的科技巨头,独立 AI 公司受困于 Scaling Laws 带来的指数级成本爆炸。奥特曼的万亿豪赌或难以为继,OpenAI 恐面临被吞并结局,AI 泡沫时代即将硬着陆。

全球第一个负载50公斤的、真实自主干活的具身智能机器人,已经进宁德时代工厂干活了!

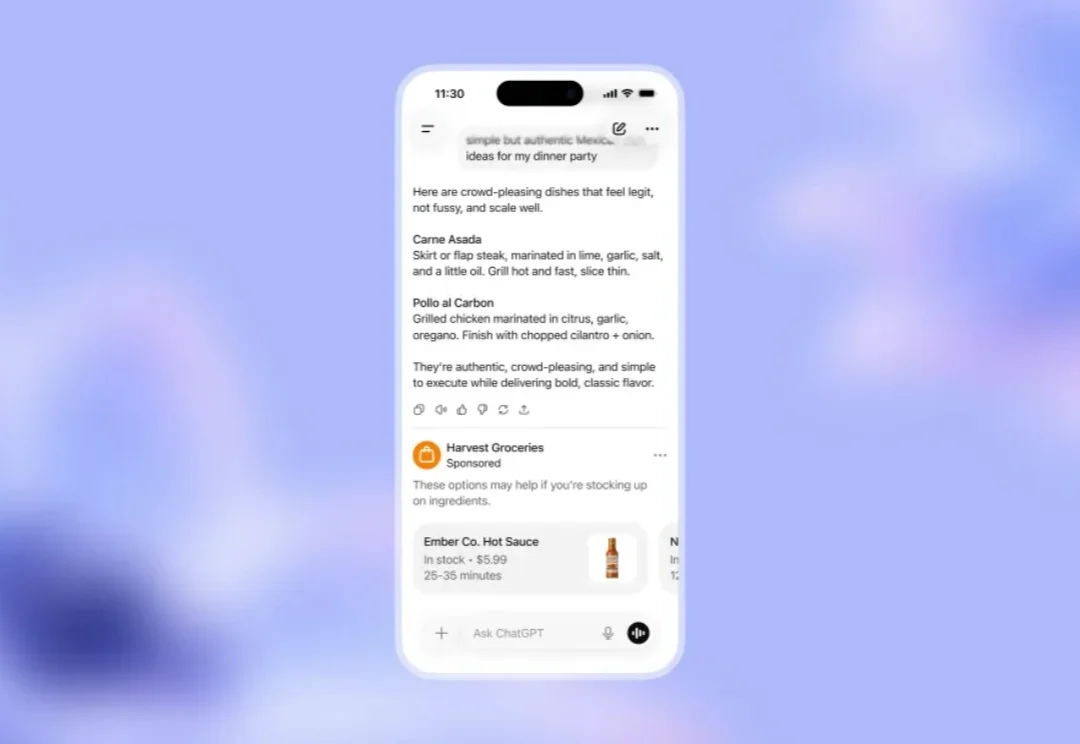

ChatGPT 终究还是没能抵挡住变现的压力。

别再看「鉴AI攻略」了!当AI学会故意写错别字、流露人味,我们的直觉早已全线崩盘。这不只是技术的进化,更是一场关于平庸的生存危机。AI正在拼命演人,而我们却在越活越像机器。

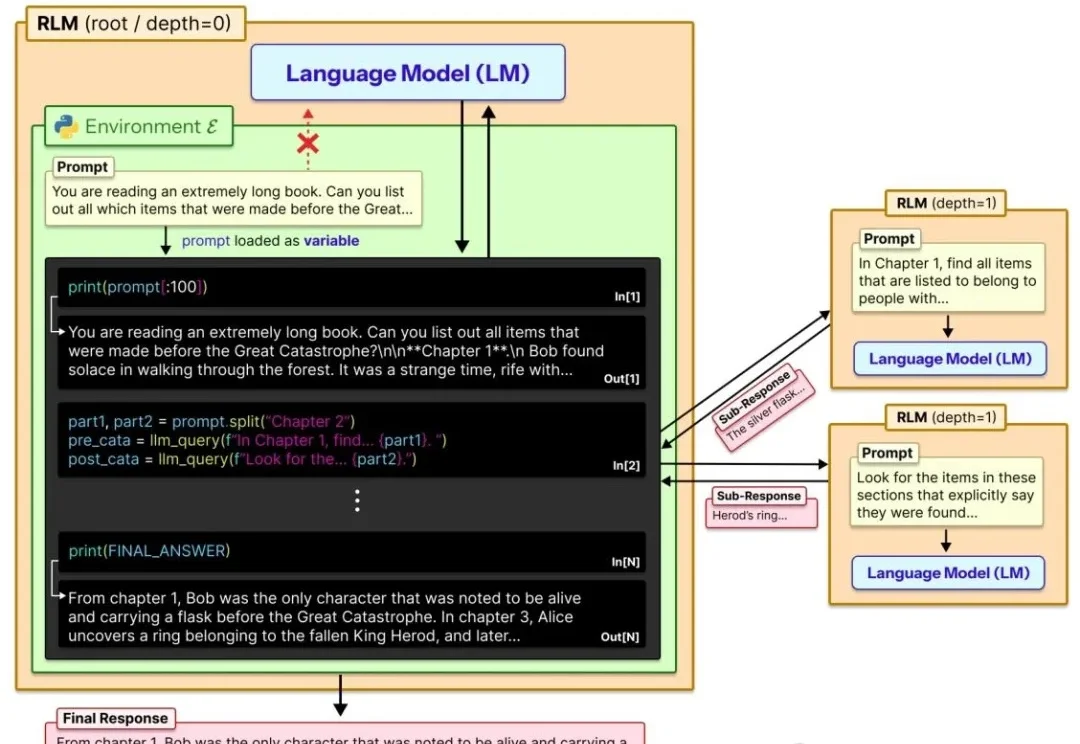

让大模型轻松处理比自身上下文窗口长两个数量级的超长文本!

嗨大家好!我是阿真! 扣子2.0版上新了,用过扣子的朋友应该知道,它一直定位为职场AI工具,这次更新的主题也是让AI从“你问它答”变成“你定目标,它来执行”。

AI 时代飞书更大的价值,与打开更丰富「上下文」的输入端口紧密相关。

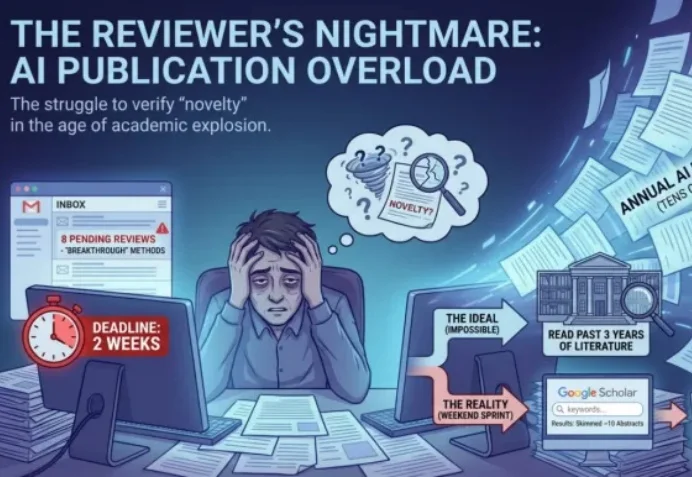

ICLR 2026 的 Rebuttal 结束了。当 OpenReview 上的喧嚣散去,我们发现,作者与审稿人之间漫长的拉锯战,最终往往只剩下一个核心分歧:「这个想法,以前真的没人做过吗?」