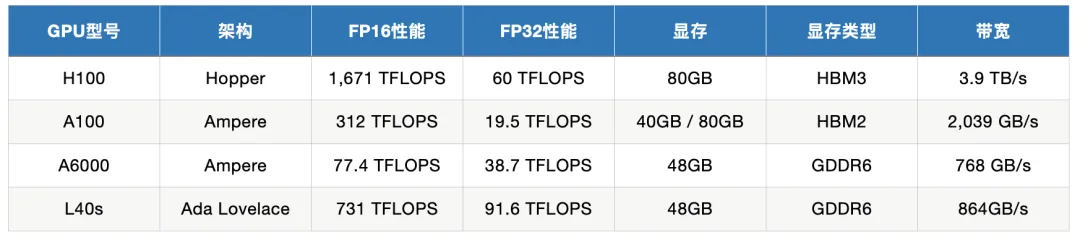

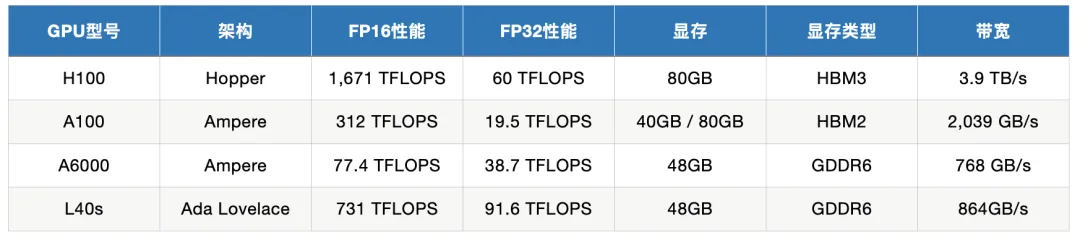

深度|NVIDIA旗舰GPU对比:H100、A6000、L40S、A100在训练与推理中的应用

深度|NVIDIA旗舰GPU对比:H100、A6000、L40S、A100在训练与推理中的应用通过深入分析这些 GPU 的性能指标,我们将探讨它们在模型训练和推理任务中的适用场景,以帮助用户在选择适合的 GPU 时做出明智的决策。同时,我们还会给出一些实际有哪些知名的公司或项目在使用这几款 GPU。

通过深入分析这些 GPU 的性能指标,我们将探讨它们在模型训练和推理任务中的适用场景,以帮助用户在选择适合的 GPU 时做出明智的决策。同时,我们还会给出一些实际有哪些知名的公司或项目在使用这几款 GPU。

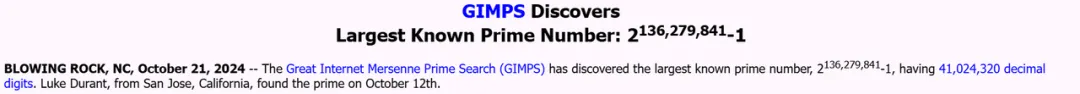

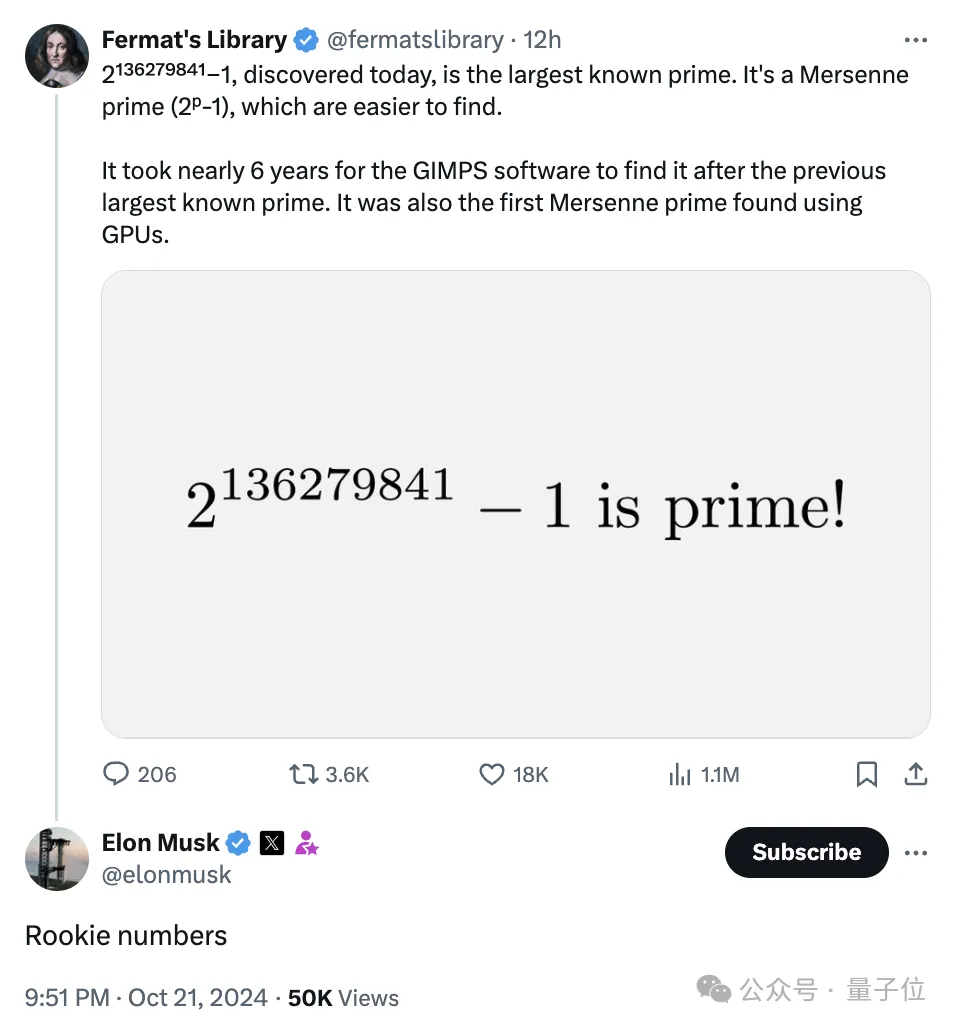

人类已知最大的素数,被GPU发现了!英伟达前员工Luke Durant发现的2136279841-1,比前一个纪录保持者多出1600万位,由A100计算,H100确认。为此,小哥搭了数千个GPU的「云超算」,分布在17个国家。

新的人类已知最大素数,被GPU发现!

自回归解码已经成为了大语言模型(LLMs)的事实标准,大语言模型每次前向计算需要访问它全部的参数,但只能得到一个token,导致其生成昂贵且缓慢。

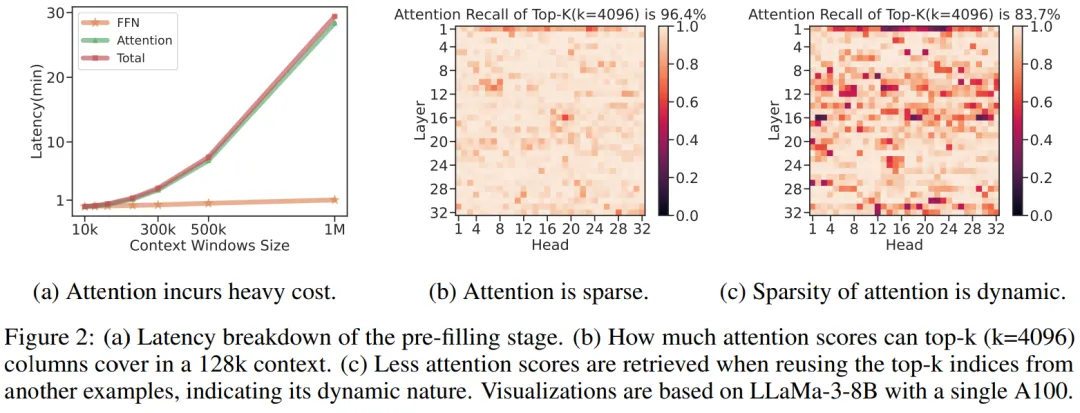

微软的这项研究让开发者可以在单卡机器上以 10 倍的速度处理超过 1M 的输入文本。

在中文互联网上,英伟达每天都在被颠覆。绝大部分自媒体和短视频达人都讨厌英伟达,包括周鸿祎在内。他们千方百计地指出,某种替代品(不管是不是国产)的性能指标已经超过英伟达A100或H100,后者即将沦为资本市场历史上最大的泡沫云云。尤其是在B站、小红书这样的平台,“英伟达将迅速被替代”可以被视为一致观点,反对这个观点的人将遭到群嘲。

可在单张A100/H100 GPU或TPU主机上高效运行全精度推理。

昨晚,谷歌正式开源了自家最强的开源模型Gemma 2,直指为全球范围研究开发者提供实用部署工具。

近日,LeCun和谢赛宁等大佬,共同提出了这一种全新的SOTA MLLM——Cambrian-1。开创了以视觉为中心的方法来设计多模态模型,同时全面开源了模型权重、代码、数据集,以及详细的指令微调和评估方法。

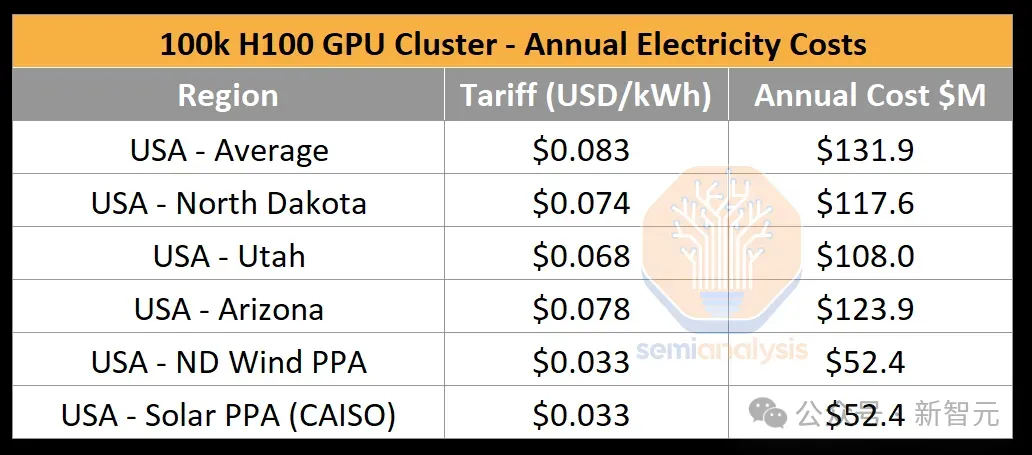

在英伟达市值猛涨、各家科技巨头囤芯片的热潮中,我们往往会忽视GPU芯片是如何转变为数据中心算力的。最近,一篇SemiAnalysis的技术文章就深入解读了10万卡H100集群的构建过程。