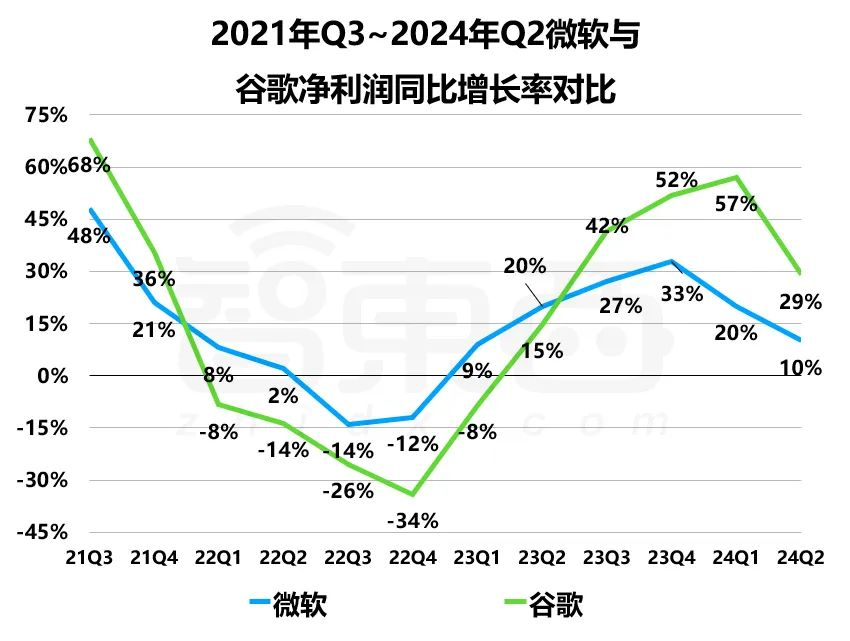

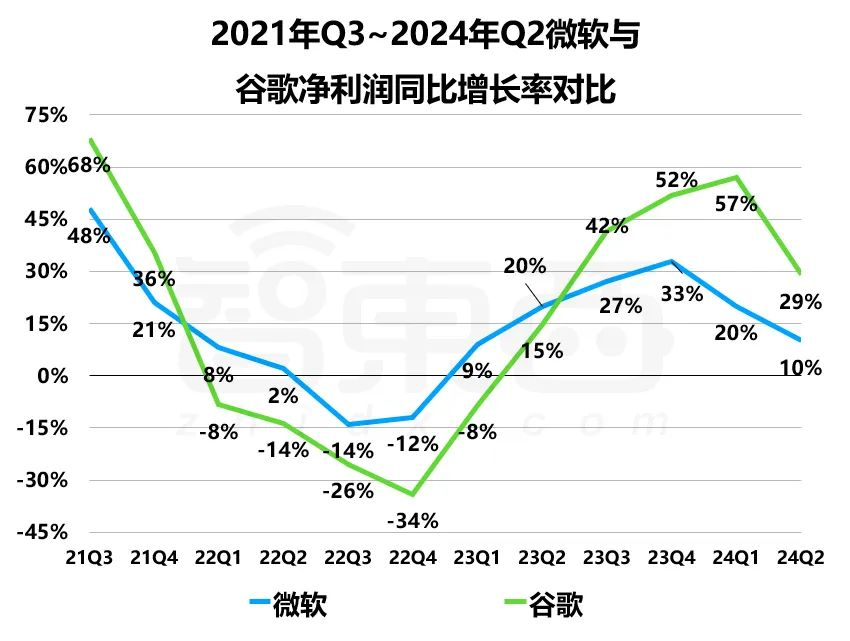

AI带不飞云巨头

AI带不飞云巨头AI仅拉动微软Azure云增长8%,谷歌云季收入首超百亿美元。

AI仅拉动微软Azure云增长8%,谷歌云季收入首超百亿美元。

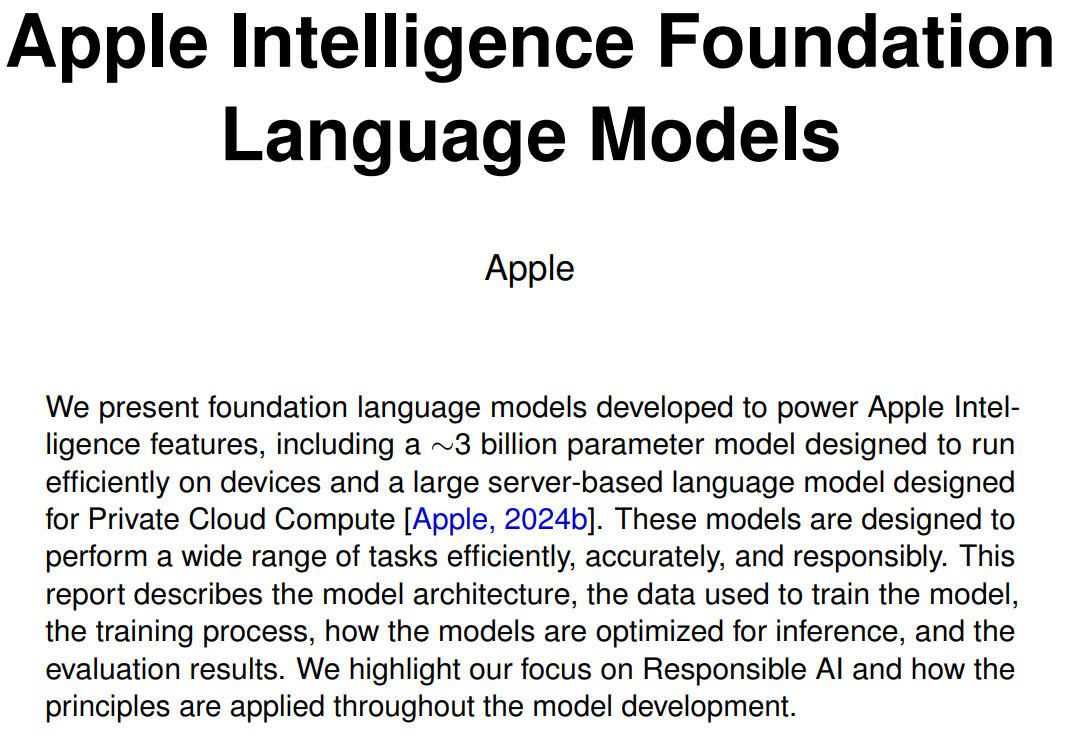

在 2024 年全球开发者大会上,苹果重磅推出了 Apple Intelligence,这是一个全新的个性化智能系统, 可以提供实用的智能服务,覆盖 iPhone、iPad 和 Mac,并深度集成在 iOS 18、iPadOS 18 和 macOS Sequoia 中。

Apple Intelligence在iOS 18.1中亮相,但在欧盟地区不可用。

今早,所有开发者们被突如其来iOS 18.1测试版砸晕了!没想到,苹果AI这就可以上手尝鲜了,一大波测评刷屏全网。更惊喜的是,苹果AI背后的基础模型47页技术报告,也一并上线了。

只用1890美元、3700 万张图像,就能训练一个还不错的扩散模型。

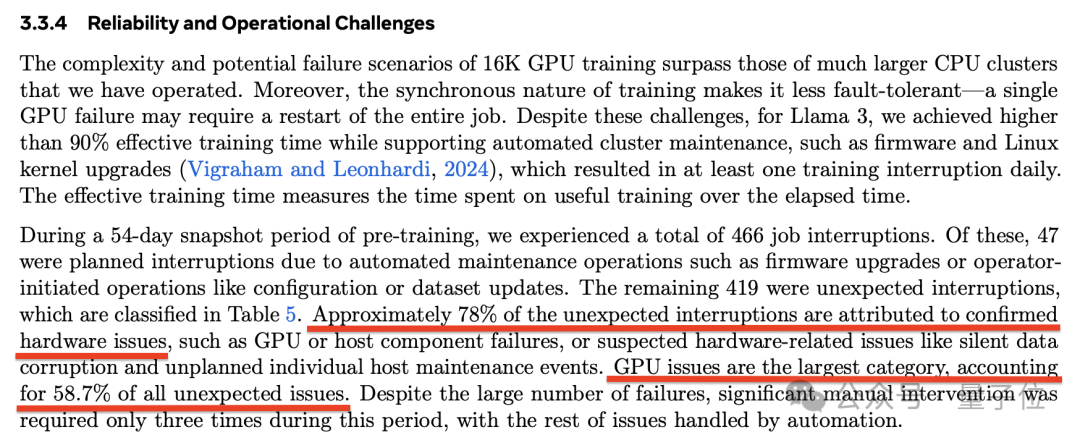

每3个小时1次、平均1天8次,Llama 3.1 405B预训练老出故障,H100是罪魁祸首?

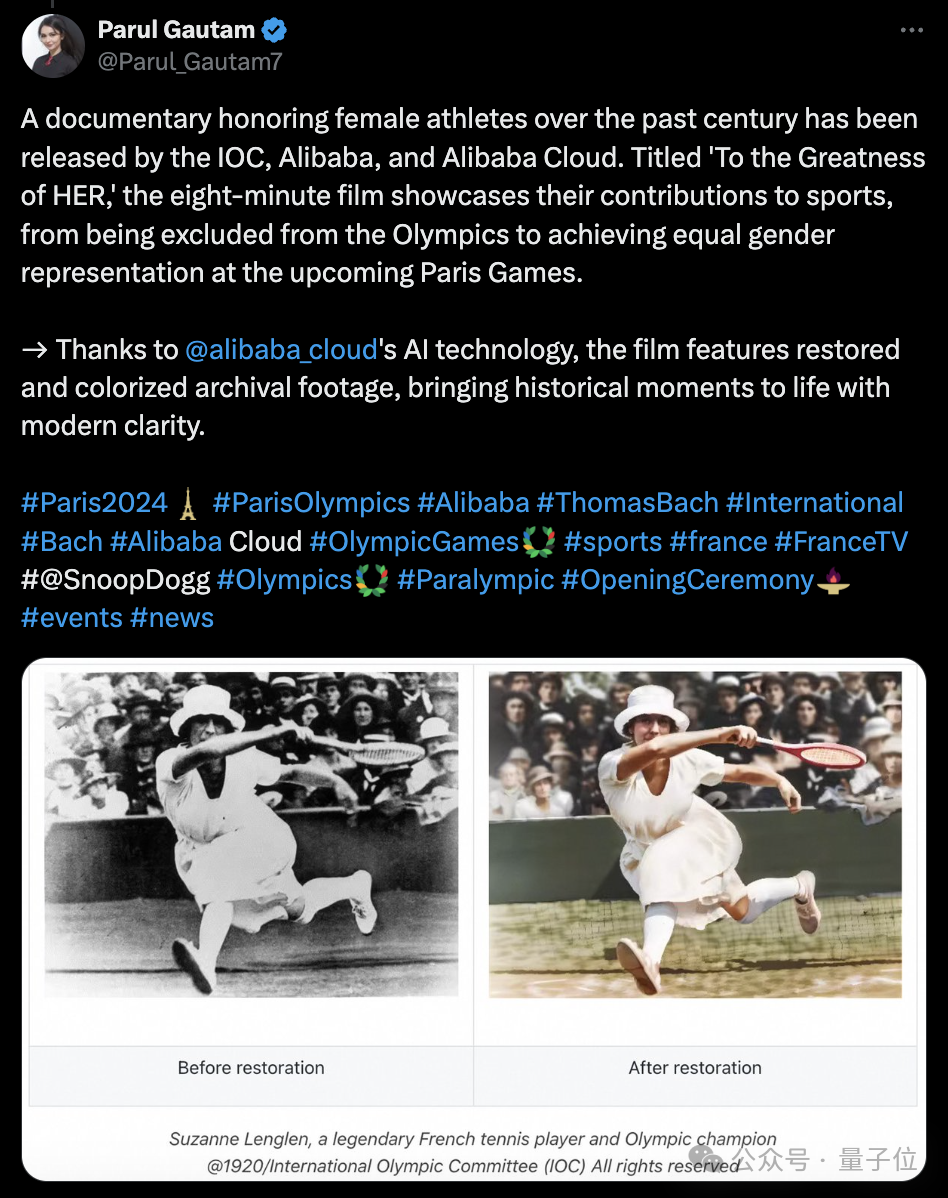

前沿AI科技,现在已经被用在了奥运会上。并且背后提供支持的,是中国科技力量。

人到中年,想半路出家转行成机器学习工程师,可行吗?最近,这位成功转行的国外小哥用一篇干货满满的硬核博客告诉我们:完全可以!

Scale AI 的创始人 8 年前意识到,所有干 AI 的都认为数据至关重要,但没多少人把数据当成主业。

每年需付微软40亿美元?