人类首次用AI反腐!美国众议院议长提交3800亿政府预算,被马斯克用AI查出夹带私货

人类首次用AI反腐!美国众议院议长提交3800亿政府预算,被马斯克用AI查出夹带私货17日众议院议长约翰逊提交避免行政部门停摆的3800亿美元紧急预算,一千五百页的文件只给议员留了17小时审查时间,按以往经验谁也看不完最后会顺利通过。但这次马斯克的DOGE部门启用AI(Gork)总结文档摘要,查出被塞进去的私货,包括给议员加薪40%、给议员增加健康保险等条款。

17日众议院议长约翰逊提交避免行政部门停摆的3800亿美元紧急预算,一千五百页的文件只给议员留了17小时审查时间,按以往经验谁也看不完最后会顺利通过。但这次马斯克的DOGE部门启用AI(Gork)总结文档摘要,查出被塞进去的私货,包括给议员加薪40%、给议员增加健康保险等条款。

在人工智能快速发展的当下,这个问题有了新的答案——处理284张720P的图片。2023年12月,随着字节跳动发布最新的豆包视觉理解模型,AI领域又迎来一次"降维打击":每千tokens的输入价格降至3厘,较行业常见价格低了整整85%。

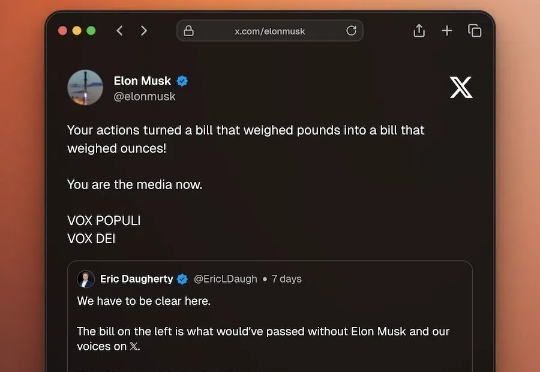

近日,上海联影医疗科技股份有限公司(简称:联影医疗)发布公告显示,联影医疗拟以自有资金投资上海联影智能医疗科技有限公司(简称“联影智能”),交易价格为2848.72万元,取得其增资后0.2849%股权。

IT之家 12 月 27 日消息,理想同学 App 现上架苹果 App Store,商店页面显示该应用当前版本为 1.0.0、大小约 89.2MB,是由理想汽车依托自研大模型打造的人工智能应用。

1822 年,电学之父法拉第在日记中写到“既然通电能够产生磁力,为什么不能用磁铁产生电流呢?我一定要反过来试试!”。于是在 1831 年,第一台发电机被发明,推动了人类进入电气化时代。

2024年大模型融资火热,全球超4000亿。2024年——大模型创企正与巨额融资深度绑定。仅在2024年最后一个月,就有xAI拿下60亿美元、阶跃星辰的数亿美元、Perplexity AI的5亿美元、智谱AI 30亿元、Liquid AI的2.5亿美元……

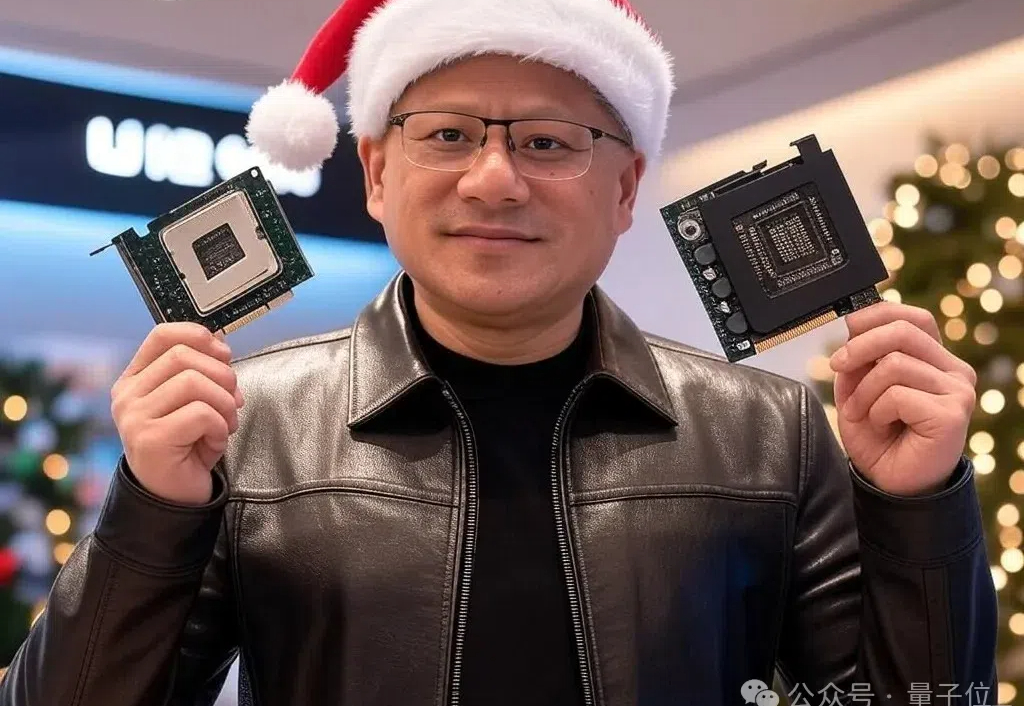

GPU新核弹B300,以及附带CPU的超级芯片GB300。 高算力,在产品层面上相比B200在FLOPS上提高50% 大显存,从192GB提升到288GB,也是提高了50%。

Mindgard 宣布完成800万美元的融资,旨在加速其研发进程,并推动其在美国市场的扩展。此次融资由.406Ventures 领投,参与投资的还有 Atlantic Bridge、Willowtree Investments 及现有投资者 IQ Capital 和 Lakestar。同时,Mindgard 还任命了两位行业领军人物,分别担任产品负责人和市场副总裁,以强化公司的产品开发和市场推广。

1866年,西门子的一位工程师发明了人类第一台直流发电机。

我们“解剖”了2024年最具迷惑性的商业骗局,将其制作成一份“职场防诈指南”,送给可能要在2025年求职的你。