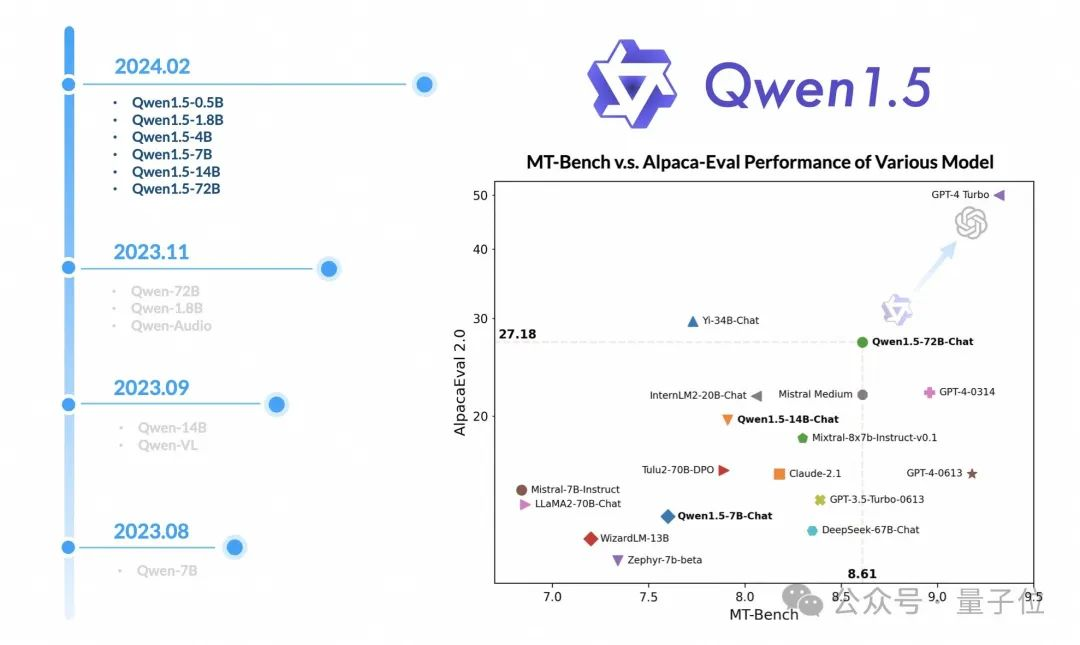

阿里大模型春节礼包来了:代码可执行率超GPT-4,1.5版本全系列开源

阿里大模型春节礼包来了:代码可执行率超GPT-4,1.5版本全系列开源阿里大模型,再次开源大放送——发布Qwen1.5版本,直接放出六种尺寸。

阿里大模型,再次开源大放送——发布Qwen1.5版本,直接放出六种尺寸。

2000年前碳化的古卷轴,成功被AI破译了近5%的内容。三人天才团队拿下70万美元大奖,谷歌华人工程师一人拿下并列亚军。

分手8个月想挽回,女友却爱上了AI男友,怎么破?这位美国博士小哥选择用错误数据毒害模型,训成一个妥妥的负分男友,结果,女友果真来找他了……

2023 年 12 月,首个开源 MoE 大模型 Mixtral 8×7B 发布,在多种基准测试中,其表现近乎超越了 GPT-3.5 和 LLaMA 2 70B,而推理开销仅相当于 12B 左右的稠密模型。为进一步提升模型性能,稠密 LLM 常由于其参数规模急剧扩张而面临严峻的训练成本。

把小扎从元宇宙大坑中拯救出来的,居然是开源AI!市值大涨的Meta,现在能让小扎一年分红7亿美元。股价图一出,LeCun都评论:有意思。

哈佛大学将AI引入CS课程,学生的个性化「导师」,学习效率拉满!

有的大模型对齐方法包括基于示例的监督微调(SFT)和基于分数反馈的强化学习(RLHF)。然而,分数只能反应当前回复的好坏程度,并不能明确指出模型的不足之处。相较之下,我们人类通常是从语言反馈中学习并调整自己的行为模式。

华中科技大学联合华南理工大学、北京科技大学等机构的研究人员对14个主流多模态大模型进行了全面测评,涵盖5个任务,27个数据集。

一个体量仅为2B的大模型,能有什么用?答案可能超出你的想象。

在 AI 赛道中,与动辄上千亿参数的模型相比,最近,小模型开始受到大家的青睐。比如法国 AI 初创公司发布的 Mistral-7B 模型,其在每个基准测试中,都优于 Llama 2 13B,并且在代码、数学和推理方面也优于 LLaMA 1 34B。