NeurIPS 2025 | 英伟达发布Nemotron-Flash:以GPU延迟为核心重塑小模型架构

NeurIPS 2025 | 英伟达发布Nemotron-Flash:以GPU延迟为核心重塑小模型架构导读 过去两年,小语言模型(SLM)在业界备受关注:参数更少、结构更轻,理应在真实部署中 “更快”。但只要真正把它们跑在 GPU 上,结论往往令人意外 —— 小模型其实没有想象中那么快。

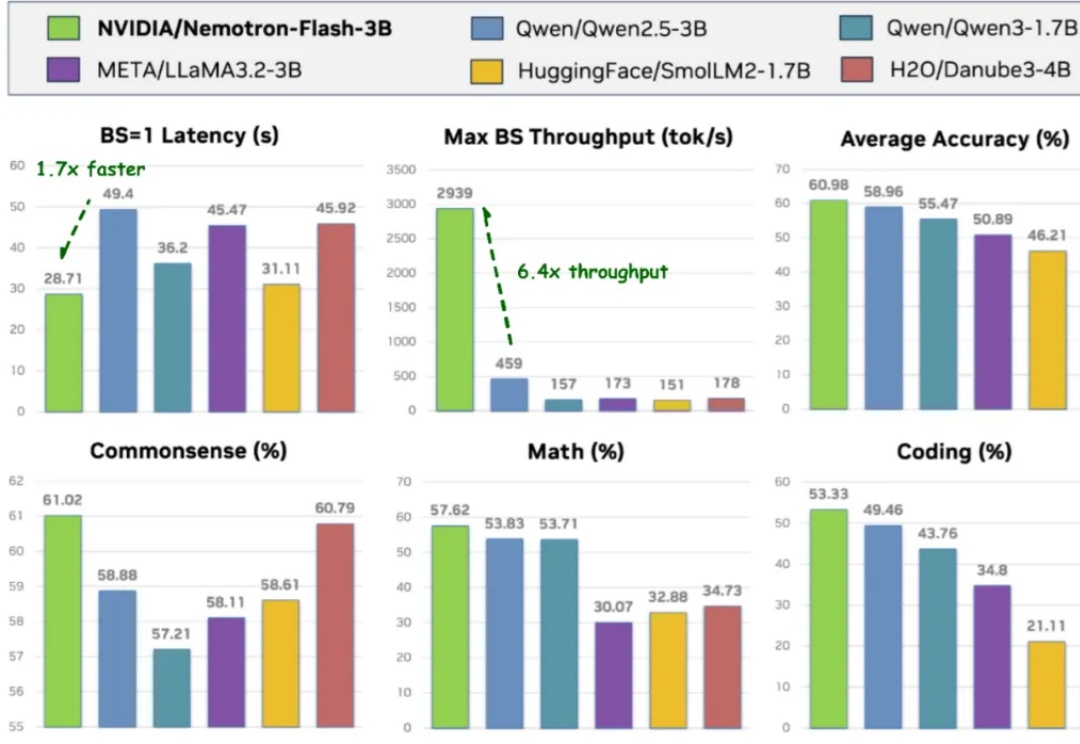

导读 过去两年,小语言模型(SLM)在业界备受关注:参数更少、结构更轻,理应在真实部署中 “更快”。但只要真正把它们跑在 GPU 上,结论往往令人意外 —— 小模型其实没有想象中那么快。

在大语言模型(LLM)的研究浪潮中,绝大多数工作都聚焦于优化模型的输出分布 —— 扩大模型规模、强化分布学习、优化奖励信号…… 然而,如何将这些输出分布真正转化为高质量的生成结果 —— 即解码(decoding)阶段,却没有得到足够的重视。

AI 创作 Agent 正在接管过去最耗时的部分。

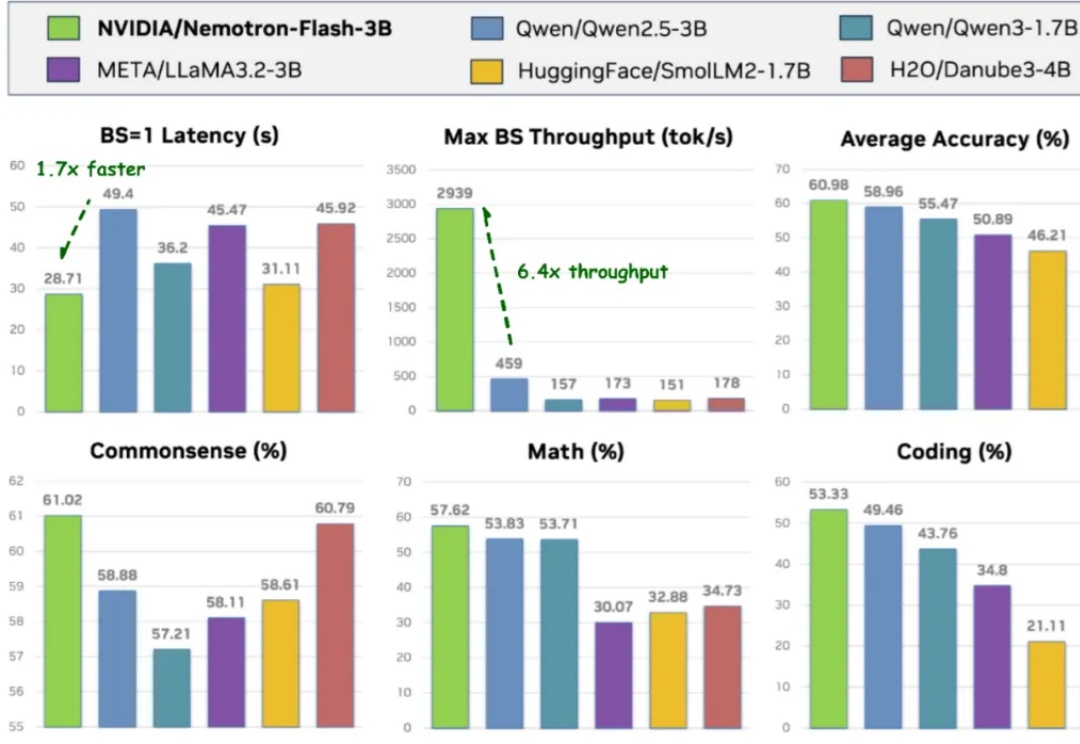

在架构层面,Milvus 2.6 大幅简化系统架构,整合多个核心组件 —— 例如将原有的 Coordinator 组件(含 RootCoord、QueryCoord、DataCoord)统一整合为 MixCoord,并将 IndexNode 与 DataNode 合并为单一组件。这些调整不仅降低了系统复杂度,更显著提升了系统的可维护性与横向扩展性。

尽管 Apple Intelligence 在大陆国行机型上落地仍然杳无音讯,但这并不代表苹果没有在努力推进。 前两天,伴随着 iOS 26.1 版本的更新,Apple Intelligence 先一步提供了对于繁体中文的支持。

a16z 指出:“模型开发的进展正在简化整个基础设施栈,使得语音智能体具备更低延迟和更高性能。这一提升主要出现在过去六个月内,得益于新一代对话模型的出现。”基于这些趋势,Deepgram 与 Opus Research 合作开展的《2025 语音 AI 状况调查报告》,基于 400 位商业领袖的洞察,涵盖十多个行业,分析了语音 AI 的应用现状与关键特性。

Digital Connexion 是由穆克什·安巴尼的依赖工业有限公司 、布鲁克菲尔德资产管理公司以及 Digital Realty Trust 共同组建的合资企业,已签署协议计划到 2030 年投资 110 亿美元在印度南部开发 数据 中心设施,标志着对科技领域增长最快赛道之一的最新投资。

CB Insights 发布的《2025 Future Tech Hotshots:Scouting Reports》报告,结合生成式 AI 分析与专有 Mosaic 评分体系,从全球海量初创企业中遴选出 45 家最具潜力的科技公司。

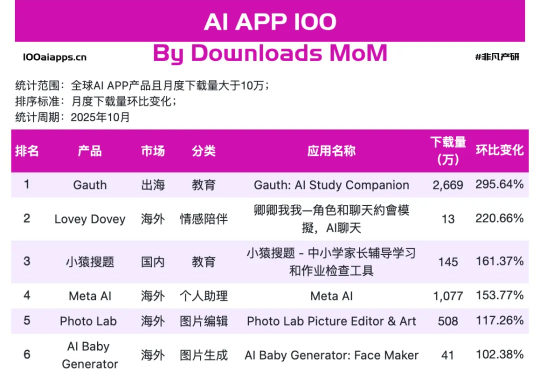

但当我们把视线从焦点模型上,挪到手机里AI应用真实数据上,就会发现一幅不同的画面。可以看到在非凡产研 10 月 AI App 增速榜上,跑得最快的那 17 个,并不是万事皆可聊的通用助手,而是一群看上去有点普通、甚至有点土气的小应用,其中Gauth、Starry、Knowunity、AI Baby Generator已经连续两个月上榜了。

大模型推理的爆发,实际源于 scaling 范式的转变:从 train-time scaling 到 test-time scaling(TTS),即将更多的算力消耗部署在 inference 阶段。典型的实现是以 DeepSeek r1 为代表的 long CoT 方法:通过增加思维链的长度来获得答案精度的提升。那么 long CoT 是 TTS 的唯一实现吗?