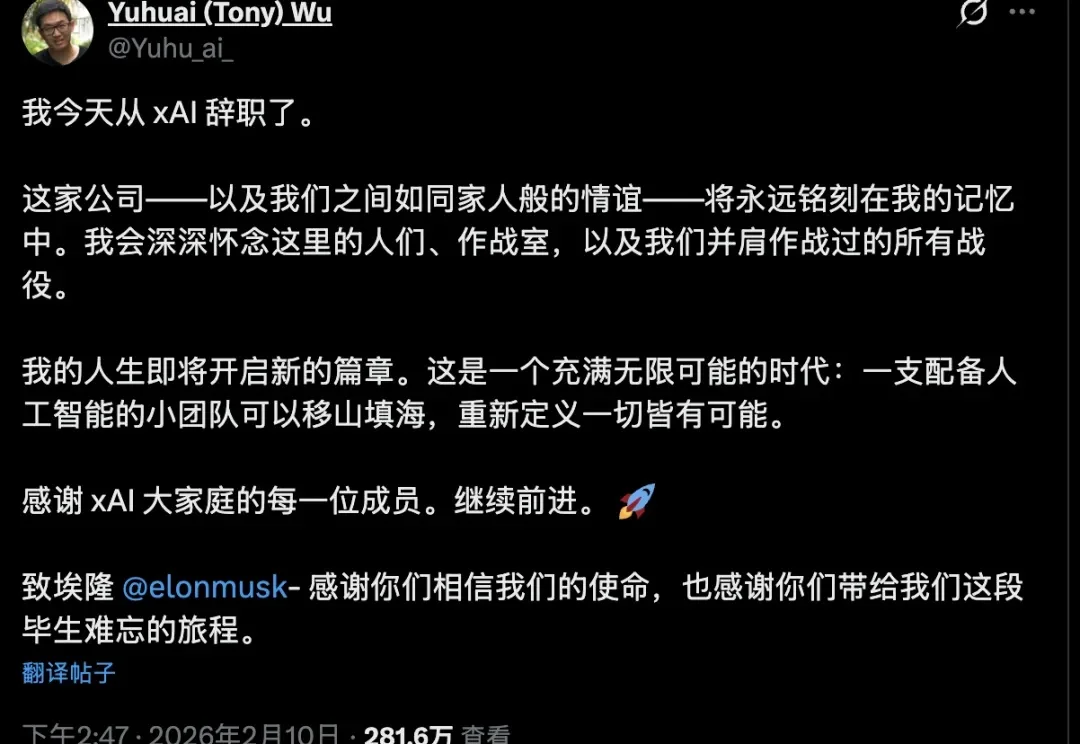

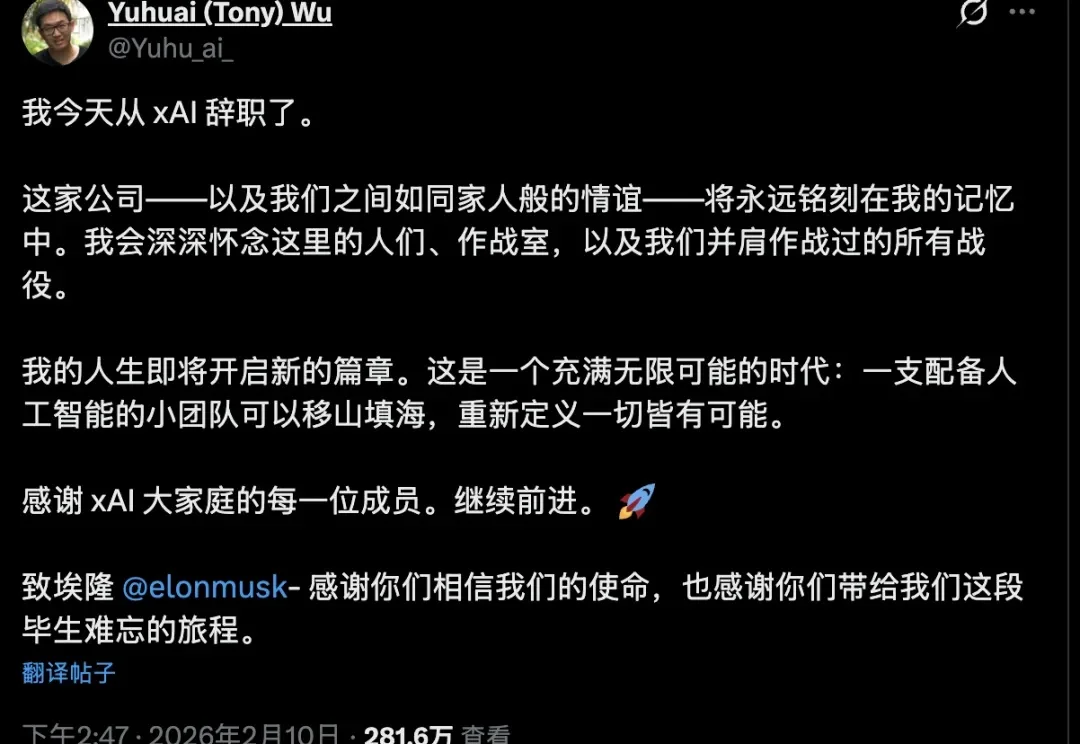

马斯克xAI雪崩!24小时两联创离职,一月内连失三位华人创始人,12人梦之队只剩一半

马斯克xAI雪崩!24小时两联创离职,一月内连失三位华人创始人,12人梦之队只剩一半24小时内,马斯克的xAI连失两位华人联合创始人。

24小时内,马斯克的xAI连失两位华人联合创始人。

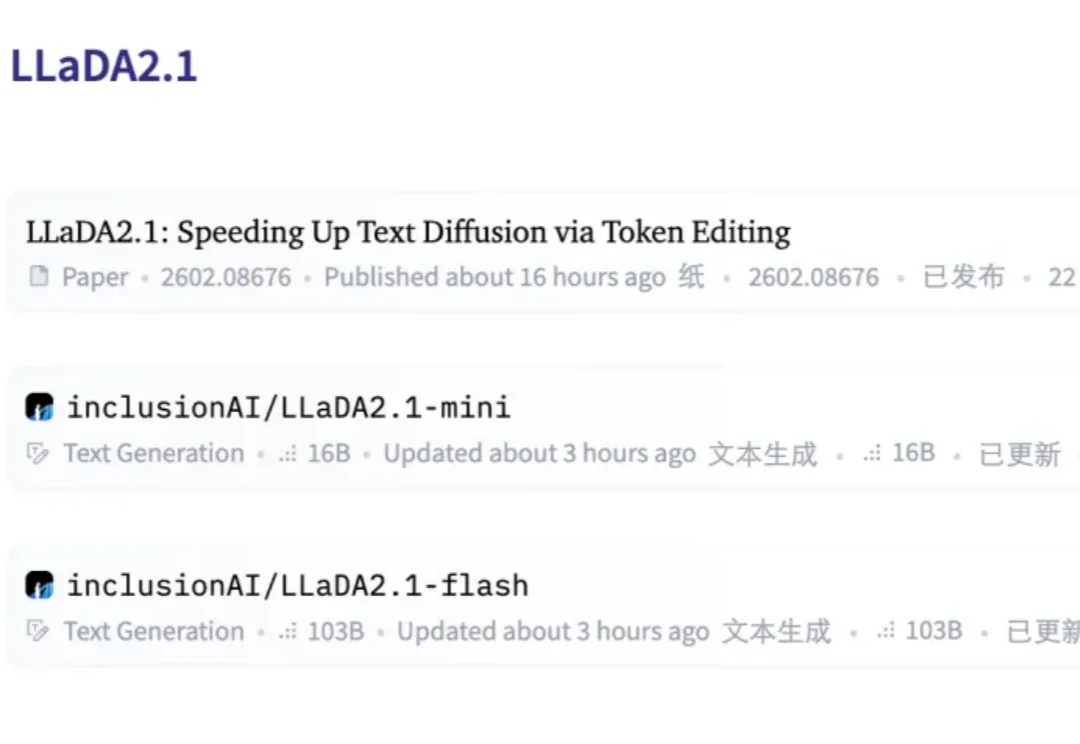

扩散语言模型(dLLM),这个曾被认为是「小众赛道」的研究方向,如今终于迎来了质变。

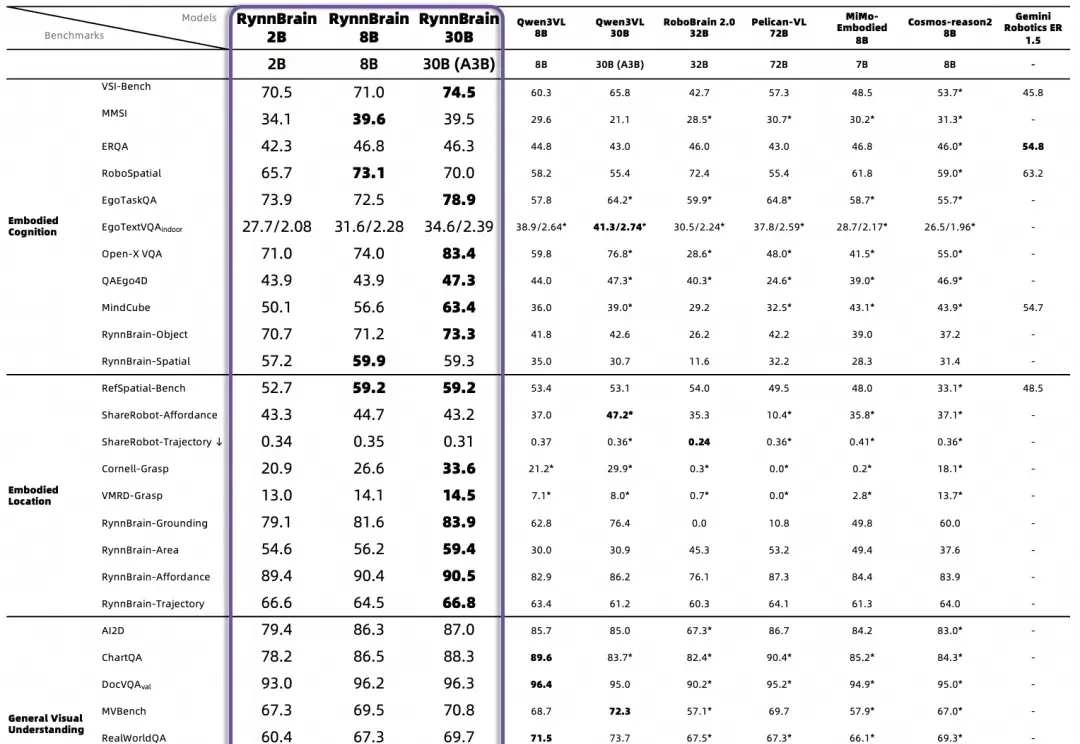

CEO高继扬判断,2026年下半年,具身智能将进入 “成果验证”阶段。

Anthropic刚刚扔出一份18页重磅炸弹:《2026年智能体编码趋势报告》。结论直接炸裂:程序员不再写代码了,他们变成了「指挥官」。

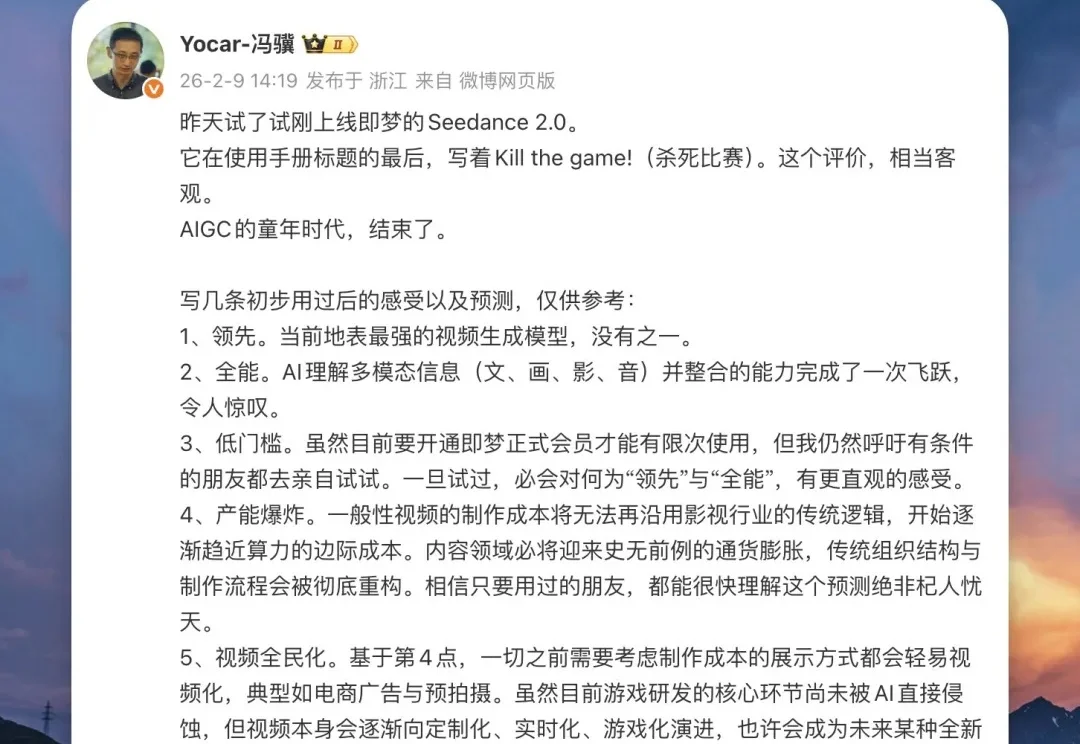

Seedance2.0的火,已经烧了好几天了。

大家好,我是袋鼠帝。 最近又要到年末了,不知道大家的年终总结PPT都交了没。

你斥巨资买回家的全能家务机器人,正在执行“把药片拿给奶奶”的任务。

「临界点」在2025年已卖了数千只灵巧手。

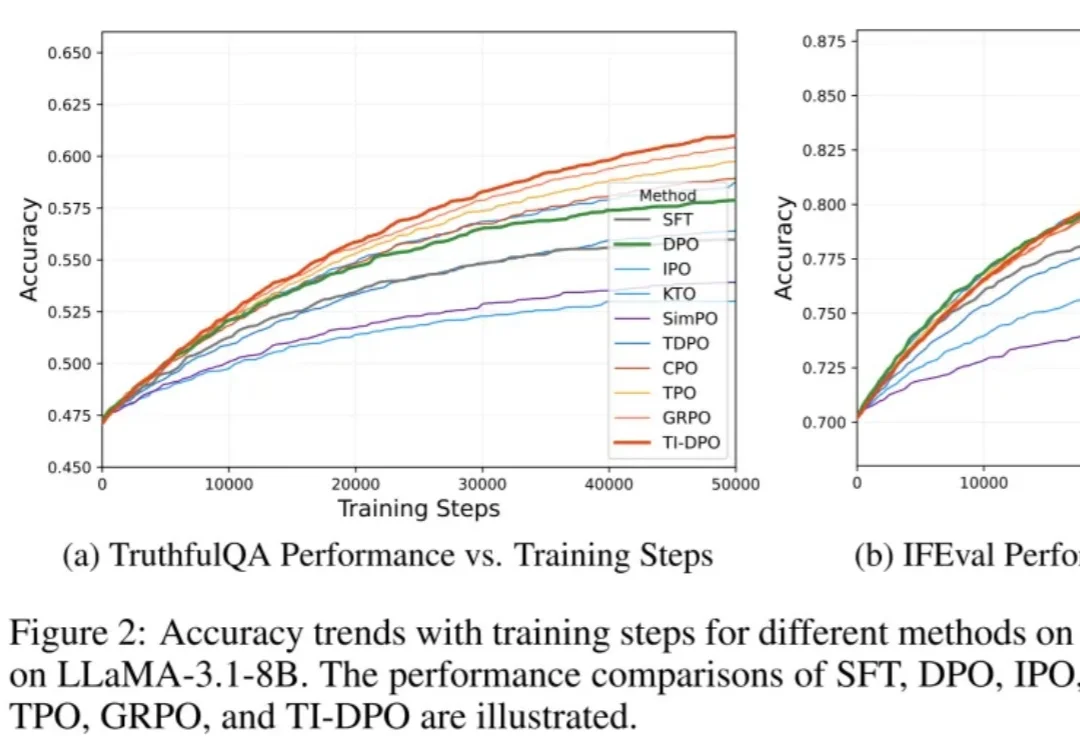

在当今的大模型后训练(Post-training)阶段,DPO(直接偏好优化) 凭借其无需训练独立 Reward Model 的优雅设计和高效性,成功取代 PPO 成为业界的 「版本之子」,被广泛应用于 Llama-3、Mistral 等顶流开源模型的对齐中。

BUBBLE 2026 — ISSUE #18 家人们, 马上没几天快过年了,明显各个厂商已经开始疯狂卷了。 上周到现在,让我们来算算有多少东西了, 5.3 Codex,4.6 Opus, 可灵3.0