老黄200亿「钞能力」回应谷歌:联手Groq,补上推理短板

老黄200亿「钞能力」回应谷歌:联手Groq,补上推理短板老黄稳准狠,谷歌的TPU威胁刚至,就钞能力回应了。

老黄稳准狠,谷歌的TPU威胁刚至,就钞能力回应了。

2025 年,AI 不仅占据话题 C 位,更成为超级造富机,将 50 多位创始人送入亿万富翁俱乐部。本文将盘点这场史无前例的 AI 财富狂欢与背后的顶级赢家。

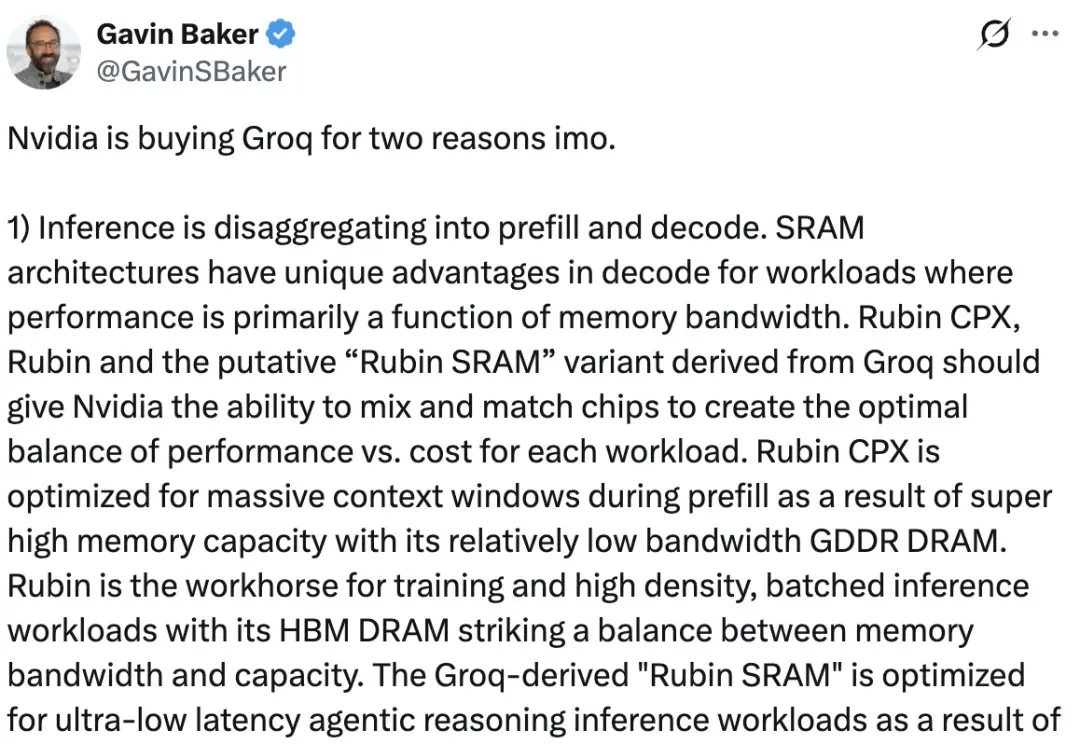

2025年12月5日,纽约时报(NYT)起诉Perplexity版权侵权。Perplexity是一家“小而美”的开发生成式AI的公司,苹果曾考虑收购它以增强自己的AI能力。

嗨大家好!我是阿真! 原本2025除了年终总结不打算写东西了,这个是我准备线下分享的内容的时候,写着写着觉得还是挺有意思的,所以按照文章的格式优化了一下分享出来。

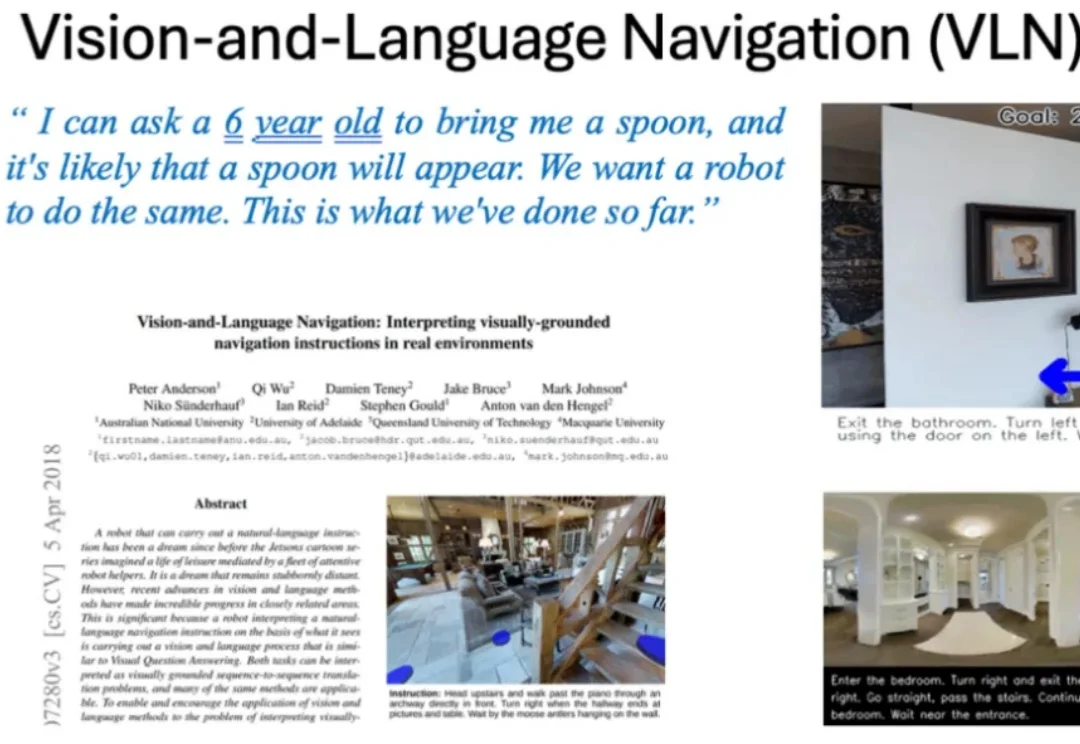

告别碎片化!以全栈之姿,开启具身导航的 2026 新篇章。

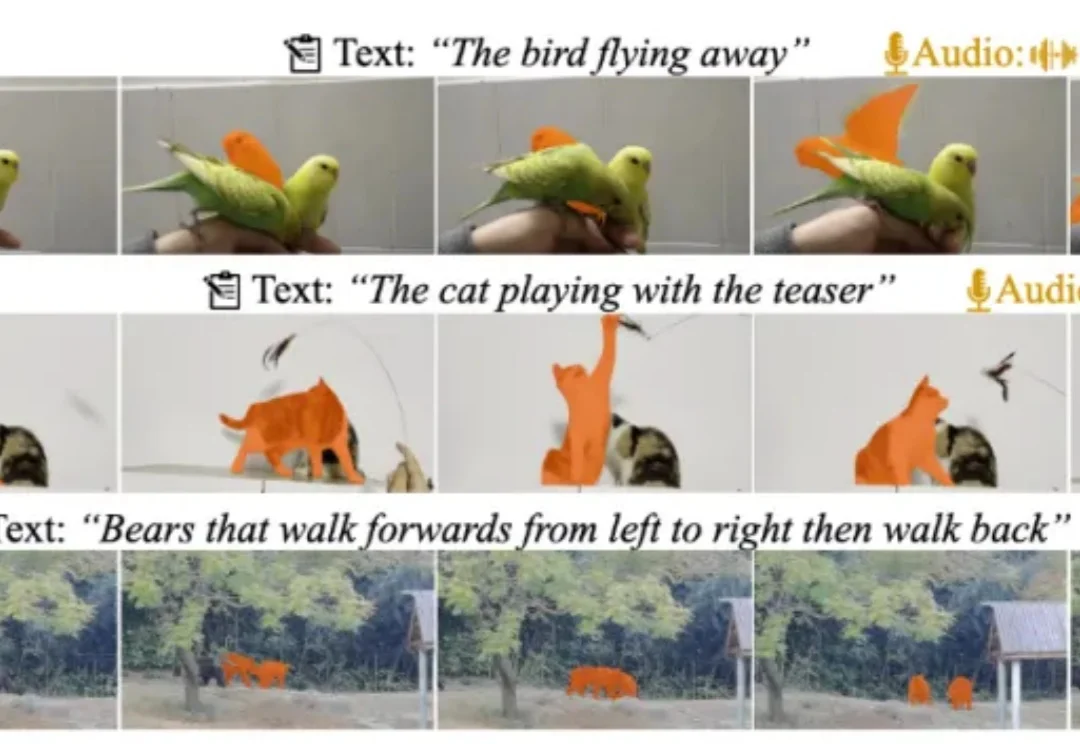

近日,多模态视频理解领域迎来重磅更新!由复旦大学、上海财经大学、南洋理工大学联合打造的 MeViSv2 数据集正式发布,并已被顶刊 IEEE TPAMI 录用。

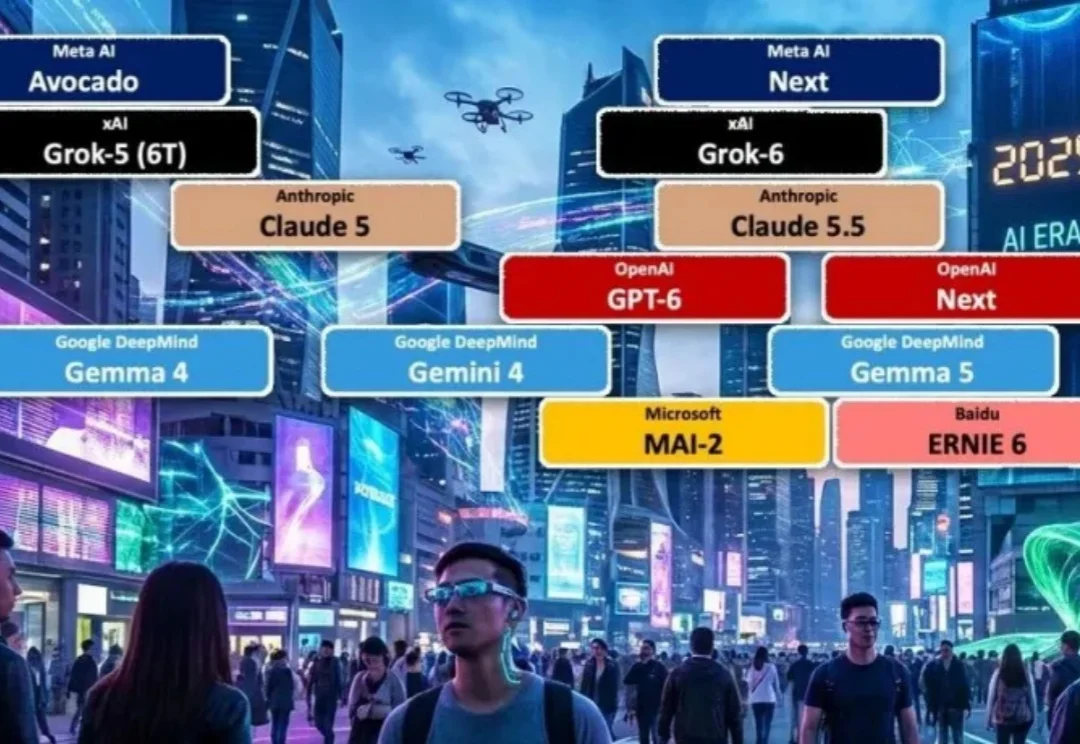

别被 2025 年的模型乱战骗了!这可能是一个巨大的误判。 LifeArchitect在上帝视角复盘:当下的喧嚣不过是爆发前的「基建期」。 到2026年,从6T规模的Grok-5到消失在后台的GPT-6,全行业正迎来一场蓄谋已久的「集体解锁」。 真正的换代不再是变聪明,而是像iPhone焊死iOS那样,让AI彻底成为文明的基础设施。

近日,部分L3级自动驾驶车型已经通过工信部批准正式上路,这标志着这我国自动驾驶产业的新阶段。

具身智能是2025年的最大的“泡沫”吗?年初,宇树突然放大招,发布了5900美元的R1人形机器人。要知道,就在一年前,业内普遍认为人形机器人的成本底线还在2到3万美元,宇树这一招,相当于把整个行业的价格预期直接打碎。

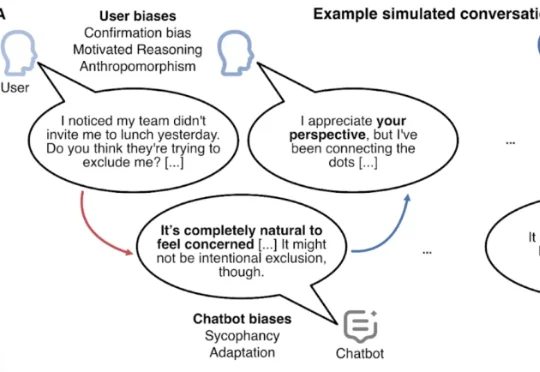

加州大学旧金山分校的一项最新研究,剖析了一名26岁的医护人员在与AI聊天的过程中发生急性精神病的案例。康复后仅3个月,这名医护人员再次因AI聊天产生妄想、精神失常。