争夺AI制高点,谷歌和Anthropic必有一战

争夺AI制高点,谷歌和Anthropic必有一战刚发布Cowork的Anthropic又要融资了。知情人士透露,这家公司正在敲定一轮250亿美元的巨额融资,距离上次融资仅仅过了两个多月。

刚发布Cowork的Anthropic又要融资了。知情人士透露,这家公司正在敲定一轮250亿美元的巨额融资,距离上次融资仅仅过了两个多月。

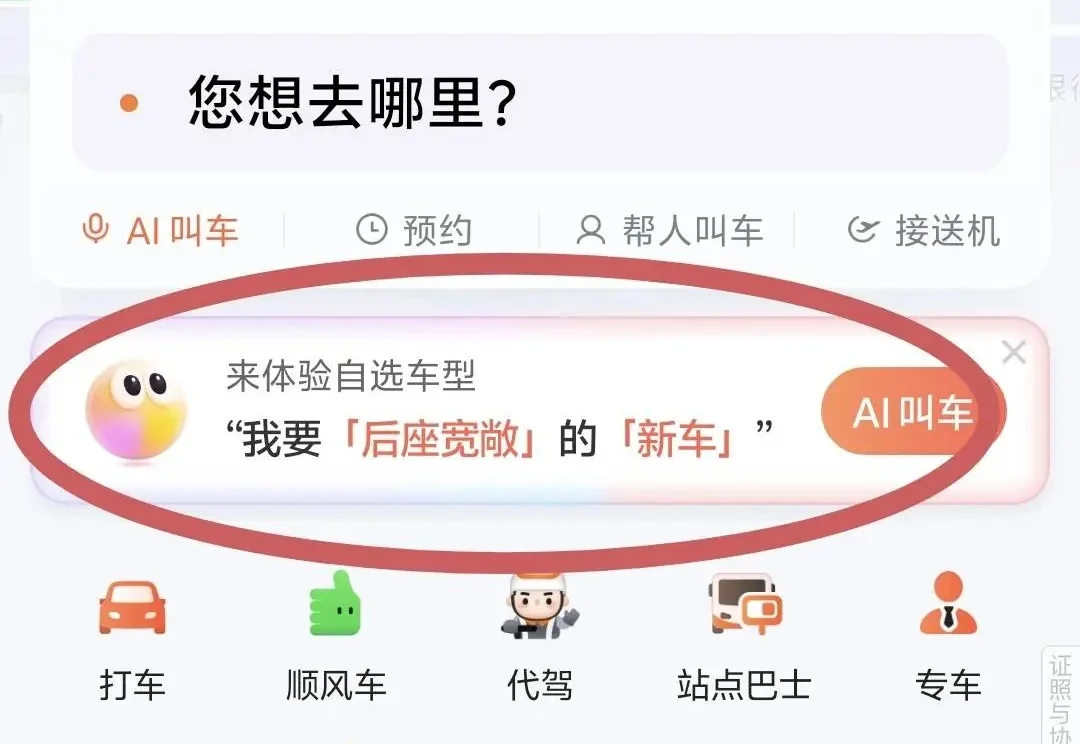

作为一个科技媒体人,基本永远在路上。刚刚过去的 2025 年飞了快 10 万公里,平均每周都要出差一次,让我练就了一个「铁屁股」。

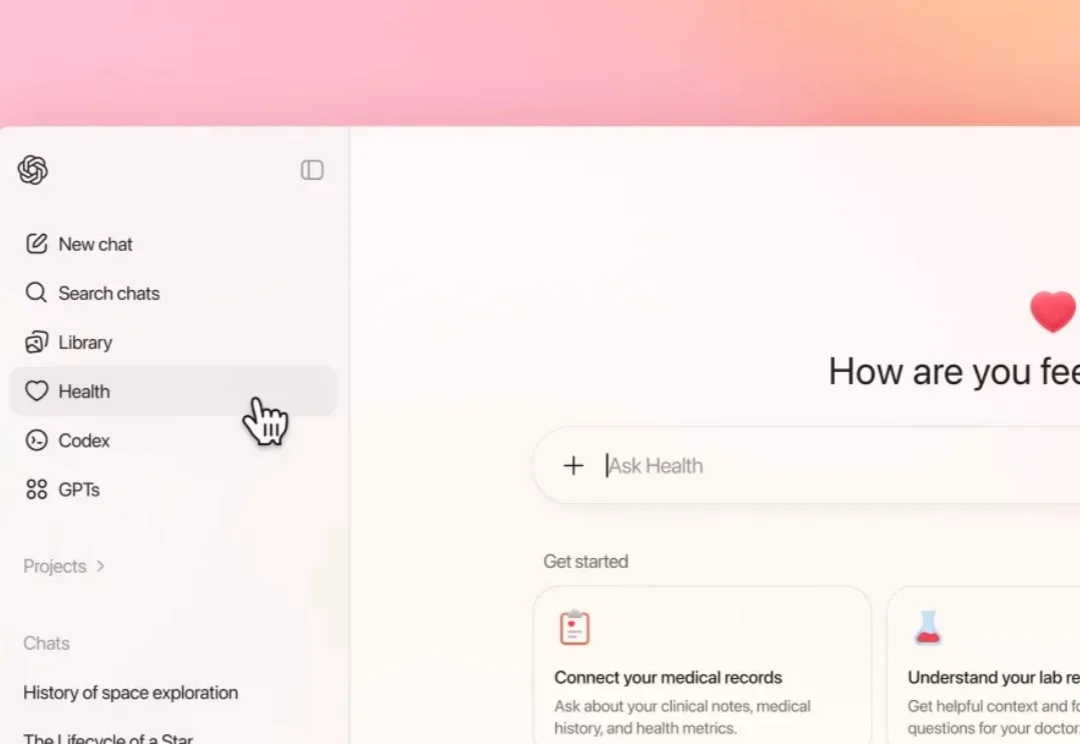

2023 年,当 GPT-4 在美国执业医师资格考试(USMLE)中取得了惊人的高分时,不只是 OpenAI,硅谷都为此喝彩,AI 在医疗上的前景仿佛一片光明。

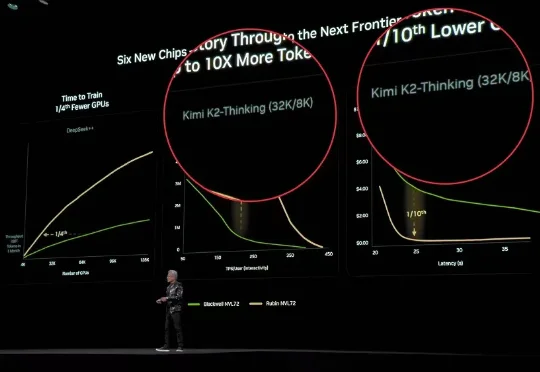

今天,据外媒CNBC报道,两位知情人士透露,北京大模型独角兽月之暗面正在进行新一轮融资,这轮融资对其估值为48亿美元(约合人民币334.13亿元),而仅在20天前公布的C轮融资中其估值还是43亿美元(约合人民币299.32亿元)。

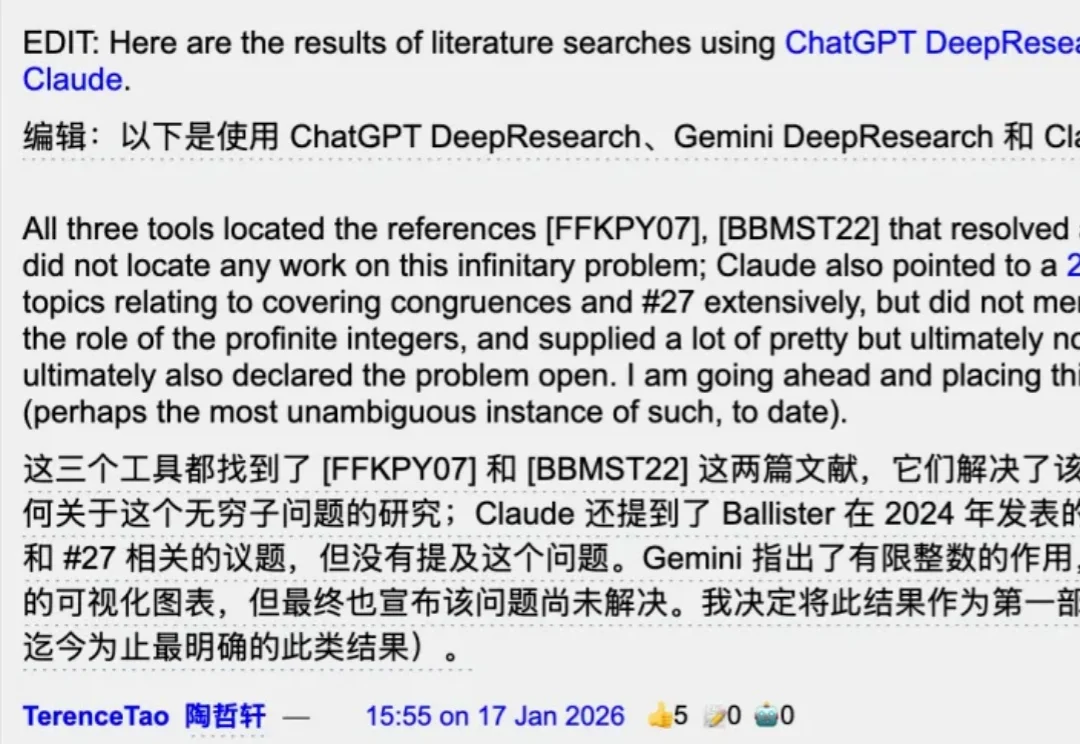

AI证明数学猜想,这次来真的了。

字节跳动的「扣子」在过去两年的「走一步看一步」和不断的「目标横跳」,其实是一个值得 AI 时代产品人研究的宝藏故事。

清华姚班、普林斯顿博士、前 OpenAI 核心成员、27 岁、首席 AI 科学家……当这些标签堆砌在一个人身上时,你很难不感受到一种来自智商层面的压迫感。

复盘2025硅谷人才大战:一场席卷32位AI高管的“大迁徙”。

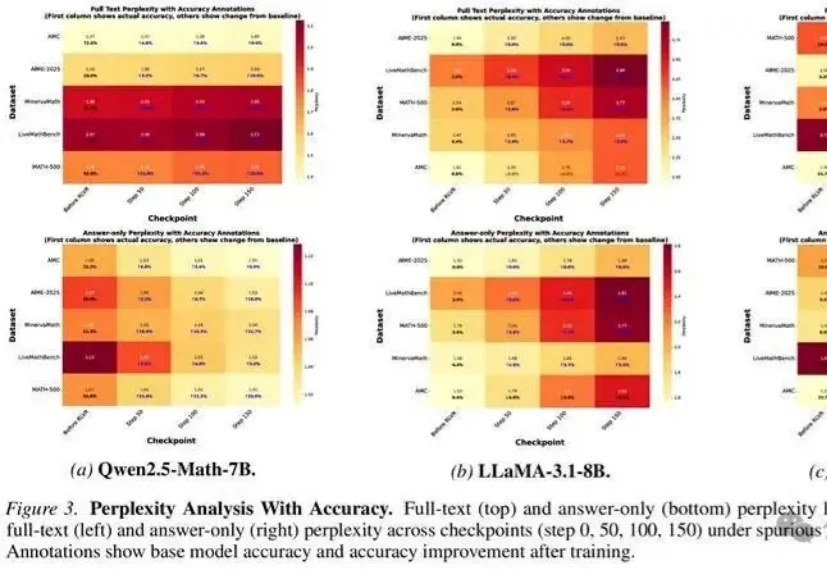

无需真实奖励,哪怕用随机、错误的信号进行训练,大模型准确率也能大幅提升?

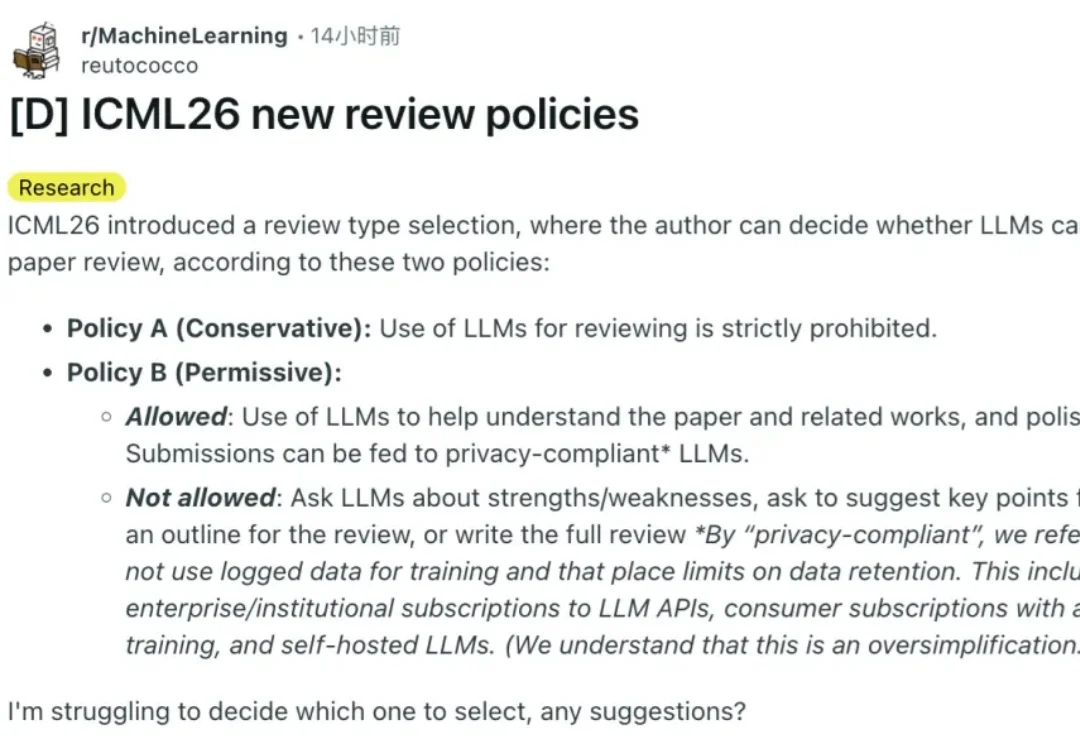

两个月前,ICML 2026发布了征稿新规,我们也详细做了报道。