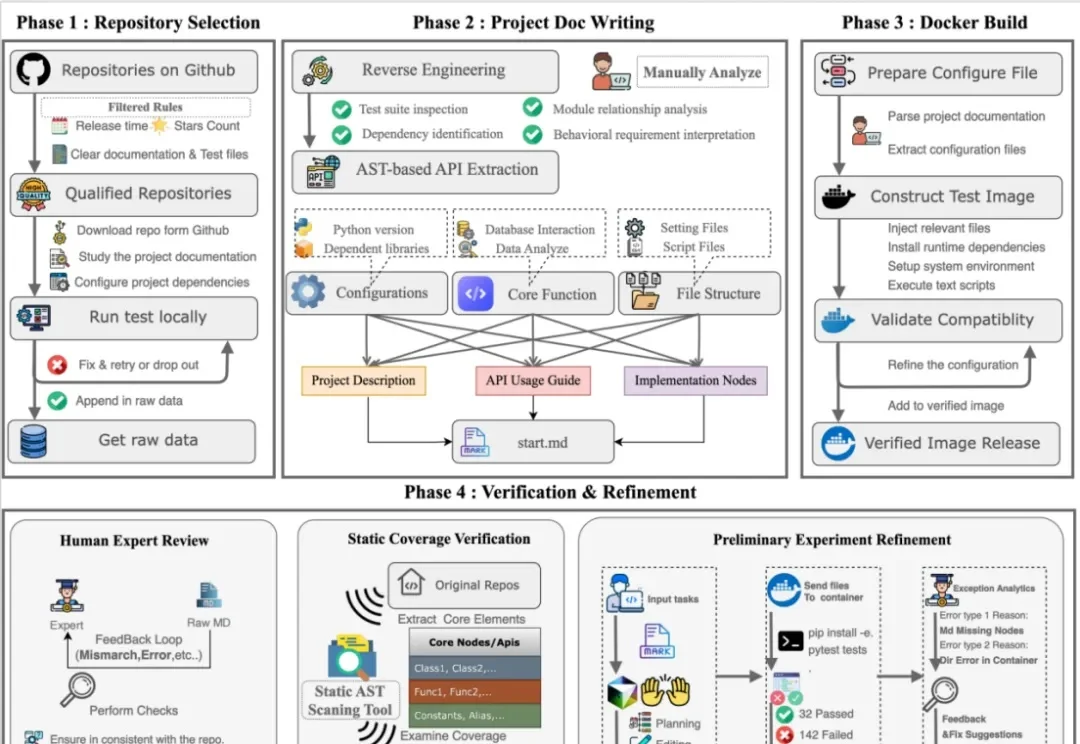

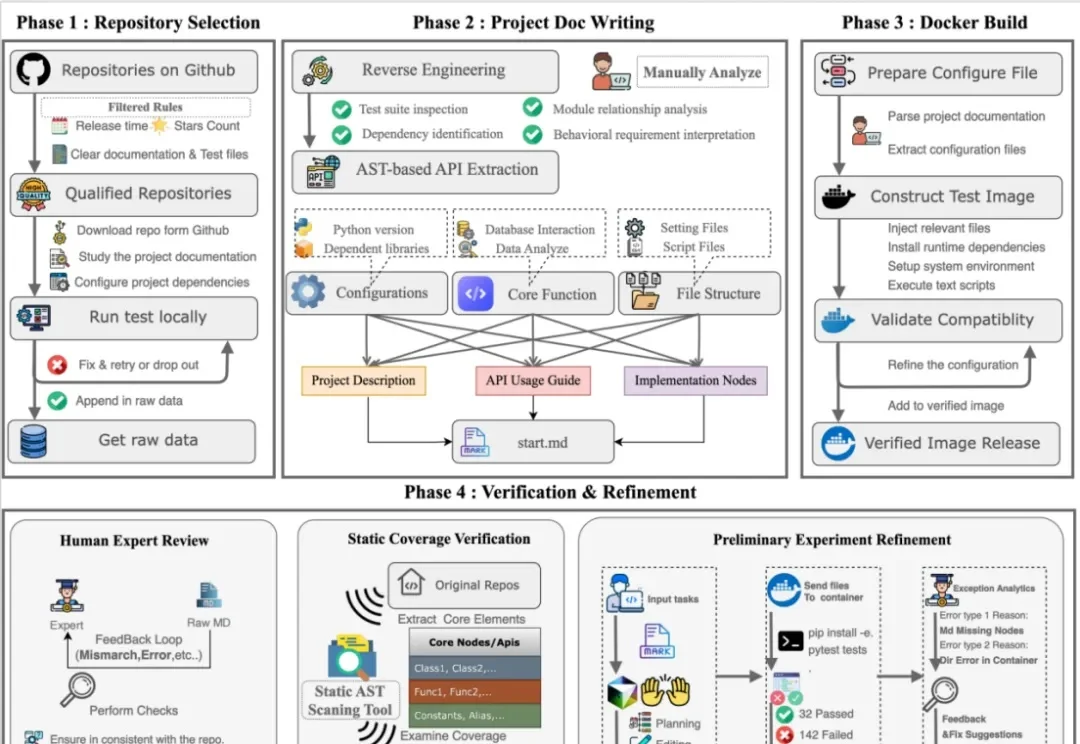

我们离Coding领域的「AGI时刻」还有多远?字节跳动Seed发布NL2Repo-Bench仓库级长程代码生成基准

我们离Coding领域的「AGI时刻」还有多远?字节跳动Seed发布NL2Repo-Bench仓库级长程代码生成基准在 AI 编程领域,大家似乎正处于一个认知错觉的顶点:随着 Coding Agents 独立完成任务的难度和范围逐渐增加,Coding 领域的 AGI 似乎就可以实现?

在 AI 编程领域,大家似乎正处于一个认知错觉的顶点:随着 Coding Agents 独立完成任务的难度和范围逐渐增加,Coding 领域的 AGI 似乎就可以实现?

爆红社交平台、登顶全球评测,中国AI视频模型集体破圈。

就在本月,AI 经历了质变式飞跃,已经能独立完成过去需要人类专家数小时才能搞定的复杂工作。AI 开始参与构建下一代 AI,递归自我提升的循环已经启动,智能爆炸可能在一两年内到来。

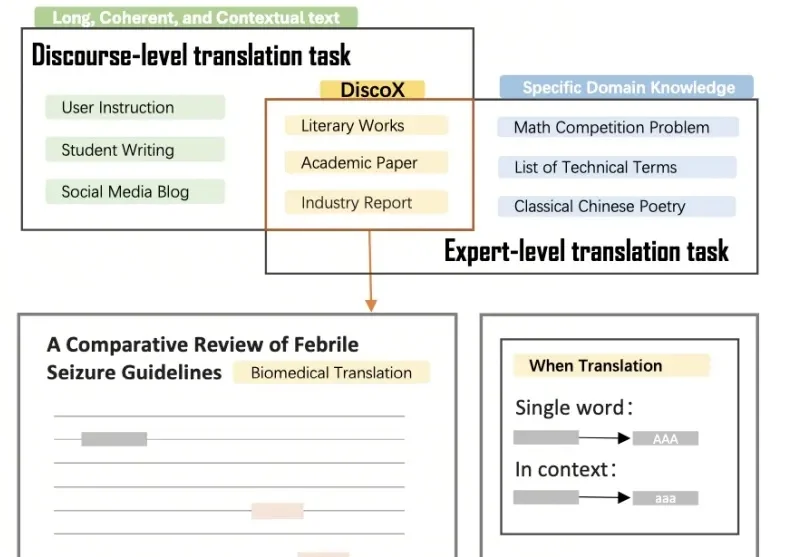

DiscoX构建了一套200题的长文翻译数据集,以平均长度1,712 tokens的长篇章做评测单元,要求整个长文文本作为一个整体来翻译,除翻译准确度外,重点考察跨段落的逻辑与风格一致性、上下文中的术语精确性、以及专业写作规范,贴合用户真实的使用场景。

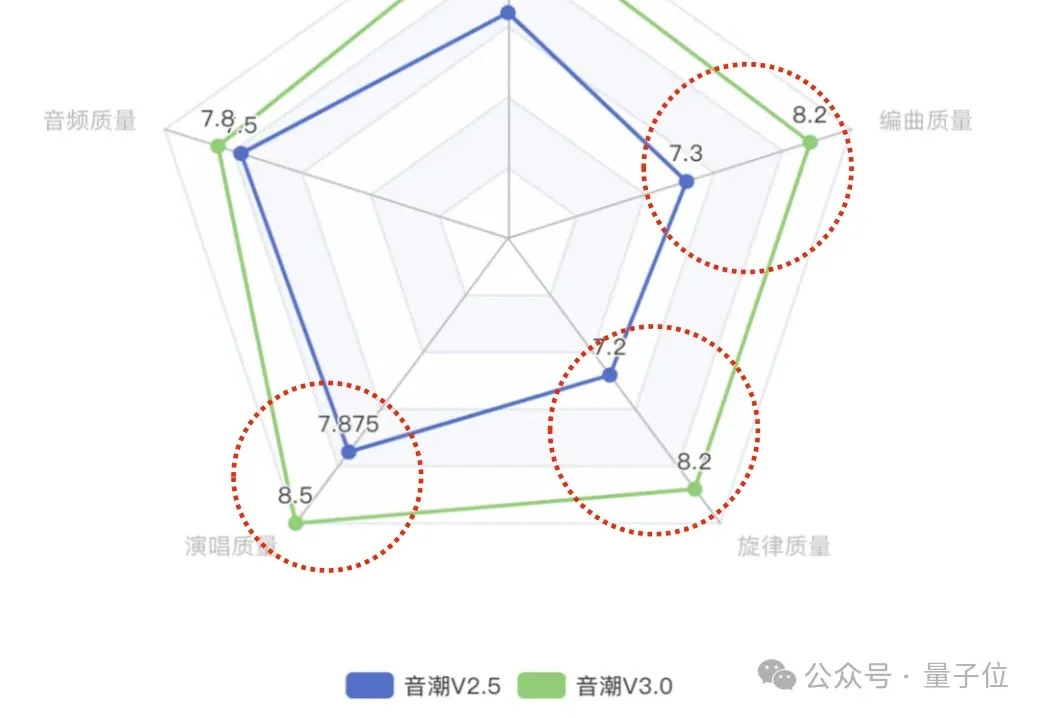

AI又在某个方面悄悄超越我了——这次是五音比我全!

今天,Gemini 3 Deep Think重磅升级,几乎刷爆全领域的SOTA,标志着AI推理能力进入了全新维度。这一次,在科学研究和硬核工程领域,Deep Think堪称一个「最强大脑」。

这两天 AI 圈真的太热闹了,就在网传 DeepSeek 要更新支持 100 万 Token 上下文的新模型时,MiniMax 率先冲锋,更新了他们的新旗舰模型:MiniMax-M2.5。更有意思的是,国外网友这段时间对国内 AI 大模型的更新节奏格外关注,他们甚至把这种争先更新的现象称为:Happy Chinese new year!

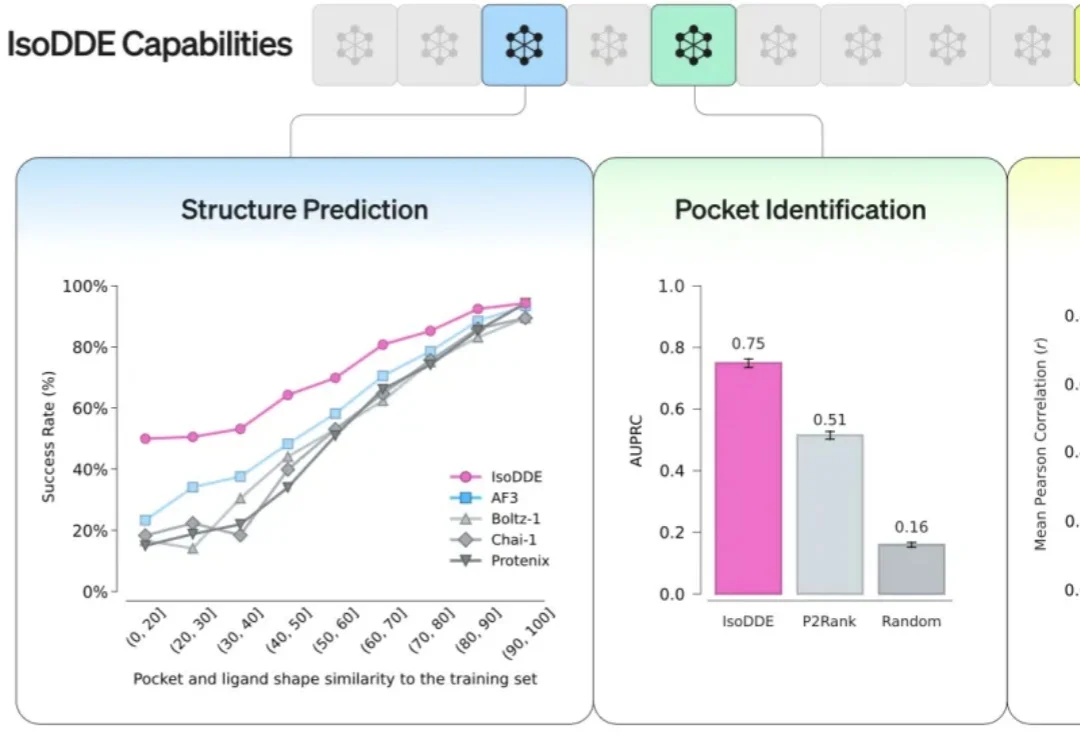

谷歌DeepMind和Isomorphic Labs合作,祭出了药物设计之王。

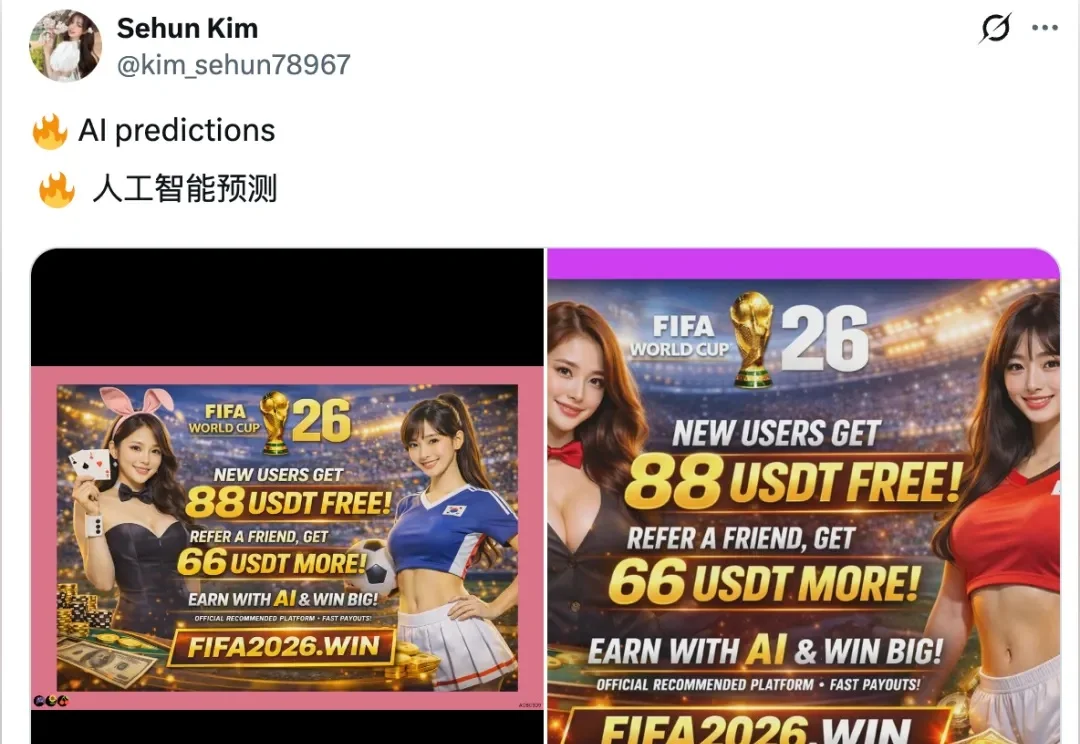

前天,我日常刷 X,当 AI 班狗 🐶 的时候,刷到一条推文,就是下面这条:

这个国产开源模型,把多模态玩出了“魔法”感。