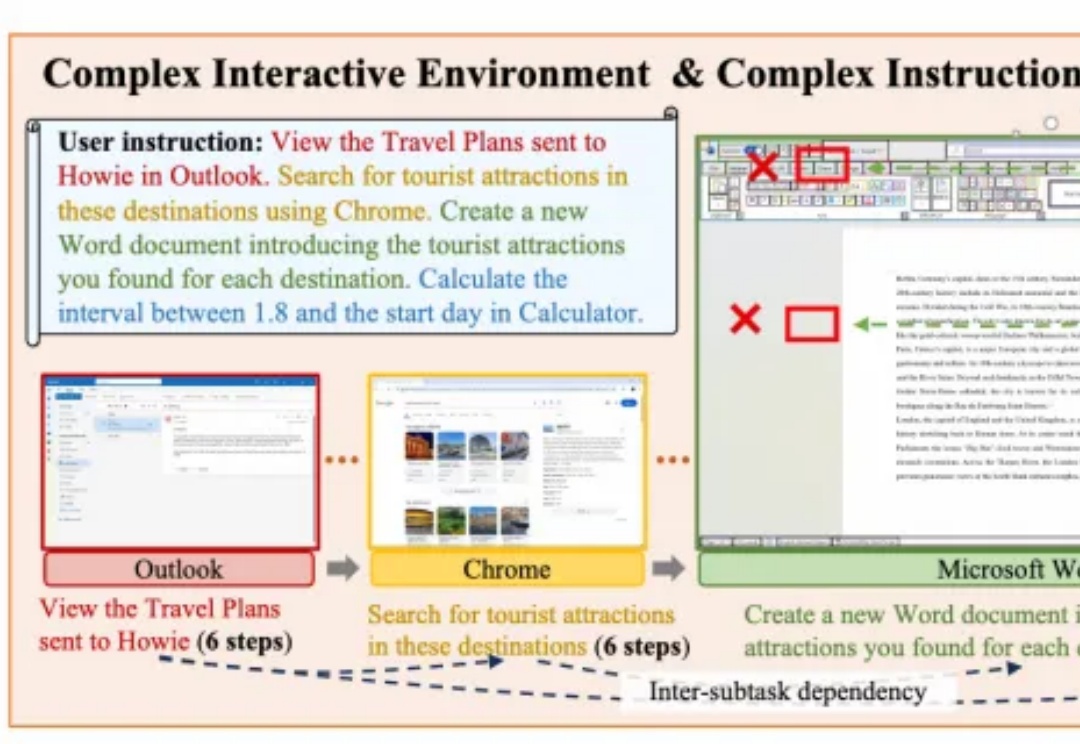

阿里PC-Agent重构人机交互,精准拆解跨应用指令,自动化办公更进一步

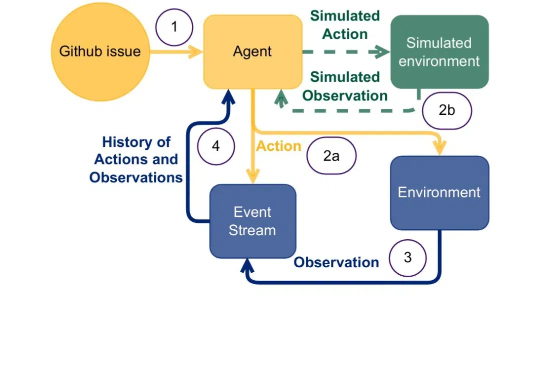

阿里PC-Agent重构人机交互,精准拆解跨应用指令,自动化办公更进一步面向复杂PC任务的多模态智能体框架PC-Agent,来自阿里通义实验室。

面向复杂PC任务的多模态智能体框架PC-Agent,来自阿里通义实验室。

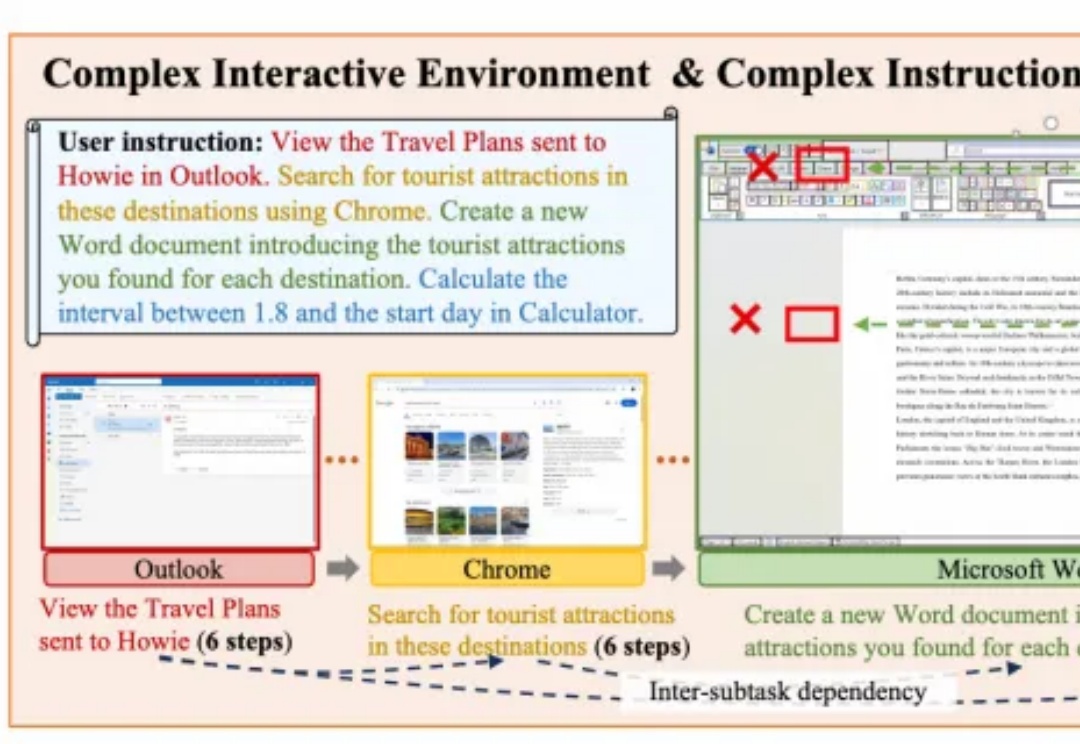

大模型的快速及持续发展,离不开对模型所有权及数据隐私的保护。

本文介绍了英特尔®至强®处理器在AI推理领域的优势,如何使用一键部署的镜像进行纯CPU环境下基于AMX加速后的DeepSeek-R1 7B蒸馏模型推理,以及纯CPU环境下部署DeepSeek-R1 671B满血版模型实践。

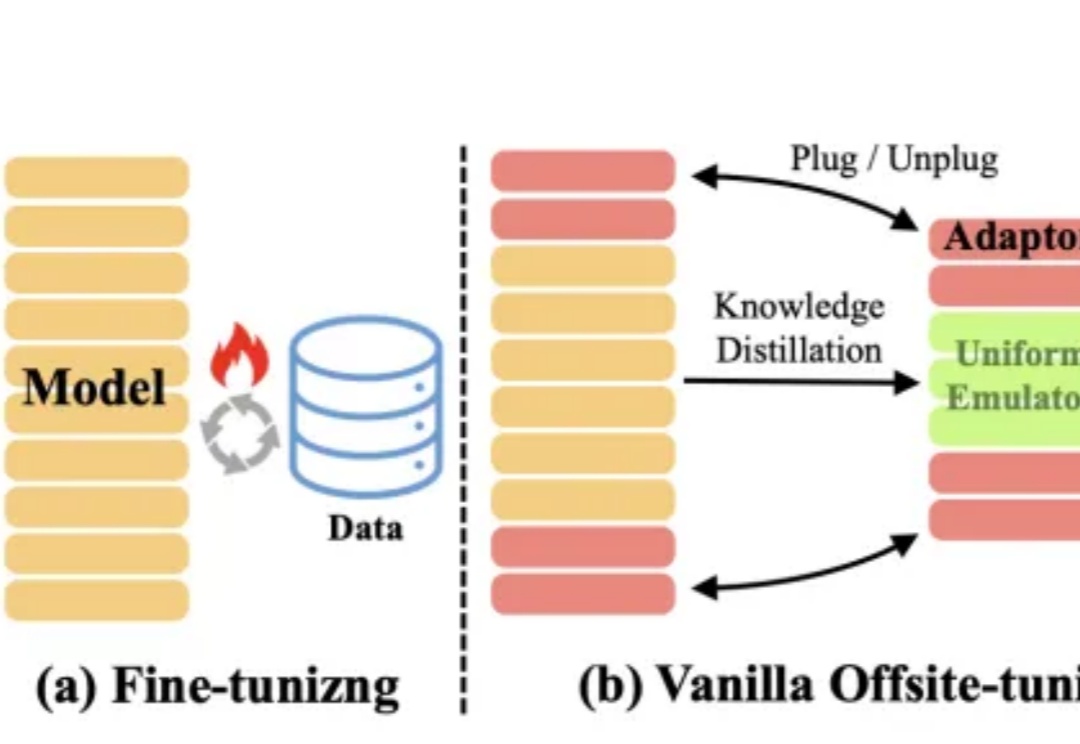

文字中貌似不起眼的标点符号,竟然可以显著加速大模型的训练和推理过程?

近年来大语言模型(LLM)的迅猛发展正推动人工智能迈向多模态融合的新纪元。然而,现有主流多模态大模型(MLLM)依赖复杂的外部视觉模块(如 CLIP 或扩散模型),导致系统臃肿、扩展受限,成为跨模态智能进化的核心瓶颈。

Hugging Face发布了「超大规模实战手册」,在512个GPU上进行超过4000个scaling实验。联创兼CEO Clement对此感到十分自豪。

农历新年刚过,DeepSeek卷王依旧,这次一下子进行了接连六天的开源Week。

什么,你在开发RAG竟然还没听说过Embedding模型还有排名?在AI应用开发热潮中,Embedding模型的选择已成为决定RAG系统成败的关键因素。然而,令人惊讶的是,许多开发者仍依靠直觉或跟风选择模型,而非基于系统化评估。

LLM在推理任务中表现惊艳,却在自我纠正上的短板却一直令人头疼。UIUC联手马里兰大学全华人团队提出一种革命性的自我奖励推理框架,将生成、评估和纠正能力集成于单一LLM,让模型像人类一样「边想边改」,无需外部帮助即可提升准确性。

听说了嘛?朋友,元宝电脑版新鲜出炉了!

现有的可控Diffusion Transformer方法,虽然在推进文本到图像和视频生成方面取得了显著进展,但也带来了大量的参数和计算开销。

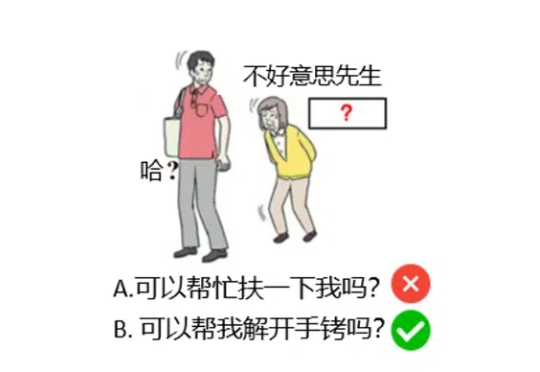

大语言模型(LLMs)在当今的自然语言处理领域扮演着越来越重要的角色,但其安全性问题也引发了广泛关注。

通过Deepseek、ChatGPT、Gemini等大模型说出来的话,不少没有辨别能力的小伙伴就会默认是公道与正确的。其实是未必。1.Deepseek、ChatGPT、Gemini等联网搜索的结果与规则还在完善;

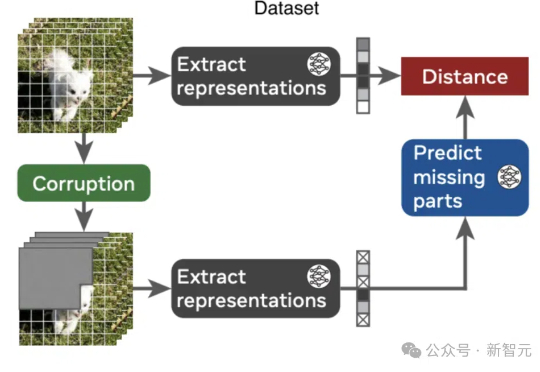

AI如何理解物理世界?视频联合嵌入预测架构V-JEPA带来新突破,无需硬编码核心知识,在自监督预训练中展现出对直观物理的理解,超越了基于像素的预测模型和多模态LLM。

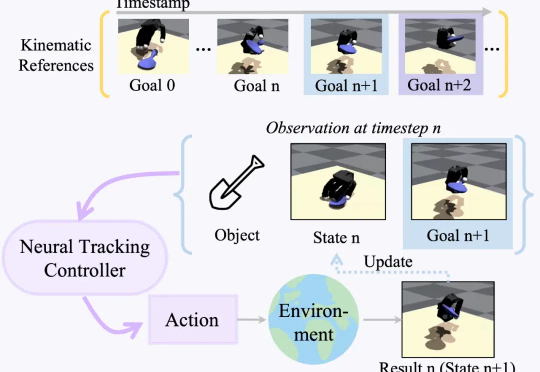

现实世界的机器人距离科幻小说里的机器人世界还有多远?通用灵巧操控何时才能实现?朝着这一伟大的目标,研究通用灵巧操控轨迹跟踪的 DexTrack 便应用而生。

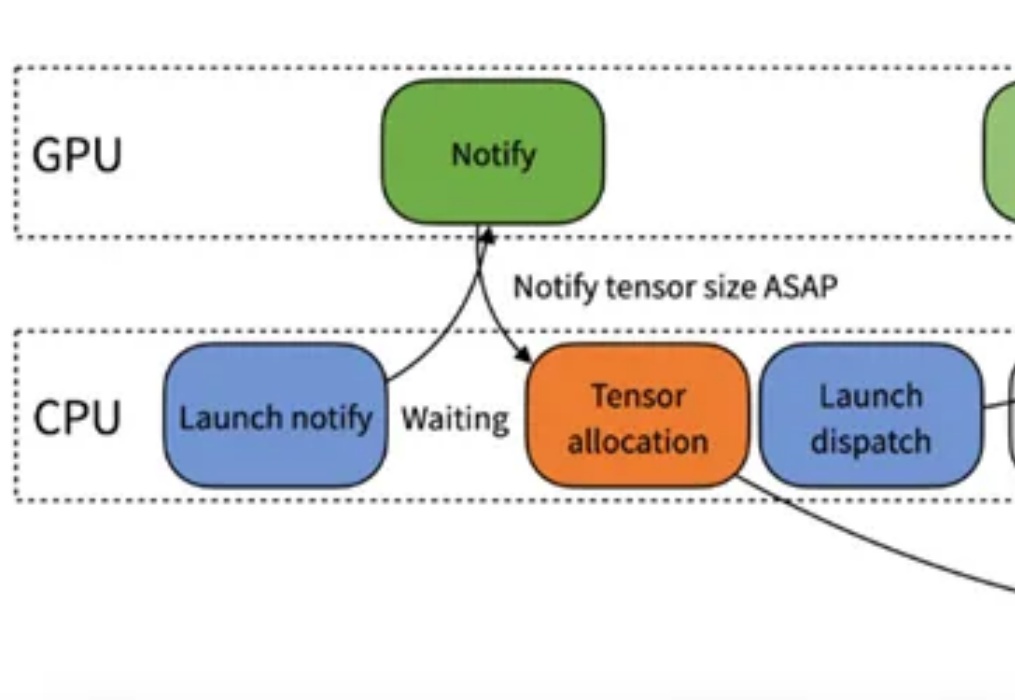

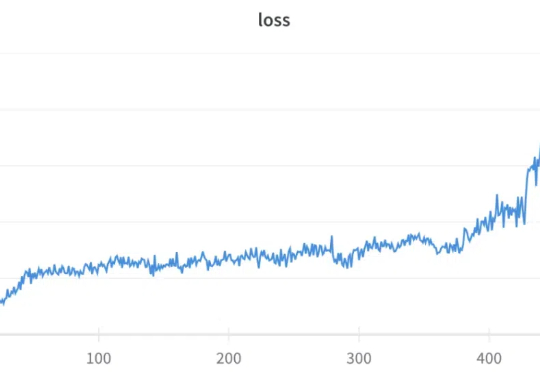

GRPO(Group Relative Policy Optimization)是 DeepSeek-R1 成功的基础技术之一,我们之前也多次报道过该技术,比如《DeepSeek 用的 GRPO 占用大量内存?有人给出了些破解方法》。

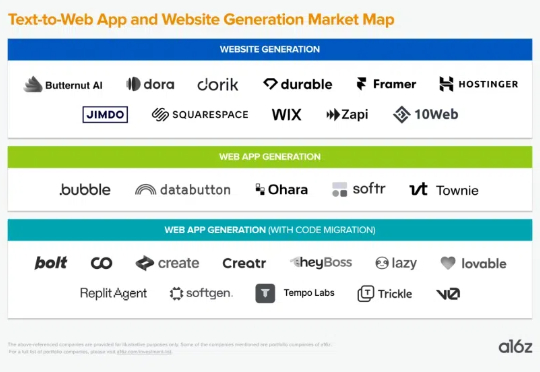

从本质上讲,LLM会根据用户从UI的输入生成代码示例。然后,生成的代码会通过中间件逻辑进行处理,根据逻辑跟踪文件、代码更改和第三方API调用。

近年来,大型语言模型(LLMs)在代码相关的任务上展现了惊人的表现,各种代码大模型层出不穷。这些成功的案例表明,在大规模代码数据上进行预训练可以显著提升模型的核心编程能力。

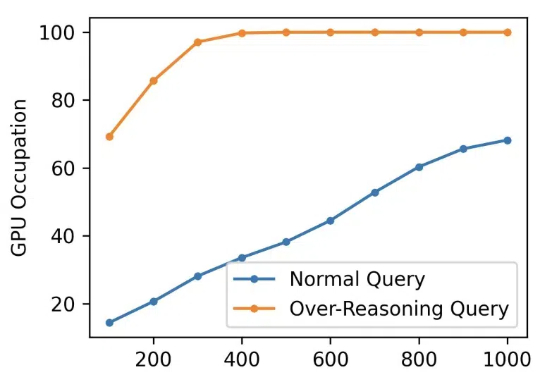

原来,大型推理模型(Large Reasoning Model,LRM)像人一样,在「用脑过度」也会崩溃,进而行动能力下降。

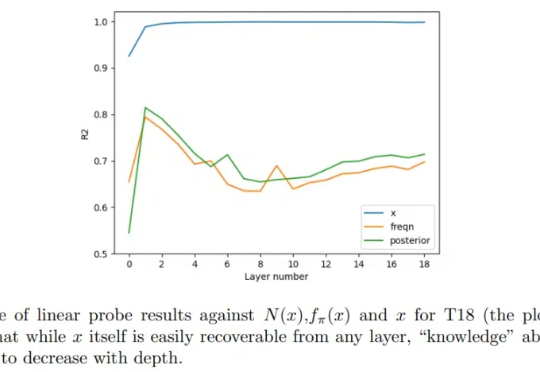

Transformer 很成功,更一般而言,我们甚至可以将(仅编码器)Transformer 视为学习可交换数据的通用引擎。由于大多数经典的统计学任务都是基于独立同分布(iid)采用假设构建的,因此很自然可以尝试将 Transformer 用于它们。

这份提示词有很多哲学性思考,很多表达让我看到背后的设计者把claude当成一个人去设计。 我猜,应该是Amanda Askell(Anthropic负责alignment和character design,是学哲学的一位女生,也是我的榜样) 主要设计的。

在大语言模型 (LLM) 的研究中,与以 Chain-of-Thought 为代表的逻辑思维能力相比,LLM 中同等重要的 Leap-of-Thought 能力,也称为创造力,目前的讨论和分析仍然较少。这可能会严重阻碍 LLM 在创造力上的发展。造成这种困局的一个主要原因是,面对「创造力」,我们很难构建一个合适且自动化的评估流程。

当百亿千亿参数的大模型霸占着科技头条,“若无必要,勿增实体”这把古老“剃刀”是否依旧闪耀?复杂性与简洁性真的是对立的吗?本文将回溯历史长河,探寻一个古老哲学原则与现代科技之间的微妙关联。在这个过程中,我们或许能够发现,复杂与简洁之间隐藏着怎样的辩证关系。

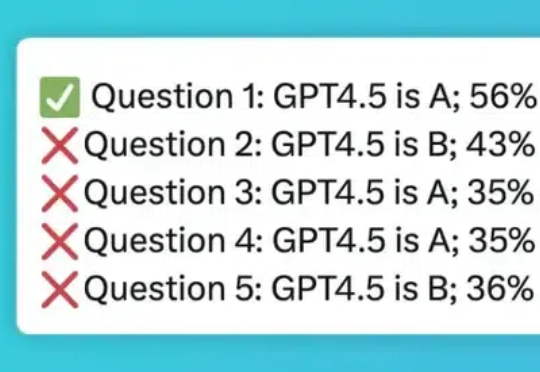

我先给大家道个歉,上一篇讲的不太对:《GPT-4.5 一手实测:垃圾》,是我喷得保守了,觉得 GPT-4.5 只是贵&慢,但模型总归是素质在线。 没想到,经过实际数万轮实测:GPT-4.5 不如 GPT-4

只要一句话,就能让DeepSeek陷入无限思考,根本停不下来?

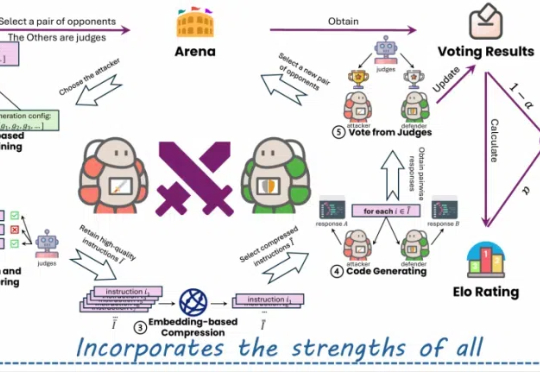

单目深度估计新成果来了!西湖大学AGI实验室等提出了一种创新性的蒸馏算法,成功整合了多个开源单目深度估计模型的优势。在仅使用2万张无标签数据的情况下,该方法显著提升了估计精度,并刷新了单目深度估计的最新SOTA性能。

近日,来自哥大的研究人员开发出了一种新AI系统,让机器人通过普通摄像头和深度神经网络实现自我建模、运动规划和自我修复,突破了传统机器人依赖工程师调整的局限,使机器人能像人类一样自主学习和适应环境变化,为具身智能发展带来新范式。

STP(自博弈定理证明器)让模型扮演「猜想者」和「证明者」,互相提供训练信号,在有限的数据下实现了无限自我改进,在Lean和Isabelle验证器上的表现显著优于现有方法,证明成功率翻倍,并在多个基准测试中达到最先进的性能。

DeepSeek最后一天,送上了3FS文件并行系统,以及数据处理框架Smallpond。五天开源连更,终于画上了完美的句号。

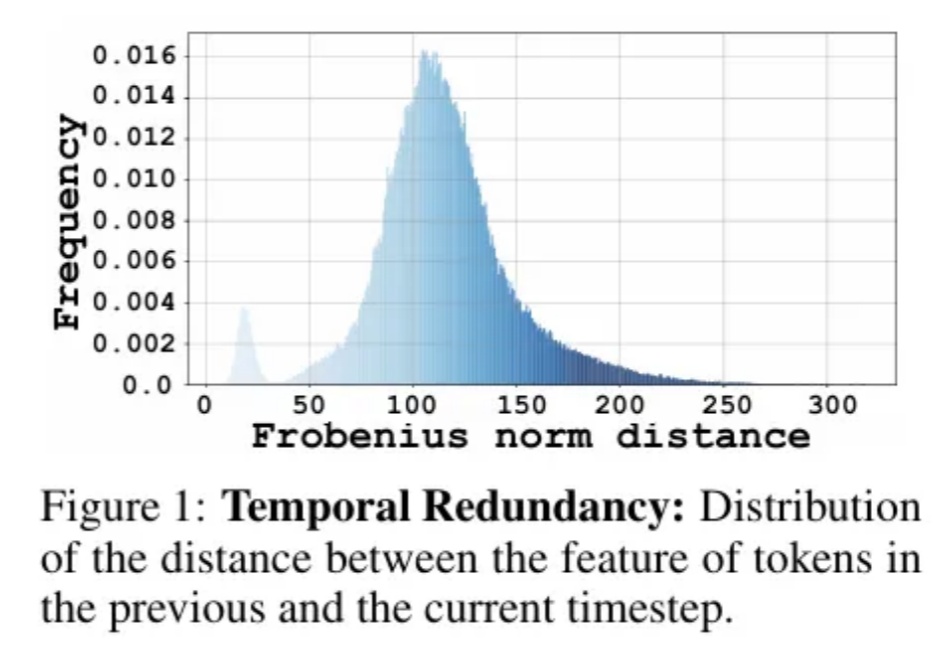

Diffusion Transformer模型模型通过token粒度的缓存方法,实现了图像和视频生成模型上无需训练的两倍以上的加速。