用Antigravity组建最强开发团队:Opus 4.5 + GPT-5.1-Codex-Max + Gemini 3 Pro

用Antigravity组建最强开发团队:Opus 4.5 + GPT-5.1-Codex-Max + Gemini 3 Pro大家好,我是鲁工。 上周发布了一篇关于如何在Antigravity中组合Claude Opus 4.5和Gemini 3 Pro进行交叉验证的文章,读者反馈不错。

大家好,我是鲁工。 上周发布了一篇关于如何在Antigravity中组合Claude Opus 4.5和Gemini 3 Pro进行交叉验证的文章,读者反馈不错。

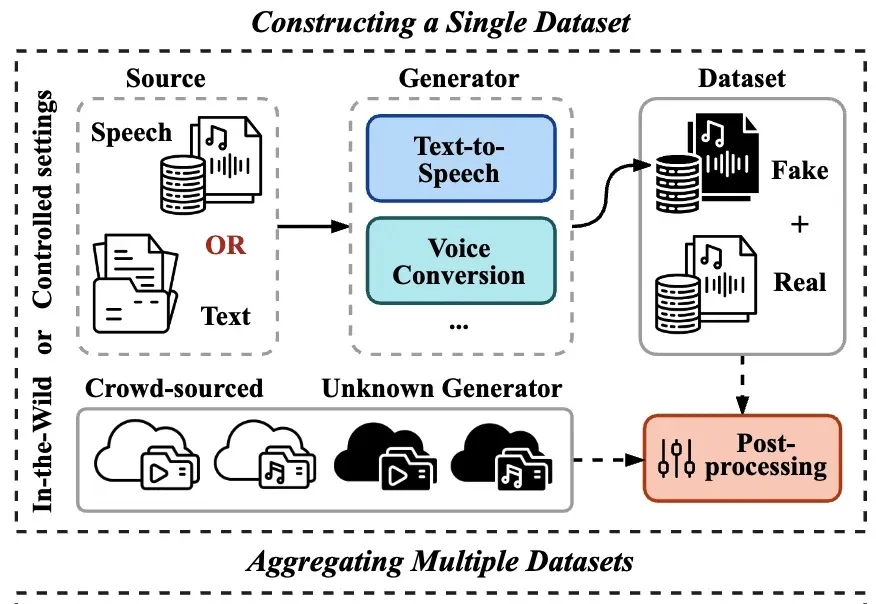

在生成式 AI 技术日新月异的背景下,合成语音的逼真度已达到真假难辨的水平,随之而来的语音欺诈与信息伪造风险也愈演愈烈。作为应对手段,语音鉴伪技术已成为信息安全领域的研究重心。

2025最后几天,是时候来看点年度宝藏论文了。

能翻译33语种+5方言,医学术语/粤语翻译实测“能打”。

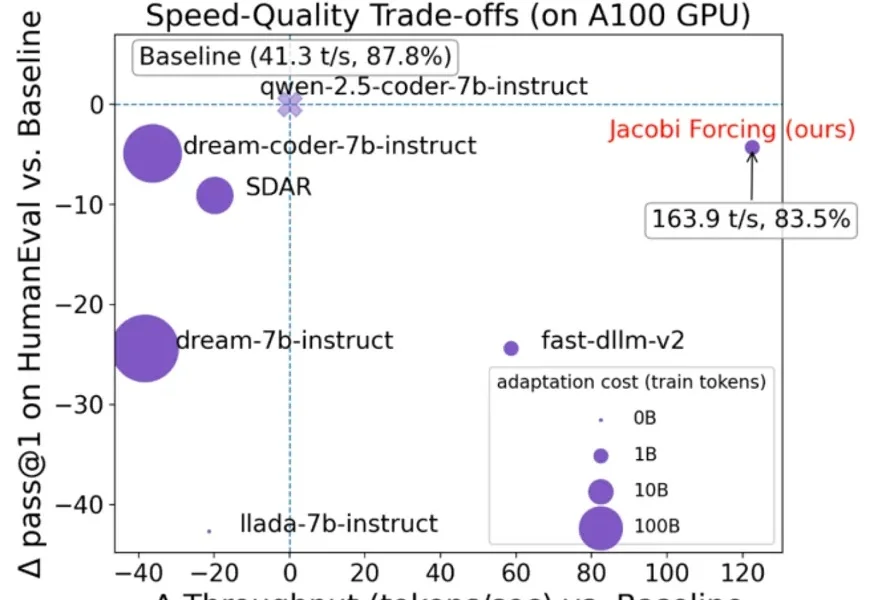

在大语言模型(LLM)落地应用中,推理速度始终是制约效率的核心瓶颈。传统自回归(AR)解码虽能保证生成质量,却需逐 token 串行计算,速度极为缓慢;扩散型 LLM(dLLMs)虽支持并行解码,却面

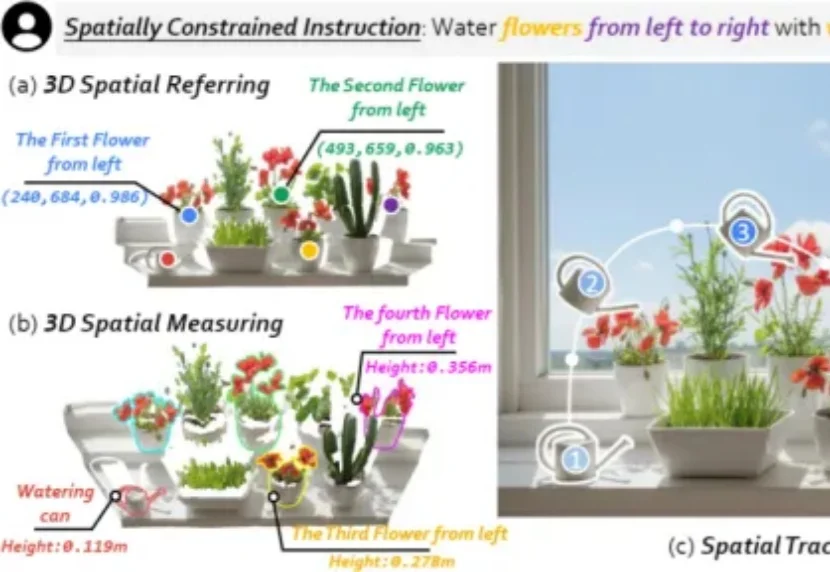

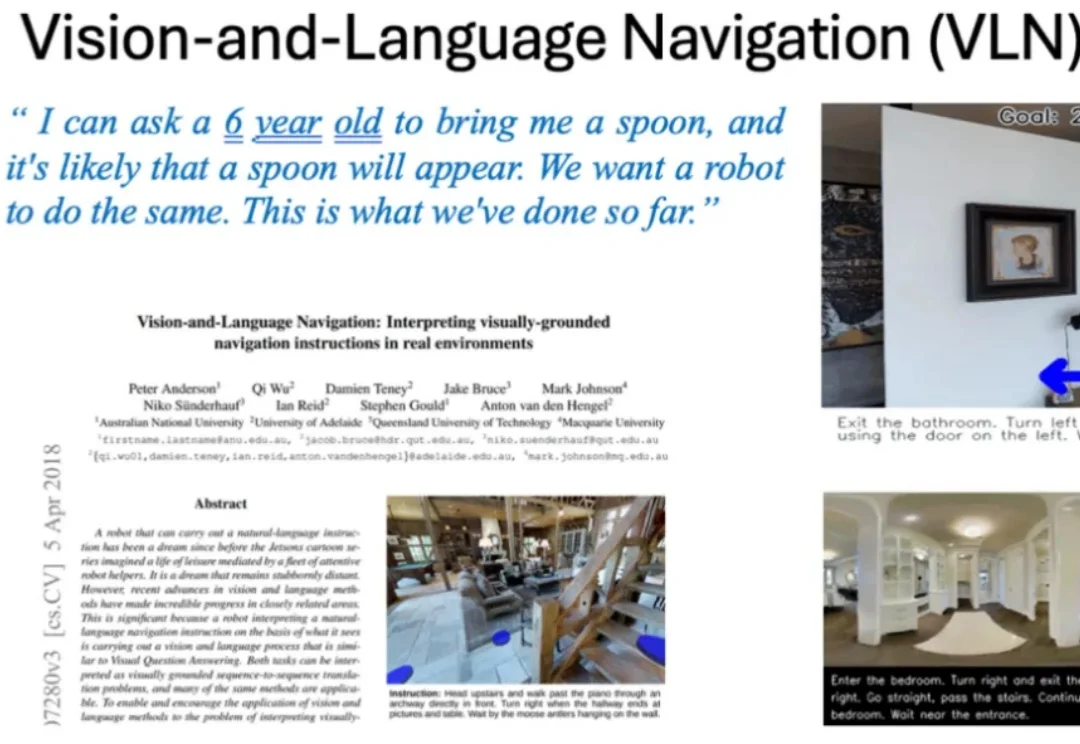

我们希望具身机器人真正走进真实世界,尤其走进每个人的家里,帮我们完成浇花、收纳、清洁等日常任务。但家庭环境不像实验室那样干净、单一、可控:物体种类多、摆放杂、随时会变化,这让机器人在三维物理世界中「看懂并做好」变得更难。

作为一名 AI 领域的博士生,徐玉庄的经历比较特殊。本科毕业于国防科技大学,随后在部队工作了 5 年,接着在清华大学获得硕士学位,目前在哈尔滨工业大学读博。

上上周跟大家盘了 Gemini 学生教育优惠。

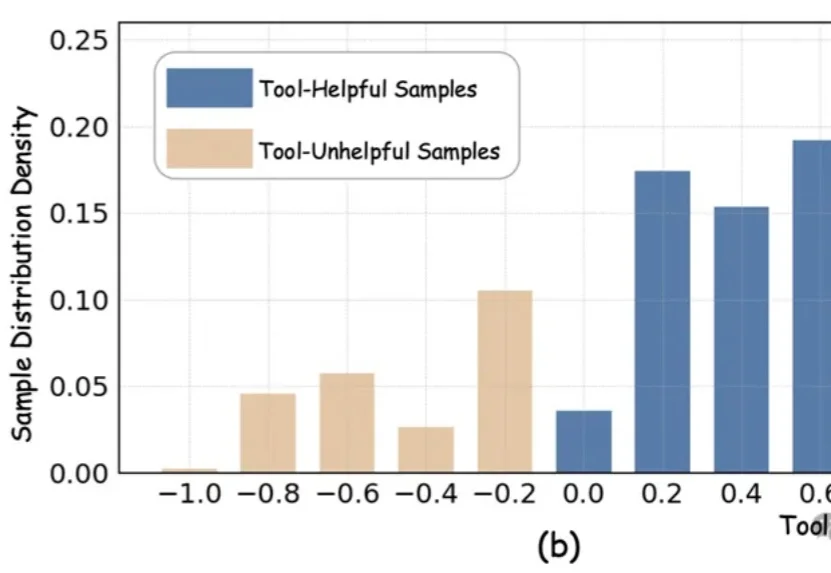

近期,以DeepEyes、Thymes为代表的类o3模型通过调用视觉工具,突破了传统纯文本CoT的限制,在视觉推理任务中取得了优异表现。

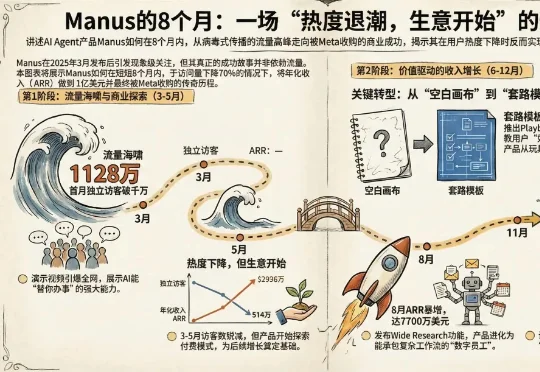

Manus被Meta收购的消息在AI圈刷屏了。 交易细节尚未完全公开,但Meta的态度很明确:它不仅要把Manus的能力整合进自家产品(包括Meta AI),还计划继续把Manus作为独立服务运营和销

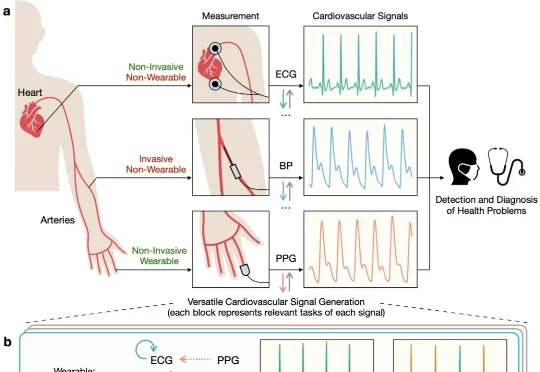

近日,清华朱军等团队提出了一种统一的多模态生成框架 UniCardio,在单扩散模型中同时实现了心血管信号的去噪、插补与跨模态生成,为真实场景下的人工智能辅助医疗提供了一种新的解决思路。

史上首次,ICLR成立后设立机制设计相关Workshop,全球顶流学者众神云集!

大家好,我是艾逗笔。 今天我花了一天时间,招聘了 6 个 AI 员工,帮助他们走完了入职流程,给他们分配了工作权限,了解了他们各自的特点和能力,然后安排了一个工作间,让他们在一起开始干活了。

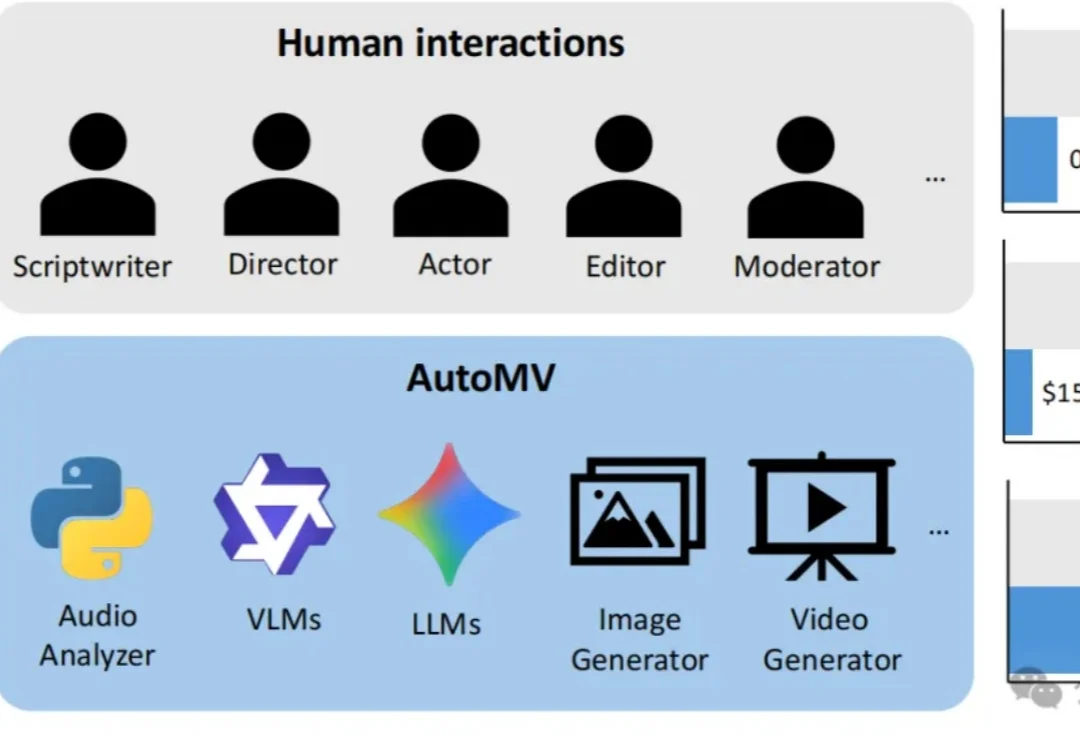

现有的AI视频生成模型虽然在短片上效果惊人,但面对一首完整的歌曲时往往束手无策——画面不连贯、人物换脸、甚至完全不理会歌词含义。

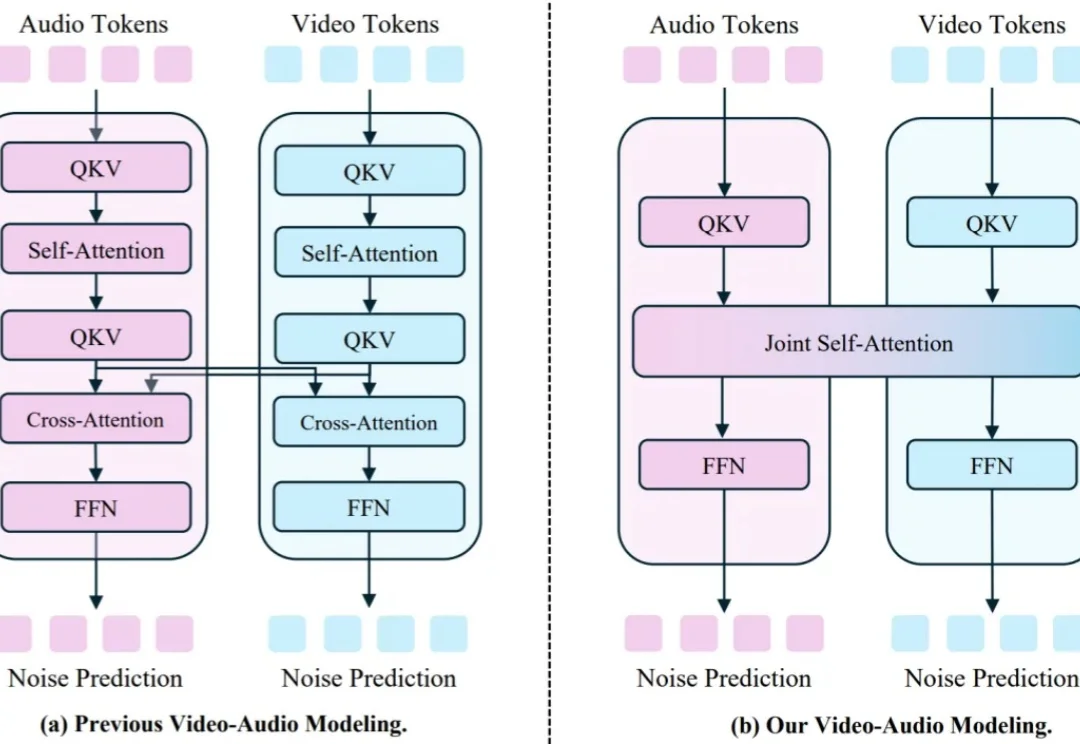

视频 - 音频联合生成的研究近期在开源与闭源社区都备受关注,其中,如何生成音视频对齐的内容是研究的重点。

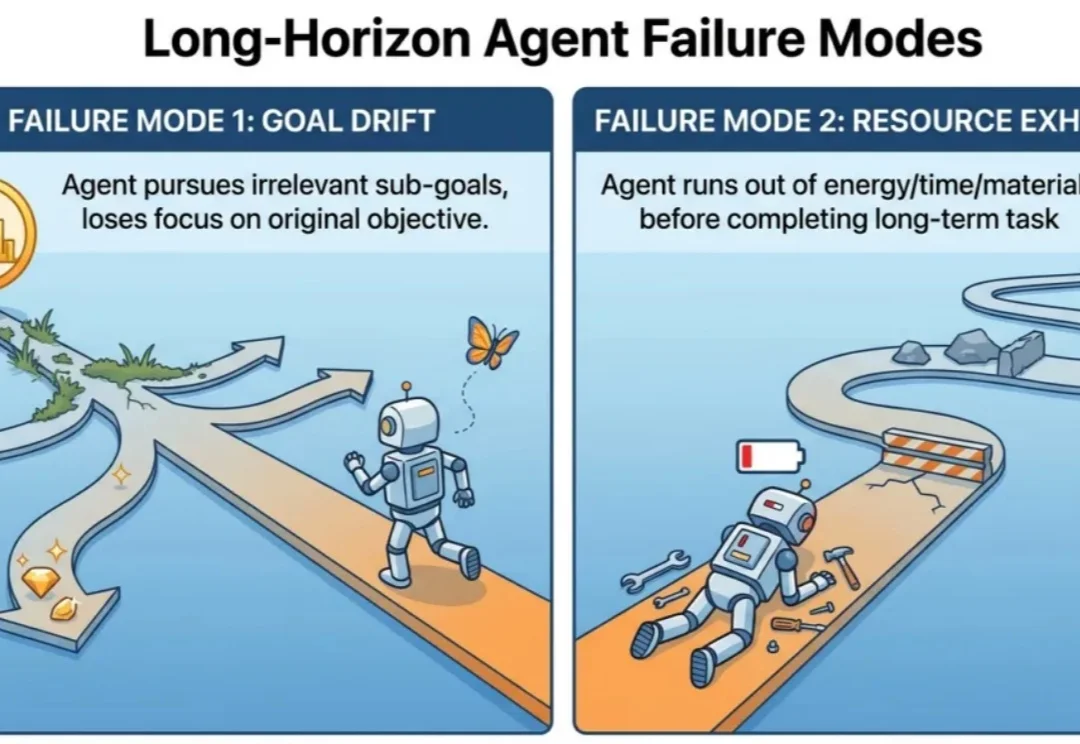

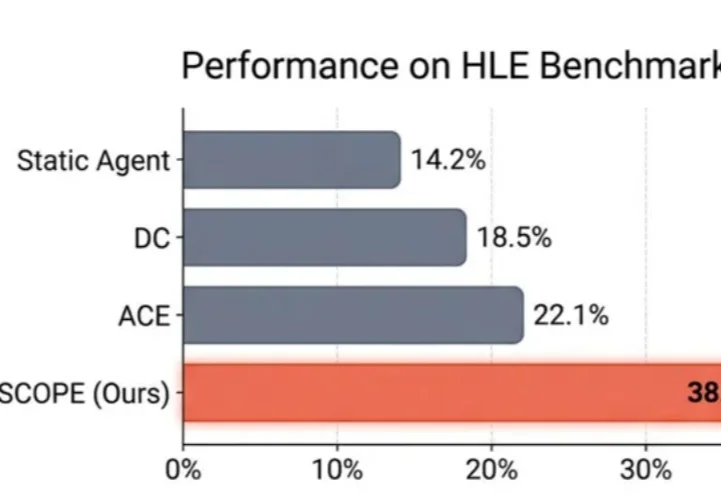

做agent简单,但是做能落地的agent难,做能落地的长周期agent更是难上加难!

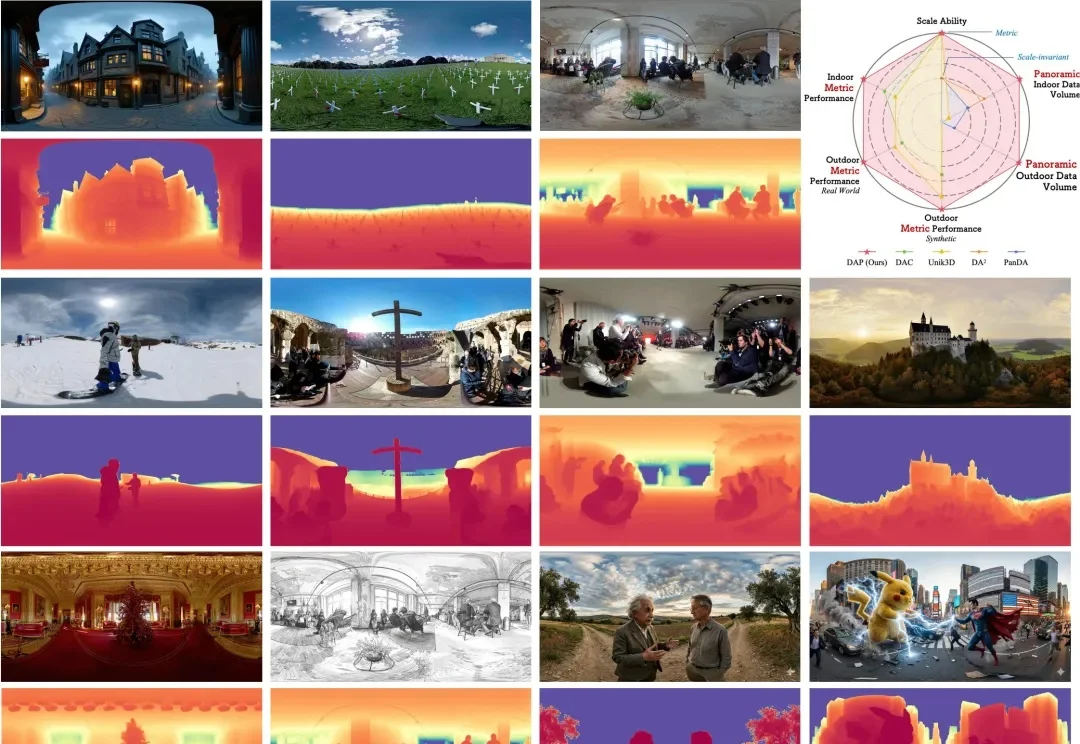

在空间智能(Spatial Intelligence)飞速发展的今天,全景视角因其 360° 的环绕覆盖能力,成为了机器人导航、自动驾驶及虚拟现实的核心基石。然而,全景深度估计长期面临 “数据荒” 与 “模型泛化差” 的瓶颈。

在 LLM Agent 领域,有一个常见的问题:Agent 明明 "看到了" 错误信息,却总是重蹈覆辙。

在电影与虚拟制作中,「看清一个人」从来不是看清某一帧。导演通过镜头运动与光线变化,让观众在不同视角、不同光照条件下逐步建立对一个角色的完整认知。然而,在当前大量 customizing video generation model 的研究中,这个最基本的事实,却往往被忽视。

近日,刚刚 IPO 的国产 GPU 公司沐曦股份,完成了自上市后的首个重大技术发布。

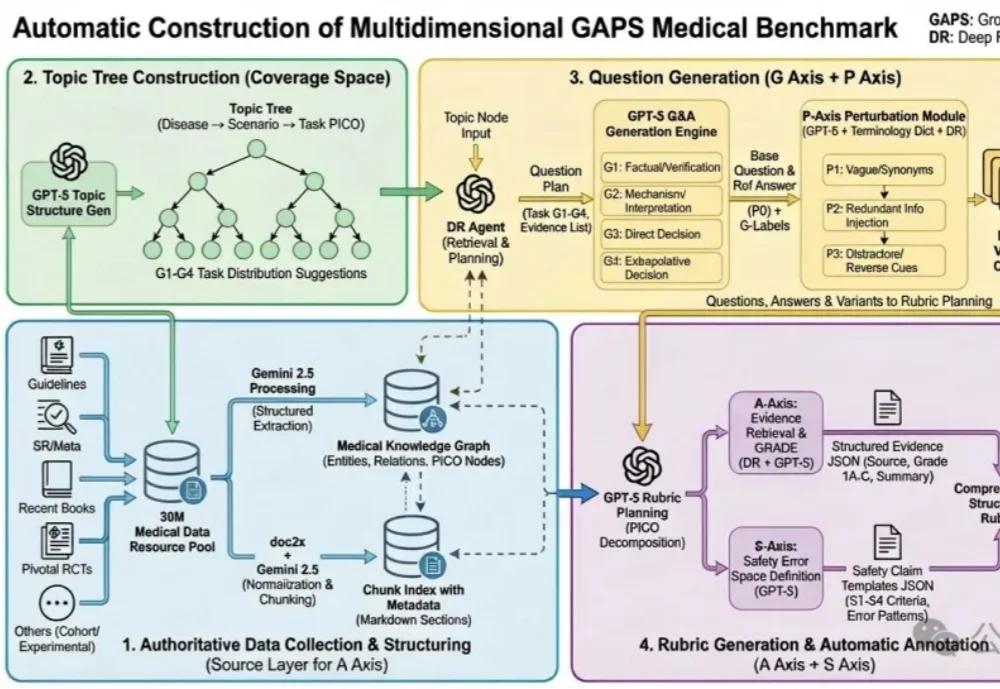

蚂蚁健康与北京大学人民医院王俊院士团队历时6个多月,联合十余位胸外科医生共同打磨,发布了全球首个大模型专病循证能力的评测框架—— GAPS(Grounding, Adequacy, Perturbation, Safety),及其配套评测集 GAPS-NSCLC-preview。

清华大学等多所高校联合发布SR-LLM,这是一种融合大语言模型与深度强化学习的符号回归框架。它通过检索增强和语义推理,从数据中生成简洁、可解释的数学模型,显著优于现有方法。在跟车行为建模等任务中,SR-LLM不仅复现经典模型,还发现更优新模型,为机器自主科学发现开辟新路径。

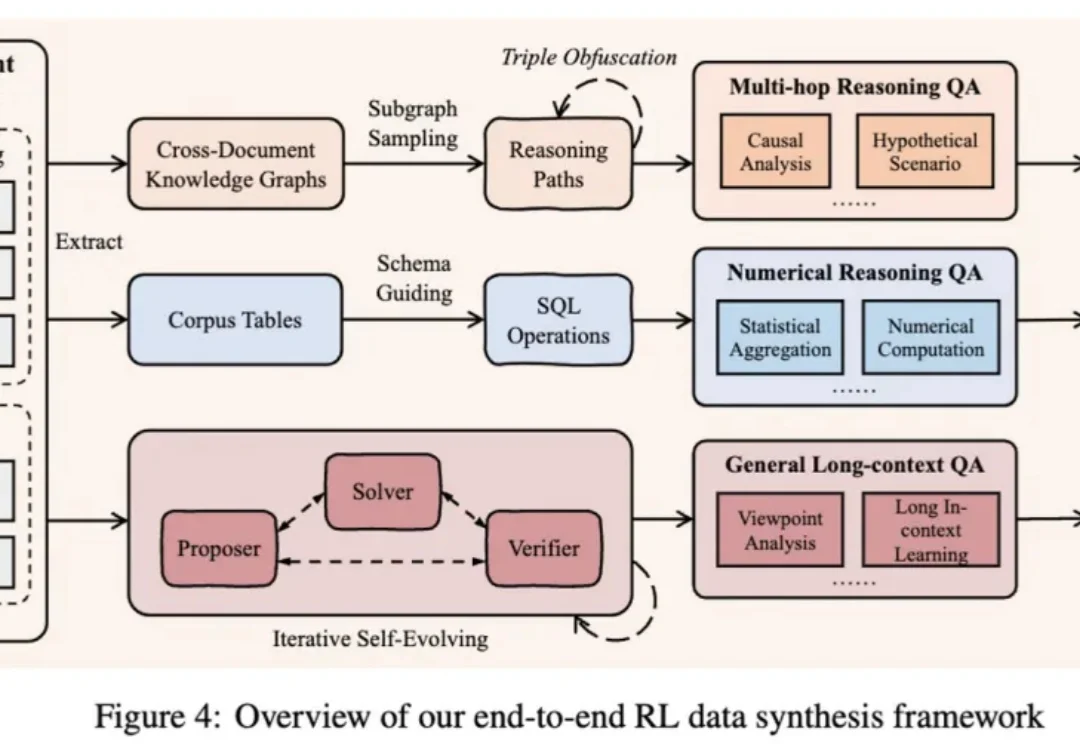

作为大模型从业者或研究员的你,是否也曾为一个模型的 “长文本能力” 而兴奋,却在实际应用中发现它并没有想象中那么智能?

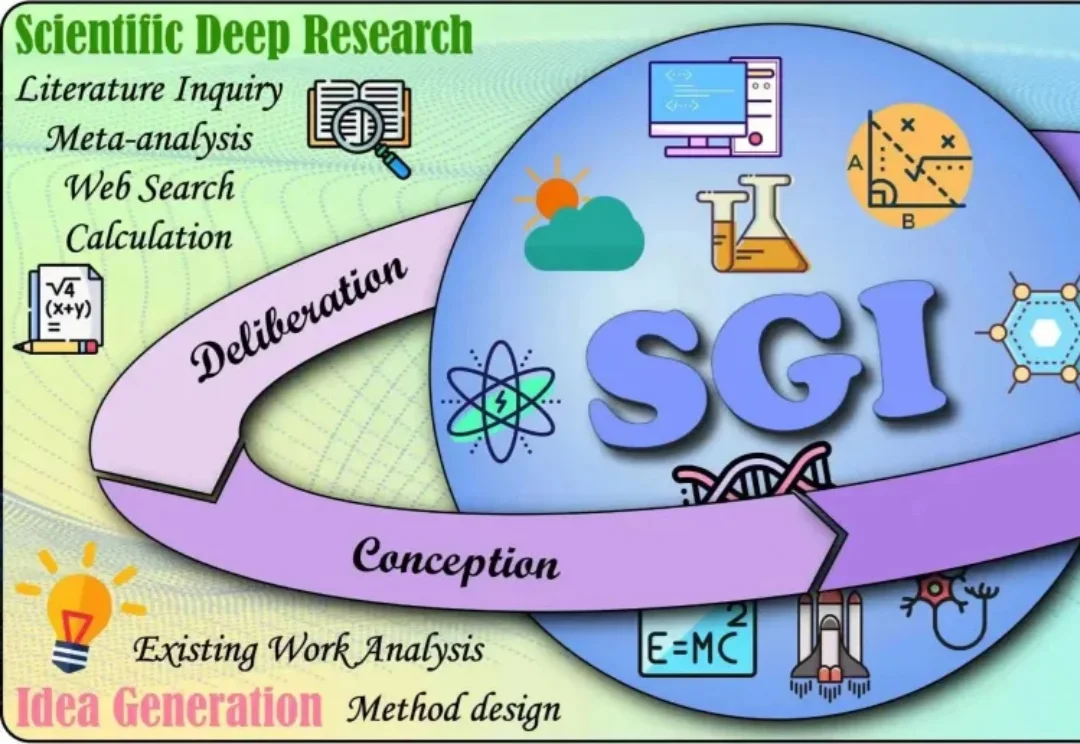

如今,大模型在理解、推理、编程等方面表现突出,但AI的“科学通用能力”(SGI)尚无统一标准。

太香了太香了,妥妥完爆ChatGPT和Nano Banana!

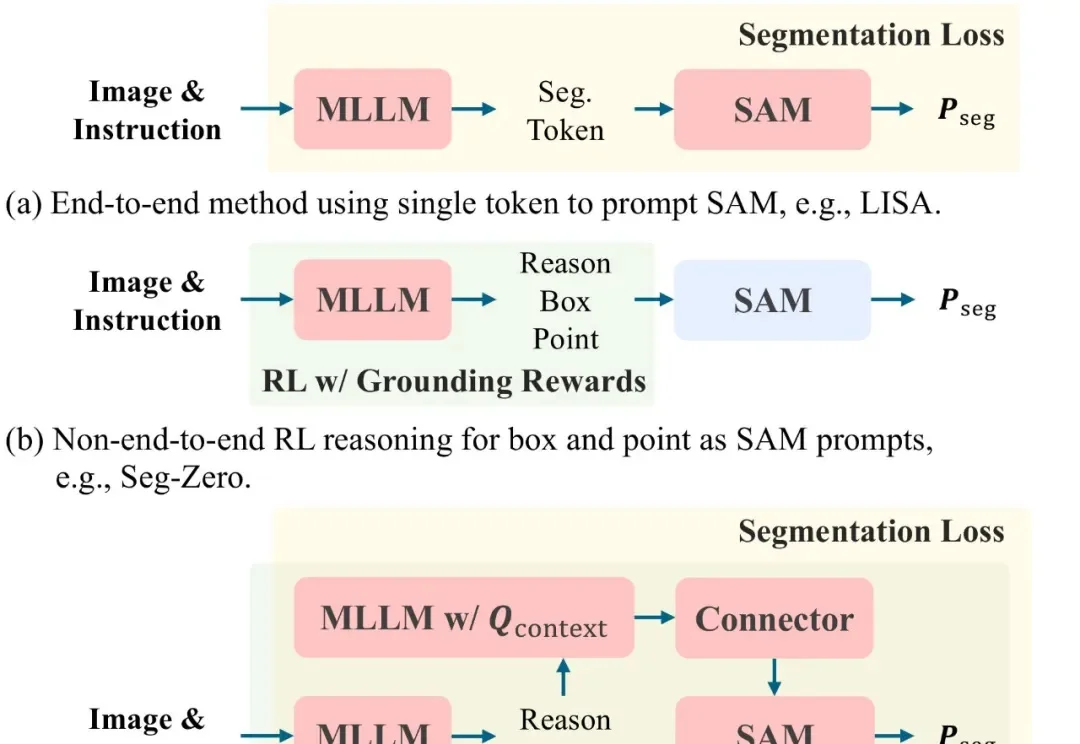

文本提示图像分割(Text-prompted image segmentation)是实现精细化视觉理解的关键技术,在人机交互、具身智能及机器人等前沿领域具有重大的战略意义。这项技术使机器能够根据自然语言指令,在复杂的视觉场景中定位并分割出任意目标。

TRAE在一年里写了1000亿行代码!如果按照一个程序员每天写100行有效代码计算,这相当于300万个程序员不吃不喝、没日没夜干了一整年。而这也仅仅是《TRAE 2025年度产品报告》中的冰山一角,更多惊人的数据还包括:

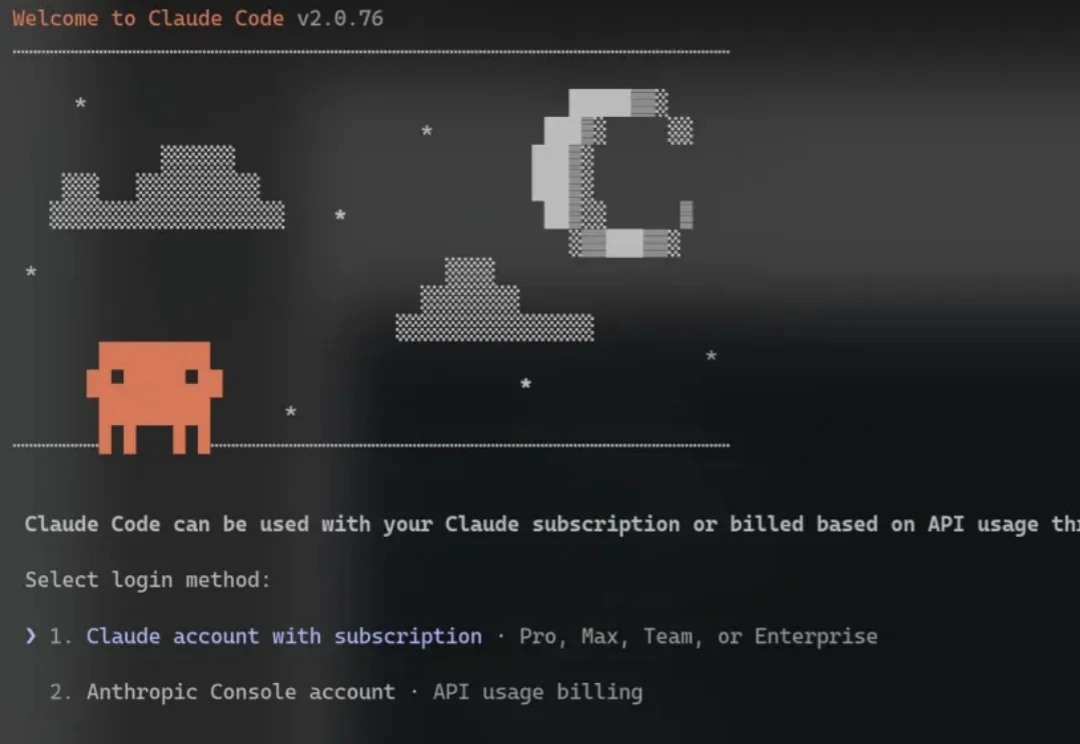

两个月以来,我一直想写一篇给小白的 CC 入门指南,今天终于可以写了。

面对苍白的CLI终端界面,有些深度依赖IDE的使用者,用Claude Code还是会不习惯的。于是我找了蛮多的资料,看看有没有适合新手的GUI工具。

告别碎片化!以全栈之姿,开启具身导航的 2026 新篇章。