SDXL Turbo、LCM相继发布,AI画图进入实时生成时代:字打多快,出图就有多快

SDXL Turbo、LCM相继发布,AI画图进入实时生成时代:字打多快,出图就有多快,Stability AI 推出了新一代图像合成模型 Stable Diffusion XL Turbo,引发了一片叫好。人们纷纷表示,图像到文本生成从来没有这么轻松。

,Stability AI 推出了新一代图像合成模型 Stable Diffusion XL Turbo,引发了一片叫好。人们纷纷表示,图像到文本生成从来没有这么轻松。

只用了 17 天,人工智能(AI)便独自创造了 41 种新材料,每天超过两种。相比之下,人类科学家可能需要几个月的尝试和实验,才能创造出一种新材料。

今天,备受广大开发者欢迎的深度学习框架Keras,正式更新了3.0版本,实现了对PyTorch和JAX的支持,同时性能提升,还能轻松实现大规模分布式训练。

研究人员利用GPT4-Vision构建了一个大规模高质量图文数据集ShareGPT4V,并在此基础上训练了一个7B模型,在多项多模态榜单上超越了其他同级模型。

浪潮信息发布源2.0基础大模型,并一口气开源了1026亿、518亿、21亿三个大模型!而在编程、推理、逻辑这些老大难问题上,源2.0都表现出了令人印象深刻的性能。

Transformer 架构可以说是近期深度学习领域许多成功案例背后的主力军。构建深度 Transformer 架构的一种简单方法是将多个相同的 Transformer 「块」(block)依次堆叠起来,但每个「块」都比较复杂,由许多不同的组件组成,需要以特定的排列组合才能实现良好的性能。

来自中国科学院深圳先进技术研究院、中国科学院大学和 VIVO AI Lab 的研究者联合提出了一个无需训练的文本生成视频新框架 ——GPT4Motion。GPT4Motion 结合了 GPT 等大型语言模型的规划能力、Blender 软件提供的物理模拟能力,以及扩散模型的文生图能力,旨在大幅提升视频合成的质量。

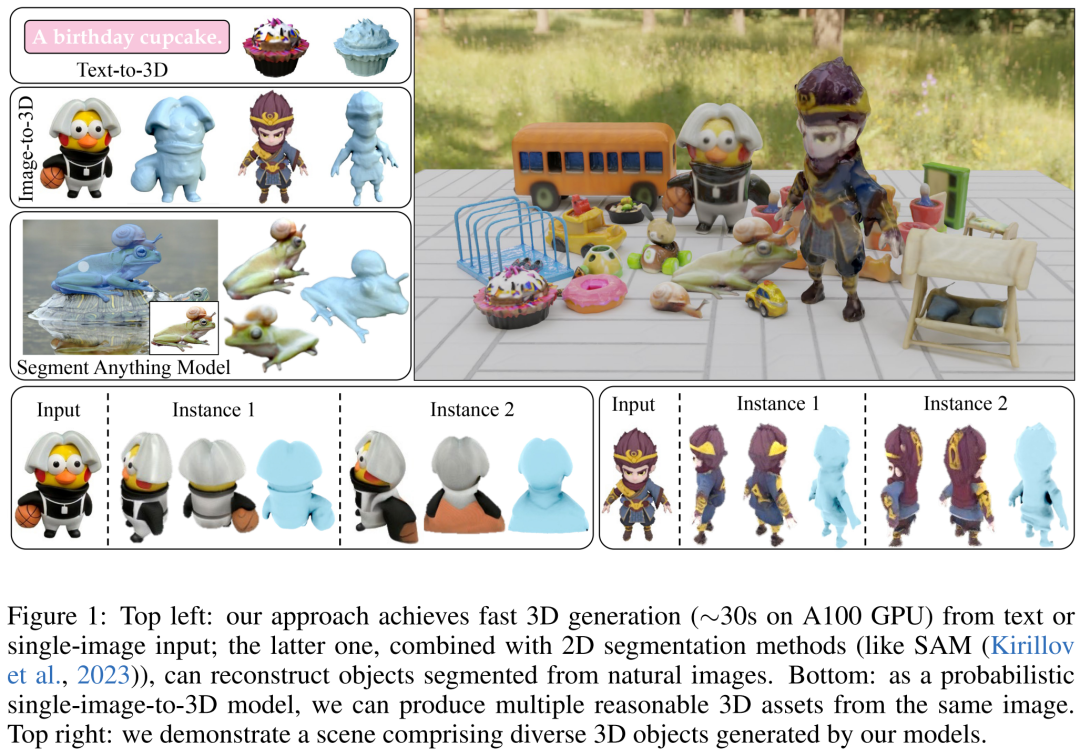

3D 生成是 AI 视觉领域的研究热点之一。本文中,来自 Adobe 研究院和斯坦福大学等机构的研究者利用基于 transformer 的 3D 大型重建模型来对多视图扩散进行去噪,并提出了一种新颖的 3D 生成方法 DMV3D,实现了新的 SOTA 结果。

我们都知道,大语言模型(LLM)能够以一种无需模型微调的方式从少量示例中学习,这种方式被称为「上下文学习」(In-context Learning)。这种上下文学习现象目前只能在大模型上观察到。比如 GPT-4、Llama 等大模型在非常多的领域中都表现出了杰出的性能,但还是有很多场景受限于资源或者实时性要求较高,无法使用大模型。

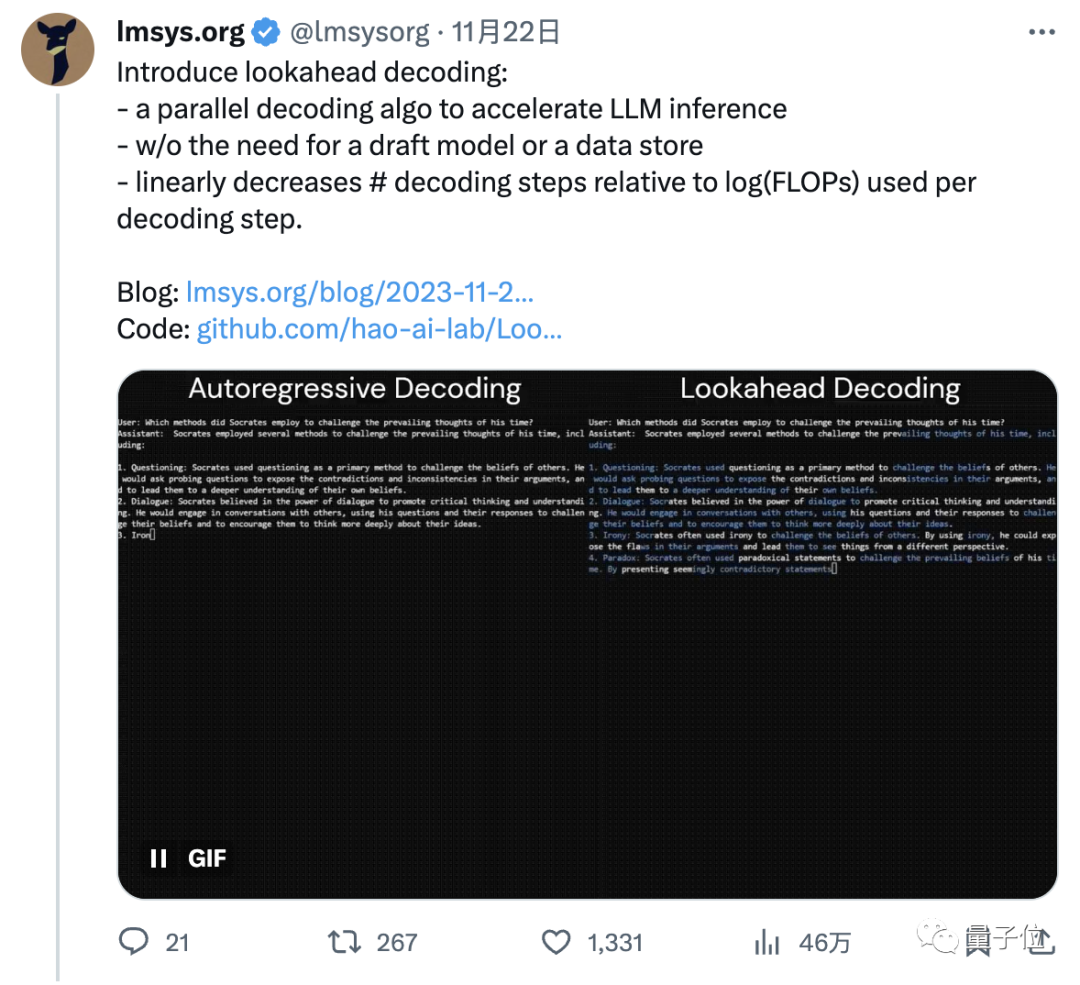

小羊驼团队的新研究火了。他们开发了一种新的解码算法,可以让模型预测100个token数的速度提高1.5-2.3倍,进而加速LLM推理。

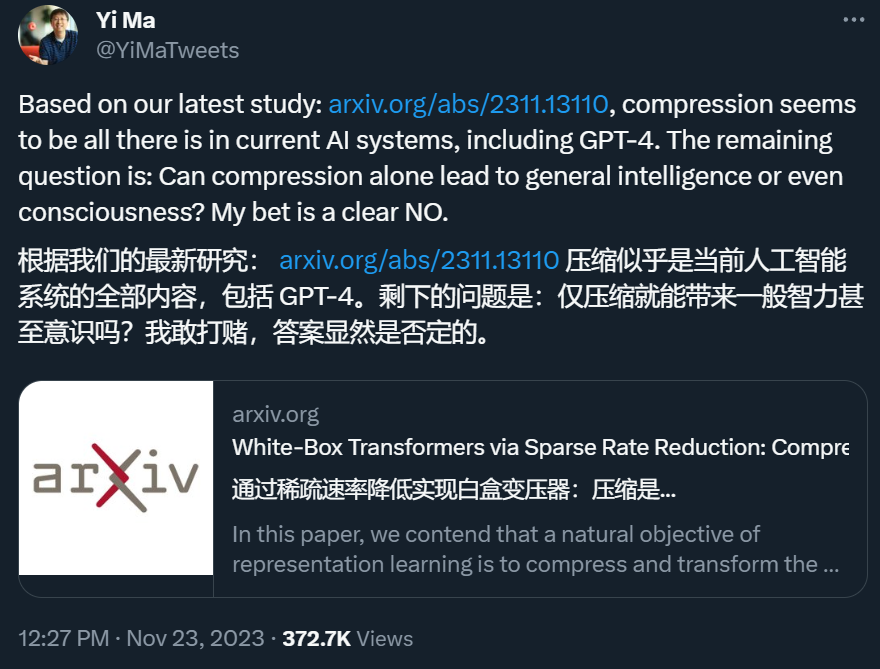

AGI 到底离我们还有多远?在 ChatGPT 引发的新一轮 AI 爆发之后,伯克利和香港大学的马毅教授领导的一个研究团队给出了自己的最新研究结果:包括 GPT-4 在内的当前 AI 系统所做的正是压缩。

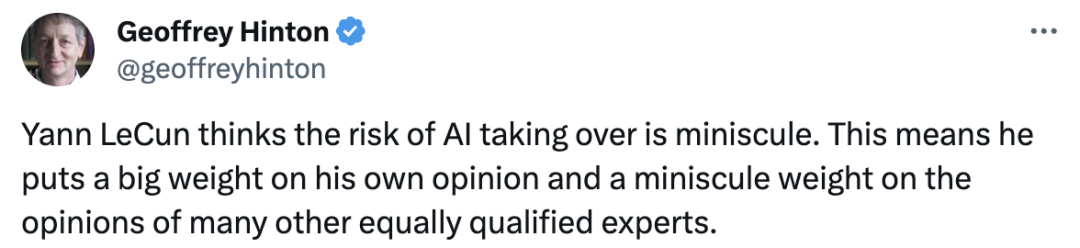

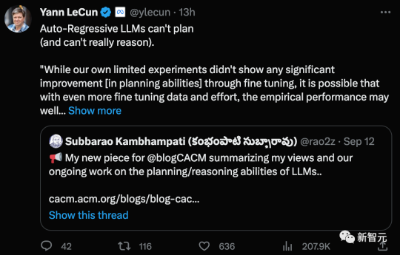

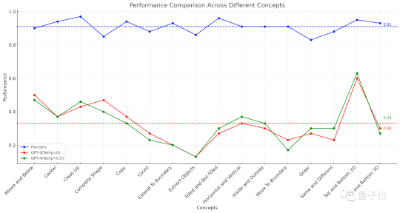

大模型能否理解自己所说,Hinton和LeCun再次吵起来了。LeCun新论文证明,GPT-4回答问题准确率仅为15%,自回归模型不及人类。AI大佬的激战再次掀起。Hinton在线直接点名LeCun,说他对AI接管风险的看法对人类的影响微乎其微。 这意味着,他把自己的意见看得很重,而把许多其他同样有资格的专家的意见看得很轻

用视觉来做Prompt!沈向洋展示IDEA研究院新模型,无需训练或微调,开箱即用

LeCun引战,LLM根本不会推理!大模型「涌现」,终究离不开上下文学习

知名投资机构coatue发布115页《2023年人工智能产业链》报告,就 AI 的现状、改善我们生活的预期、AI 对一些行业的巨大影响、开源 AI 模型现状以及以 AI 为中心的技术栈机会等做了分享,认为最好的 AI 人工智能还没有到来。

学术造假有了GPT-4,变得更容易了.这两天,一篇刊登在Nature上的新闻表示,GPT-4生成的造假数据集,第一眼还真不一定看得出来。

最近,来自北京大学等机构研究者提出了一种全新视觉语言大模型——Video-LLaVA,使得LLM能够同时接收图片和视频为输入。Video-LlaVA在下游任务中取得了卓越的性能,并在图片、视频的13个基准上达到先进的性能。这个结果表明,统一LLM的输入能让LLM的视觉理解能力提升。

全面兼容Stable Diffusion生态,LCM模型成功实现5-10倍生成速度的提升,实时AI艺术时代即将到来,所想即所得!

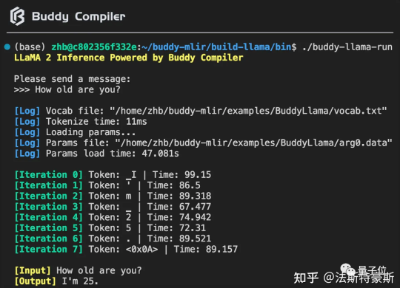

Buddy Compiler 端到端 LLaMA2-7B 推理示例已经合并到 buddy-mlir仓库[1]主线。我们在 Buddy Compiler 的前端部分实现了面向 TorchDynamo 的第三方编译器,从而结合了 MLIR 和 PyTorch 的编译生态。

OpenAI开发者大会后不久,它的最强竞对Claude也宣布推出了重磅更新。更新后的Claude 2.1,上下文长度直接翻番到20万,重新超过了GPT-4。

GPT-4的图形推理能力,竟然连人类的一半都不到? 美国圣塔菲研究所的一项研究显示,GPT-4做图形推理题的准确率仅有33%。而具有多模态能力的GPT-4v表现更糟糕,只能做对25%的题目。

AI能理解搞笑视频笑点在哪里了。北大等团队开源视觉语言大模型Video-LLaVA,将图像和视频表示对齐到统一的视觉特征空间,在13个图片和视频基准上达到先进的性能。

微软AI4Science部门发布230页报告,详细描述了GPT-4为代表的大语言模型在生物,药物发现,计算化学,偏微分方程,材料设计等5个科研领域的应用潜力。而且,作者还把目前GPT-4表现不好的地方也贴心地标记出来,防止科研人员踩雷。

良好的人设还原度是AI角色扮演的关键,研究人员对大五人格的NEO-FFI问卷和MBTI的16Personalities进行了改写,利用LLM将其中的问题从陈述句改写为了引导开放式问答的提问句,对AI角色进行测试。

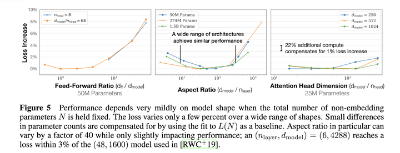

计划训练一个10B的模型,想知道至少需要多大的数据?收集到了1T的数据,想知道能训练一个多大的模型?老板准备1个月后开发布会,给的资源是100张A100,那应该用多少数据训一个多大模型最终效果最好?

人工智能(AI)和加密货币是融合的技术,有潜力改变数字世界。AI可以解决加密货币的挑战,如波动性、安全性、可扩展性和能源消耗。

现代认知科学认为,人类会在头脑中构建关于周围真实世界的抽象模型——世界模型(world model)。获取“世界模型”的问题一直是人工智能研究的焦点。OpenAI 联合创始人兼首席科学家 Ilya Sutskever 认为, ChatGPT 已经学到了关于真实世界的复杂抽象模型。

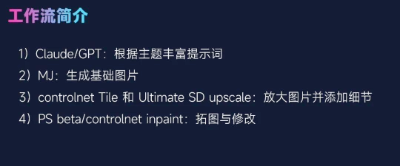

有一部分业内人士开始专门钻研 AI 技术,并且尝试作为一个独立的团队与游戏厂商展开合作,为他们提供包括建立合理工作流、自主训练模型、AI 辅助概念设计等方面的解决方案。和 AI 技术一样,这种团队非常新兴,人们尚且不够全面了解他们所能做到的事情。

C-MCR利用现有多模态对比表征间可能存在的重叠模态,来连接不同的对比表征,从而学到更多模态间的对齐关系,实现了在缺乏配对数据的多模态间进行训练。

大模型正变得越来越“像人”,但事实真是如此吗?现在,一篇发表Nature上的文章,直接否决了这个观点——所有大模型,都不过是在玩角色扮演而已!