只要会说话,不写代码也能开发!百度又搞了一个大动作

只要会说话,不写代码也能开发!百度又搞了一个大动作文心大模型,又有新进展了!

文心大模型,又有新进展了!

继Mamba之后,又一敢于挑战Transformer的架构诞生了!

近日,由DeepMind、谷歌和Meta的研究人员创立的AI初创公司Reka,推出了他们最新的多模态语言模型——Reka Core

多任务机器人学习在应对多样化和复杂情景方面具有重要意义。然而,当前的方法受到性能问题和收集训练数据集的困难的限制

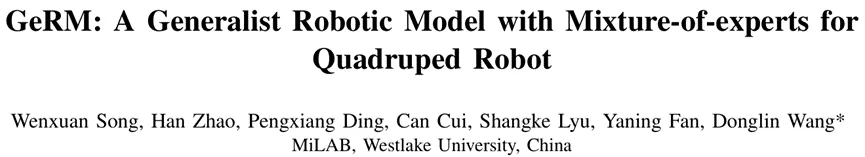

继之前公开课之后(周鸿祎:2024 年 AI 产业发展的 16 个趋势。)红衣大叔兑现诺言,开源了 7B 系列大模型

脑机接口最新进展登上Nature子刊,深度学习三巨头之一的LeCun都来转发。

纵观生成式AI领域中的两个主导者:自回归和扩散模型。 一个专攻文本等离散数据,一个长于图像等连续数据。 如果,我们让后者来挑战前者的主场,它能行吗?

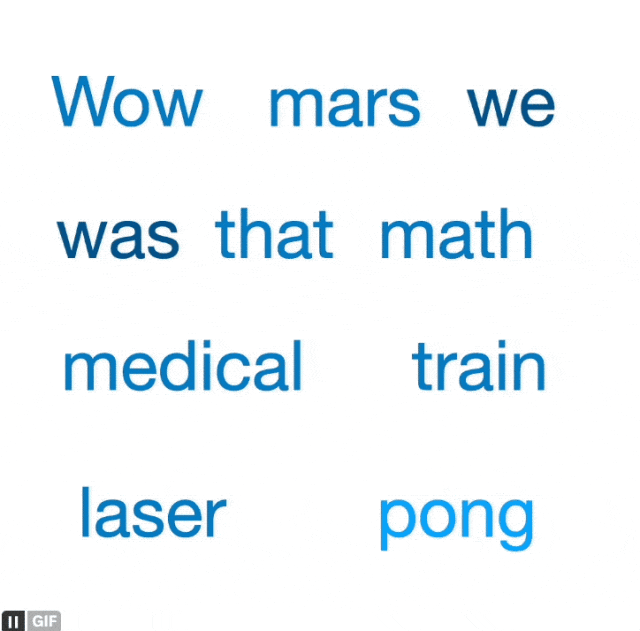

MiniCPM 系列的最新多模态版本 MiniCPM-V 2.0。该模型基于 MiniCPM 2.4B 和 SigLip-400M 构建,共拥有 2.8B 参数。MiniCPM-V 2.0 具有领先的光学字符识别(OCR)和多模态理解能力

如何复盘大模型技术爆发的这一年?除了直观的感受,你还需要一份系统的总结

现今,机器学习(ML),更具体地说,深度学习已经改变了从金融到医疗等广泛的行业。在当前的 ML 范式中,训练数据首先被收集和策划,然后通过最小化训练数据上的某些损失标准来优化 ML 模型

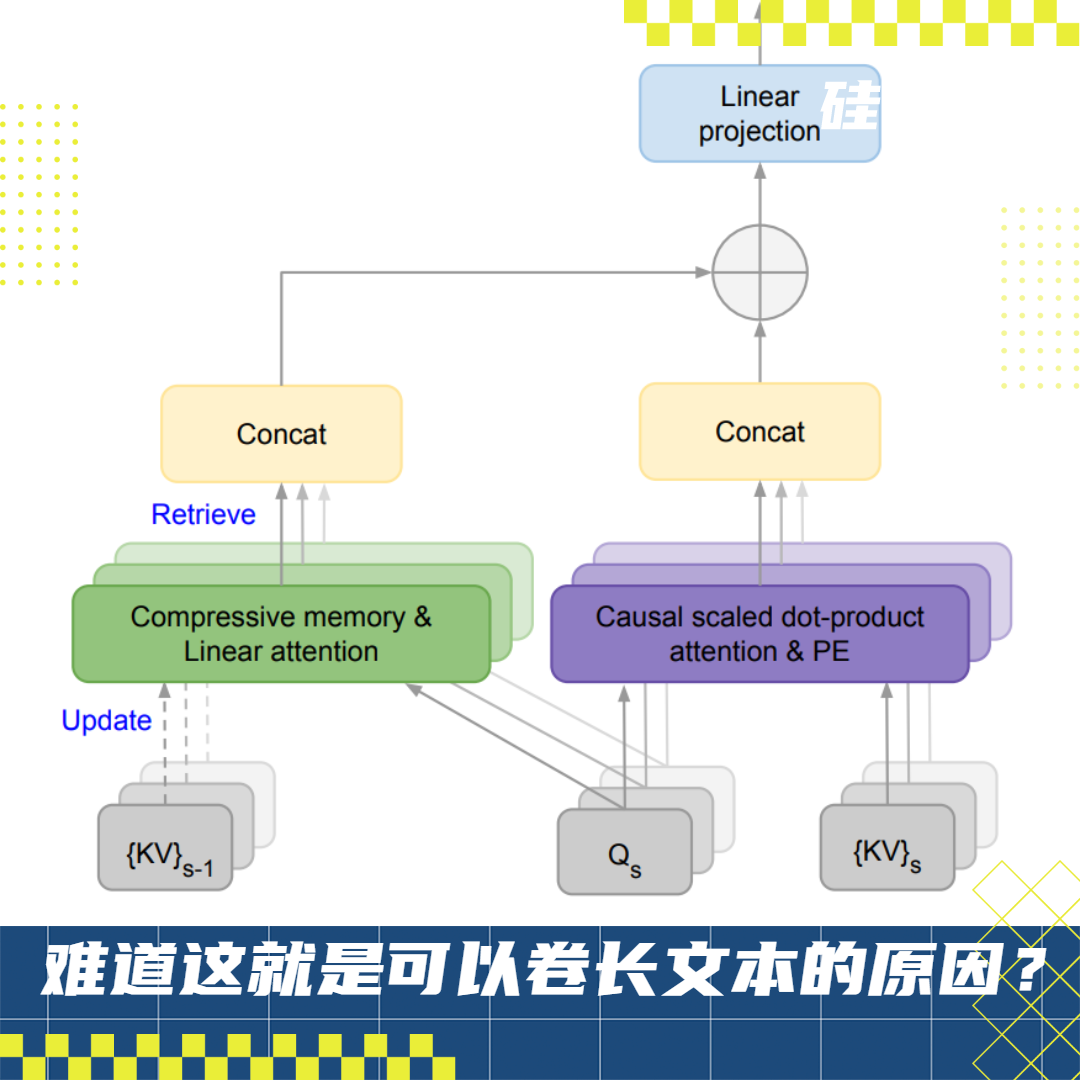

从国际顶流 GPT-4 128K、Claude 200K 到国内「当红炸子鸡」支持 200 万字上下文的 Kimi Chat,大语言模型(LLM)在长上下文技术上不约而同地卷起来了

CUDA 是英伟达的壁垒, 推理场景是算力未来的重点

提出图像生成新范式,从预测下一个token变成预测下一级分辨率,效果超越Sora核心组件Diffusion Transformer(DiT

在开源社区中把GPT-4+Dall·E 3能⼒整合起来的模型该有多强?

史上最全的「数学人工智能资源」清单出炉了。 陶哲轩,信奉AI将在2026年成为人类数学家的重要合著者,一早便转发了这份清单。

以神经网络为基础的深度学习技术已经在诸多应用领域取得了有效成果

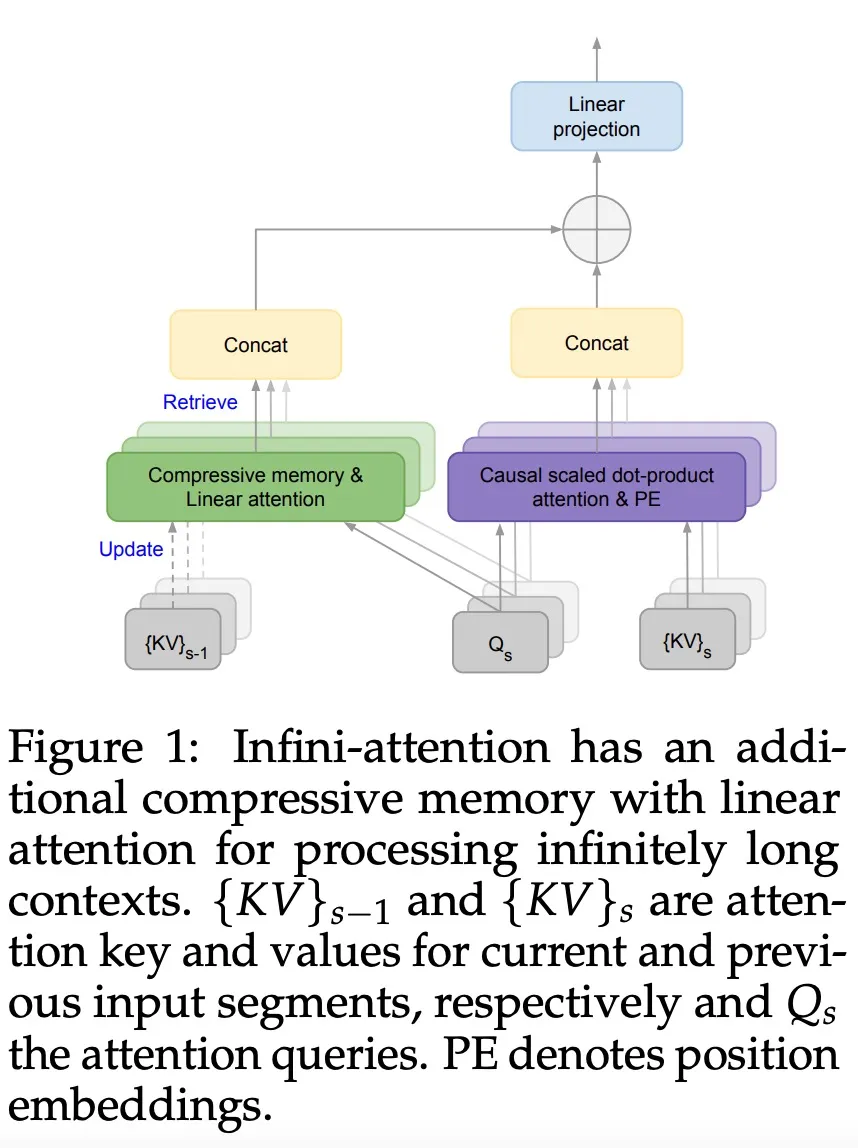

通过这项技术,能使transformer大模型在有限的计算资源 条件下,处理无限长度的输入。

风格化图像生成,也常称为风格迁移,其目标是生成与参考图像风格一致的图像。

自从 2023 年 11 月 Grok 首次亮相以来,马斯克的 xAI 正在大模型领域不断取得进步,向 OpenAI 等先行者发起进攻。在 Grok-1 开源后不到一个月,xAI 的首个多模态模型就问世了。

人工智能模型在对话说服力方面表现如何?

液体都有“智能”、可编程了? 最近,一种被称为“智能"液体的多功能可编程的新型超材料——Metafluid,登上了Nature。

120秒超长AI视频模型来了!不但比Sora长,而且免费开源

新一代视觉生成范式「VAR: Visual Auto Regressive」视觉自回归来了

自 2020 年神经辐射场 (Neural Radiance Field, NeRF) 提出以来,将隐式表达推上了一个新的高度。作为当前最前沿的技术之一

近,来自澳大利亚蒙纳士大学、蚂蚁集团、IBM 研究院等机构的研究人员探索了模型重编程 (model reprogramming) 在大语言模型 (LLMs) 上应用,并提出了一个全新的视角

随着大模型的参数量日益增长,微调整个模型的开销逐渐变得难以接受。 为此,北京大学的研究团队提出了一种名为 PiSSA 的参数高效微调方法,在主流数据集上都超过了目前广泛使用的 LoRA 的微调效果。

谷歌又放大招了,发布下一代 Transformer 模型 Infini-Transformer。

第一个针对「Segment Anything」大模型的域适应策略来了!相关论文已被CVPR 2024 接收。

在社交活动中,大语言模型既可以是你的合作伙伴(partner),也可以成为你的导师(mentor)。在人类的社交活动中,为了更有效地在工作和生活中与他人沟通,需要一定的社交技能,比如解决冲突。

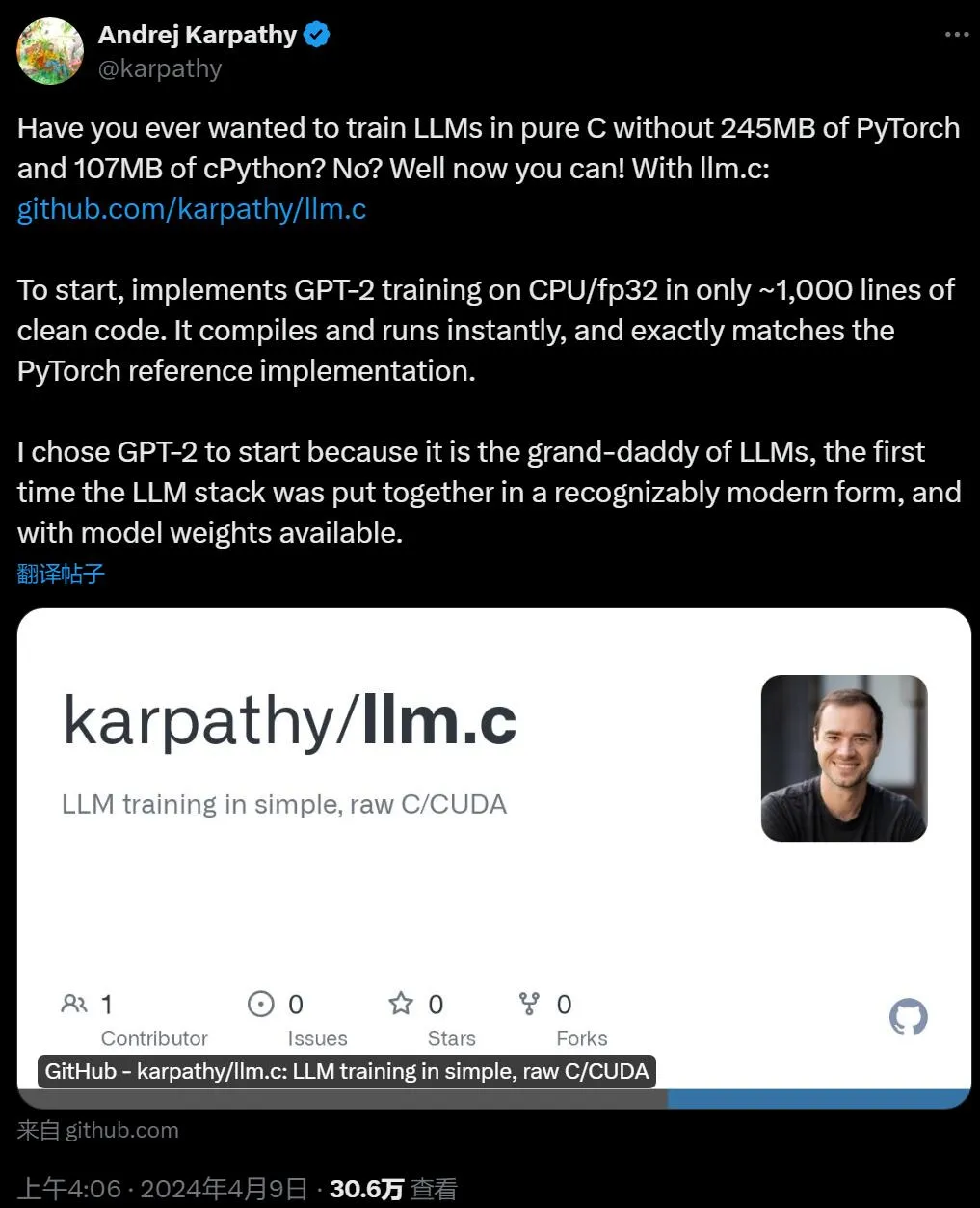

「Real men program in C.」 众所周知,大语言模型还在快速发展,应该有很多可以优化的地方。我用纯 C 语言来写,是不是能优化一大截? 也许很多人开过这样的脑洞,现在有大佬实现了。