Kimi论文自曝推理架构,80%流量都靠它承担

Kimi论文自曝推理架构,80%流量都靠它承担月之暗面和清华KVCache.ai团队的最新论文,首次揭秘了Kimi背后的推理架构! 要知道Kimi是国产大模型的当红炸子鸡,火到可以说从来没缺过流量,甚至还经常出现过载。

月之暗面和清华KVCache.ai团队的最新论文,首次揭秘了Kimi背后的推理架构! 要知道Kimi是国产大模型的当红炸子鸡,火到可以说从来没缺过流量,甚至还经常出现过载。

该文章的作者团队来自于斯坦福大学,共同第一作者团队Mert Yuksekgonul,Federico Bianchi, Joseph Boen, Sheng Liu, Zhi Huang

只有10亿参数的xLAM-1B在特定任务中击败了LLM霸主:OpenAI的GPT-3.5 Turbo和Anthropic的Claude-3 Haiku。上个月刚发布的苹果智能模型只有30亿参数,就连奥特曼都表示,我们正处于大模型时代的末期。那么,小语言模型(SLM)会是AI的未来吗?

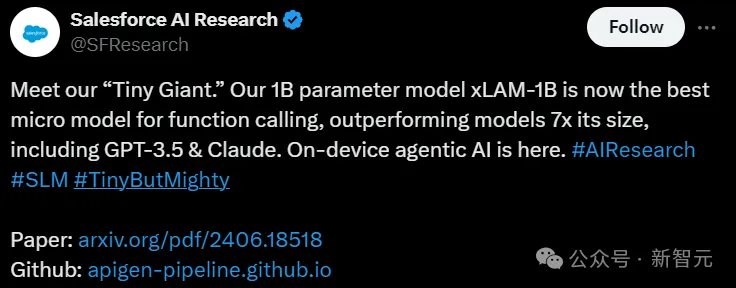

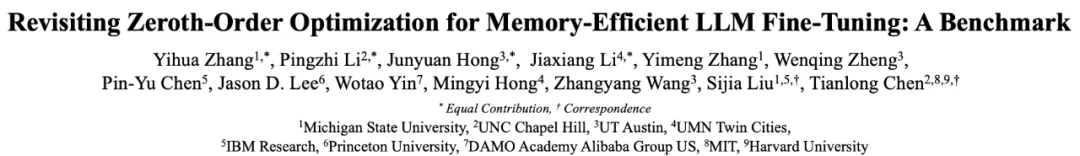

开源大语言模型(LLM)百花齐放,为了让它们适应各种下游任务,微调(fine-tuning)是最广泛采用的基本方法。基于自动微分技术(auto-differentiation)的一阶优化器(SGD、Adam 等)虽然在模型微调中占据主流,然而在模型越来越大的今天,却带来越来越大的显存压力。

检索增强式生成(RAG)是一种使用检索提升语言模型的技术。

3D 生成,一直在等待它的「ChatGPT时刻」。

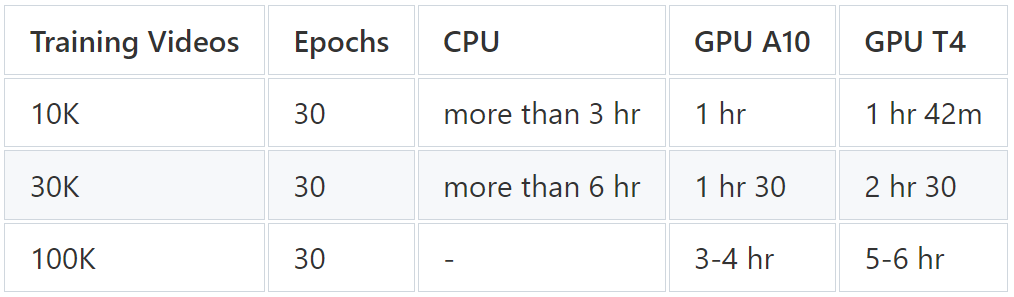

为了让大模型在特定任务、场景下发挥更大作用,LoRA这样能够平衡性能和算力资源的方法正在受到研究者们的青睐。

Meta的GenAI团队在最新研究中介绍了Meta 3D Gen模型:可以在不到1分钟的时间内从文本直接端到端生成3D资产。

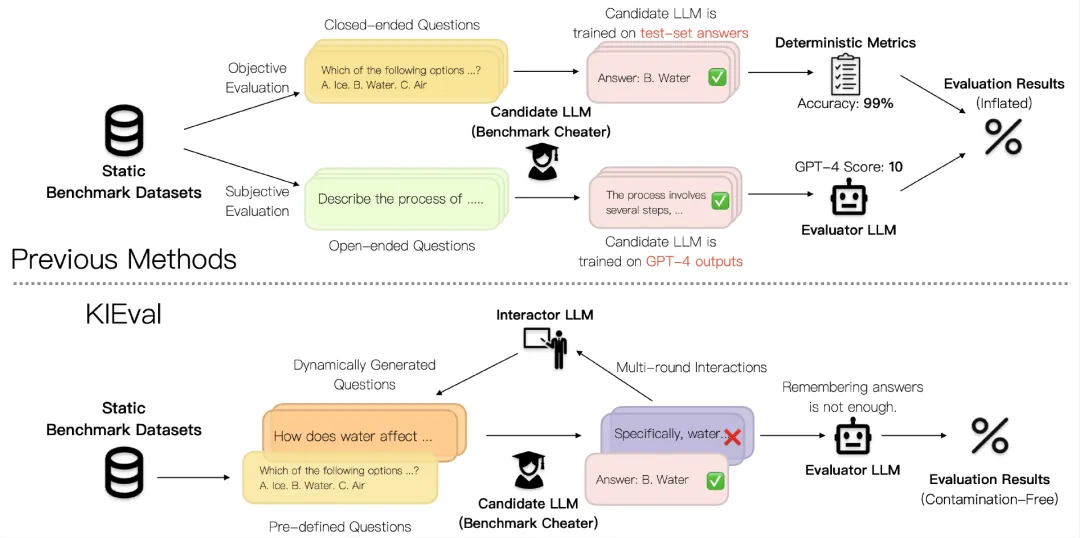

当前大语言模型(LLM)的评估方法受到数据污染问题的影响,导致评估结果被高估,无法准确反映模型的真实能力。北京大学等提出的KIEval框架,通过知识基础的交互式评估,克服了数据污染的影响,更全面地评估了模型在知识理解和应用方面的能力。

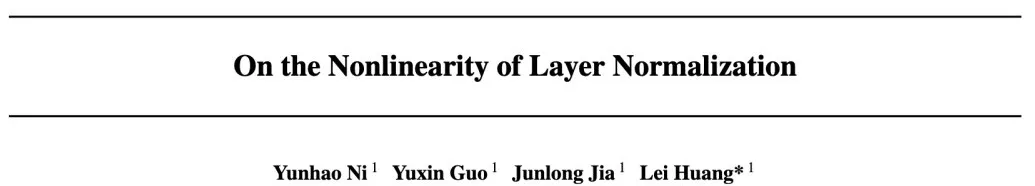

神经网络通常由三部分组成:线性层、非线性层(激活函数)和标准化层。线性层是网络参数的主要存在位置,非线性层提升神经网络的表达能力,而标准化层(Normalization)主要用于稳定和加速神经网络训练,很少有工作研究它们的表达能力,例如,以Batch Normalization为例

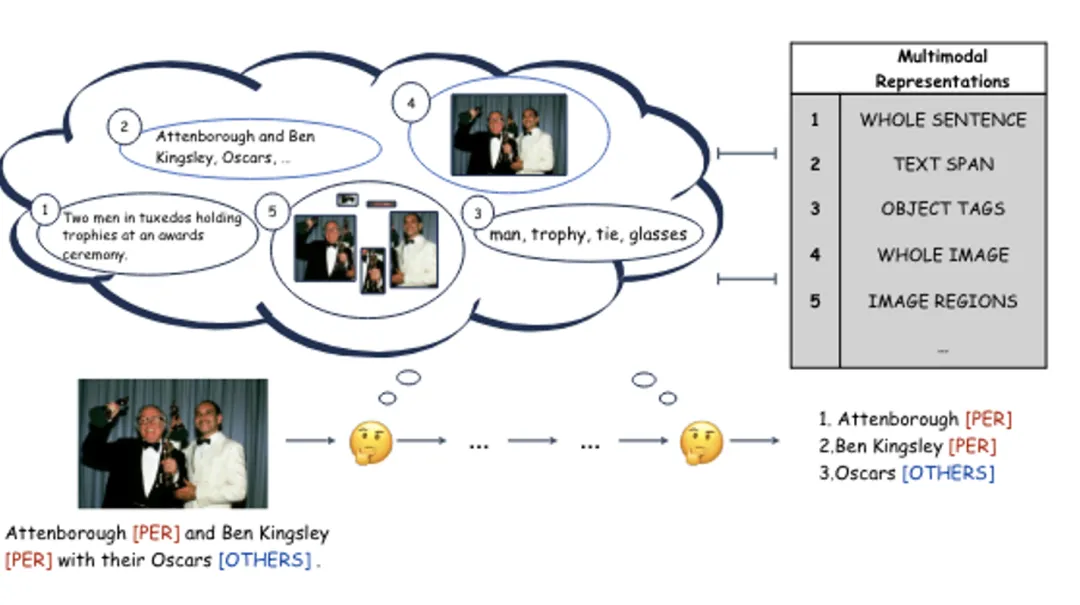

多模态命名实体识别,作为构建多模态知识图谱的一项基础而关键任务,要求研究者整合多种模态信息以精准地从文本中提取命名实体。尽管以往的研究已经在不同层次上探索了多模态表示的整合方法,但在将这些多模态表示融合以提供丰富上下文信息、进而提升多模态命名实体识别的性能方面,它们仍显不足。

「微调你的模型,获得比GPT-4更好的性能」不只是说说而已,而是真的可操作。最近,一位愿意动手的ML工程师就把几个开源LLM调教成了自己想要的样子。

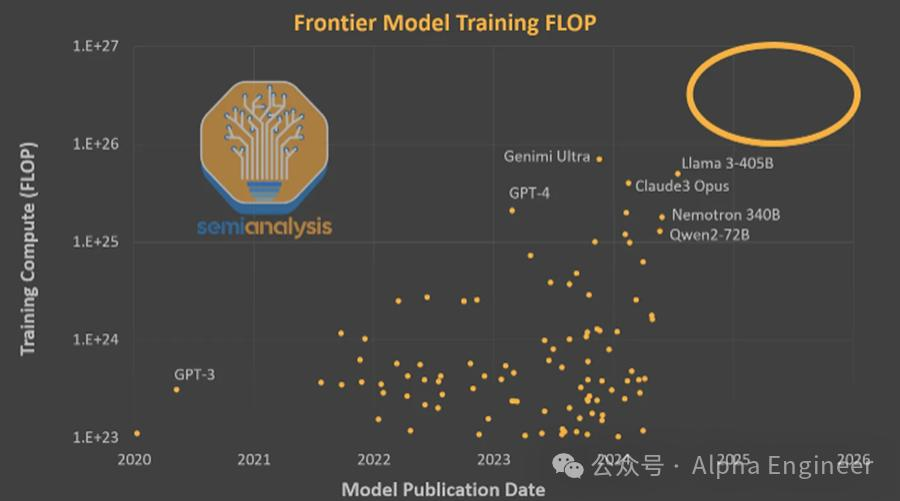

10万张H100卡构成的超级AI算力集群就像是现代人类文明的奇观,是人类通向AGI的钥匙。AI时代的军备竞赛已经拉开帷幕,赌注是天量的Capex支出,胜者则有机会成为AI时代的造物主。

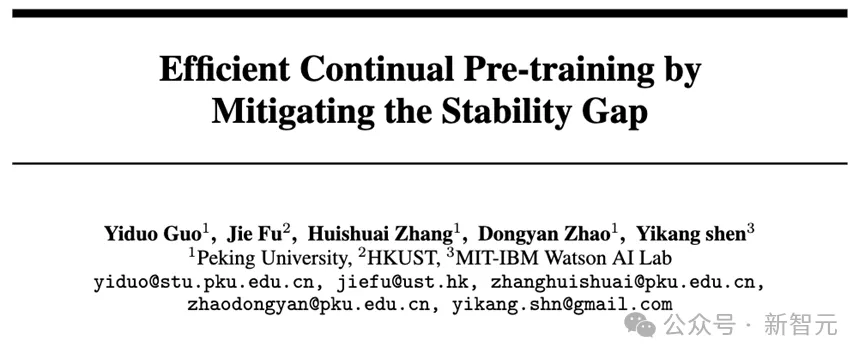

本文研究发现大语言模型在持续预训练过程中出现目标领域性能先下降再上升的现象。

看看这个时代最伟大 AI 学者的研究脉络。

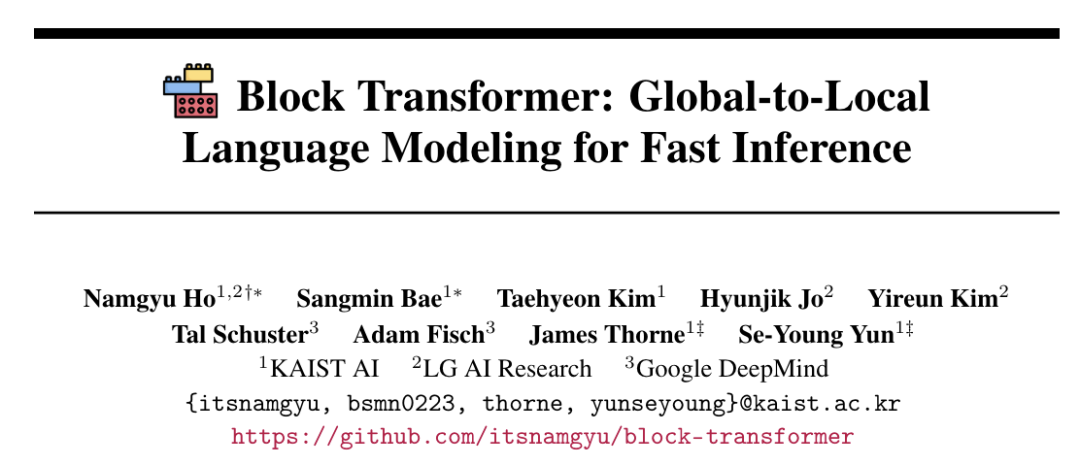

只要将注意力切块,就能让大模型解码提速20倍。

本文介绍了一篇语言模型对齐研究的论文,由瑞士、英国、和法国的三所大学的博士生和 Google DeepMind 以及 Google Research 的研究人员合作完成。

人工智能(AI)在过去十年里取得了长足进步,特别是在自然语言处理和计算机视觉领域。然而,如何提升 AI 的认知能力和推理能力,仍然是一个巨大的挑战。

看看这个时代最伟大 AI 学者的研究脉络。

迄今为止最快、近乎完美的网络流(Network Flow)算法,来了!

糖类是自然界中最丰富的有机物质,对生命至关重要。了解糖类如何在生理和病理过程中调节蛋白质,可以为解决关键的生物学问题和开发新的治疗方法提供机遇。

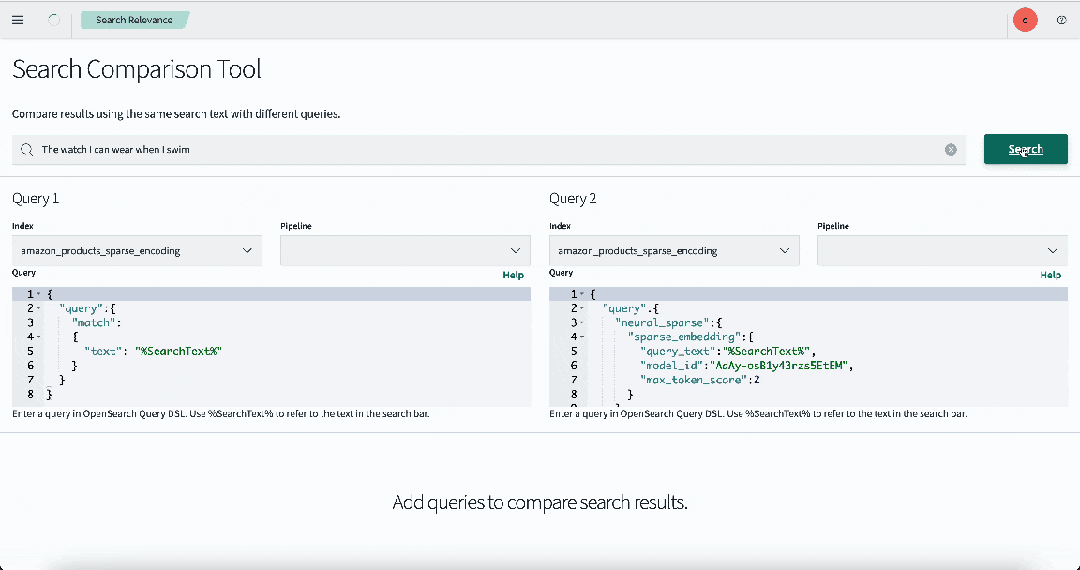

自从大模型爆火以来,语义检索也逐渐成为一项热门技术。尤其是在 RAG(retrieval augmented generation)应用中,检索结果的相关性直接决定了 AI 生成的最终效果。

很翔实的一篇教程。

随着 AI for Science 受到越来越多的关注,人们更加关心 AI 如何解决一系列科学问题并且可以被成功借鉴到其他相近的领域。

文章第一作者为来自北京大学物理学院、即将加入人工智能研究院读博的胡逸。胡逸的导师为北京大学人工智能研究院助理教授、北京通用人工智能研究院研究员张牧涵,主要研究方向为图机器学习和大模型的推理和微调。

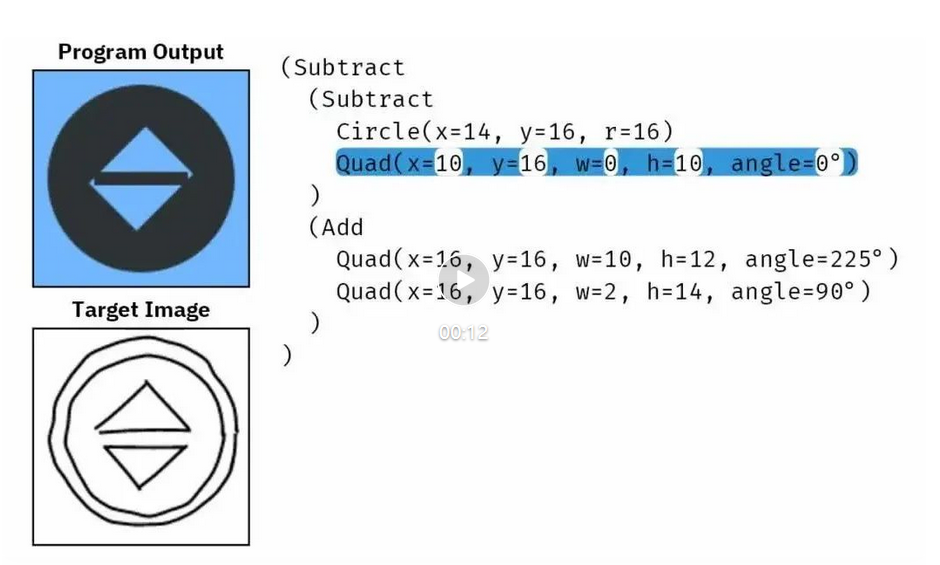

事实证明,扩散模型不仅能用于生成图像和视频,也能用于合成新程序。

本文提出了解决一般性编辑任务的统一框架!近期,复旦大学 FVL 实验室和南洋理工大学的研究人员对于多模态引导的基于文生图大模型的图像编辑算法进行了总结和回顾。综述涵盖 300 多篇相关研究,调研的最新模型截止至今年 6 月!

性能翻倍的Gemma 2, 让同量级的Llama3怎么玩?

想要达成通用人工智能 AGI 的终极目标,首先要达成的是模型要能完成人类所能轻松做到的任务。为了做到这一点,大模型开发的关键指导之一便是如何让机器像人类一样思考和推理。诸如注意力机制和思维链(Chain-of-Thought)等技术正是由此产生的灵感。

Claude 3.5 Sonnet的图表推理能力,比GPT-4o高出了27.8%。 针对多模态大模型在图表任务上的表现,陈丹琦团队提出了新的测试基准。 新Benchmark比以往更有区分度,也让一众传统测试中的高分模型暴露出了真实能力。