大模型“玩”Excel更6了,微软搞的

大模型“玩”Excel更6了,微软搞的大模型理解、推理Excel,现在变得更加精准了。

大模型理解、推理Excel,现在变得更加精准了。

近期,关于多模态大模型的研究如火如荼,工业界对此的投入也越来越多。

把因果链展示给 LLM,它就能学会公理。

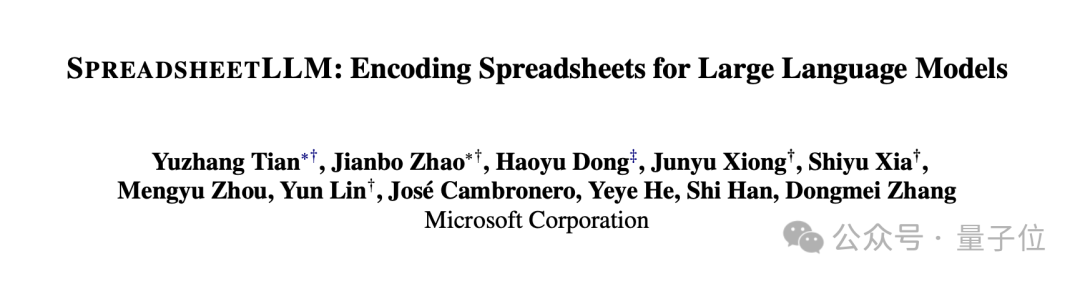

视觉大语言模型在最基础的视觉任务上集体「翻车」,即便是简单的图形识别都能难倒一片,或许这些最先进的VLM还没有发展出真正的视觉能力?

最核心的Claude 3.5编码系统提示,火遍Reddit社区。就在刚刚,原作者发布了进化后的第二版,有的网友已经将其加入工作流。

MoE已然成为AI界的主流架构,不论是开源Grok,还是闭源GPT-4,皆是其拥趸。然而,这些模型的专家,最大数量仅有32个。最近,谷歌DeepMind提出了全新的策略PEER,可将MoE扩展到百万个专家,还不会增加计算成本。

无需训练或微调,在提示词指定的新场景中克隆参考视频的运动,无论是全局的相机运动还是局部的肢体运动都可以一键搞定。

自从 Devin(首个全自动 AI 软件工程师)提出以来,针对软件工程的 AI Agent 的设计成为研究的焦点,越来越多基于 Agent 的 AI 自动软件工程师被提出,并在 SWE-bench 数据集上取得了不俗的表现、自动修复了许多真实的 GitHub issue。

准确诊断痴呆症有利于老年人晚年的身体健康,并减轻他们的家庭负担。

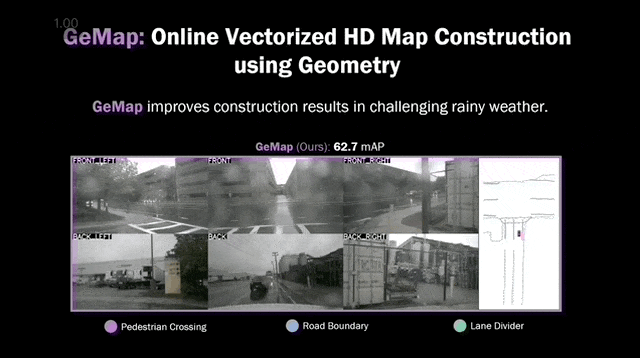

用几何图形来实时构建高精地图,真香!

最近,多个机构学者合著的一篇研究为AI的规模化指了一条新路:物理神经网络(PNN),这一新兴的前沿领域还鲜少有人涉足,但绝对值得深耕!AI模型再扩展1000倍的秘密可能就藏在这里。

来自微软、MIT等机构的学者提出了一种创新的训练范式,攻破了大模型的推理缺陷。他们通过因果模型构建数据集,直接教模型学习公理,结果只有67M参数的微型Transformer竟能媲美GPT-4的推理能力。

为什么说理解长视频难如 “大海捞针”?

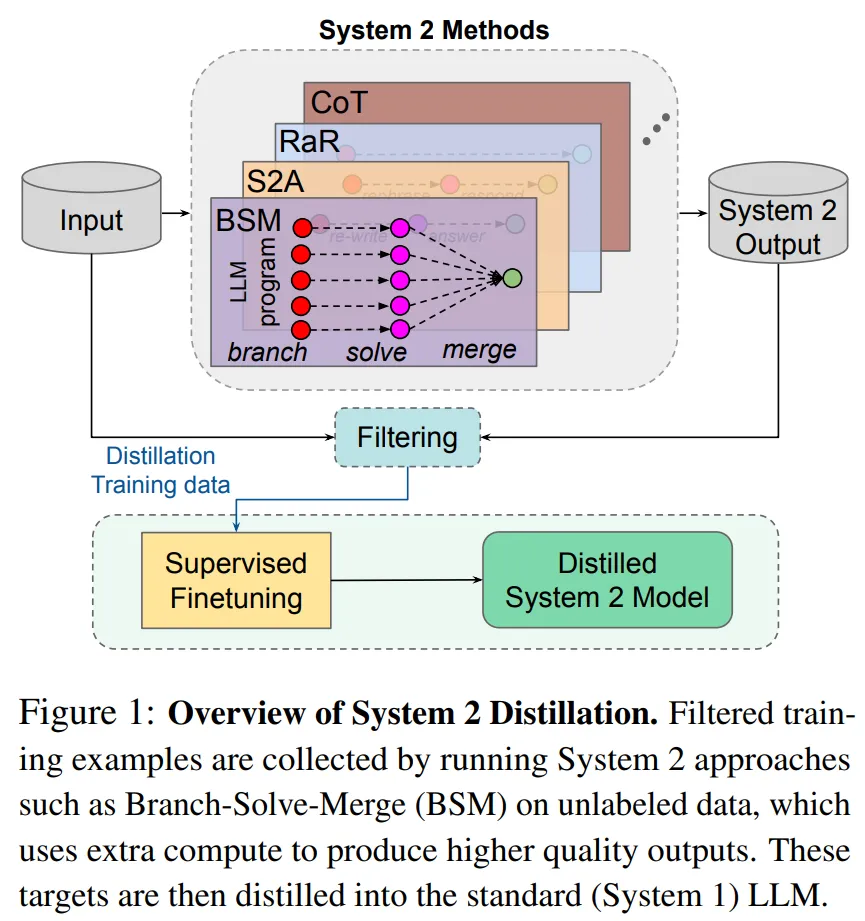

研究者表示,如果 Sytem 2 蒸馏可以成为未来持续学习 AI 系统的重要特征,则可以进一步提升 System 2 表现不那么好的推理任务的性能。

AI 代理得越来越重要,能够实现自主决策和解决问题。为了有效运作,这些代理需要一个确定最佳行动方案的规划过程,然后执行计划的行动。

当前的视觉语言模型(VLM)主要通过 QA 问答形式进行性能评测,而缺乏对模型基础理解能力的评测,例如 detail image caption 性能的可靠评测手段。

Mamba模型由于匹敌Transformer的巨大潜力,在推出半年多的时间内引起了巨大关注。但在大规模预训练的场景下,这两个架构还未有「一较高低」的机会。最近,英伟达、CMU、普林斯顿等机构联合发表的实证研究论文填补了这个空白。

文生图、文生视频,视觉生成赛道火热,但仍存在亟需解决的问题。

最近,新加坡国立大学联合南洋理工大学和哈工深的研究人员共同提出了一个全新的视频推理框架,这也是首次大模型推理社区提出的面向视频的思维链框架(Video-of-Thought, VoT)。视频思维链VoT让视频多模态大语言模型在复杂视频的理解和推理性能上大幅提升。该工作已被ICML 2024录用为Oral paper。

自从大型 Transformer 模型逐渐成为各个领域的统一架构,微调就成为了将预训练大模型应用到下游任务的重要手段

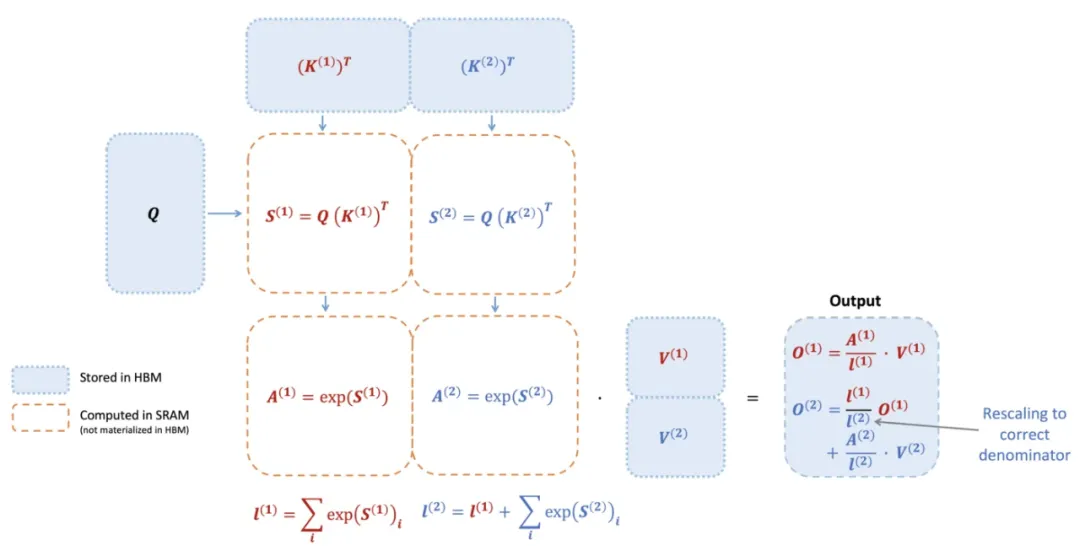

740 TFLOPS!迄今最强 FlashAttention 来了。

生成式模型原本被设计来模仿人类的各种复杂行为,但人们普遍认为它们最多只能达到与其训练数据中的专家相当的水平。不过,最新的研究突破了这一限制,表明在特定领域,如国际象棋,通过采用低温采样技术,这些模型能够超越它们所学习的那些专家,展现出更高的能力。

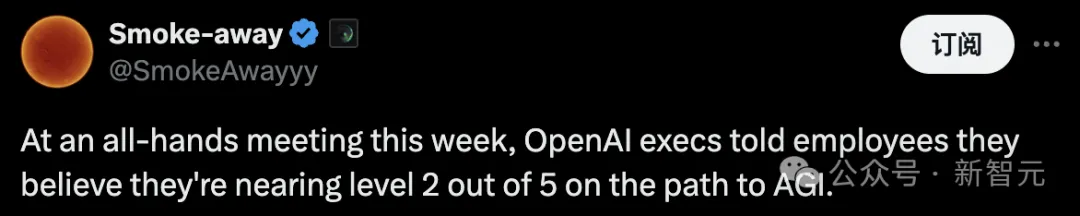

OpenAI全新的AGI路线图,刚刚被曝出了!OpenAI将AI划分为5个等级,自称其AI模型正处于L1,但很快就会达到L2(推理者)。而根据其前研究员预测,五级AGI最快将在27年实现。

时隔一年,FlashAttention又推出了第三代更新,专门针对H100 GPU的新特性进行优化,在之前的基础上又实现了1.5~2倍的速度提升。

智能体又双叒叕进化了!这次,什么游戏都能玩,什么软件都能操控了。

评估大模型是否诚实的基准来了!

大模型权威测试,翻车了?! HuggingFace都在用的MMLU-PRO,被扒出评测方法更偏向闭源模型,被网友直接在GitHub Issue提出质疑。

一年一度谷歌学术指标公布了!Nature年年霸榜,而今年与以往不同的是,国际学术顶会的排名大幅提升,CVPR位居第二,超越Science仅次于Nature。另外,TOP 20中,共有五大顶会入选,被引最高论文与大模型时代下前沿技术,一脉相承。

近年来,人物动作生成的研究取得了显著的进展,在众多领域,如计算机视觉、计算机图形学、机器人技术以及人机交互等方面获得广泛的关注。然而,现有工作大多只关注动作本身,以场景和动作类别同时作为约束条件的研究依然处于起步阶段。

四大 VLM,竟都在盲人摸象?