在机器人顶会 RSS 2024 上,中国的人形机器人研究斩获最佳论文奖

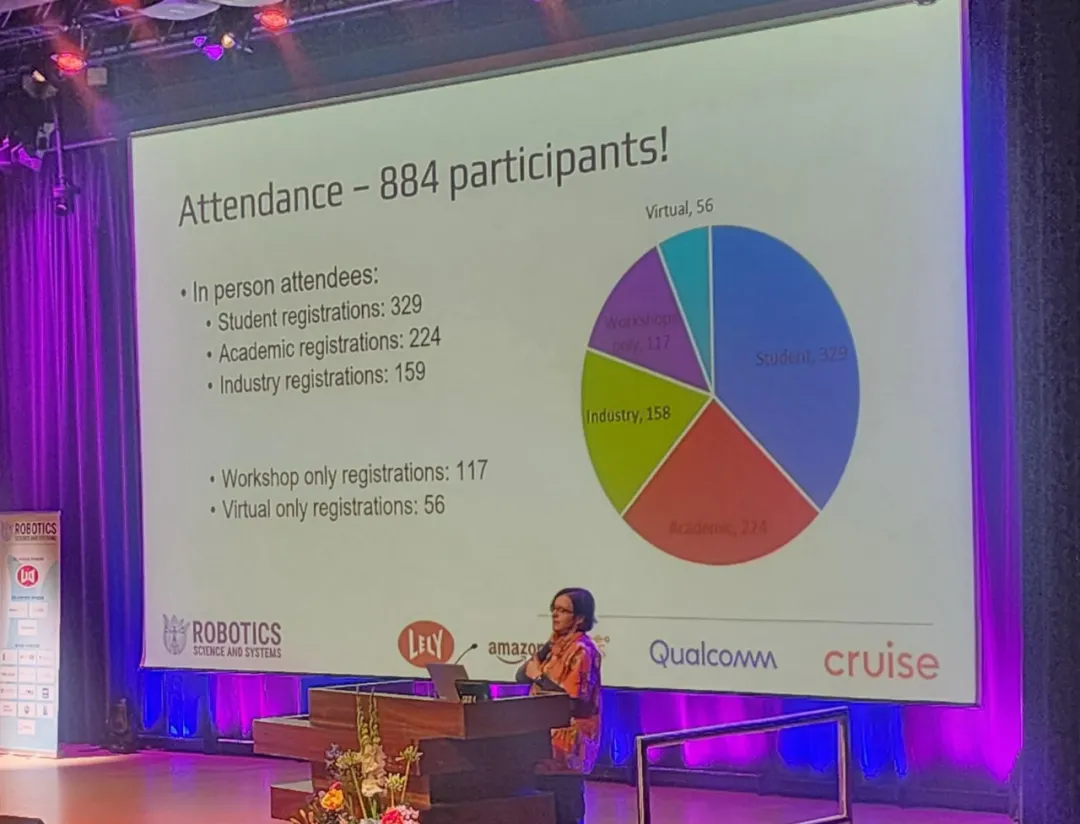

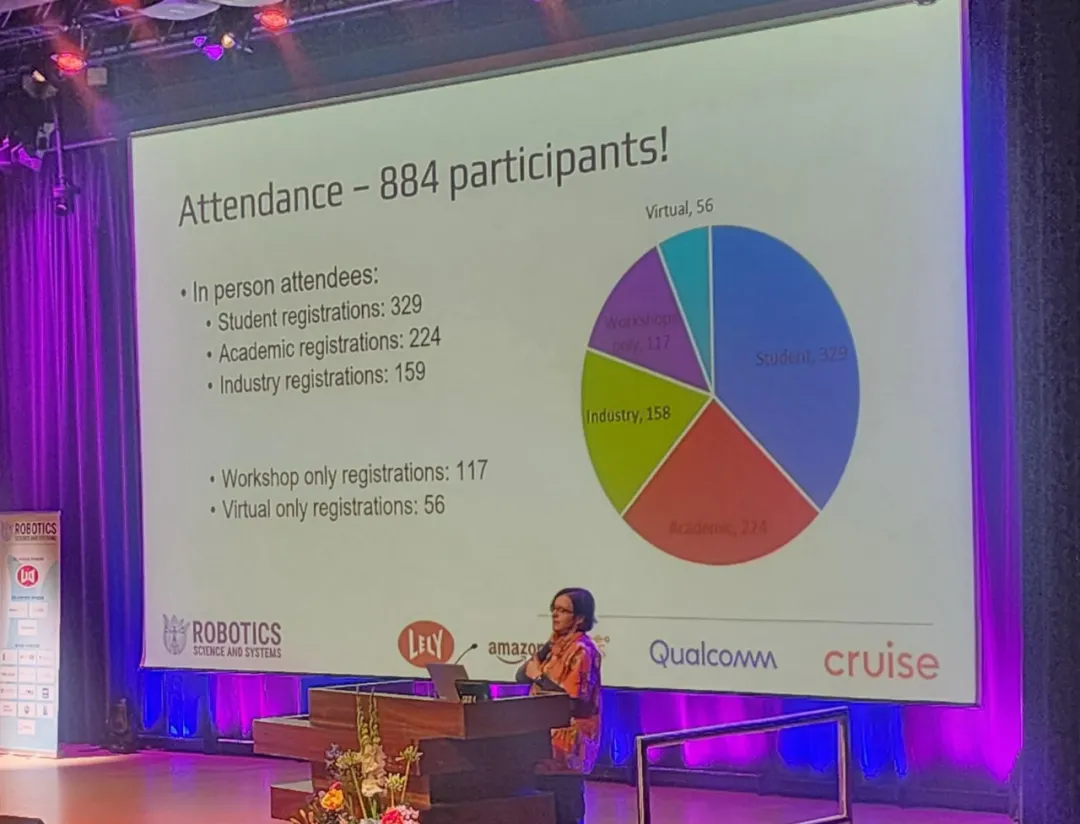

在机器人顶会 RSS 2024 上,中国的人形机器人研究斩获最佳论文奖近日,机器人领域著名会议 RSS(Robotics: Science and Systems) 2024 在荷兰代尔夫特理工大学圆满落幕。

近日,机器人领域著名会议 RSS(Robotics: Science and Systems) 2024 在荷兰代尔夫特理工大学圆满落幕。

「通过系统优化软件的帮助,开发的门槛会被降低,各种不同硬件会得到统一,让技术生态得到发展。

前谷歌科学家Yi Tay重磅推出「LLM时代的模型架构」系列博客,首篇博文的话题关于:基于encoder-only架构的BERT是如何被基于encoder-decoder架构的T5所取代的,分析了BERT灭绝的始末以及不同架构模型的优缺点,以史为鉴,对于未来的创新具有重要意义。

AlphaFold 3的论文太晦涩?没关系,斯坦福大学的两位博士生「图解」AlphaFold 3 ,将模型架构可视化,同时不遗漏任何一个细节。

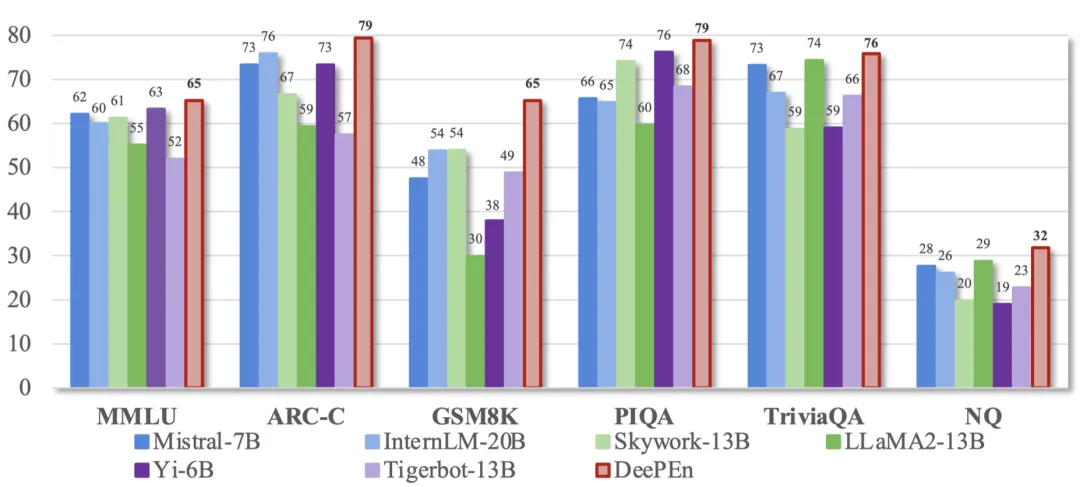

小模型时代来了?OpenAI带着GPT-4o mini首次入局小模型战场,Mistral AI、HuggingFace本周接连发布了小模型。如今,苹果也发布了70亿参数小模型DCLM,性能碾压Mistral-7B。

在信息爆炸的当今时代,我们如何从浩如烟海的数据中探寻深层次的联系呢?

小模型成趋势?

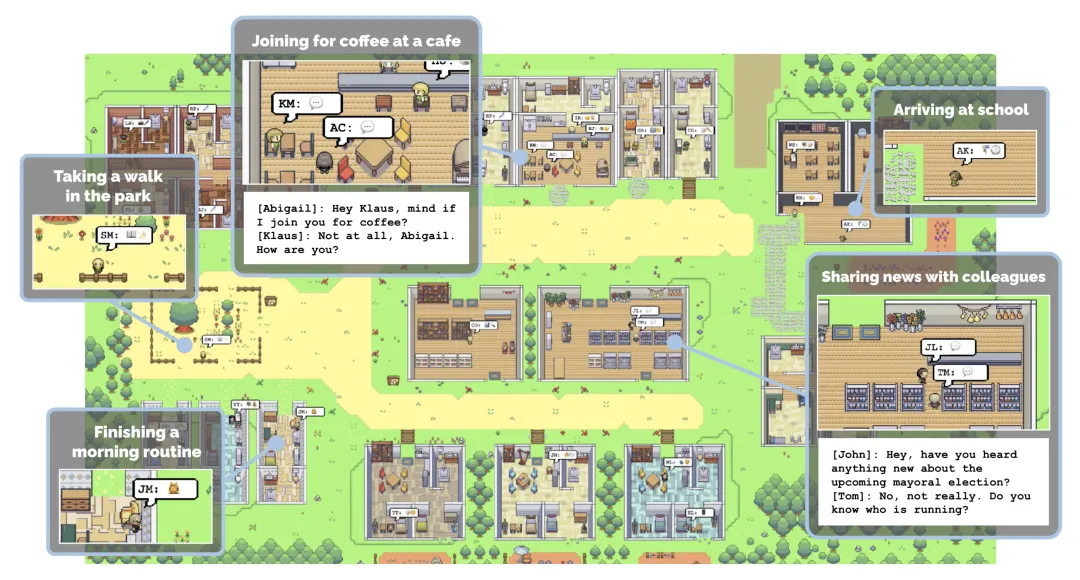

首个专为各种机器人设计的模拟互动 3D 社会。

![使用视觉语言模型进行 PDF 检索 [译]](https://blog.vespa.ai/assets/2024-07-15-retrieval-with-vision-language-models-colpali/GRuDx-xXAAAFqBR.jpeg)

近年来,随着大语言模型 (LLM) 的发展,构建检索增强生成 (RAG) 解决方案成为了一个热门话题。RAG 将 LLM 的强大功能与检索模型结合,应用于专有知识数据库。然而,对于开发人员来说,一个主要挑战是将各种文档格式(如 PDF、HTML 等)转换为可供文本模型处理的格式。

低秩适应(Low-Rank Adaptation,LoRA)通过可插拔的低秩矩阵更新密集神经网络层,是当前参数高效微调范式中表现最佳的方法之一。此外,它在跨任务泛化和隐私保护方面具有显著优势。

GPT-4o mini头把交椅还未坐热,Mistral AI联手英伟达发布12B参数小模型Mistral Nemo,性能赶超Gemma 2 9B和Llama 3 8B。

AI经过多轮“自我提升”,能力不增反降?

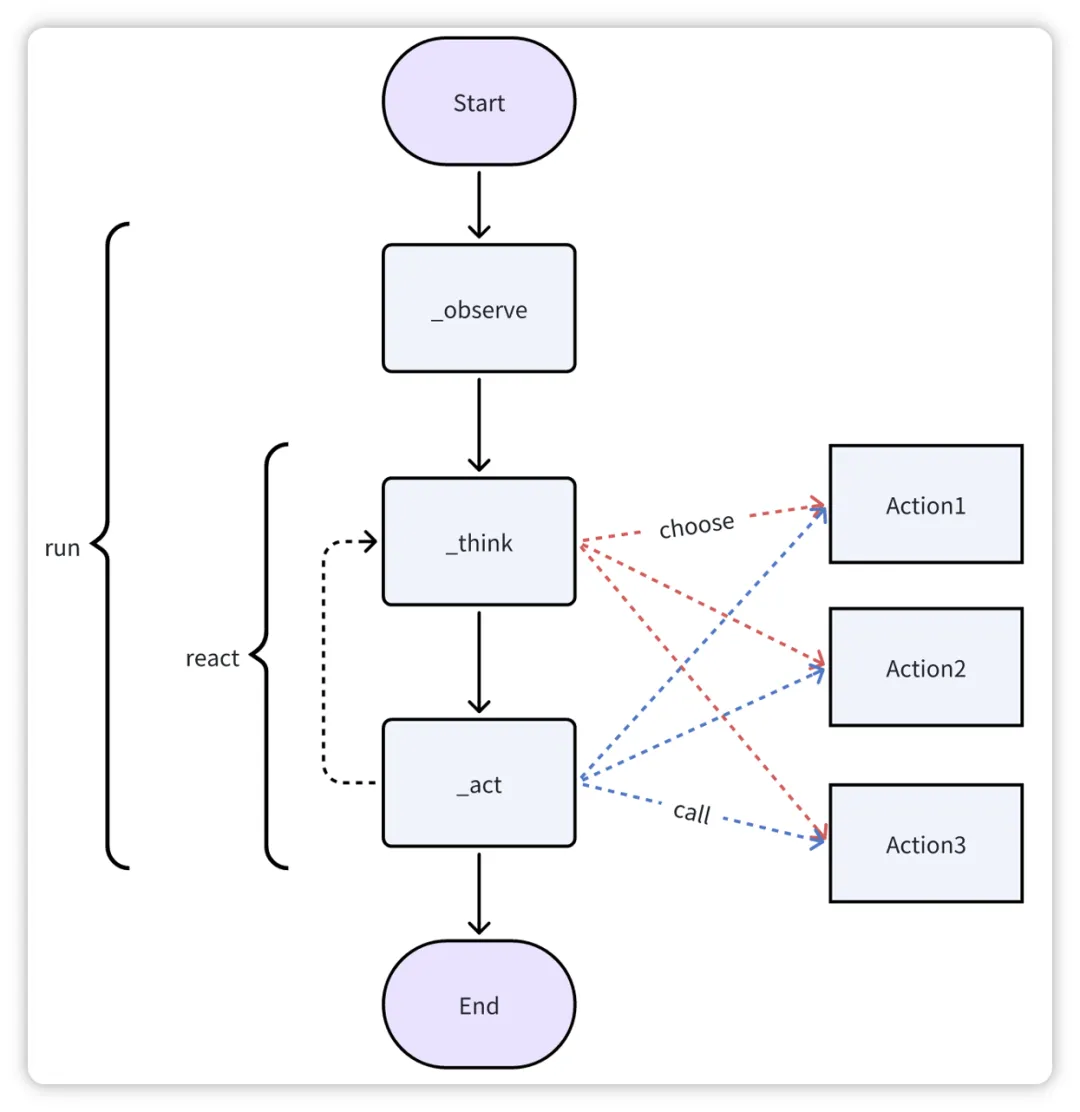

著名AI学者、斯坦福大学教授吴恩达提出了AI Agent的四种设计方式后,Agentic Workflow(智能体工作流)立即火爆全球,多个行业都在实践智能体工作流的应用,并推动了新的Agentic AI探索热潮。

随着大语言模型展现出惊人的语言智能,各大 AI 公司纷纷推出自己的大模型。这些大模型通常在不同领域和任务上各有所长,如何将它们集成起来以挖掘其互补潜力,成为了 AI 研究的前沿课题。

MoE 因其在训推流程中低销高效的特点,近两年在大语言模型领域大放异彩。作为 MoE 的灵魂,专家如何能够发挥出最大的学习潜能,相关的研究与讨论层出不穷。此前,华为 GTS AI 计算 Lab 的研究团队提出了 LocMoE ,包括新颖的路由网络结构、辅助降低通信开销的本地性 loss 等,引发了广泛关注。

大模型开源的热潮下,隐藏着诸多问题,从定义的模糊到实际开放内容的局限性,Lecun再陷Meta大模型是否真开源的质疑风波只是冰山一角。

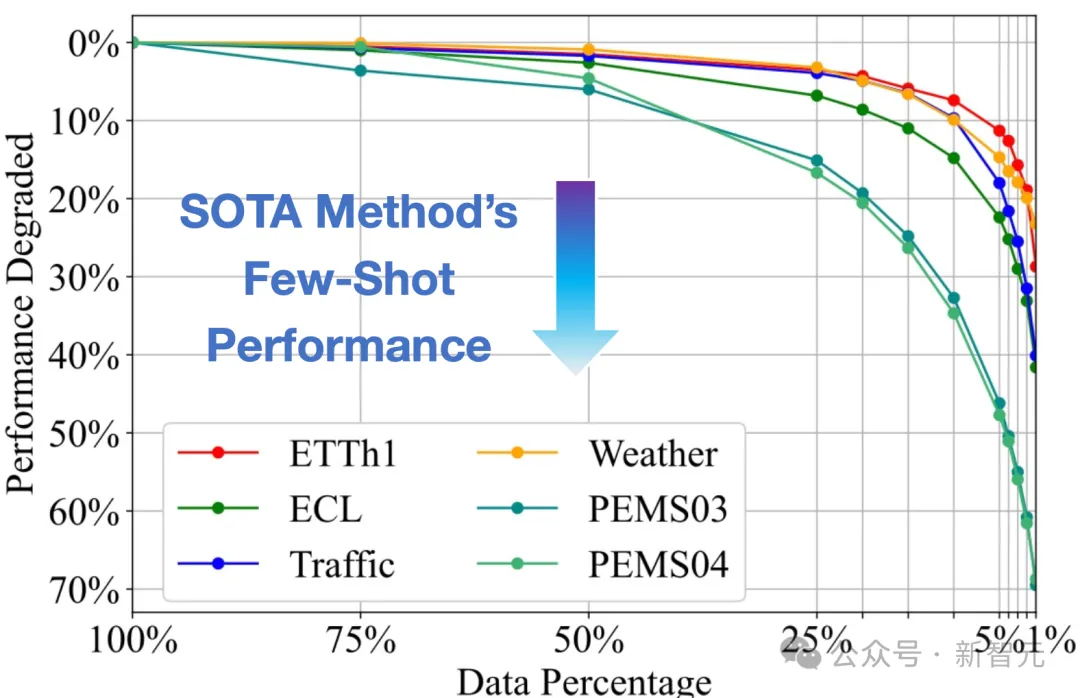

大模型在语言、图像领域取得了巨大成功,时间序列作为多个行业的重要数据类型,时序领域的大模型构建尚处于起步阶段。近期,清华大学的研究团队基于Transformer在大规模时间序列上进行生成式预训练,获得了任务通用的时序分析模型,展现出大模型特有的泛化性与可扩展性

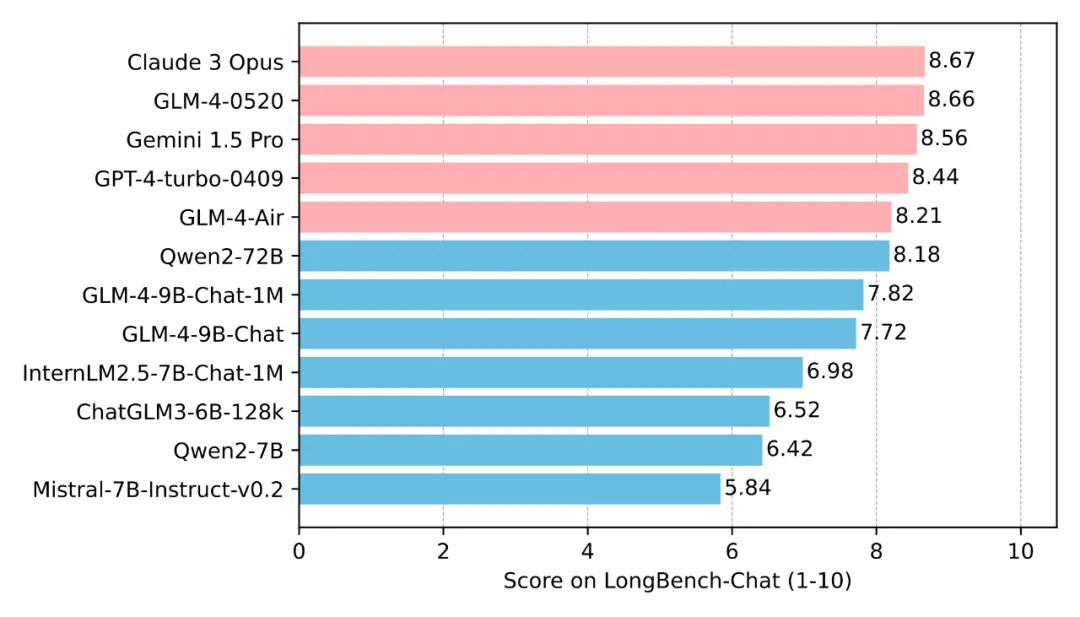

在2023年初,即便是当时最先进的GPT-3.5,其上下文长度也仅限于2k。然而,时至今日,1M的上下文长度已经成为衡量模型技术先进性的重要标志之一。

Agent 是什么

大模型测试能拿高分,实际场景中却表现不佳的问题有解了。

只需激活60%的参数,就能实现与全激活稠密模型相当的性能。

好家伙!为了揭秘Transformer内部工作原理,陈丹琦团队直接复现——

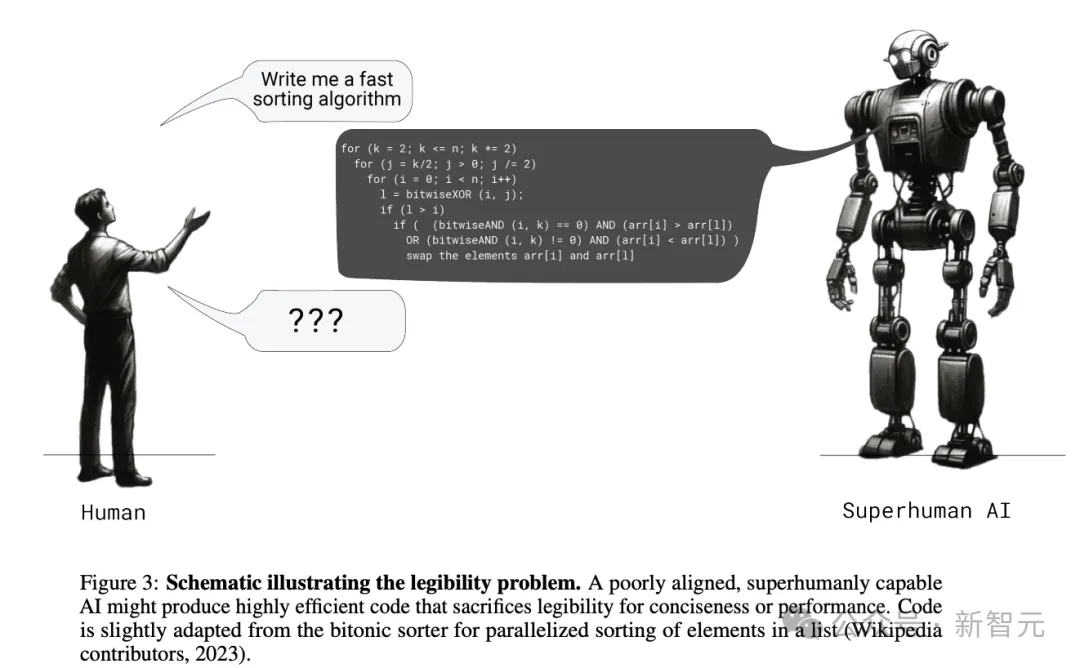

当我们不停在CoT等领域大下苦功、试图提升LLM推理准确性的同时,OpenAI的对齐团队从另一个角度发现了华点——除了准确性,生成答案的清晰度、可读性和可验证性也同样重要。

自回归解码已经成为了大语言模型(LLMs)的事实标准,大语言模型每次前向计算需要访问它全部的参数,但只能得到一个token,导致其生成昂贵且缓慢。

近日,快手可灵大模型团队开源了名为LivePortrait的可控人像视频生成框架,该框架能够准确、实时地将驱动视频的表情、姿态迁移到静态或动态人像视频上,生成极具表现力的视频结果。

最近,7B小模型又成为了AI巨头们竞相追赶的潮流。继谷歌的Gemma2 7B后,Mistral今天又发布了两个7B模型,分别是针对STEM学科的Mathstral,以及使用Mamaba架构的代码模型Codestral Mamba。

视频生成也能参考“上下文”?!

大模型理解、推理Excel,现在变得更加精准了。

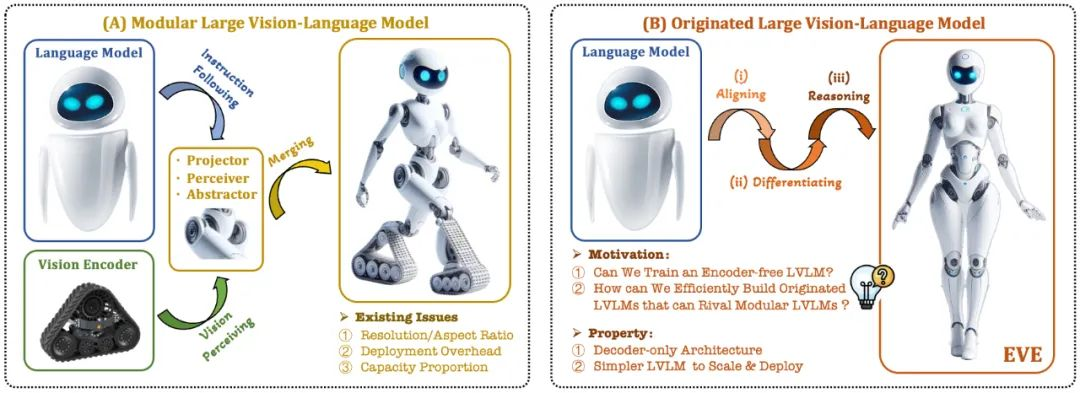

近期,关于多模态大模型的研究如火如荼,工业界对此的投入也越来越多。

把因果链展示给 LLM,它就能学会公理。