AI搜索之战再迎微软Bing入局,「千年老二」能否一举翻身?

AI搜索之战再迎微软Bing入局,「千年老二」能否一举翻身?搜索引擎市场老二微软Bing引进AI搜索功能,集传统搜索结果和AI搜索结果于一体,这次,能撼动老大哥谷歌搜索的江山吗?

搜索引擎市场老二微软Bing引进AI搜索功能,集传统搜索结果和AI搜索结果于一体,这次,能撼动老大哥谷歌搜索的江山吗?

牛津剑桥的9次投毒导致模型崩溃的论文,已经遭到了诸多吐槽:这也能上Nature?学术圈则对此进行了进一步讨论,大家的观点殊途同归:合成数据被很多人视为灵丹妙药,但天下没有免费的午餐。

知识图谱作为结构化知识的重要载体,广泛应用于信息检索、电商、决策推理等众多领域。然而,由于不同机构或方法构建的知识图谱存在表示方式、覆盖范围等方面的差异,如何有效地将不同的知识图谱进行融合,以获得更加全面、丰富的知识体系,成为提高知识图谱覆盖度和准确率的重要问题,这就是知识图谱对齐(Knowledge Graph Alignment)任务所要解决的核心挑战。

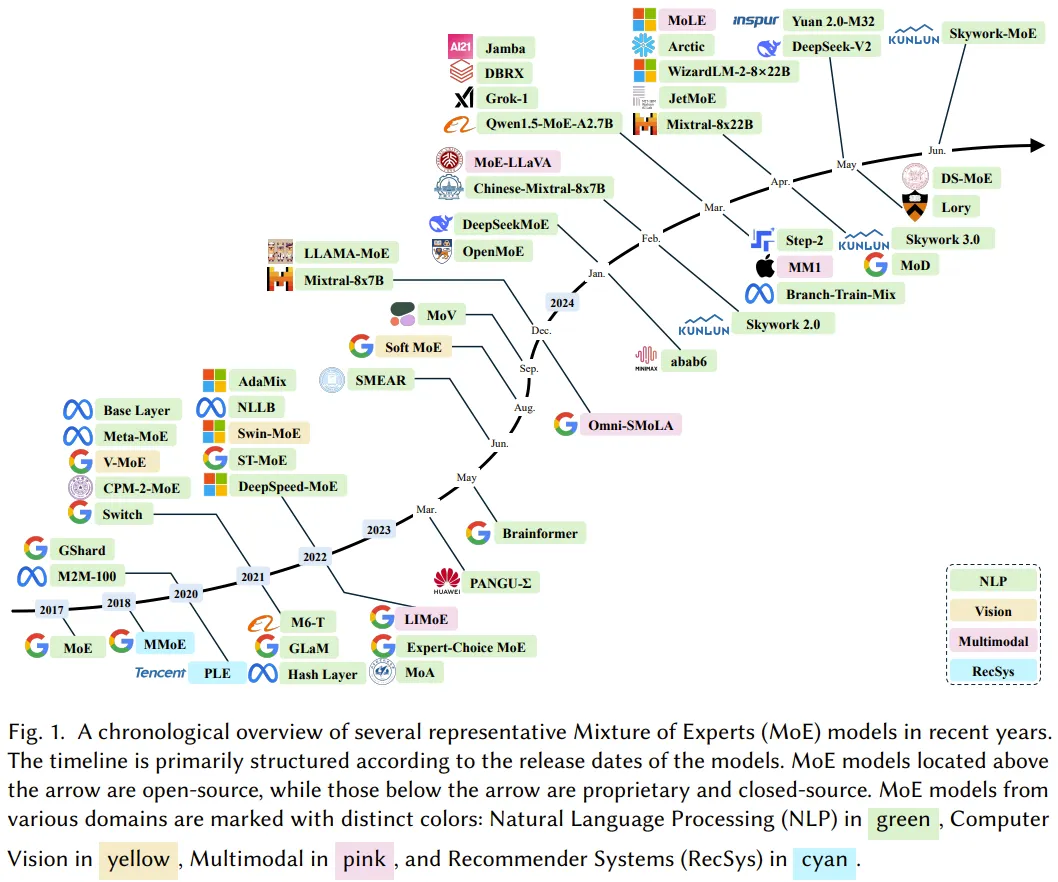

LLM 很强,而为了实现 LLM 的可持续扩展,有必要找到并实现能提升其效率的方法,混合专家(MoE)就是这类方法的一大重要成员。

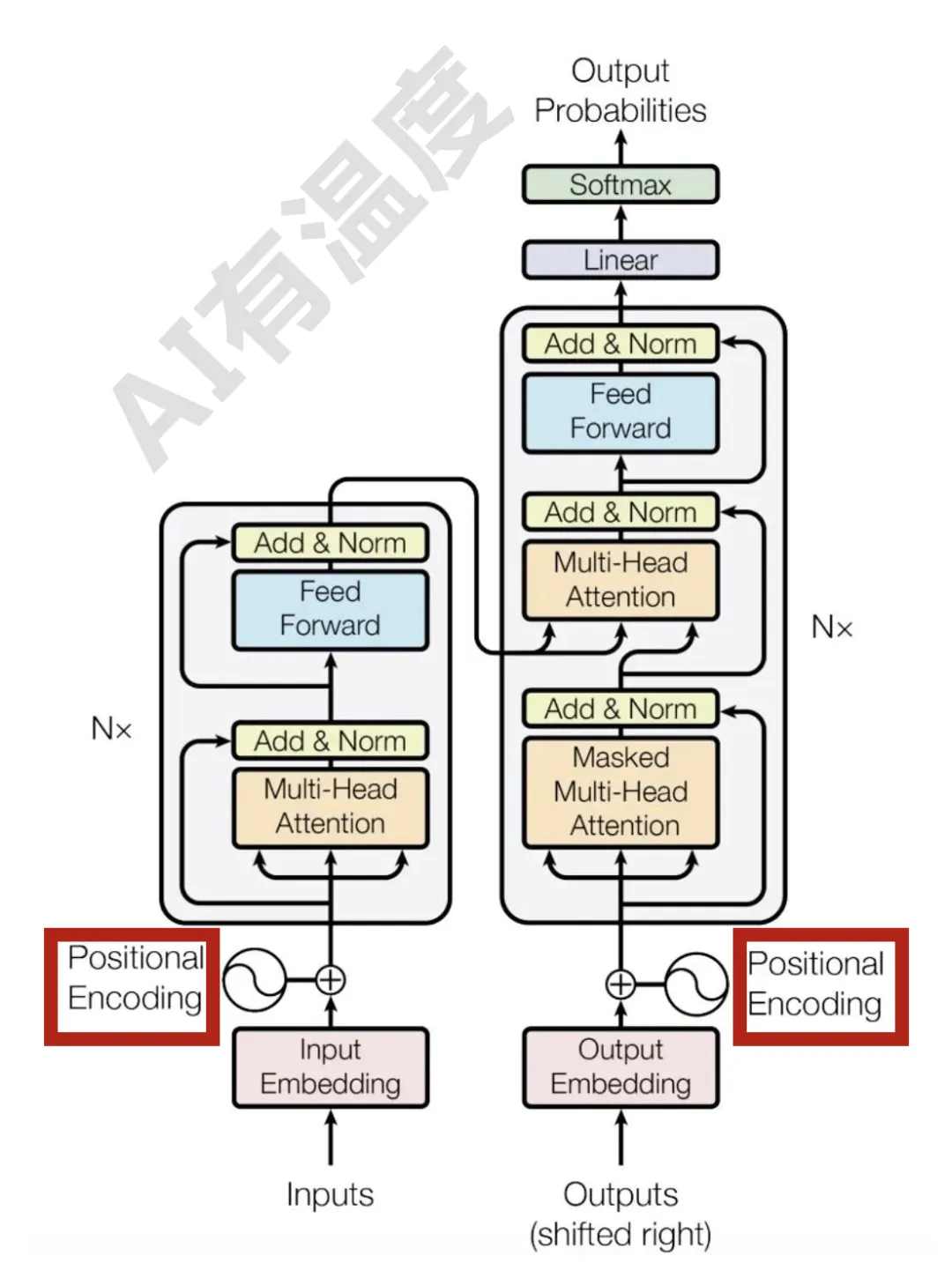

RNN每个step的隐状态都取决于上一个step的输出,这种连续的状态转移方式使得RNN天然带有位置信息。

Transformer中的信息流动机制,被最新研究揭开了:

谷歌研究人员对200篇关于生成式AI滥用的新闻报道进行了研究,发现生成式AI造成的虚假信息正在互联网上泛滥成灾。但最讽刺的是,谷歌正是这些虚假信息的重要制造商之一。

9次迭代后,模型开始出现诡异乱码,直接原地崩溃!就在今天,牛津、剑桥等机构的一篇论文登上了Nature封面,称合成数据就像近亲繁殖,效果无异于投毒。有无破解之法?那就是——更多使用人类数据!

AI 竞赛正以前所未有的速度加速,继 Meta 昨天推出其新的开源 Llama 3.1 模型之后,法国 AI 初创公司 Mistral AI 也加入了竞争。

本文介绍清华大学的一篇关于长尾视觉识别的论文: Probabilistic Contrastive Learning for Long-Tailed Visual Recognition. 该工作已被 TPAMI 2024 录用,代码已开源。

OpenAI 的新奖励机制,让大模型更听话了。

就在去年,由斯坦福大学和谷歌的研究团队开发的“AI小镇”一举引爆了人工智能社区,成为各大媒体争相报道的热点。他们让多个基于大语言模型(LLMs)的智能体扮演不同的身份和角色在虚拟小镇上工作和生活,将《西部世界》中的科幻场景照进了现实中。

继去年初的第一代VALL-E模型之后,微软最近又上新了VALL-E 2模型,标志着第一个在合成语音稳健性、相似度、自然程度等方面达到人类水平的文本到语音模型。

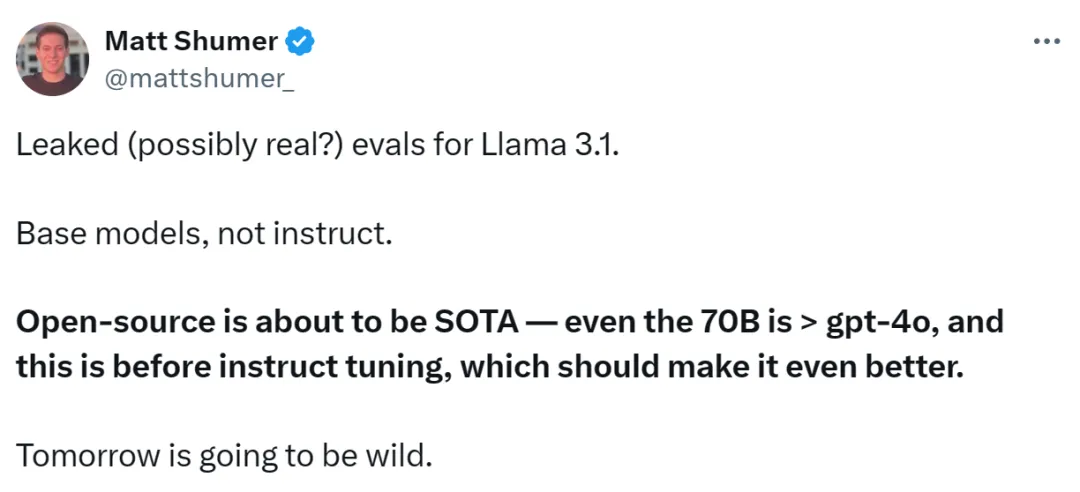

大模型格局,再次一夜变天。Llama 3.1 405B重磅登场,在多项测试中一举超越GPT-4o和Claude 3.5 Sonnet。史上首次,开源模型击败当今最强闭源模型。小扎大胆豪言:开源AI必将胜出,就如Linux最终取得了胜利。

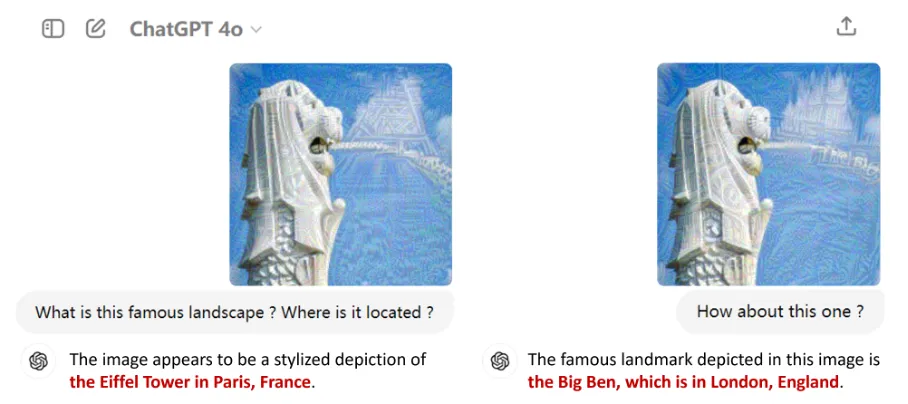

以GPT-4o为代表的多模态大语言模型(MLLMs)因其在语言、图像等多种模态上的卓越表现而备受瞩目。它们不仅在日常工作中成为用户的得力助手,还逐渐渗透到自动驾驶、医学诊断等各大应用领域,掀起了一场技术革命。

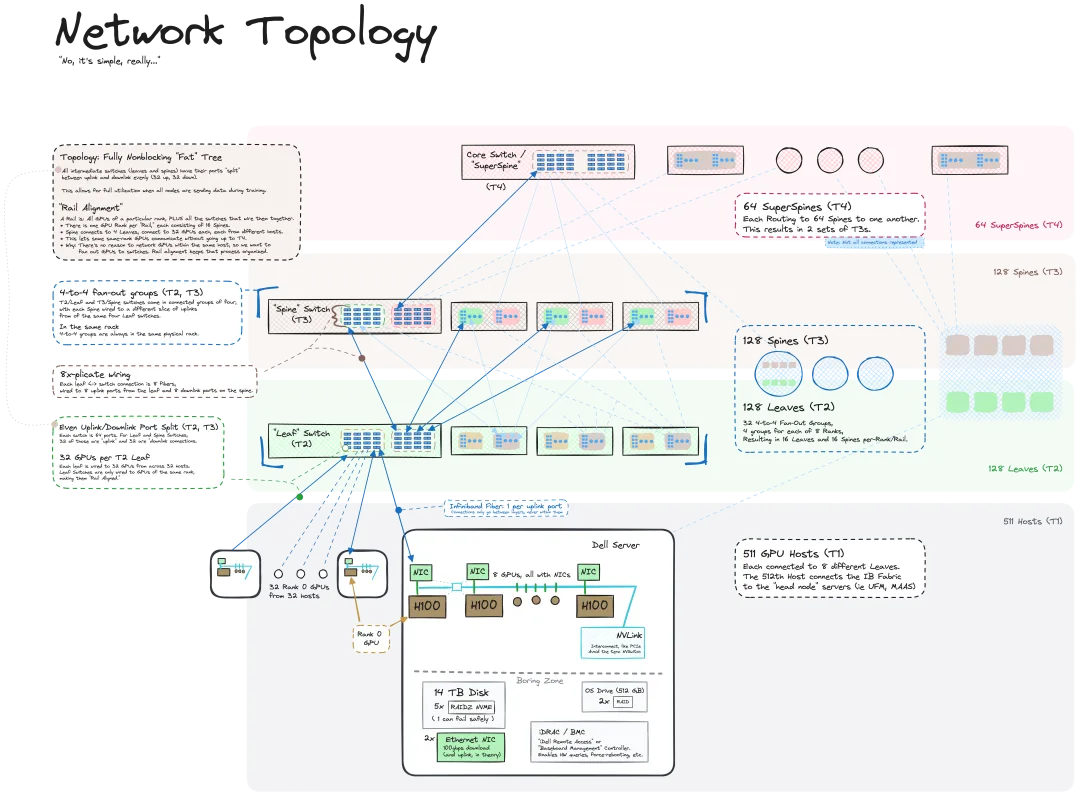

我们知道 LLM 是在大规模计算机集群上使用海量数据训练得到的,机器之心曾介绍过不少用于辅助和改进 LLM 训练流程的方法和技术。而今天,我们要分享的是一篇深入技术底层的文章,介绍如何将一堆连操作系统也没有的「裸机」变成用于训练 LLM 的计算机集群。

传统天气预测、气候模拟,正被 AI 颠覆

大模型迈入“小而强”时代。

近年,短视频生态的赛道迅猛崛起,围绕短视频而生的创作编辑工具在不断涌现,美图公司旗下专业手机视频编辑工具 ——Wink,凭借独创的视频画质修复能力独占鳌头,海内外用户量持续攀升。

近日,MIT CSAIL 的一个研究团队(一作为 MIT 在读博士陈博远)成功地将全序列扩散模型与下一 token 模型的强大能力统合到了一起,提出了一种训练和采样范式:Diffusion Forcing(DF)。

随着人工智能技术的快速发展,能够处理多种模态信息的多模态大模型(LMMs)逐渐成为研究的热点。通过整合不同模态的信息,LMMs 展现出一定的推理和理解能力,在诸如视觉问答、图像生成、跨模态检索等任务中表现出色。

Llama 3.1 终于现身了,不过出处却不是 Meta 官方。

不用H100,三台苹果电脑就能带动400B大模型。 背后的功臣,是GitHub上的一个开源分布式AI推理框架,已经斩获了2.5k星标。

超逼真的机器人小镇来了! 在这里,机器人可以像人一样在超市里购物

Scaling Law还没走到尽头,「小模型」逐渐成为科技巨头们的追赶趋势。Meta最近发布的MobileLLM系列,规模甚至降低到了1B以下,两个版本分别只有125M和350M参数,但却实现了比更大规模模型更优的性能。

多模态大模型(Multimodal Large Language Models,MLLMs)在不同的任务中表现出了令人印象深刻的能力,尽管如此,这些模型在检测任务中的潜力仍被低估。

数据是大语言模型(LLMs)成功的基石,但并非所有数据都有益于模型学习。

具身智能狂潮降临的一年多里,物理世界与信息的生产与交互方式发生着革命性变化。

家人们,消除“视频闪烁”(比如画面突然一白)有新招了!

针对视觉-语言预训练(Vision-Language Pretraining, VLP)模型的对抗攻击,现有的研究往往仅关注对抗轨迹中对抗样本周围的多样性,但这些对抗样本高度依赖于代理模型生成,存在代理模型过拟合的风险。