让AI更懂物理世界!人大北邮上海AI Lab等提出多模态分割新方法 | ECCV2024

让AI更懂物理世界!人大北邮上海AI Lab等提出多模态分割新方法 | ECCV2024让AI像人类一样借助多模态线索定位感兴趣的物体,有新招了!

让AI像人类一样借助多模态线索定位感兴趣的物体,有新招了!

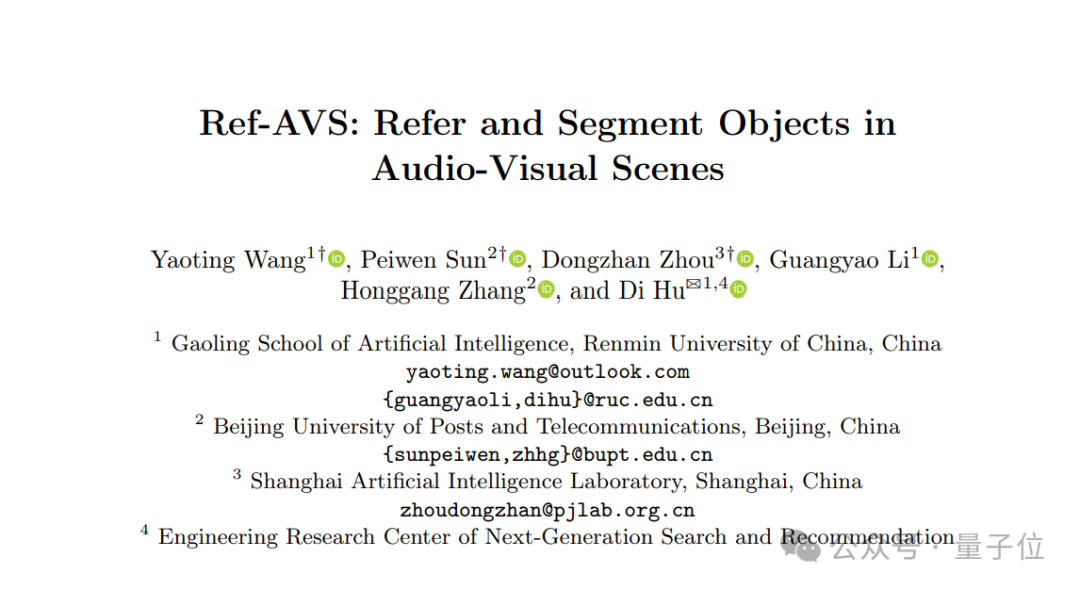

新的最强开源多模态大模型来了!

现有的大模型已经能够创作令人惊叹画作,那鉴赏艺术画作岂不是信手拈来?

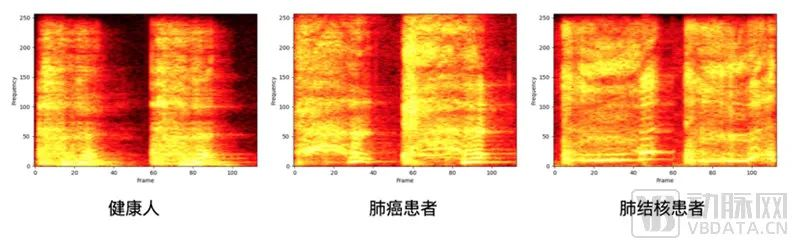

通过患者体内发出的声音“听音辨病”成为现实又近了一步

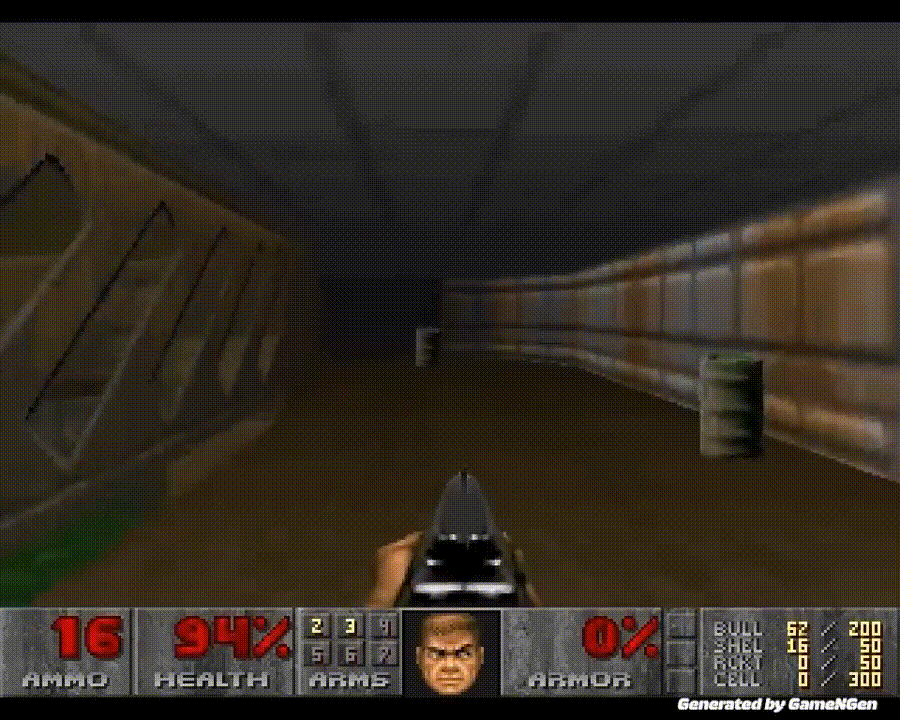

GameNGen 是第一个完全由神经模型驱动的游戏引擎。

本文的主要作者来自香港大学的数据智能实验室 (Data Intelligence Lab@HKU)。

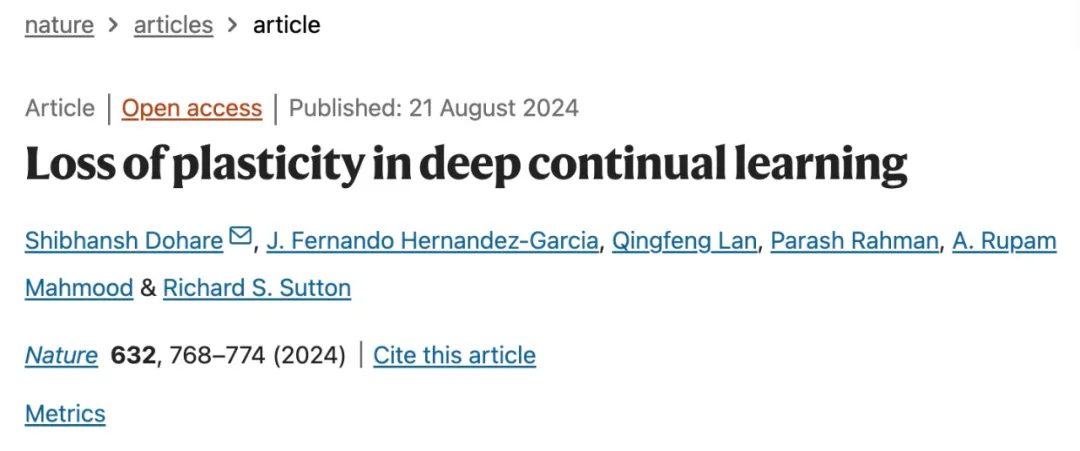

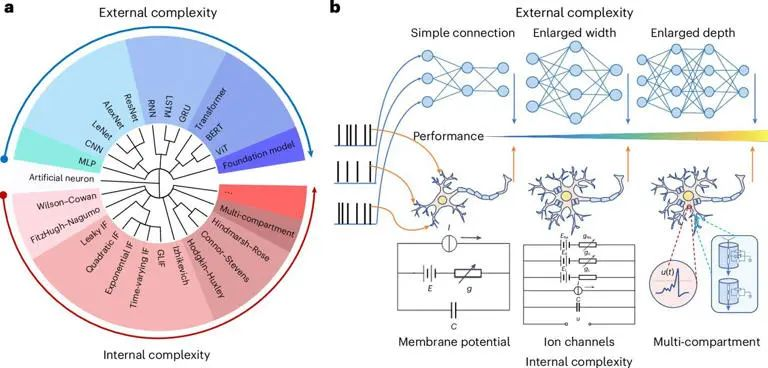

人工神经网络、深度学习方法和反向传播算法构成了现代机器学习和人工智能的基础。但现有方法往往是一个阶段更新网络权重,另一个阶段在使用或评估网络时权重保持不变。这与许多需要持续学习的应用程序形成鲜明对比。

在探索「数学之美」的路上,人工智能到底走到哪一步了?说到这个话题,可能没人比数学家陶哲轩更懂。他几乎是最常用 AI 辅助证明的数学家之一,还在今年的 AI 数学奥林匹克竞赛(AIMO 进步奖)担任了顾问委员。

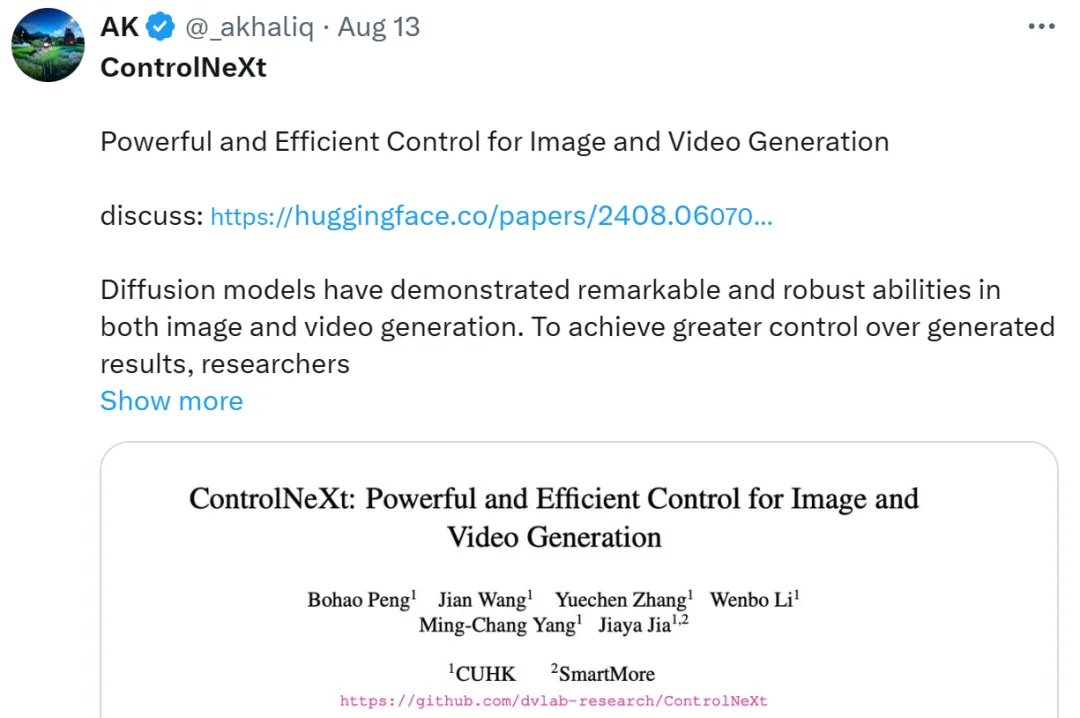

最近,又一款国产 AI 神器吸引了众网友和圈内研究人员的关注!它就是全新的图像和视频生成控制工具 —— ControlNeXt,由思谋科技创始人、港科大讲座教授贾佳亚团队开发。

最近,Meta的多个工程团队联合发表了一篇论文,描述了在引入基于GPU的分布式训练时,他们如何为其「量身定制」专用的数据中心网络。

炸裂!世界上首个完全由AI驱动的游戏引擎来了。谷歌研究者训练的GameNGen,能以每秒20帧实时生成DOOM的游戏画面,画面如此逼真,60%的片段都没让玩家认出是AI!全球2000亿美元的游戏行业,从此将被改变。

AI Agent的机会来了!

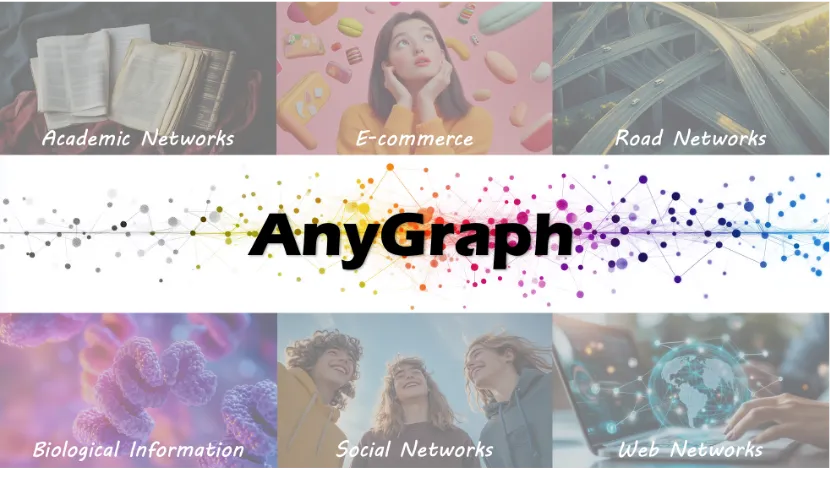

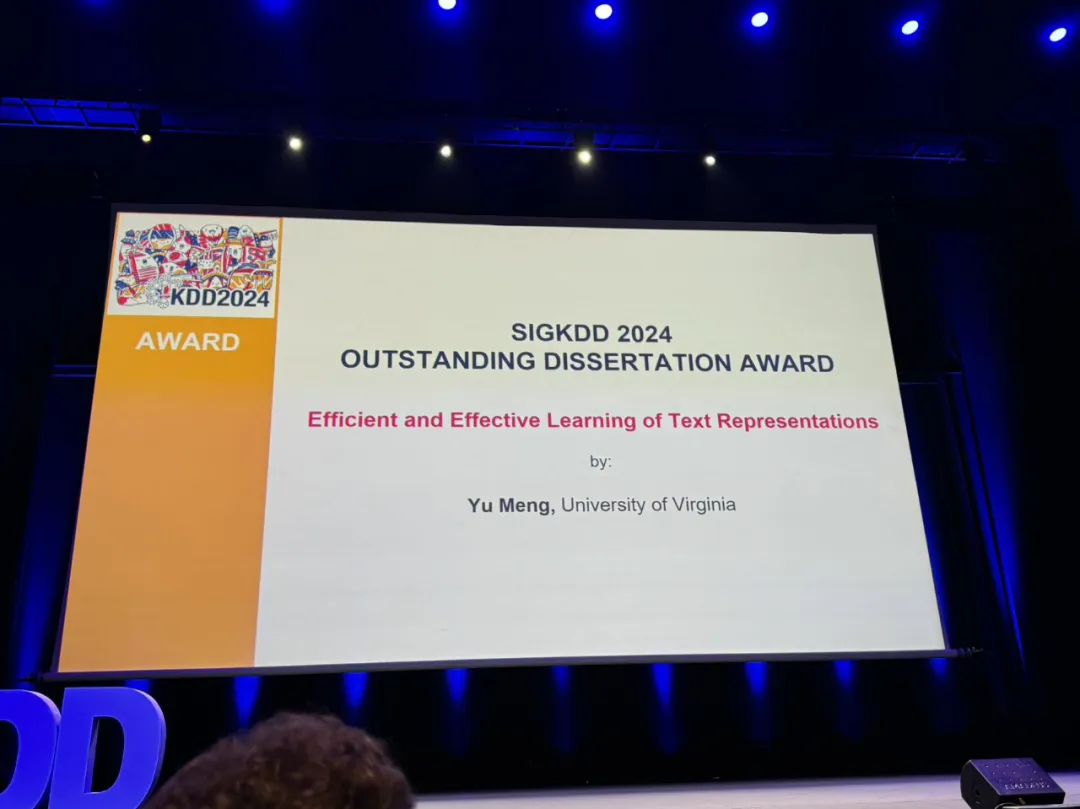

ACM SIGKDD(国际数据挖掘与知识发现大会,KDD) 会议始于 1989 年,是数据挖掘领域历史最悠久、规模最大的国际顶级学术会议,也是首个引入大数据、数据科学、预测分析、众包等概念的会议。

EasyRec利用语言模型的语义理解能力和协同过滤技术,提升了在零样本学习场景下的推荐性能。通过整合用户和物品的文本描述,EasyRec能够生成高质量的语义嵌入,实现个性化且适应性强的推荐。

本文第一作者为牛津大学 Harish Bhaskaran 院士课题组董博维博士。

陶哲轩最新演讲公开,AI含量爆表。

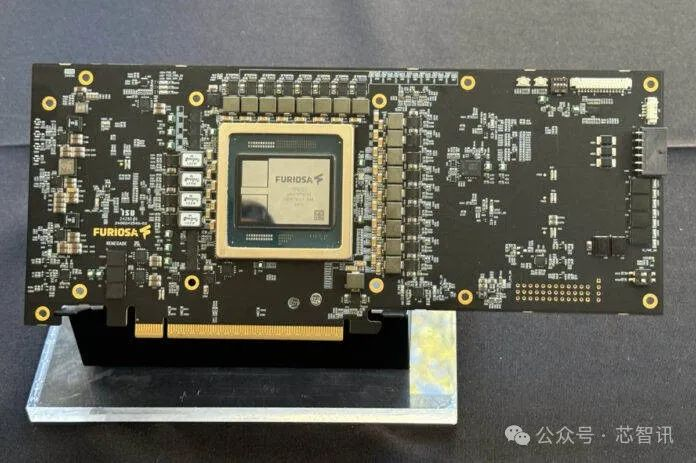

8月27日消息,在近日召开的Hot Chips 2024大会上,韩国AI芯片初创公司FuriosaAI 推出了一款面向高性能大型语言模型和多模态模型推理的高能效数据中心AI加速器 RNGD。

来自复旦大学视觉与学习实验室的研究者们提出了一种新型的面向视频模型的对抗攻击方法 - 基于扩散模型的视频非限制迁移攻击(ReToMe-VA)。该方法采用逐时间步对抗隐变量优化策略,以实现生成对抗样本的空间不可感知性;同时,在生成对抗帧的去噪过程中引入了递归 token 合并策略,通过匹配及合并视频帧之间的自注意力 token,显著提升了对抗视频的迁移性和时序一致性。

AI原生应用正接连不断地快速涌现。但是从产品的数量和社会公众对其认知程度来看,AI原生应用仍处于早期发展阶段,目前业界对于其明确定义、产品范式以及相关商业模式也还无清晰、完整的论述。但是这并不影响我们的判断,即:当前正处在AI原生应用大规模爆发并将深刻影响各行各业的前夜。

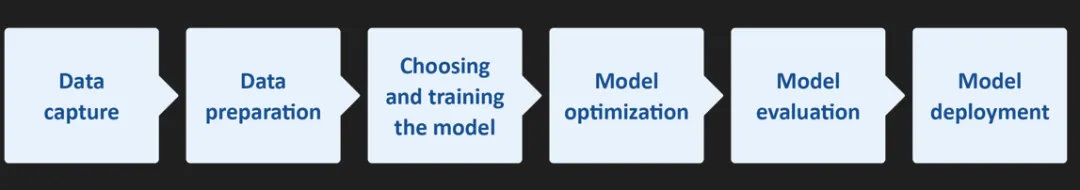

从监控和访问控制到智能工厂和预测性维护,基于机器学习(ML)模型构建的人工智能(AI)在工业物联网边缘处理应用中已变得无处不在。

人工智能,AI,大模型,神经网络

睡觉做梦,大脑实际上会运行一个内部“世界模型”!

本文对AI增强的VR在医疗应用中的技术细节、工作流程和下游应用进行了全面审视,并提出了一个系统性的分类方法,将相关工作分为医学视觉增强、VR医学数据处理和VR辅助干预三个主要类别,为未来跨学科研究提供了基础。

计算机是二进制的世界,所以浮点数也是用二进制来表示的,与整型不同的是,浮点数通过3个区间来表示:

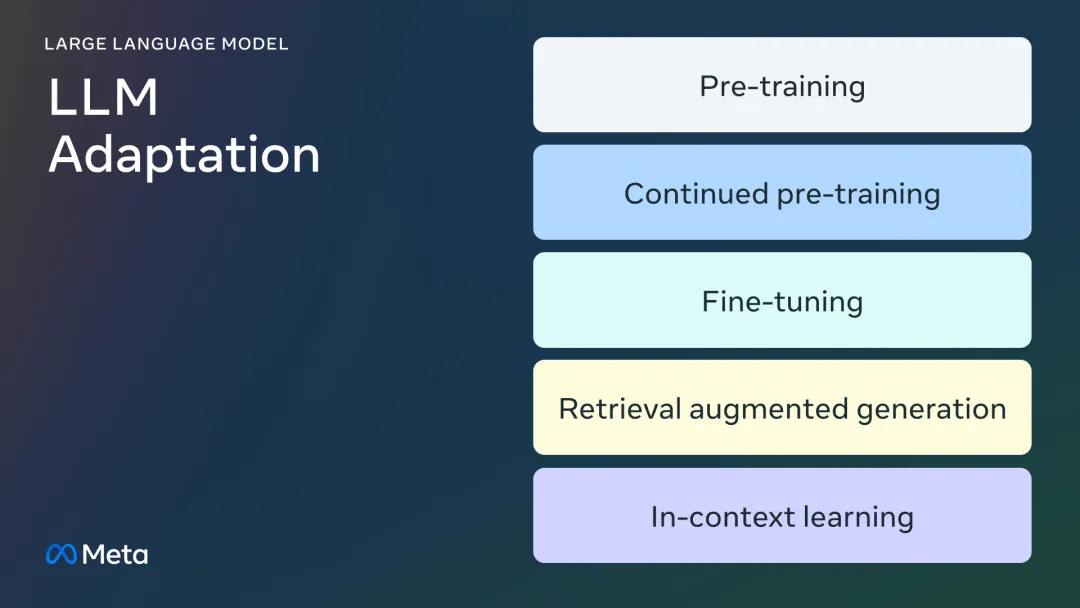

微调的所有门道,都在这里了。

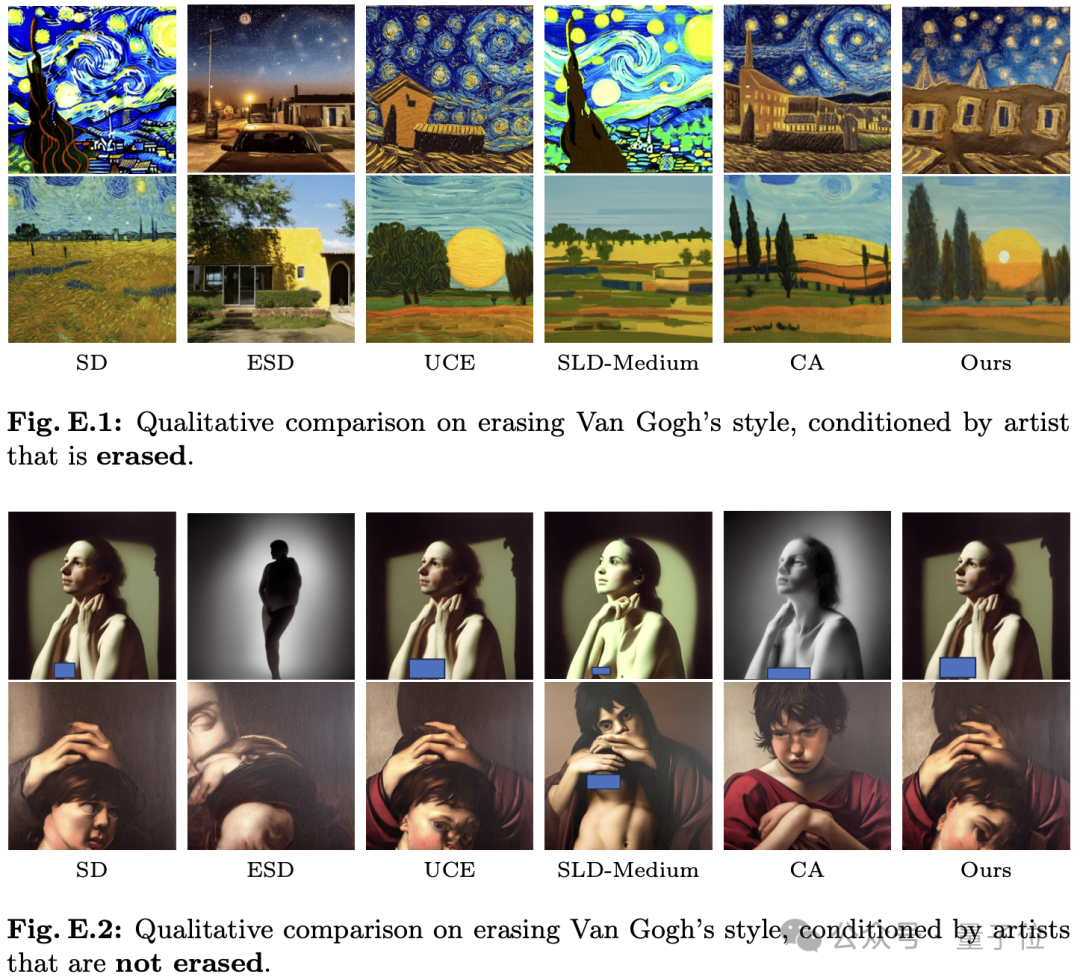

让AI绘画模型变“乖”,现在仅需3秒调整模型参数。

在 ECCV 2024 中,来自南洋理工大学 S-Lab、上海 AI Lab 以及北京大学的研究者提出了一种原生 3D LDM 生成框架。

本文引入了 Transfusion,这是一种可以在离散和连续数据上训练多模态模型的方法。

最近 ACL 2024 论文放榜,扫了下,SMoE(稀疏混合专家)的论文不算多,这里就仔细梳理一下,包括动机、方法、有趣的发现,方便大家不看论文也能了解的七七八八,剩下只需要感兴趣再看就好。

在人工智能领域,图像生成技术一直是一个备受关注的话题。近年来,扩散模型(Diffusion Model)在生成逼真且复杂的图像方面取得了令人瞩目的进展。然而,技术的发展也引发了潜在的安全隐患,比如生成有害内容和侵犯数据版权。这不仅可能对用户造成困扰,还可能涉及法律和伦理问题。