ACL杰出论文奖|GPT-4V暴露致命缺陷?JHU等发布首个多模态ToM 测试集,全面提升大模型心智能力

ACL杰出论文奖|GPT-4V暴露致命缺陷?JHU等发布首个多模态ToM 测试集,全面提升大模型心智能力本文第一作者为 Chuanyang Jin (金川杨),本科毕业于纽约大学,即将前往 JHU 读博。本文为他本科期间在 MIT 访问时的工作,他是最年轻的杰出论文奖获得者之一。

本文第一作者为 Chuanyang Jin (金川杨),本科毕业于纽约大学,即将前往 JHU 读博。本文为他本科期间在 MIT 访问时的工作,他是最年轻的杰出论文奖获得者之一。

不必增加模型参数,计算资源相同,小模型性能超过比它大14倍的模型!

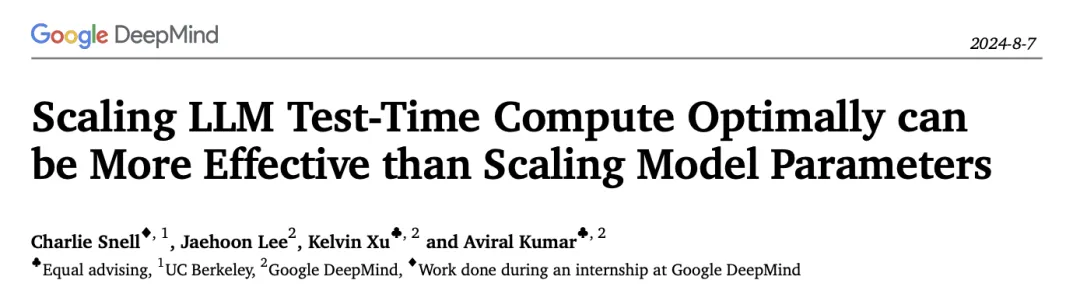

大模型基准测试还能信吗?

更好的效果,更低的价格,听起来是不是像梦呓?

端云结合是长期状态

今年 6 月,高盛曾发布一份名为《GEN AI: TOO MUCH SPEND, TOO LITTLE BENEFIT?》报告,高盛策略师 Peter Oppenheimer 及其团队近日发布了该系列最新观察,旨在更深入地理解所谓的“科技的理性繁荣”。

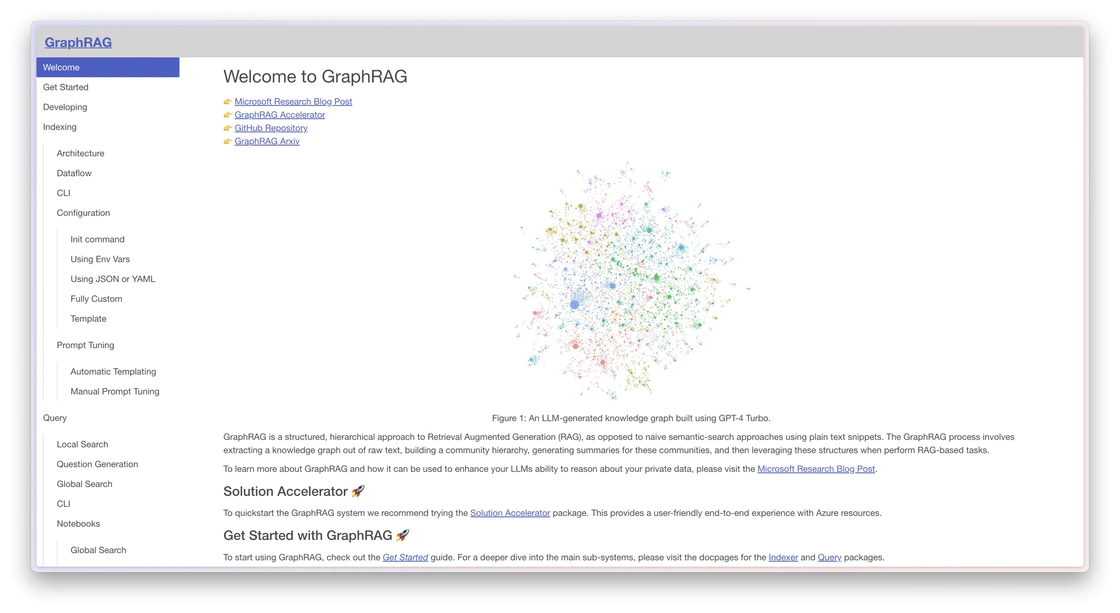

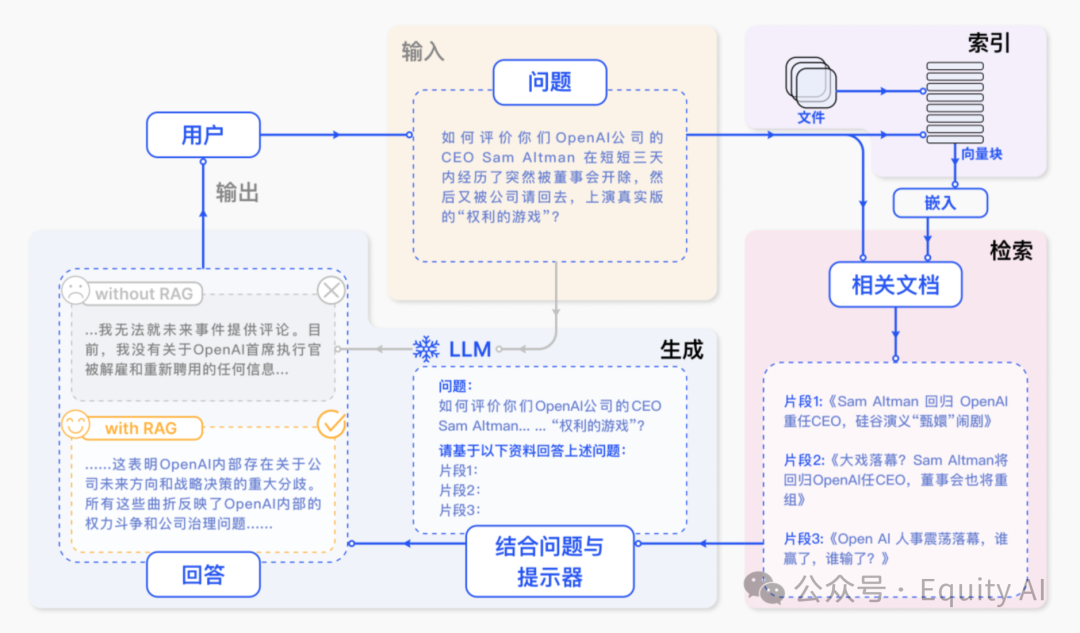

上篇已经详细介绍了AI使用知识库进行时到底发生了什么

在把AI大模型能力接入微信后,发现很多朋友想要落地在类似客服的应用场景。但目前大模型存在幻觉,一不留神就胡乱回答,这在严肃的商用场景下是不可接受的。

张大鹏,加拿大皇家科学院院士,加拿大工程院院士,国际电气与电子工程师协会终身会士(IEEE Fellow),国际模式识别协会会士,亚太人工智能学会会士,香港中文大学(深圳)数据科学学院校长学勤讲座教授,深圳市人工智能与机器人研究院(AIRS)计算机视觉研究中心主任,香港中文大学(深圳)—联易融计算机视觉与人工智能联合实验室主任,以及香港理工大学荣誉教授。

本文作者来自于清华大学电子工程系,北京大学人工智能研究院、第四范式、腾讯和清华-伯克利深圳学院。其中第一作者张瑞泽为清华大学硕士,主要研究方向为博弈算法。通讯作者为清华大学电子工程系汪玉教授、于超博后和第四范式研究员黄世宇博士。

论文共同第一作者郑淼,来自于周泽南领导的百川对齐团队,毕业于北京大学,研究方向包括大语言模型、多模态学习以及计算机视觉等,曾主导MMFlow等开源项目。

与 Text2SQL 或 RAG 不同,TAG 充分利用了数据库系统和 LLM 的功能。

人工设计提示词太麻烦了!想过让 LLM 帮你设计用于 LLM 的提示词吗?

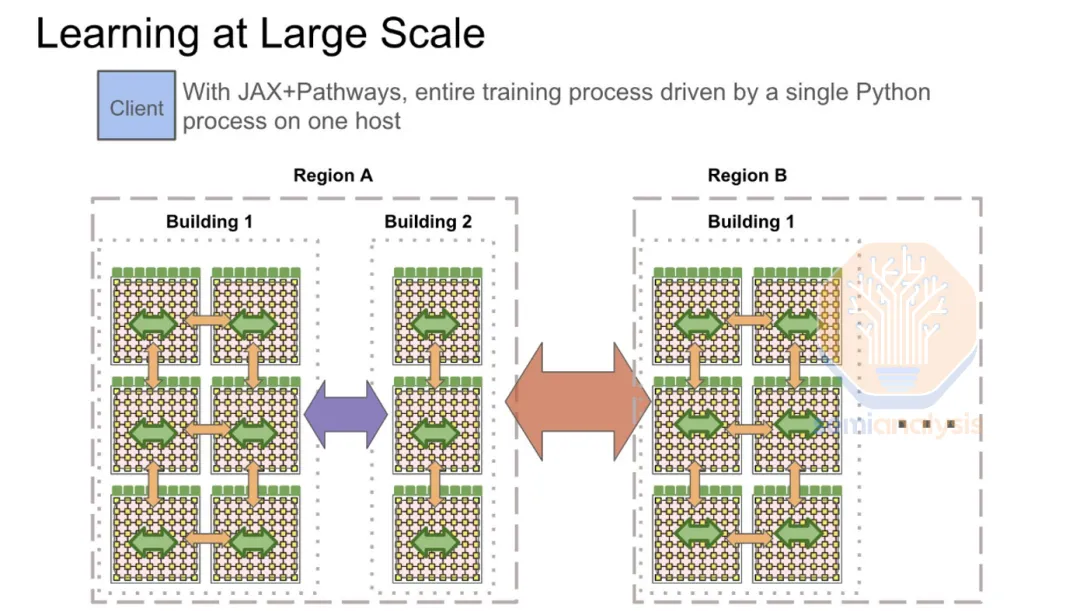

最近,国外的一份研究报告揭秘了 OpenAI、围绕和谷歌在 AI Infra 层的布局,我们将文章提炼出了核心观点,并进行精校翻译。

DeepMind又闷声放大招了!

之前已经分享过一次AI领域GitHub上那些神级项目,大家可以回顾下这篇文章《震撼来袭,盘点GitHub上那些免费的神级AI项目,建议立刻收藏!》。但是AI发展那么迅速,所以今天继续来给大家盘点一下近期在Github上,AI领域又有哪些神级的项目,最后一个特别推荐。

基于已有配体来开发新分子, 药效会更好吗?

本次展会为广大人工智能企业、高校科研机构搭建技术交流、深化产业合作的重要平台,构筑供需对接、场景牵引的产业生态。

在大模型对话框之外,DeepMind 始终坚持做一些独特的工作。

近日,上海交通大学、上海人工智能实验室和上海交通大学附属瑞金医院联合团队发布基于异常检测预训练的心电长尾诊断模型。

近日,来自小红书的技术团队 FireRed,提出了基于大语言模型的 FireRedTTS 语音合成系统,并分享了在短视频配音及聊天式语音对话等应用的一些实践。

免训练多模态分割领域有了新突破!

提示工程师Riley Goodside小哥,依然在用「Strawberry里有几个r」折磨大模型们,GPT-4o在无限次PUA后,已经被原地逼疯!相比之下,Claude坚决拒绝PUA,是个大聪明。而谷歌最近的论文也揭示了本质原因:LLM没有足够空间,来存储计数向量。

今天,DeepMind又发布了Alpha模型家族的新成员,堪称是「专精版」的AlphaFold,专注于设计蛋白质结合剂,将大幅减少所需的实验室工作,提升开发效率。

用英伟达的GPU,但可以不用CUDA?PyTorch官宣,借助OpenAI开发的Triton语言编写内核来加速LLM推理,可以实现和CUDA类似甚至更佳的性能。

Nature子刊新研究「大脑时钟」可以判断一个人的大脑衰老速度是否快于实际年龄。结果显示,女性、不平等现象严重的国家和拉丁美洲国家的人,大脑衰老速度更快。

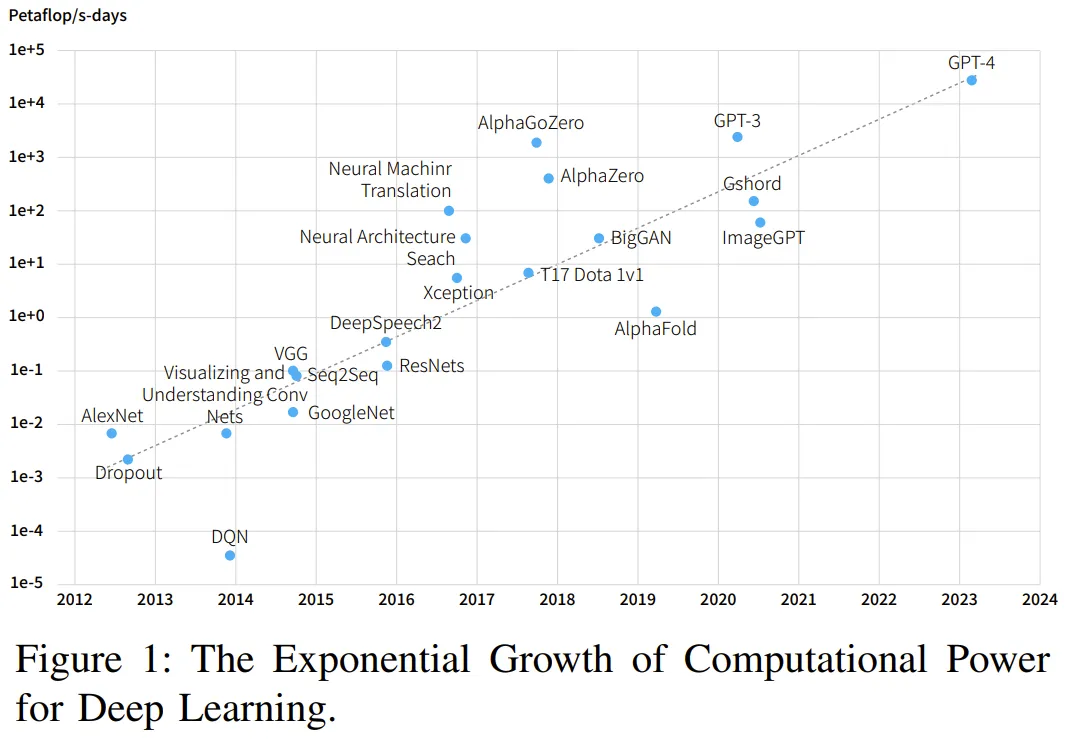

硬件发展速度跟不上 AI 需求,就需要精妙的架构和算法。

本文出自启元世界多模态算法组,共同一作是来自清华大学的一年级硕士生谢之非与启元世界多模态负责人吴昌桥,研究兴趣为多模态大模型、LLM Agents 等。本论文上线几天内在 github 上斩获 1000+ 星标。

视频理解仍然是计算机视觉和人工智能领域的一个主要挑战。最近在视频理解上的许多进展都是通过端到端地训练多模态大语言模型实现的[1,2,3]。然而,当这些模型处理较长的视频时,内存消耗可能会显著增加,甚至变得难以承受,并且自注意力机制有时可能难以捕捉长程关系 [4]。这些问题阻碍了将端到端模型进一步应用于视频理解。

近日,由北京大学人工智能研究院杨耀东课题组牵头完成的研究成果 ——「大规模多智能体系统的高效强化学习」在人工智能顶级学术期刊 Nature Machine Intelligence 上发表。