AI版《黑客帝国》:无限生成逼真视频,3A画质,还能实时交互

AI版《黑客帝国》:无限生成逼真视频,3A画质,还能实时交互人类离电影《黑客帝国》的场景,似乎又近了一步。

人类离电影《黑客帝国》的场景,似乎又近了一步。

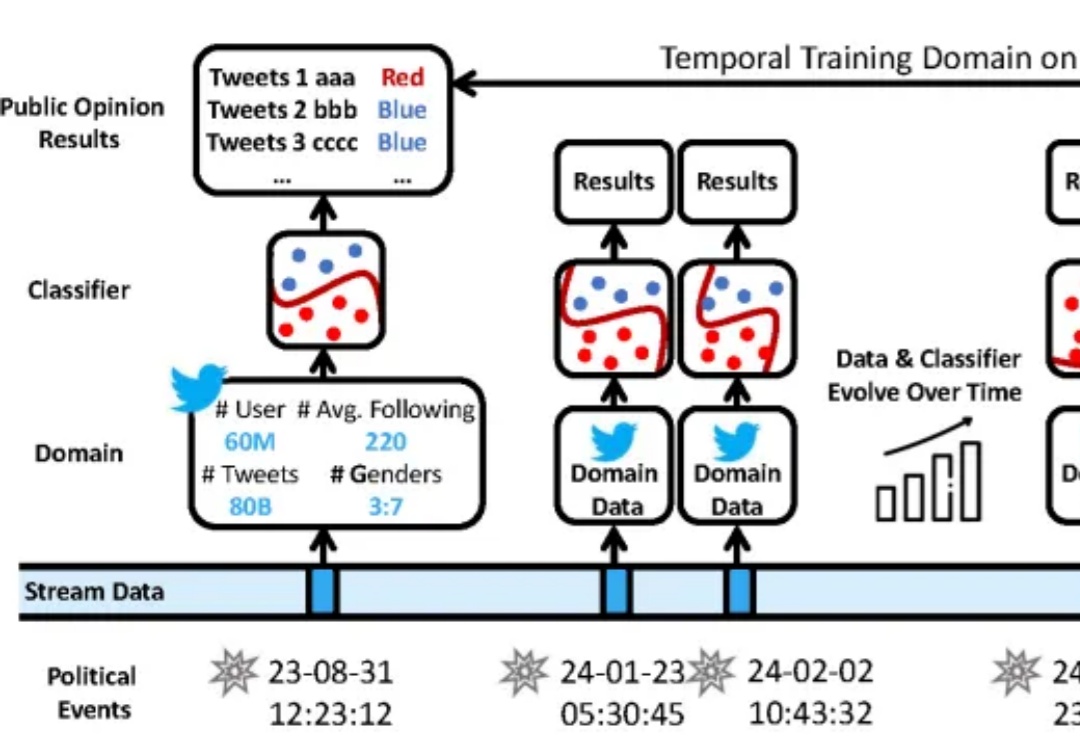

在数据分布持续变化的动态环境中,如何进行连续模型泛化?

近日,来自斯坦福、MIT等机构的研究人员推出了低秩线性转换方法,让传统注意力无缝转移到线性注意力,仅需0.2%的参数更新即可恢复精度,405B大模型两天搞定!

新的大语言模型(LLM)评估基准对于跟上大语言模型的快速发展至关重要。

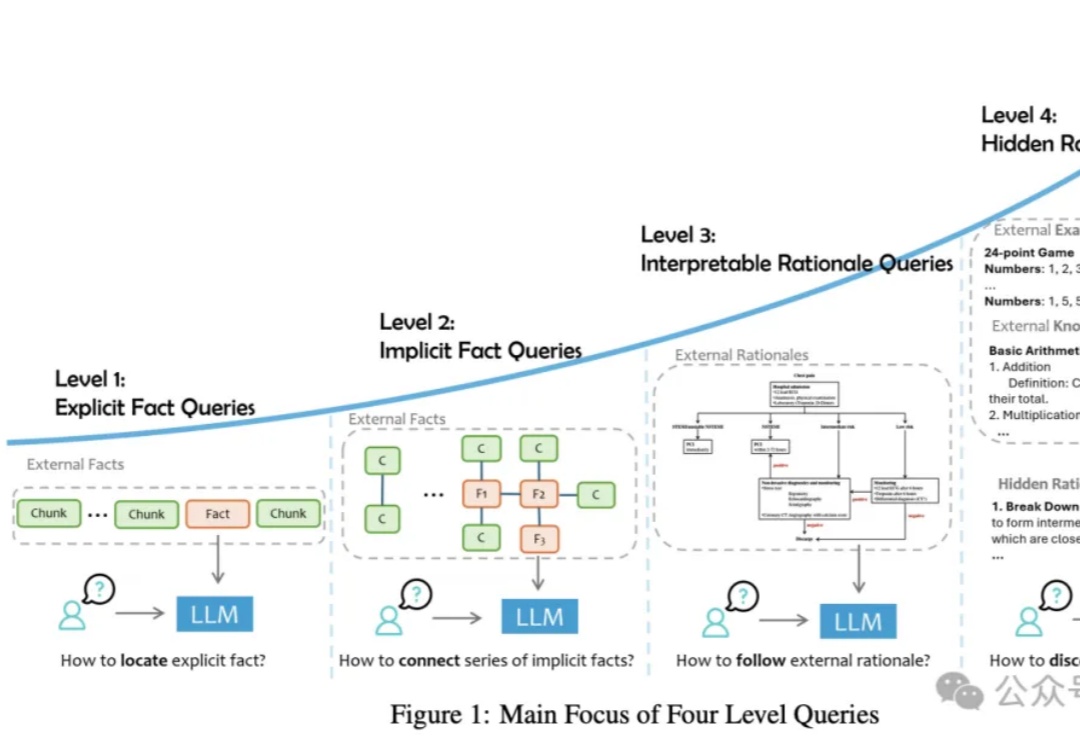

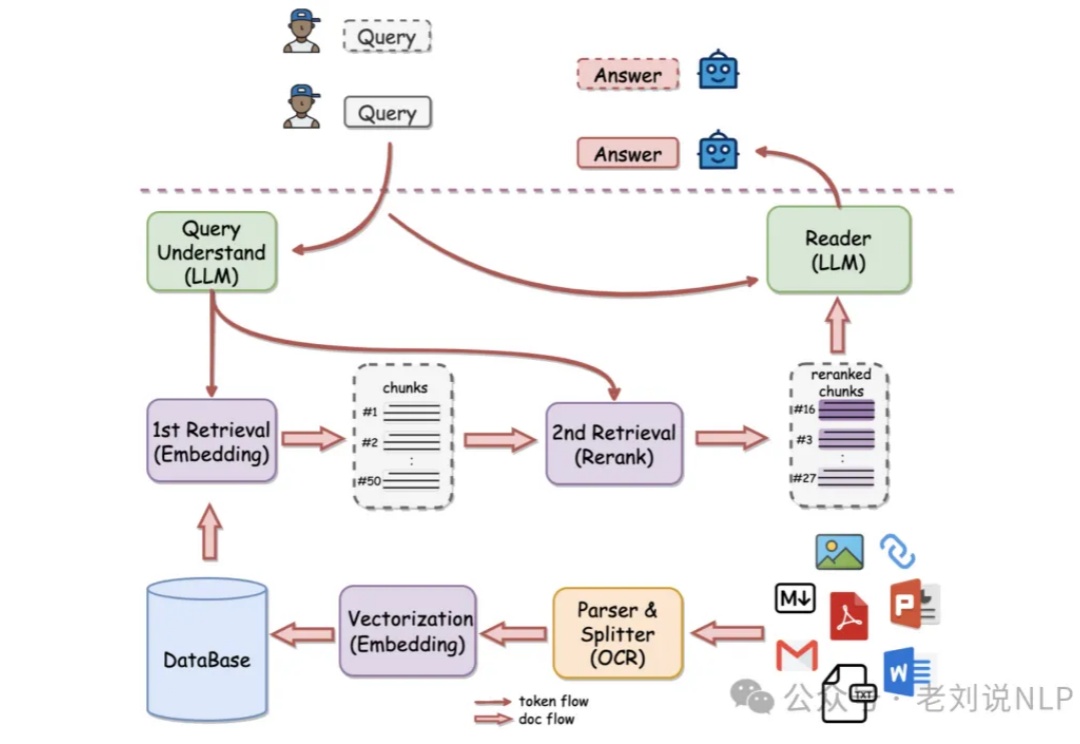

论文提出了一种RAG任务分类法,将用户查询分为四个级别,并讨论了将外部数据集成到LLMs中的三种主要方式。从简单的事实检索到复杂的推理任务,每个级别都有其独特的难点和解决方案,需要不同的技术和方法来优化性能。

大模型的执行力从哪里来?

“赛博螺丝工”解放双手的时刻来了!

关于产业进展,代码辅助工具,PearAI ,https://trypear.ai/,提供了代码自动生成、智能代码预测、代码编辑聊天、代码记忆提升、智能代码搜索等功能,还内置了Perplexity、Memo等其他AI工具,这其实加剧了如cursor等同质产品的竞争。

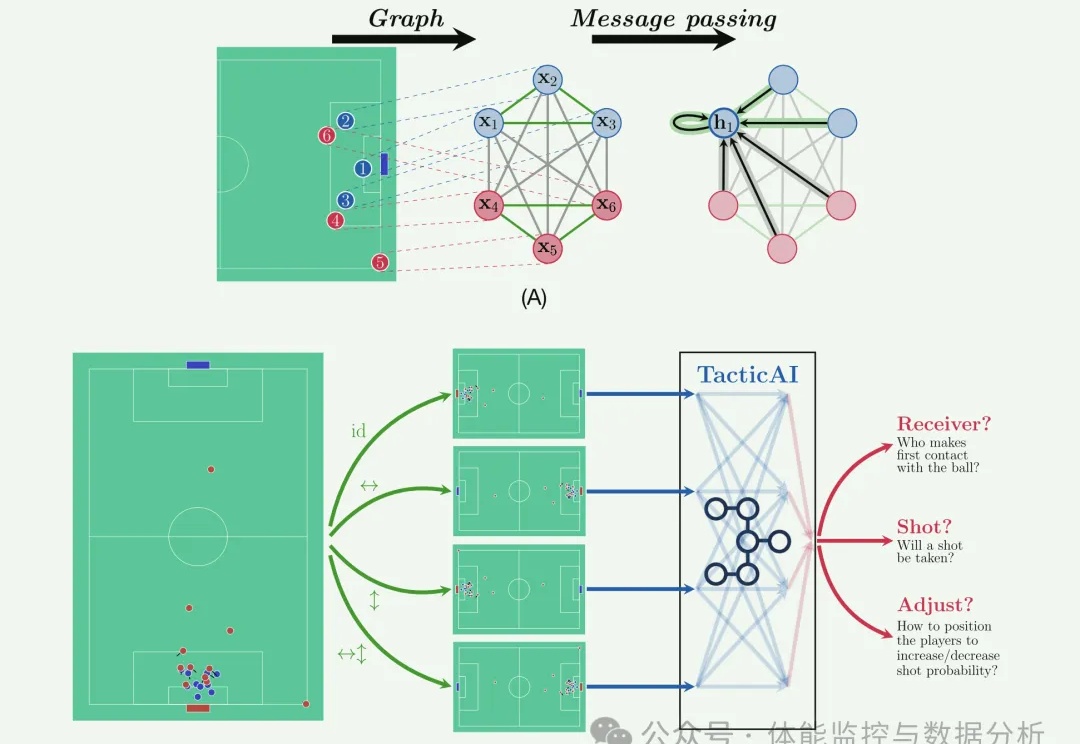

识别对手球队实施的关键战术模式并制定有效的应对措施是现代足球的核心。 然而,通过算法实现这一点仍然是一个开放的研究挑战。 为了解决这一未满足的需求,我们提出了 TacticAI,这是一款与利物浦足球俱乐部领域专家密切合作开发和评估的人工智能足球战术助手。

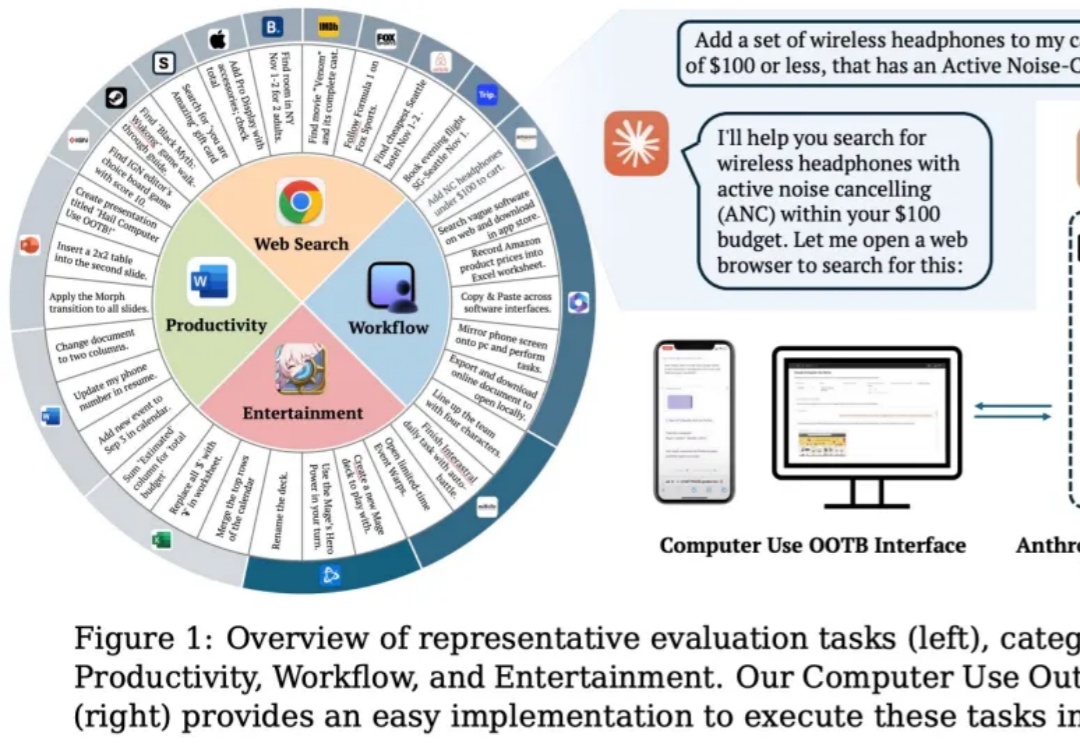

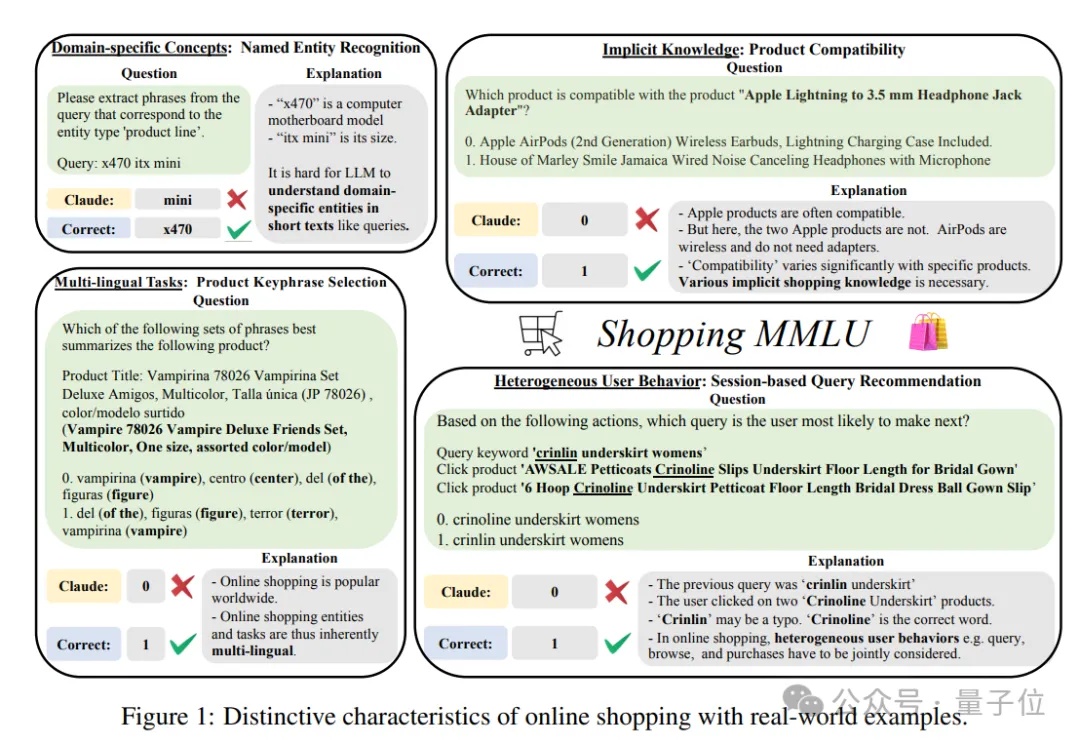

谁是在线购物领域最强大模型?也有评测基准了。

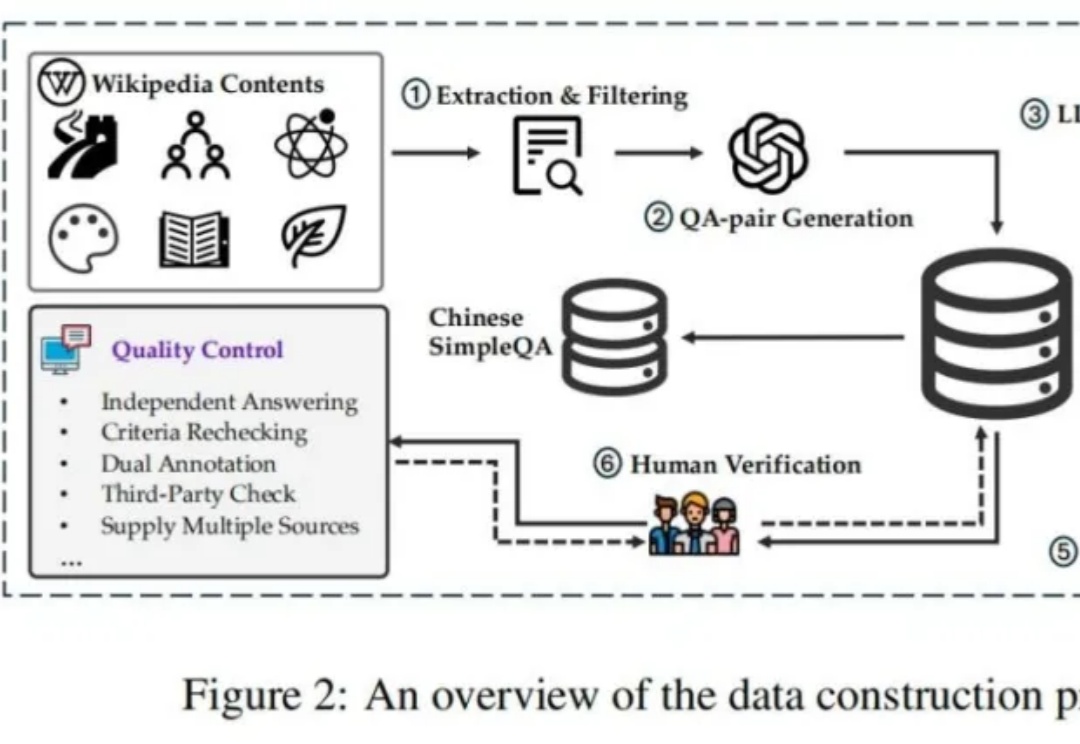

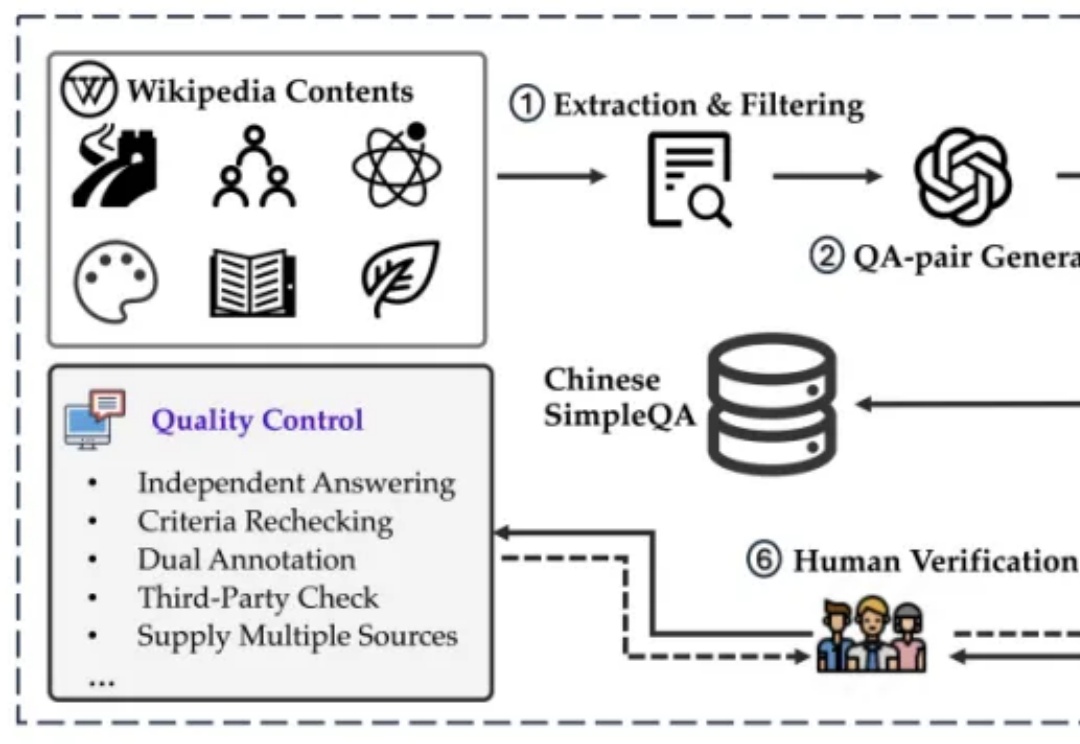

如何解决模型生成幻觉一直是人工智能(AI)领域的一个悬而未解的问题。为了测量语言模型的事实正确性,近期 OpenAI 发布并开源了一个名为 SimpleQA 的评测集。而我们也同样一直在关注模型事实正确性这一领域,目前该领域存在数据过时、评测不准和覆盖不全等问题。例如现在大家广泛使用的知识评测集还是 CommonSenseQA、CMMLU 和 C-Eval 等选择题形式的评测集。

近年来,AI for Science 发展提速,不仅为科研领域带来创新研究思路,同时也拓宽了 AI 的落地通路,为其提供了更多具有挑战性的应用场景。在这个过程中,越来越多的 AI 领域研究人员开始关注医疗、材料、生物等传统科研领域,探索其中的研究难点与行业挑战。

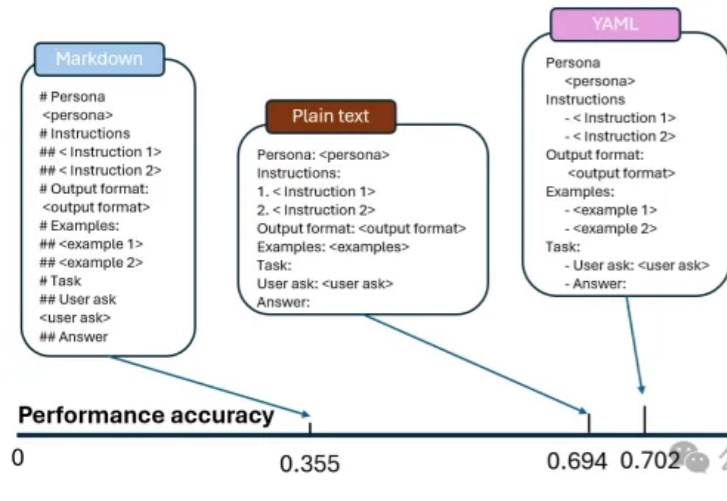

朋友们,想了解为什么同一模型会带来大量结果的不一致性吗?今天,我们来一起深入分析一下来自微软和麻省理工学院的一项重大发现——不同的Prompt格式如何显著影响LLM的输出精度。这些研究结果对于应用Prompt优化设计具有非常重要的应用价值。

1966年,首个AI精神健康聊天机器人Eliza问世,作为一种简单的自然语言处理程序,它模拟了心理治疗师的对话风格,标志着AI在心理健康领域应用的起点。

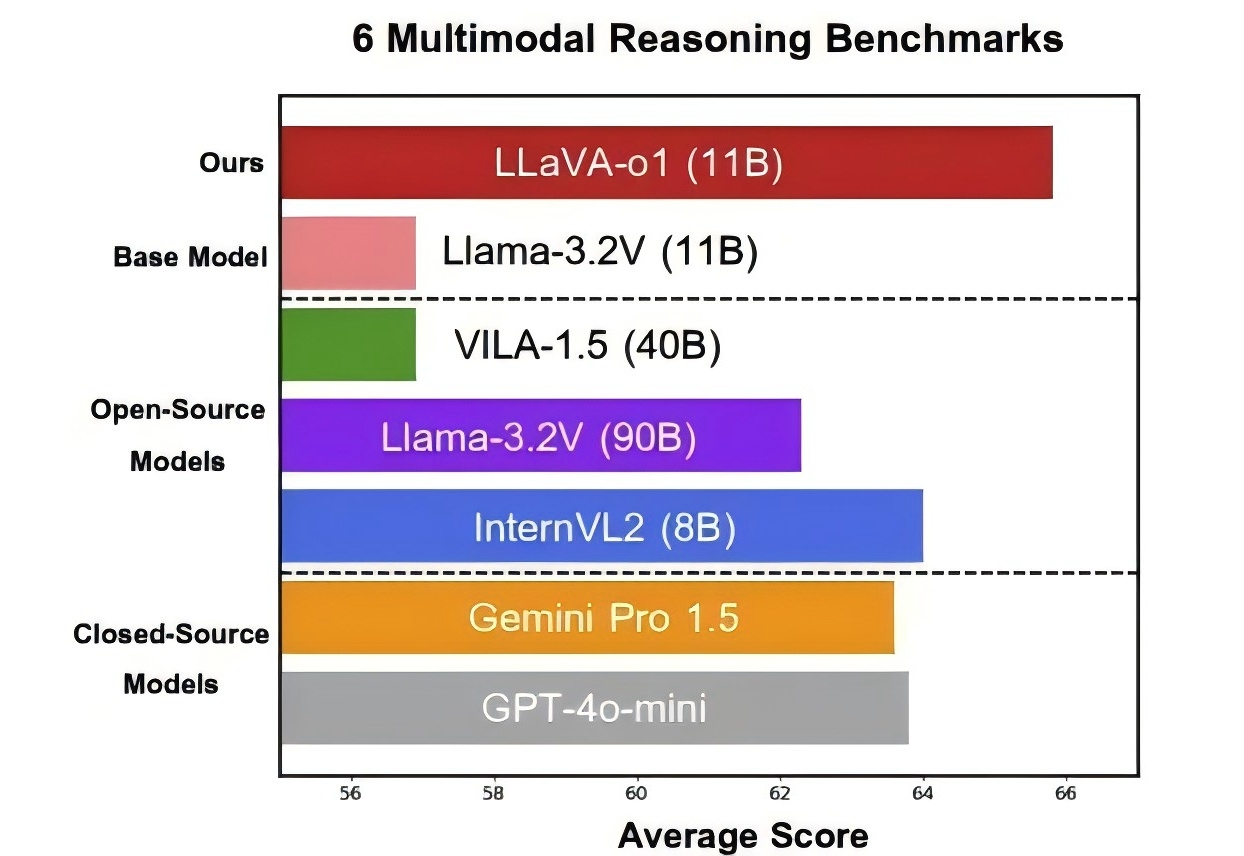

北大等出品,首个多模态版o1开源模型来了—— 代号LLaVA-o1,基于Llama-3.2-Vision模型打造,超越传统思维链提示,实现自主“慢思考”推理。 在多模态推理基准测试中,LLaVA-o1超越其基础模型8.9%,并在性能上超越了一众开闭源模型。

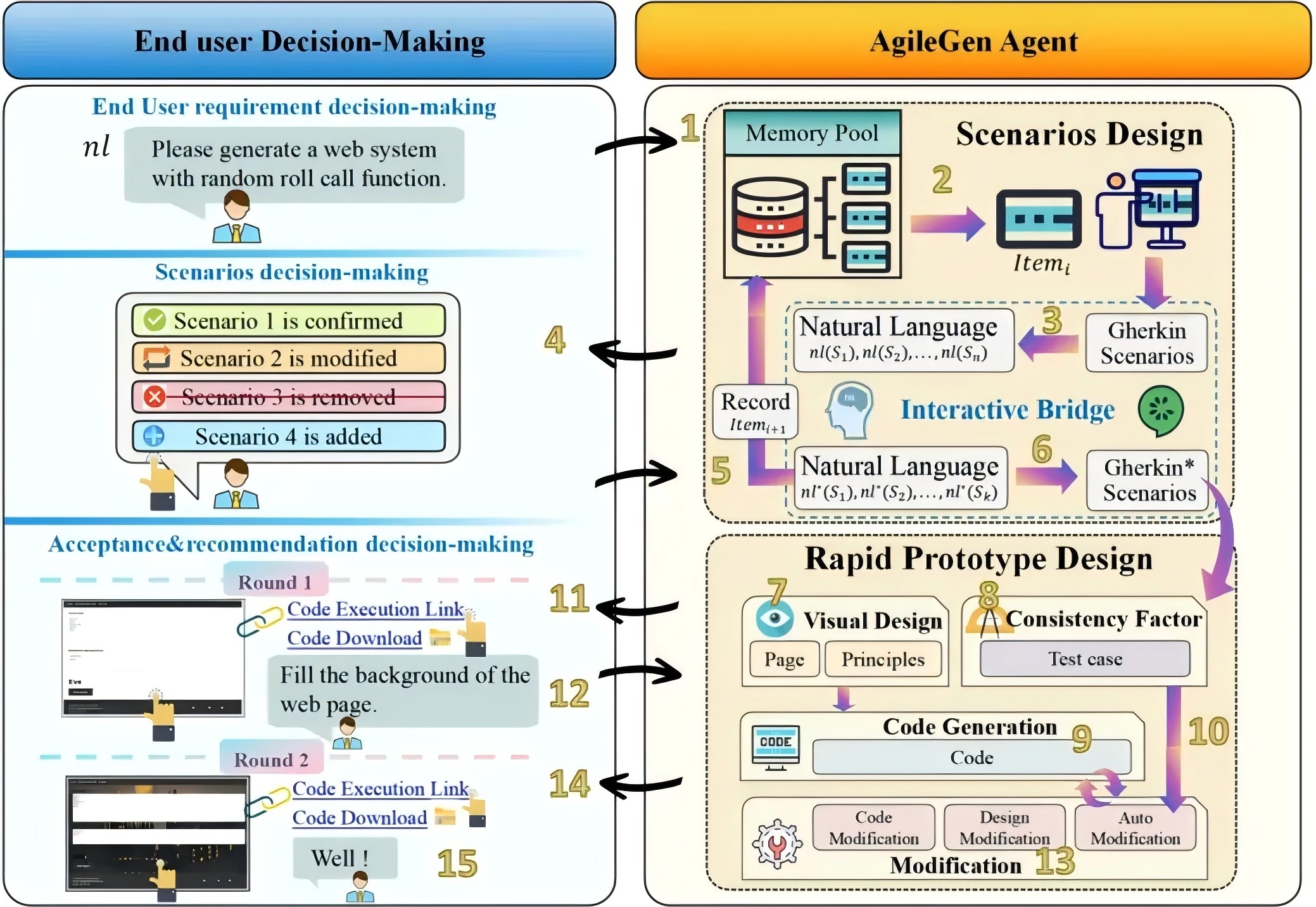

我们即将介绍的 AgileGen— 一种基于人机协作的敏捷生成式软件开发框架。

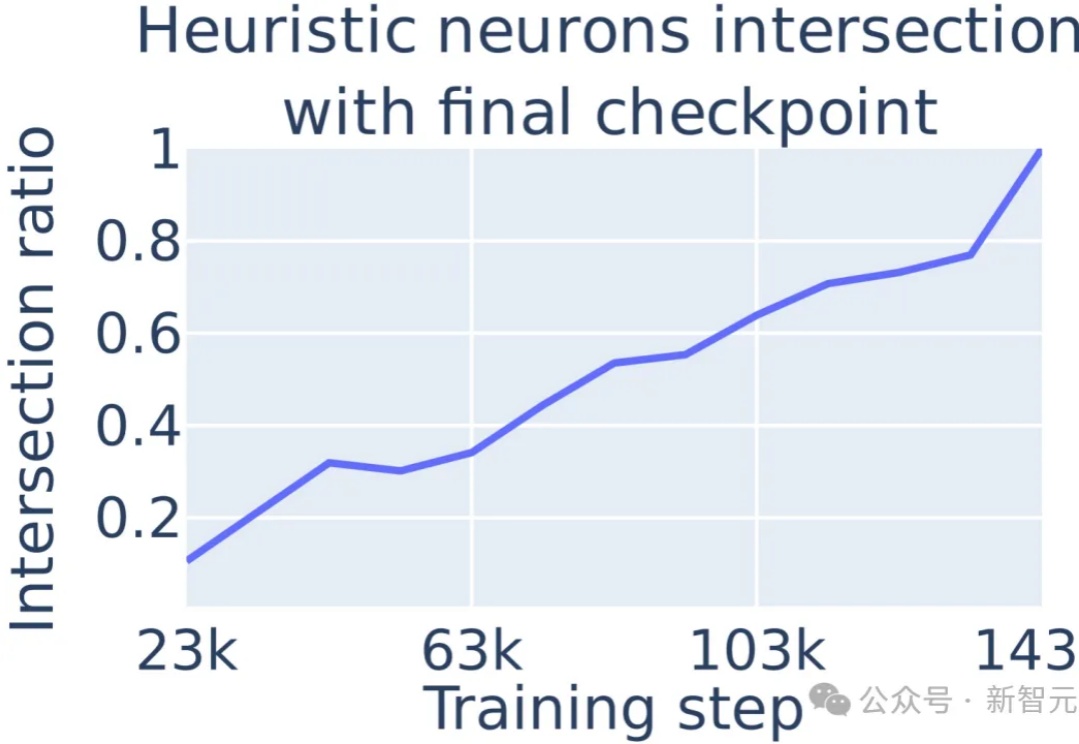

大模型在数学问题上的表现不佳,原因在于采取启发式算法进行数学运算的,通过定位到多层感知机(MLP)中的单个神经元,可以对进行数学运算的具体过程进行解释。

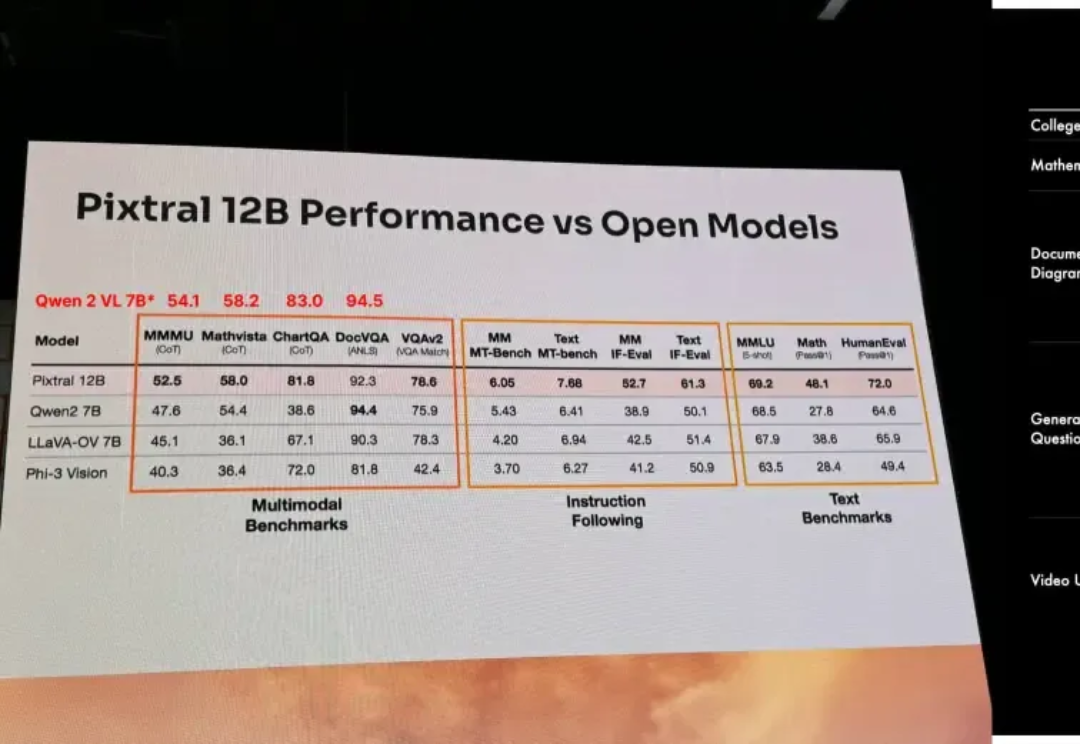

以开源极客之姿杀入江湖的Mistral AI,在9月份甩出了自家的首款多模态大模型Pixtral 12B,如今,报告之期已至,技术细节全公开。

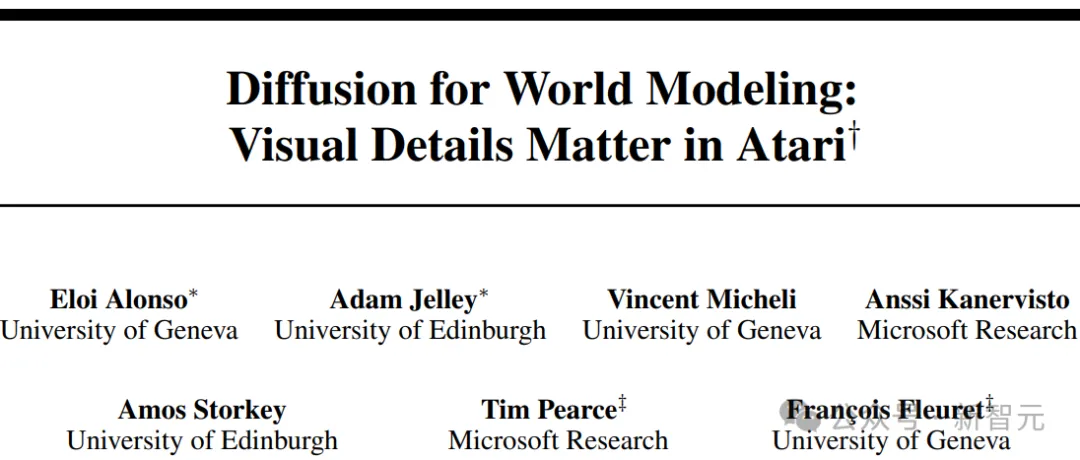

DIAMOND是一种新型的强化学习智能体,在一个由扩散模型构建的虚拟世界中进行训练,能够以更高效率学习和掌握各种任务。在Atari 100k基准测试中,DIAMOND的平均得分超越了人类玩家,证明了其在模拟复杂环境中处理细节和进行决策的能力。

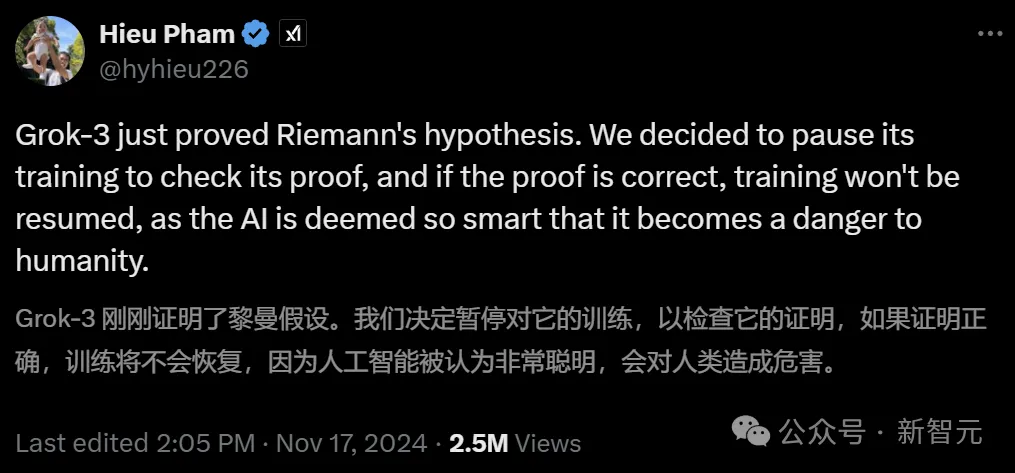

最近,大家都被这条消息吓到了:传说Grok 3已经成功证明出黎曼猜想?!虽然这是在玩梗,但还是让我们来仔细剖析下,目前的AI距离千禧年数学难题,究竟还有多远。

自我纠错(Self Correction)能力,传统上被视为人类特有的特征,正越来越多地在人工智能领域,尤其是大型语言模型(LLMs)中得到广泛应用,最近爆火的OpenAI o1模型[1]和Reflection 70B模型[2]都采取了自我纠正的方法。

大模型发展了这么久,AI 智能体们早就开始整顿职场了。

如今,机器人学习最大的瓶颈是缺乏数据。与图片和文字相比,机器人的学习数据非常稀少。目前机器人学科的主流方向是通过扩大真实世界中的数据收集来尝试实现通用具身智能,但是和其他的基础模型,比如初版的 StableDiffusion 相比,即使是 pi 的数据都会少七八个数量级。

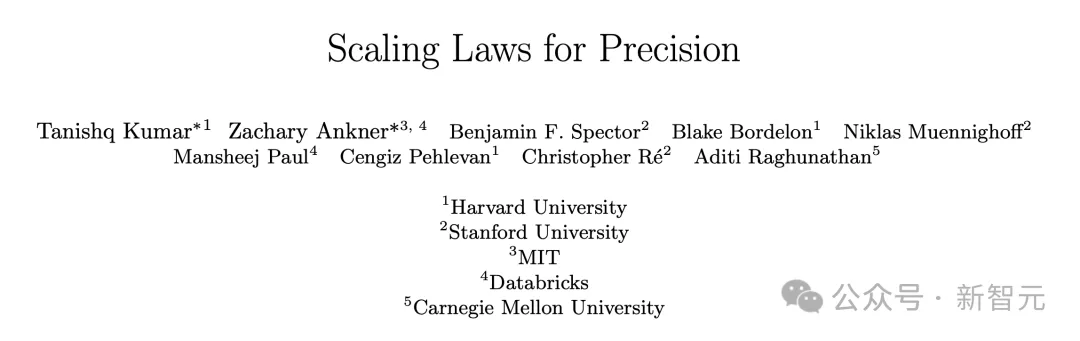

在现代 AI 模型的快速迭代中,如何在保持模型精度的同时提升计算效率成为关键课题。尤其在大规模 AI 推理中,非结构化稀疏矩阵的计算效率低下成为难以突破的瓶颈。面对这一挑战,我们自主研发了 CROSS—— 一种创新的端到端稀疏编译优化方案,为 AI 推理带来细粒度稀疏计算的加速效果。

哈佛斯坦福MIT等机构首次提出「精度感知」scaling law,揭示了精度、参数规模、数据量之间的统一关系。数据量增加,模型对量化精度要求随之提高,这预示着AI领域低精度加速的时代即将结束!

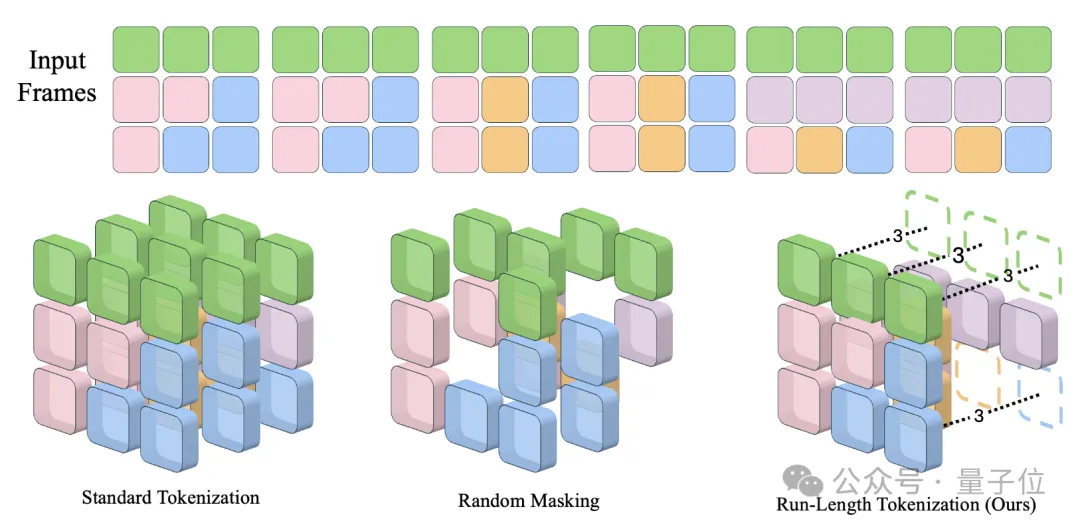

卡内基梅隆大学提出了视频生成模型加速方法Run-Length Tokenization(RLT),被NeurIPS 2024选为Spotlight论文。 在精度几乎没有损失的前提下,RLT可以让模型训练和推理速度双双提升。

4-bit量化,能让现有反学习/机器遗忘技术失灵!

真・覆盖当前 AI 领域 90% 重要知识。

最近,Nature上的一项研究,全面驳斥了LLM具有类人推理能力的说法。研究者设定的「人类亲吻难题」把7个大模型彻底绕晕。最终研究者表示,与其说LLM是科学理论,不如说它们更接近工具,比如广义导数。

通过过程奖励模型(PRM)在每一步提供反馈,并使用过程优势验证器(PAV)来预测进展,从而优化基础策略,该方法在测试时搜索和在线强化学习中显示出比传统方法更高的准确性和计算效率,显著提升了解决复杂问题的能力。