清华新VLA框架加速破解具身智能止步实验室“魔咒”,LLM开销节省4-6倍 | NeurIPS'24

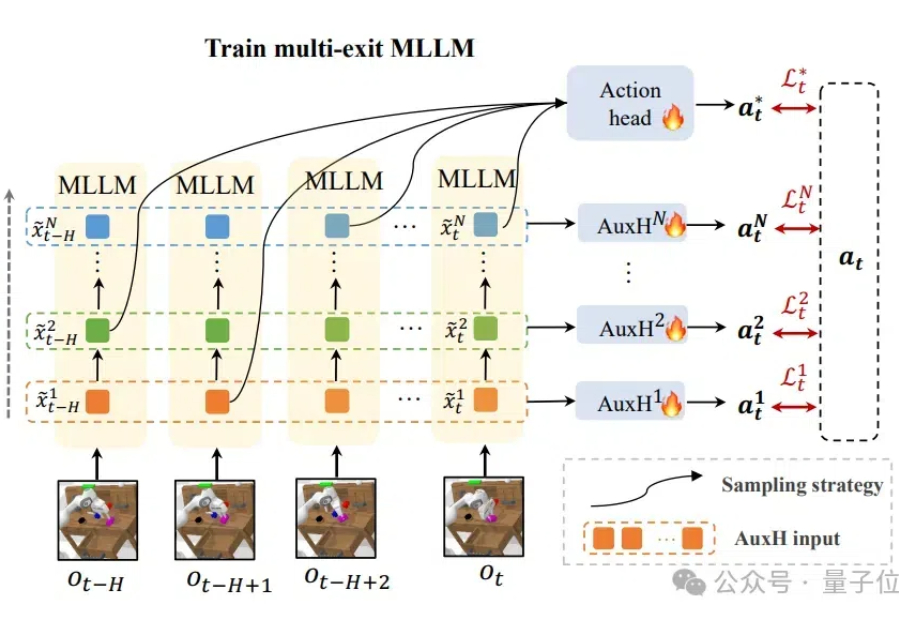

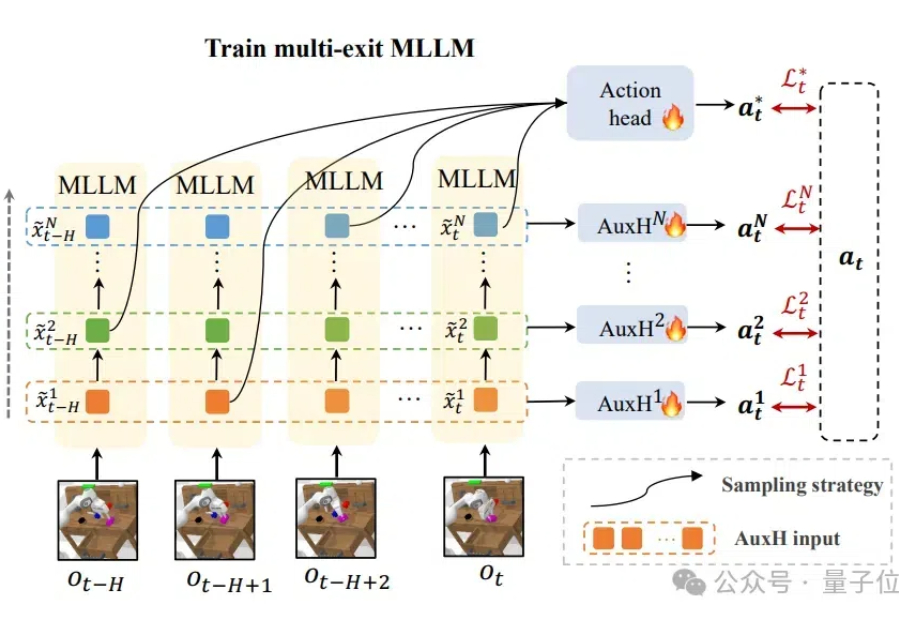

清华新VLA框架加速破解具身智能止步实验室“魔咒”,LLM开销节省4-6倍 | NeurIPS'24计算、存储消耗高,机器人使用多模态模型的障碍被解决了! 来自清华大学的研究者们设计了DeeR-VLA框架,一种适用于VLA的“动态推理”框架,能将LLM部分的相关计算、内存开销平均降低4-6倍。

计算、存储消耗高,机器人使用多模态模型的障碍被解决了! 来自清华大学的研究者们设计了DeeR-VLA框架,一种适用于VLA的“动态推理”框架,能将LLM部分的相关计算、内存开销平均降低4-6倍。

当前,生成式AI正席卷整个社会,大语言模型(LLMs)在文本(ChatGPT)和图像(DALL-E)生成方面取得了令人惊叹的成就,仅仅依赖零星几个提示词,它们就能生成超出预期的内容

一家总部位于美国加州的初创公司Tilde,正在构建解释器模型,解读模型的推理过程,并通过引导采样动态调整生成策略,提升大语言模型的推理能力和生成精度。相比直接优化提示的提示工程,这一方法展现出更灵活高效的潜力,有望重塑AI交互方式。

最近,上海 AI Lab、CAMEL-AI.org、大连理工大学、牛津大学、马普所等国内外多家机构联合发布了一个名为 OASIS 的百万级智能体交互开源项目。

BlueLM-V-3B 是一款由 vivo AI 研究院与香港中文大学联合研发的端侧多模态模型。该模型现已完成对天玑 9300 和 9400 芯片的初步适配,未来将逐步推出手机端应用,为用户带来更智能、更便捷的体验。

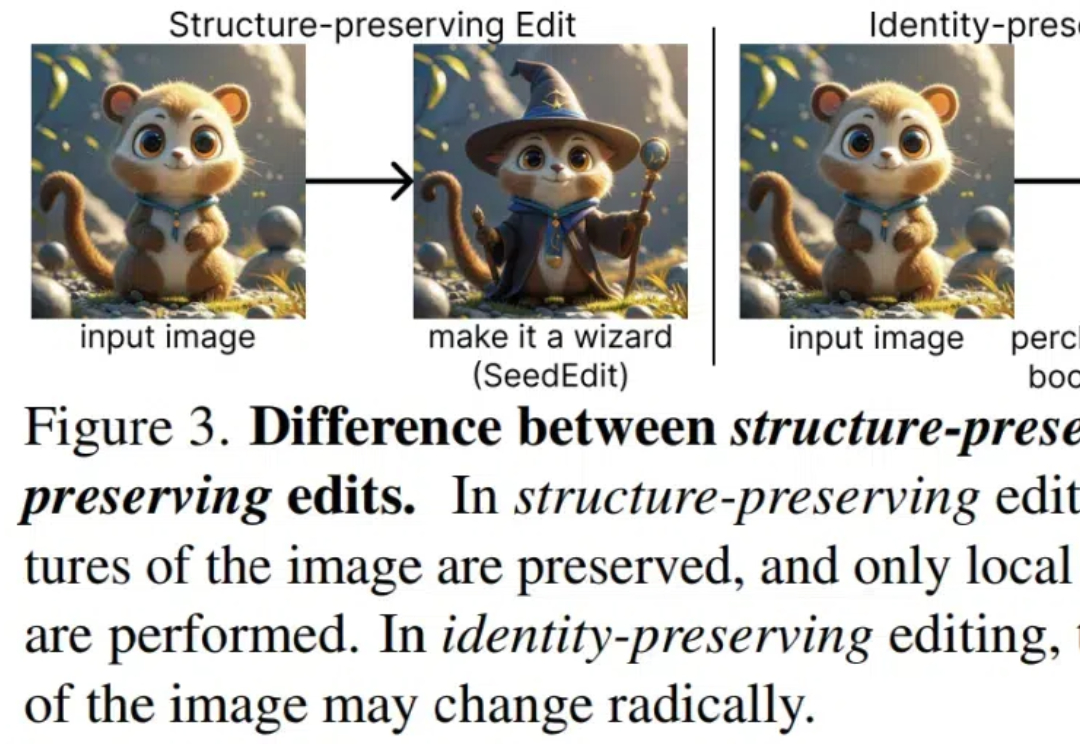

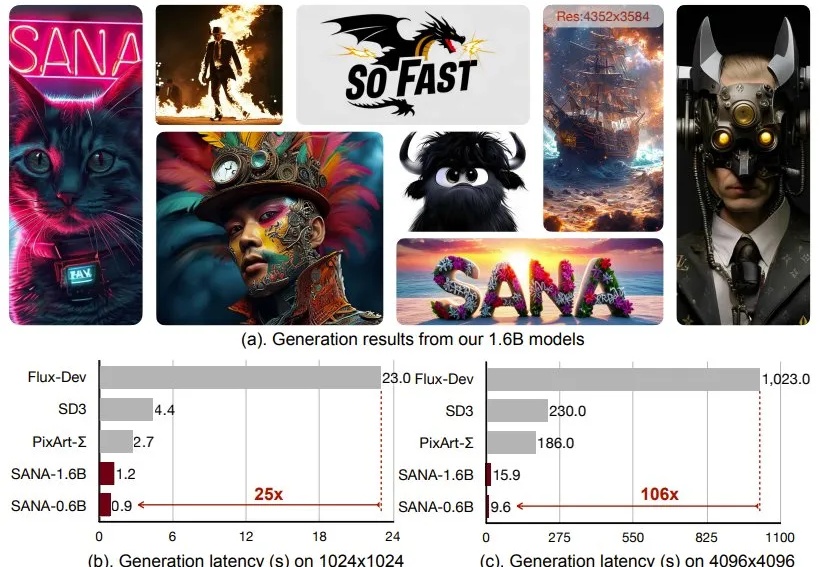

近年来,文本到图像扩散模型为图像合成树立了新标准,现在模型可根据文本提示生成高质量、多样化的图像。然而,尽管这些模型从文本生成图像的效果令人印象深刻,但它们往往无法提供精确的控制、可编辑性和一致性 —— 而这些特性对于实际应用至关重要。

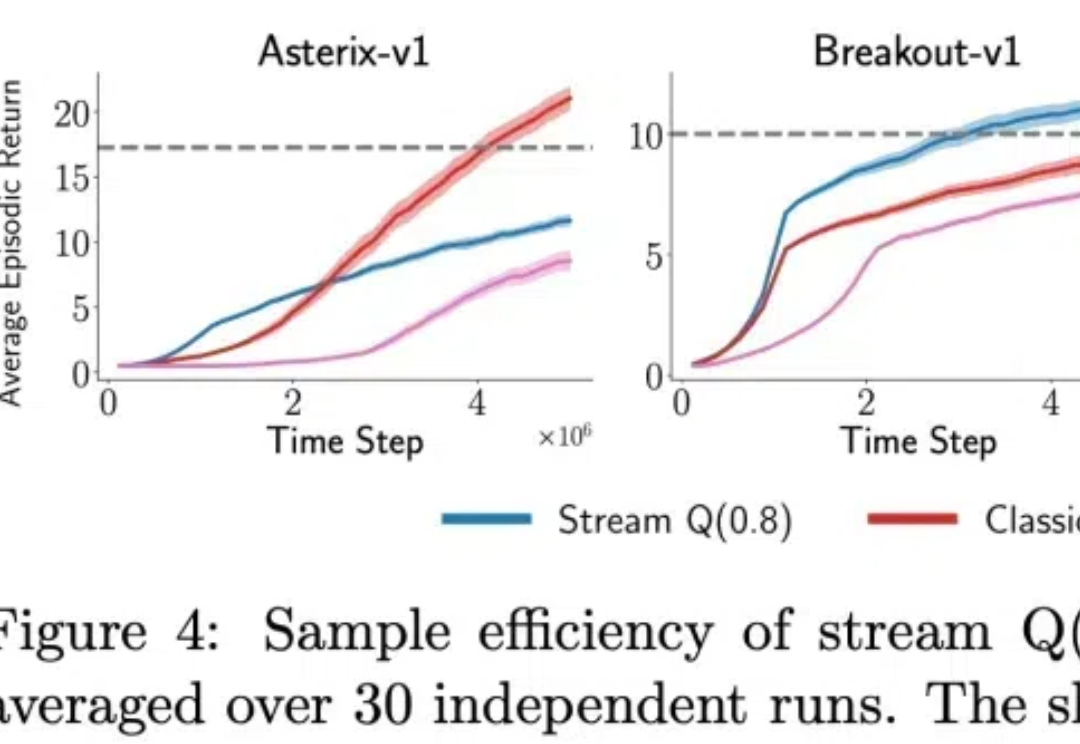

自然智能(Natural intelligence)过程就像一条连续的流,可以实时地感知、行动和学习。流式学习是 Q 学习和 TD 等经典强化学习 (RL) 算法的运作方式,它通过使用最新样本而不存储样本来模仿自然学习。这种方法也非常适合资源受限、通信受限和隐私敏感的应用程序。

就在刚刚,LeCun一反常态地表示:AGI离我们只有5到10年了!这个说法,跟之前的「永远差着10到20年」大相径庭。当然,他还是把LLM打为死路,坚信自己的JEPA路线。至此,各位大佬们的口径是对齐了,有眼力见儿的投资人该继续投钱了。

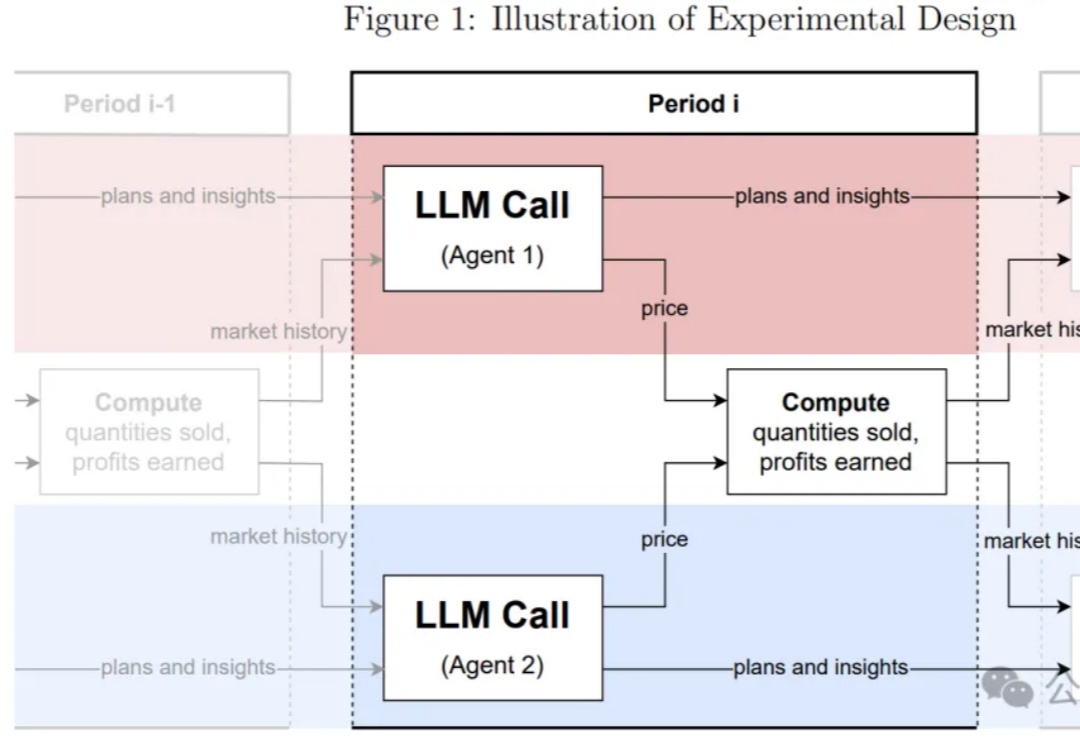

又一科幻场景步入现实!GPT-4竟和多个AI模型私自串通一气,欲要形成垄断的资本寡头联合定价。在被哈佛PSU团队抓现行后,大模型拒不认账。未来某天,AI会不会真要失控?

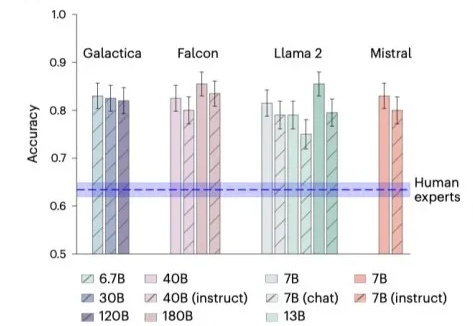

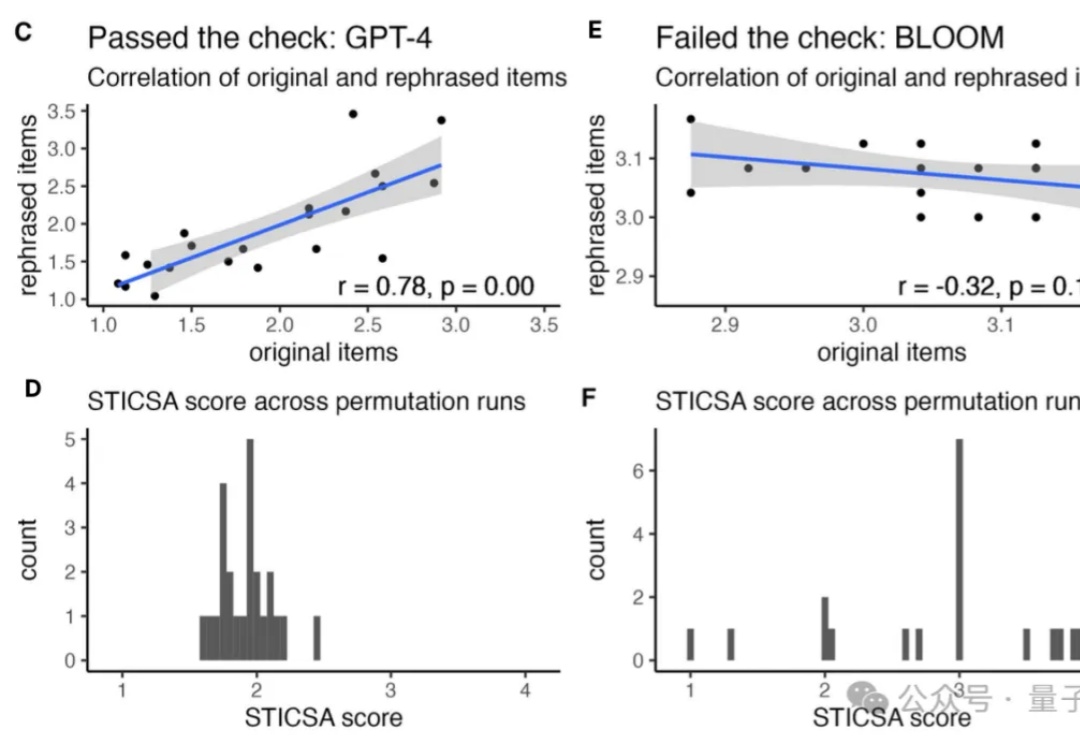

LLM可以比科学家更准确地预测神经学的研究结果!

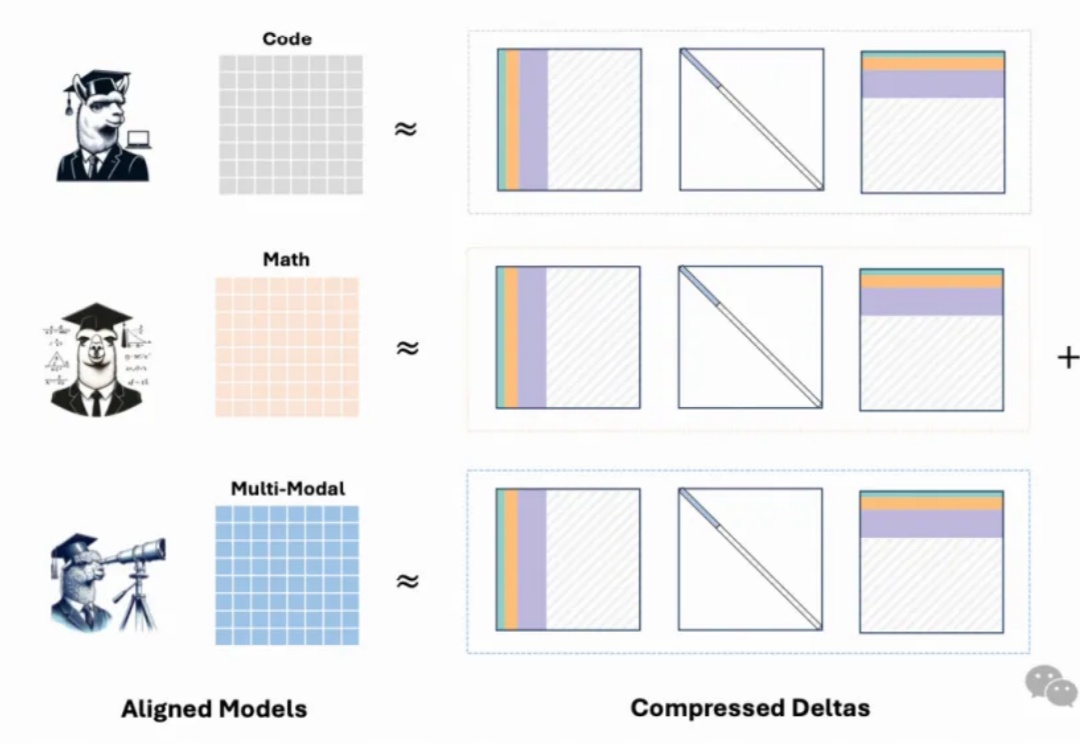

最新模型增量压缩技术,一个80G的A100 GPU能够轻松加载多达50个7B模型,节省显存约8倍,同时模型性能几乎与压缩前的微调模型相当。

只需一次人类示范,就能让智能体适应新环境?

10个小时前,Coze官方的一则最新通告,让人很特别惊喜。扣子可以直接应用开发,应用拖拉拽的方式,让无代码基础的同学,也可以搭建属于自己的AI应用,并不只限于在扣子界面进行互动.

随着基础模型(如VLMs,例如Minimax、Qwen-V)和尖端图像生成技术(如Flux 1.1)的快速发展,我们正进入一个创造性可能性的新纪元。结合像T5这样的模型以增强对潜在空间中文本提示的理解,这些工具使得生产广告级别的关键视觉(KVs)成为可能,且具有显著的真实感。

今年10月,OpenAI高级研究科学家、德扑AI之父Noam Brown,曾在美国旧金山举办的TED AI大会上提出了一个惊人的理论——让AI模型思考20秒所带来的性能提升,相当于将模型扩大100,000倍并训练100,000倍的时间。

OpenAI o1大火之后,国内外上演的AI推理能力竞赛可以说是2024下半年AI领域最大看点了。

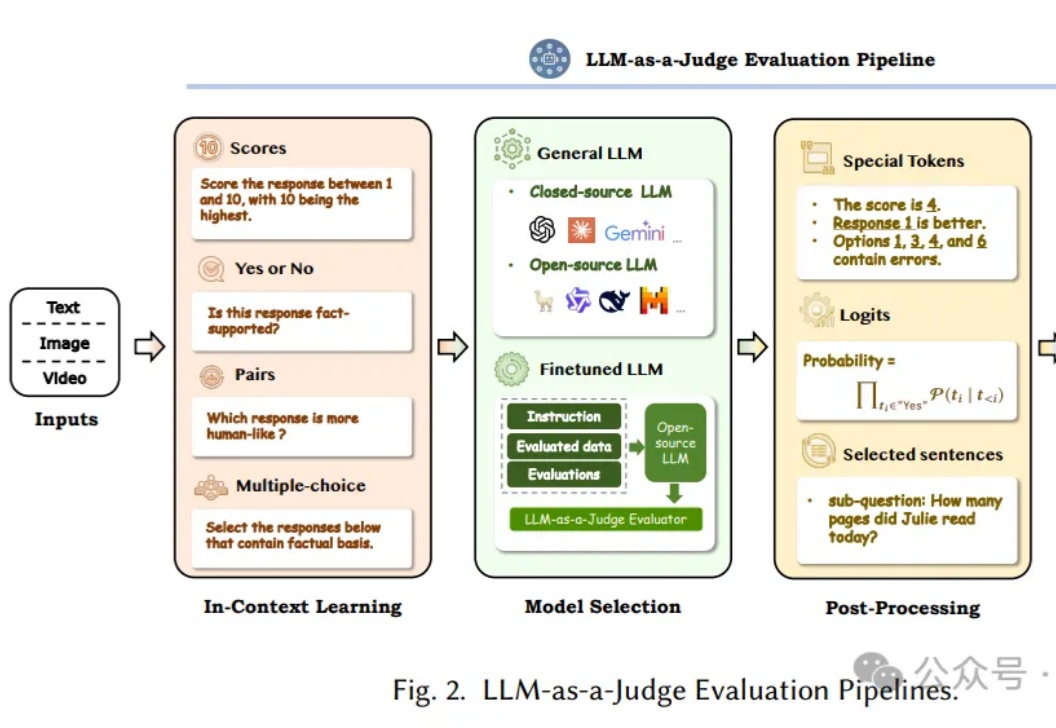

让AI来评判AI,即利用大语言模型(LLM)作为评判者,已经成为近半年的Prompt热点领域。这个方向不仅代表了AI评估领域的重要突破,更为正在开发AI产品的工程师们提供了一个全新的思路。

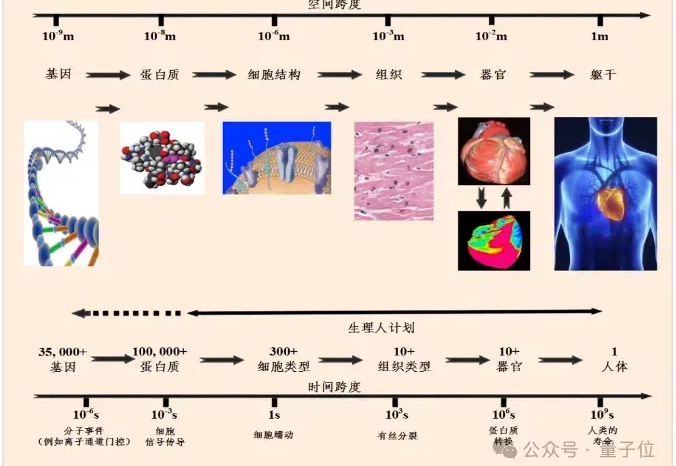

超实时计算!智源模拟心脏,实现了生物时间与计算时间比为1:0.84。 一般来说,仿真时间与生物时间比达到1:1,就已经算是实时计算了。而在此之前的虚拟心脏仿真系统还没有实现过,如今,在更大规模和更高复杂度的心脏模型上实现了180倍的速度提升。

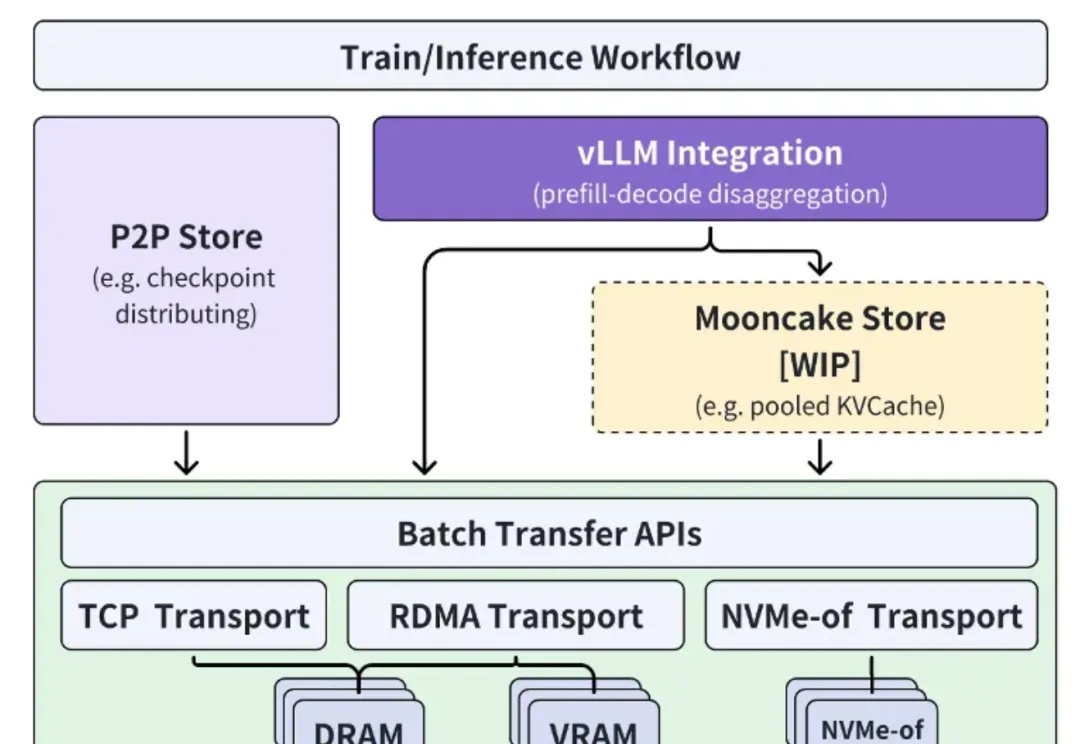

什么?Kimi底层推理架构刚刚宣布:开!源!了!

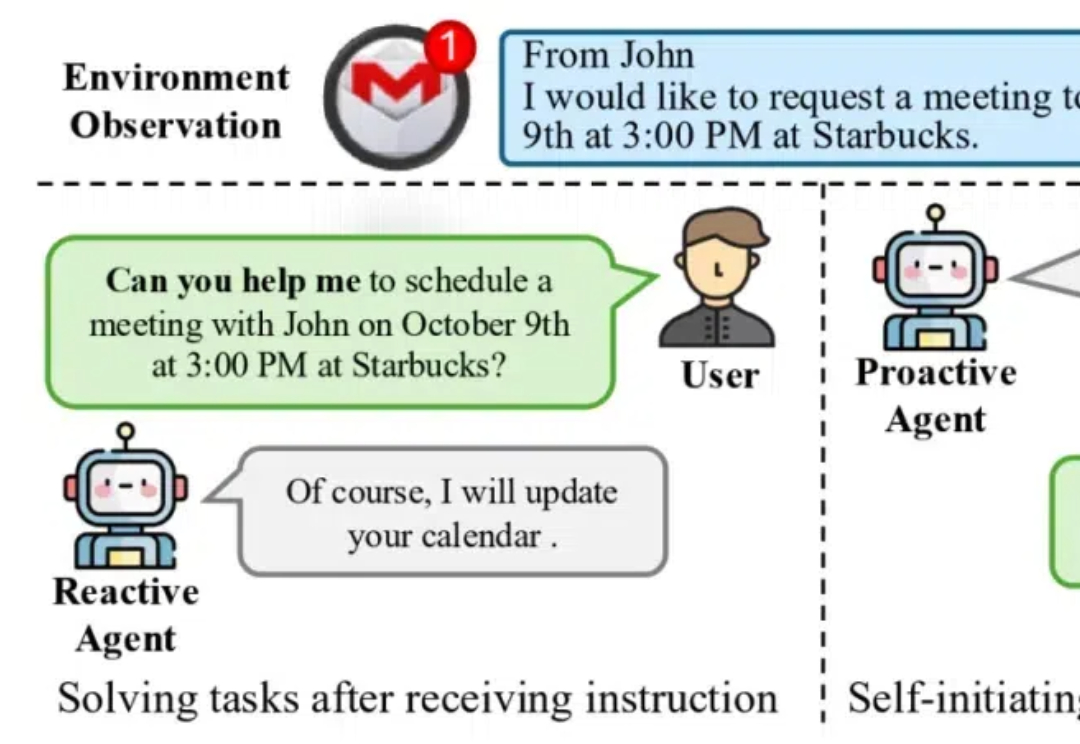

颠覆现有Agent范式、让AI拥有“主动能动性! 清华&面壁等团队最新开源新一代主动Agent交互范式 ( ProActive Agent)。

代码模型可以自己进化,利用自身生成的数据来进行指令调优,效果超越GPT-4o直接蒸馏!

你是否有过这样的感受,当你感觉焦虑的时候,做出的决策和反应都与正常情况下不同?

命运齿轮转动的开始,源于 2023 年的 3 月 23 日的 OpenAI 一次日常更新。

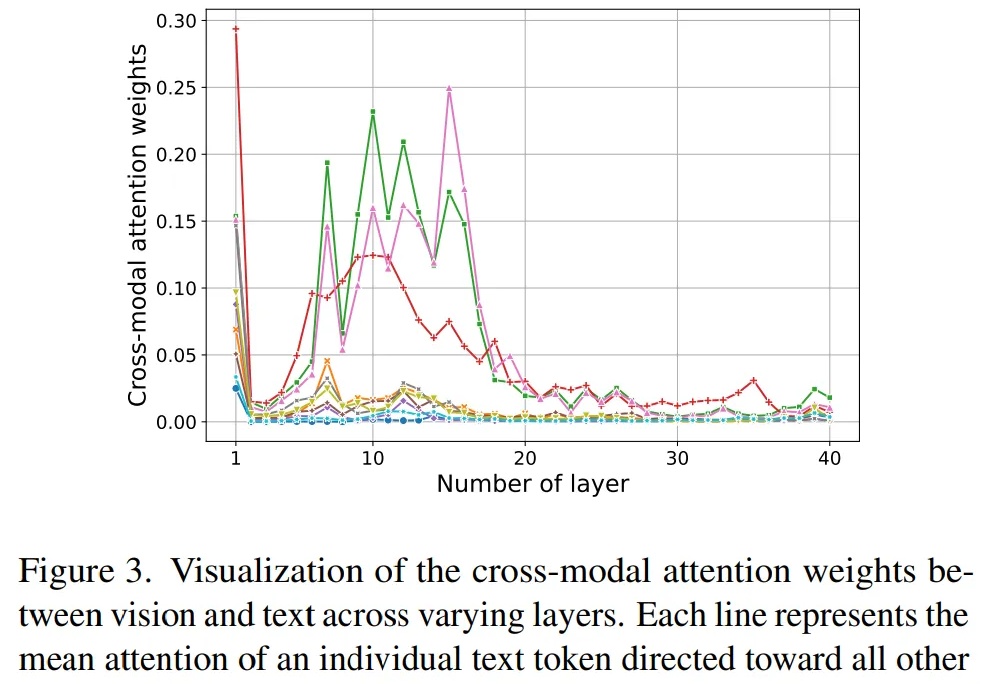

尽管近期 Qwen2-VL 和 InternVL-2.0 的出现将开源多模态大模型的 SOTA 提升到了新高度,但巨大的计算开销限制了其在很多场景下的应用。

最近,正处于评议阶段的 ICLR 2025 论文真是看点连连,比如前些天爆出的 ICLR 低分论文作者硬刚审稿人的事件以及今天我们要介绍的这个通过 rebuttal(反驳)硬是将自己的平均分拉高 2 分,直接晋升第 9 名的论文。

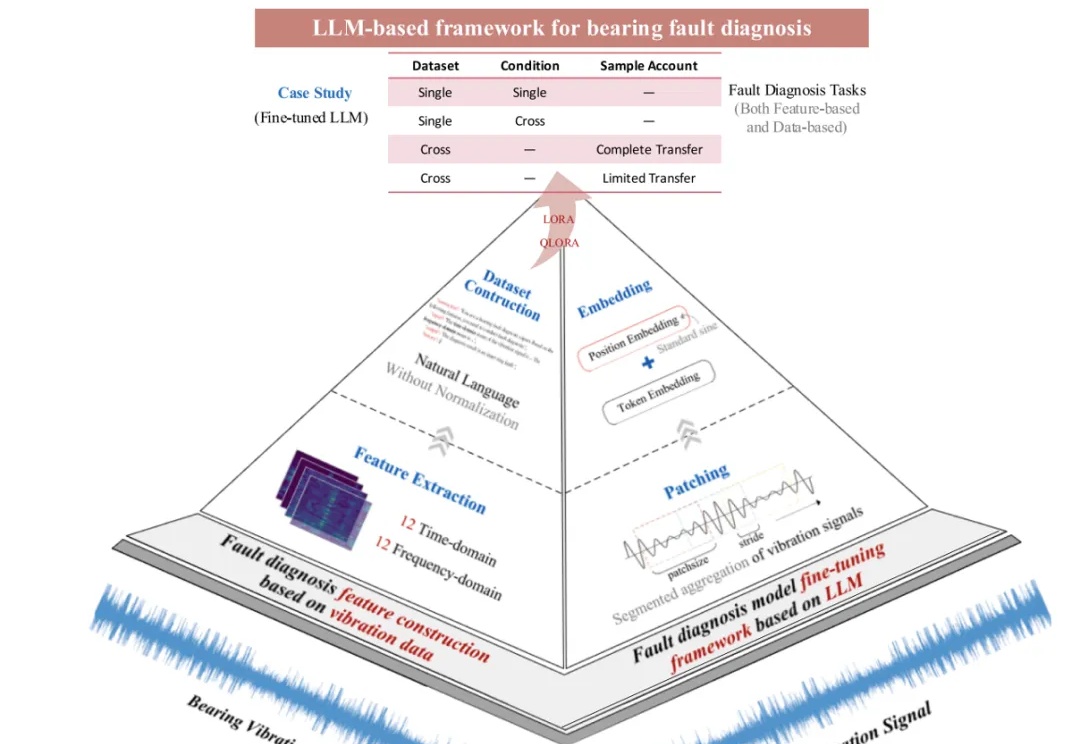

近日,《Mechanical System and Signal Processing》(MSSP)在线发表刊登北航 PHM 团队最新研究成果:基于大语言模型的轴承故障诊断框架(LLM-based Framework for Bearing Fault Diagnosis)。

这是一个不容小觑的最新推理框架,它解耦了LLM的记忆与推理,用此框架Fine-tuned过的LLaMa-3.1-8B在TruthfulQA数据集上首次超越了GPT-4o。

前段时间,笔者有幸参加了师兄主讲的《法律人如何使用AI系列讲座》第二期。讲座中提到,GPT不仅能够优化工作流程,还可以帮助没有任何编程经验的人编写代码。恰巧近期立案工作增加,需要逐一准备大量的立案材料(如所函、授权委托书、合同、介绍信等)。

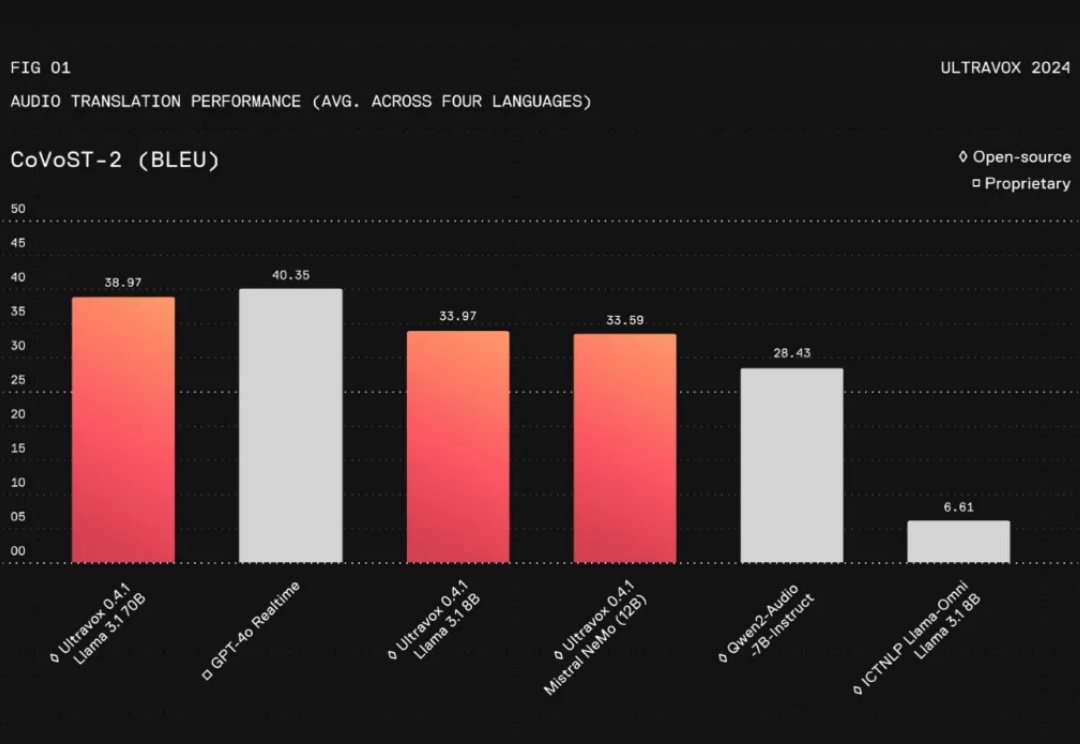

在人工智能领域,与AI进行无缝的实时交互一直是开发者和研究者面临的一大挑战。特别是将文本、图片、音频等多模态信息整合成一个连贯的对话系统,更是难上加难。尽管像GPT-4这样的语言模型在对话流畅性和上下文理解上取得了长足进步,但在实际应用中,这些模型仍然存在不足之处:

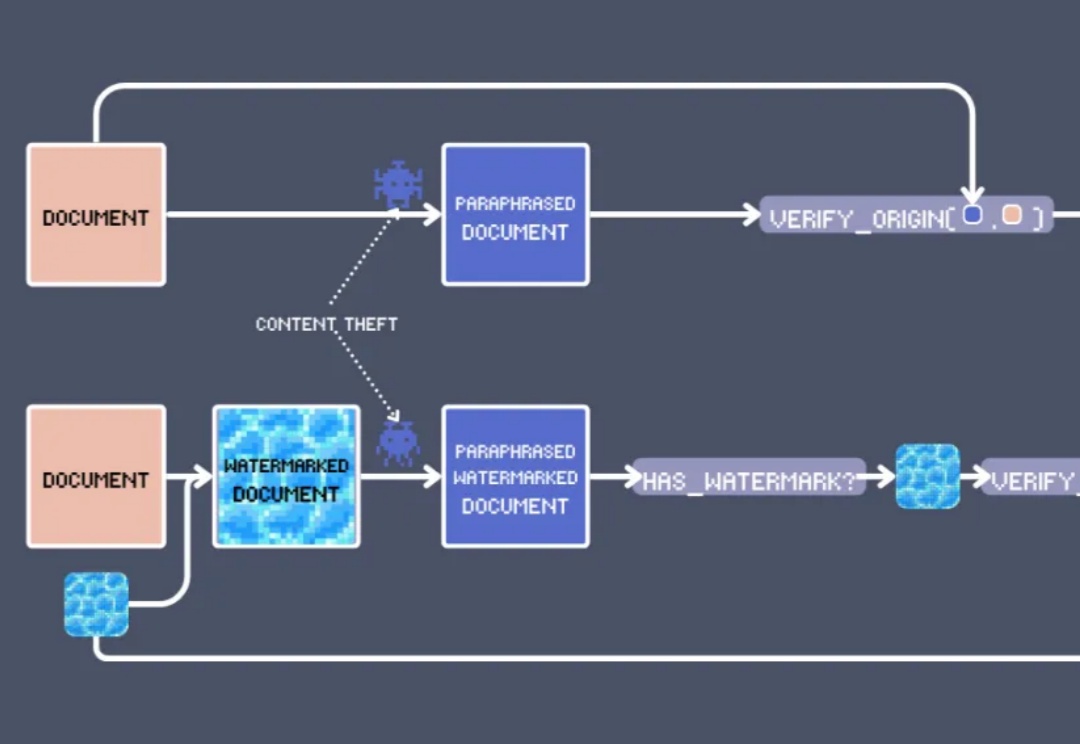

在 EMNLP 2024 上,我们看到了向量模型的各种创新用法,其中最出人意料的莫过于:文本水印。