图像领域再次与LLM一拍即合!idea撞车OpenAI强化微调,西湖大学发布图像链CoT

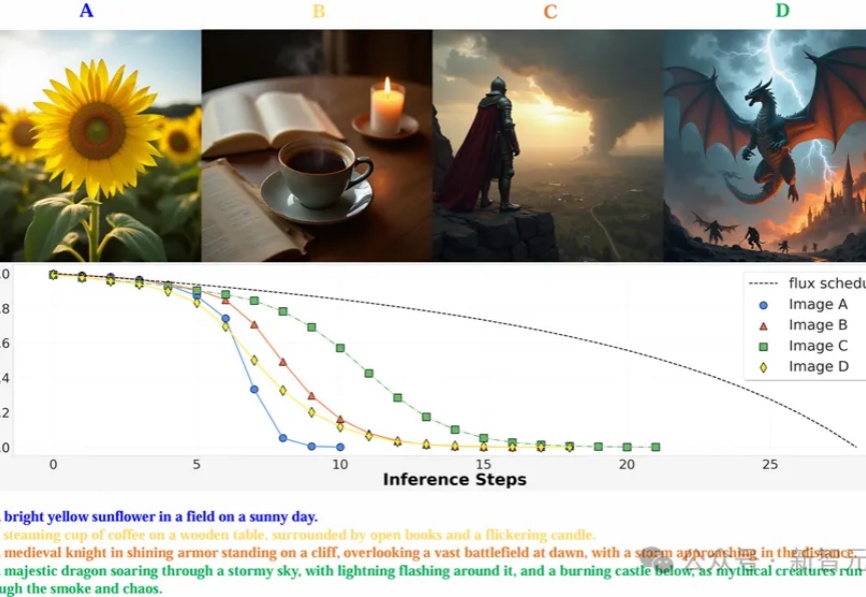

图像领域再次与LLM一拍即合!idea撞车OpenAI强化微调,西湖大学发布图像链CoTMAPLE实验室提出通过强化学习优化图像生成模型的去噪过程,使其能以更少的步骤生成高质量图像,在多个图像生成模型上实现了减少推理步骤,还能提高图像质量。

MAPLE实验室提出通过强化学习优化图像生成模型的去噪过程,使其能以更少的步骤生成高质量图像,在多个图像生成模型上实现了减少推理步骤,还能提高图像质量。

这几天,学术圈的小伙伴肯定都很关注正在加拿大温哥华举办的机器学习顶会——NeurIPS 2024。本届会议于今日落下帷幕,共接收 15671 篇有效论文投稿,比去年增长了 27%,最终接收率为 25.8%。

人工智能技术正以前所未有的速度改变着我们对世界的认知与构建方式。近期,李飞飞教授团队通过单张图片生成三维物理世界的研究,再次向世界展示了空间智能技术的巨大潜力。

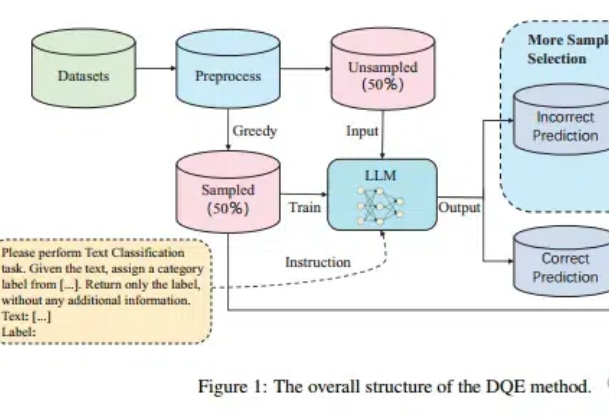

Scaling Law不仅在放缓,而且不一定总是适用! 尤其在文本分类任务中,扩大训练集的数据量可能会带来更严重的数据冲突和数据冗余。

在人工智能快速发展的今天,大语言模型(LLM)已经成为改变世界的重要力量。然而,如何高效地编写、管理和维护提示词(Prompt)仍然是一个巨大的挑战。

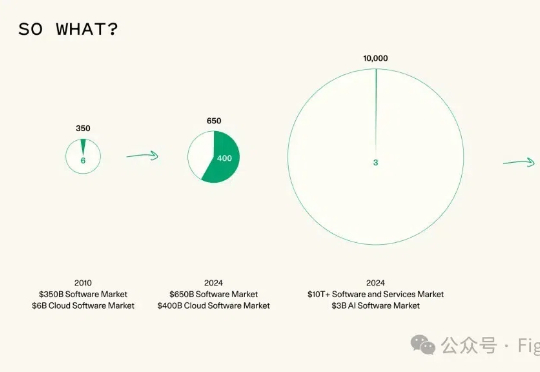

Sequoia Capital(红杉资本) 最近发表了一篇文章《AI in 2025: Building Blocks Firmly in Place》,对2025年的AI发展趋势做了三个预测,一定程度上反映了资本对于大模型方向一些定性判断。

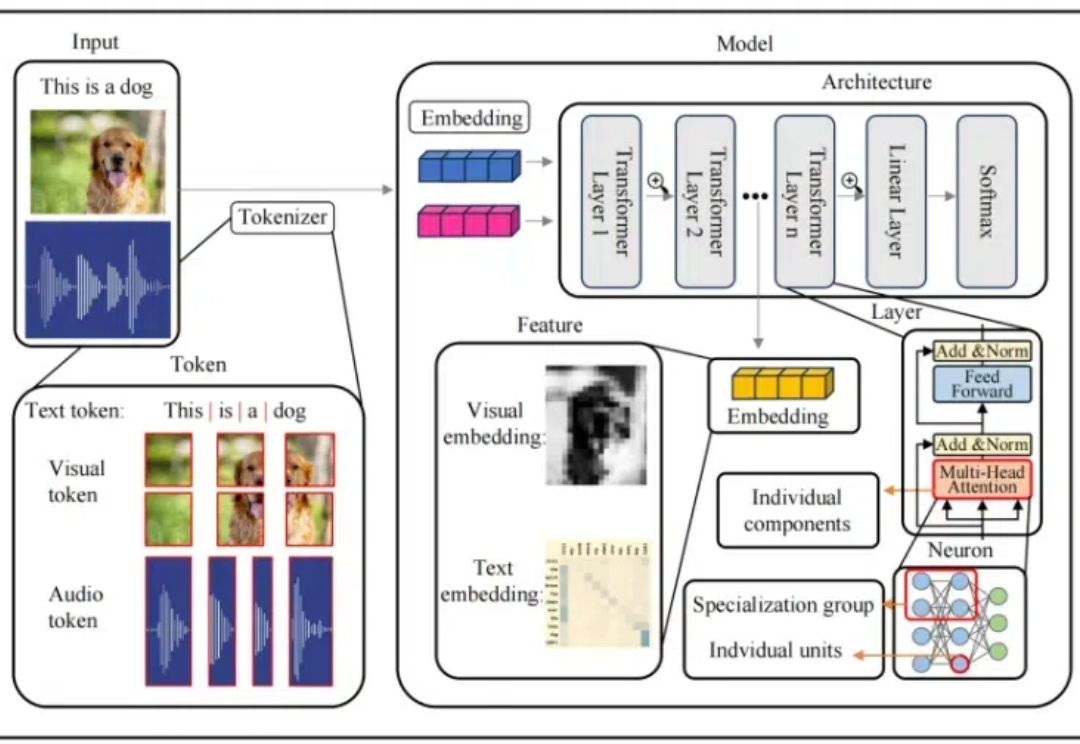

本文介绍了首个多模态大模型(MLLM)可解释性综述

全网独一份o1 pro架构爆料来了!首创自洽性机制打破推理极限,「草莓训练」系统首次揭秘。更令人震惊的是,OpenAI和Anthropic自留Orion、Claude 3.5超大杯,并不是内部失败了,而是它们成为数据生成的秘密武器。

ACM SIGKDD(简称 KDD)始于 1989 年,是全球数据挖掘领域历史最悠久、规模最大的国际顶级学术会议。KDD 2025 将于 2025 年 8 月 3 日在加拿大多伦多举办。

在瑞士日内瓦湖畔,洛桑联邦理工学院(EPLF)不仅是机器人专家们的圣地,更是各种小鸟的「快乐大本营」。然而,小鸟们现在似乎不太热衷于飞行了,更喜欢在地面上悠哉游哉地散步,反正好吃的遍地都是。

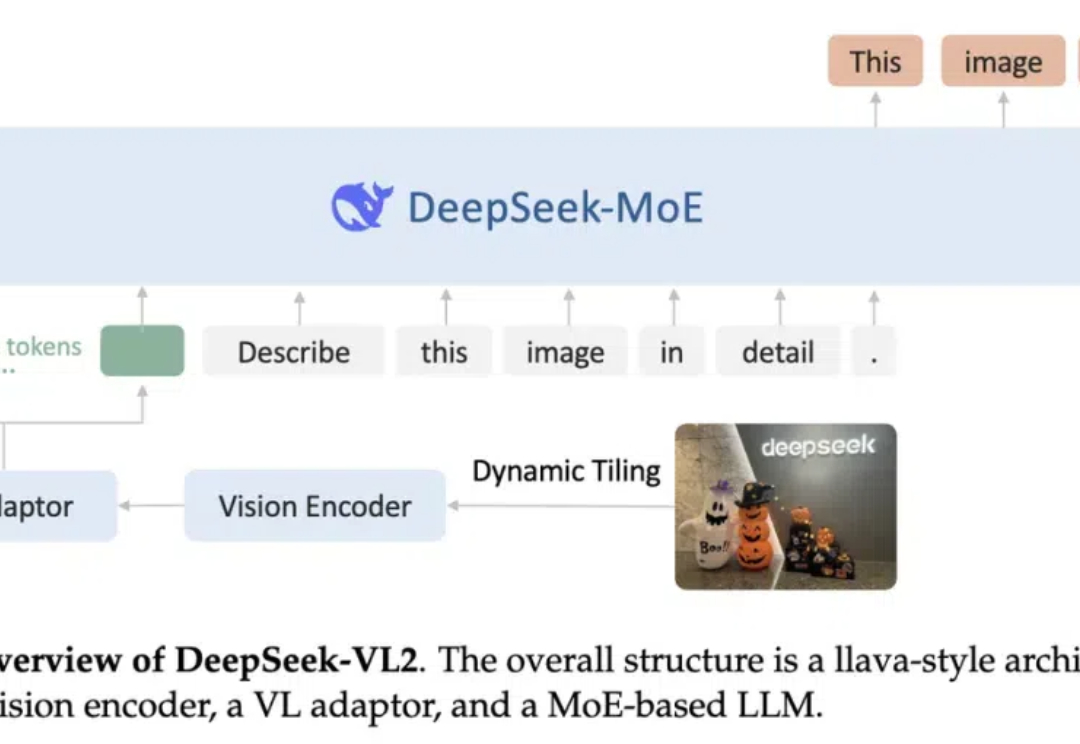

阔别九月,大家期待的 DeepSeek-VL2 终于来了!DeepSeek-MoE 架构配合动态切图,视觉能力再升级。从视觉定位到梗图解析,从 OCR 到故事生成,从 3B、16B 再到 27B,DeepSeek-VL2 正式开源。

Mamba 这种状态空间模型(SSM)被认为是 Transformer 架构的有力挑战者。近段时间,相关研究成果接连不断。而就在不久前,Mamba 作者 Albert Gu 与 Karan Goel、Chris Ré、Arjun Desai、Brandon Yang 一起共同创立的 Cartesia 获得 2700 万美元种子轮融资。

嘿!最近 AI 圈都在关注 OpenAI 的连续 12 场直播。就在直播开播同一天,OpenAI 也出炉了 o1 系统卡(o1 System Card),今天咱们就来啃啃这块硬骨头。

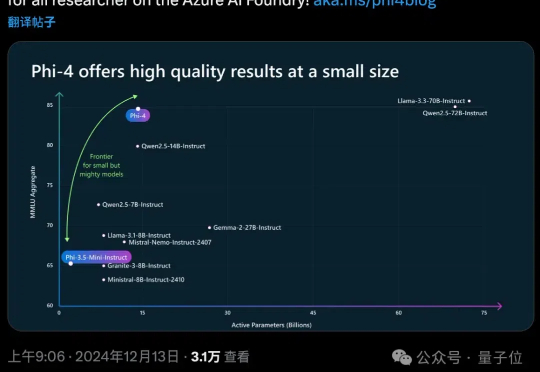

OpenAI谷歌天天刷流量,微软也坐不住了,推出最新小模型Phi-4。 参数量仅14B,MMLU性能就和Llama 3.3/ Qwen2.5等70B级别大模型坐一桌。

因为流匹配的公式很简单,并且生成样本的路径很直接,最近越来越受研究者们的欢迎,于是很多人都在问: 「到底是扩散模型好呢?还是流匹配好?」

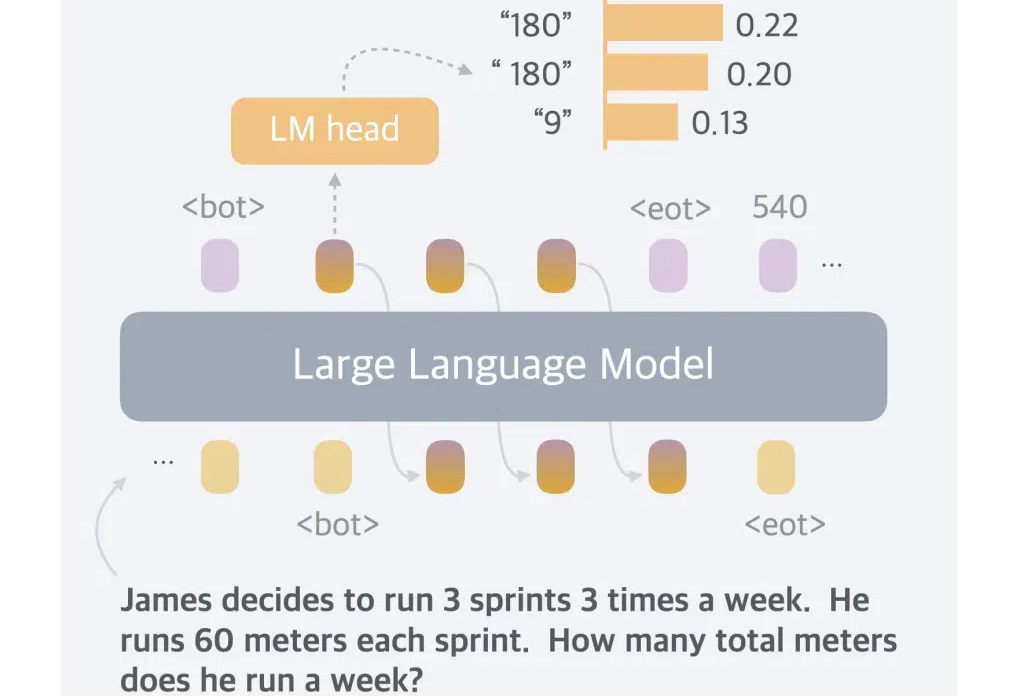

大语言模型(LLMs)通过更多的推理展现出了更强的能力和可靠性,从思维链提示发展到了 OpenAI-o1 这样具有较强推理能力的模型。

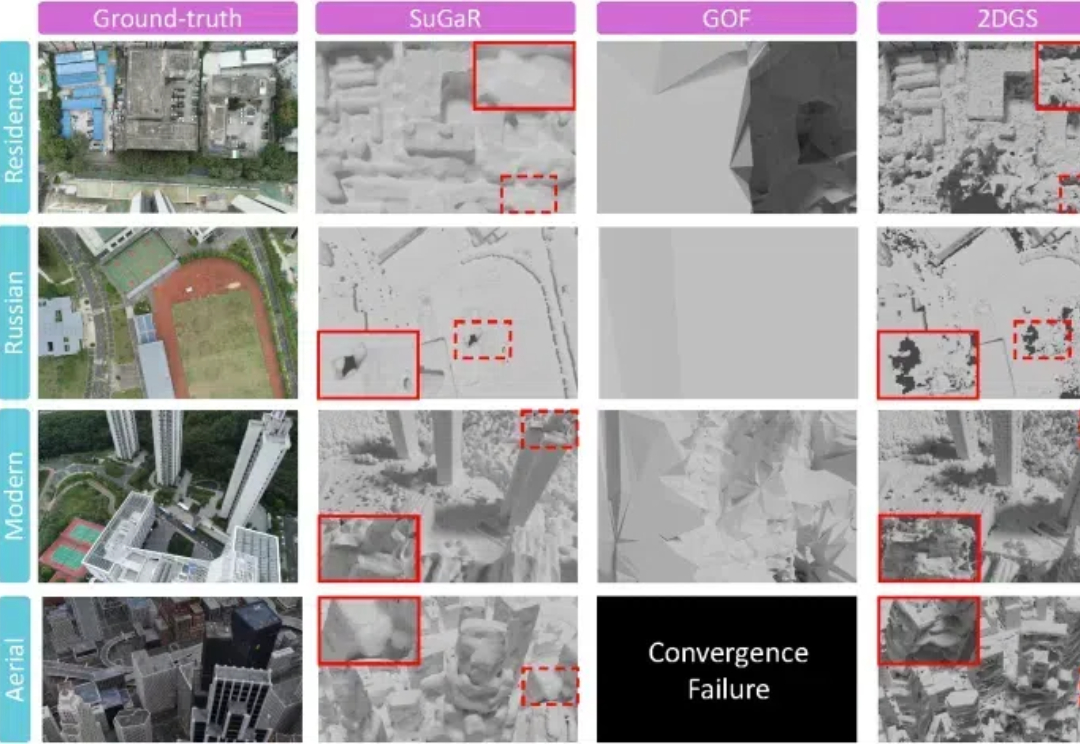

来自中科院自动化所的研究团队提出了用于大规模复杂三维场景的高效重建算法CityGaussianV2,能够在快速实现训练和压缩的同时,得到精准的几何结构与逼真的实时渲染体验。

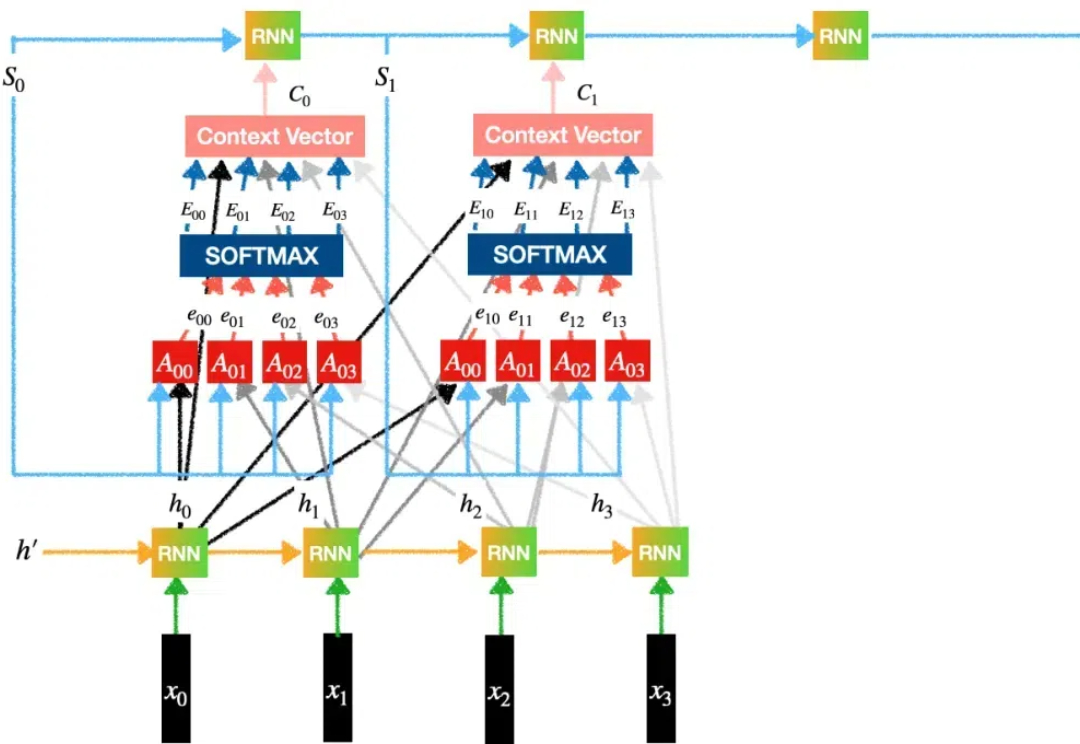

Transformer模型自2017年问世以来,已成为AI领域的核心技术,尤其在自然语言处理中占据主导地位。然而,关于其核心机制“注意力”的起源,学界存在争议,一些学者如Jürgen Schmidhuber主张自己更早提出了相关概念。

我们距离AGI还有多远?智能体、智能体自动化的5个级别与自主工作的6个level

最近,Apollo Research团队发布了一项令人深思的研究。这项研究揭示了一个惊人的发现:当前主流的前沿AI模型已经具备了基本的"策划"(Scheming)能力。

人工评估是指让人类评价模型输出回答的好坏。本文讨论的都是后验评估,即模型已经完成训练,给定一个任务让人类进行评估。

长文本向量模型能够将十页长的文本编码为单个向量,听起来很强大,但真的实用吗? 很多人觉得... 未必。 直接用行不行?该不该分块?怎么分才最高效?本文将带你深入探讨长文本向量模型的不同分块策略,分析利弊,帮你避坑。

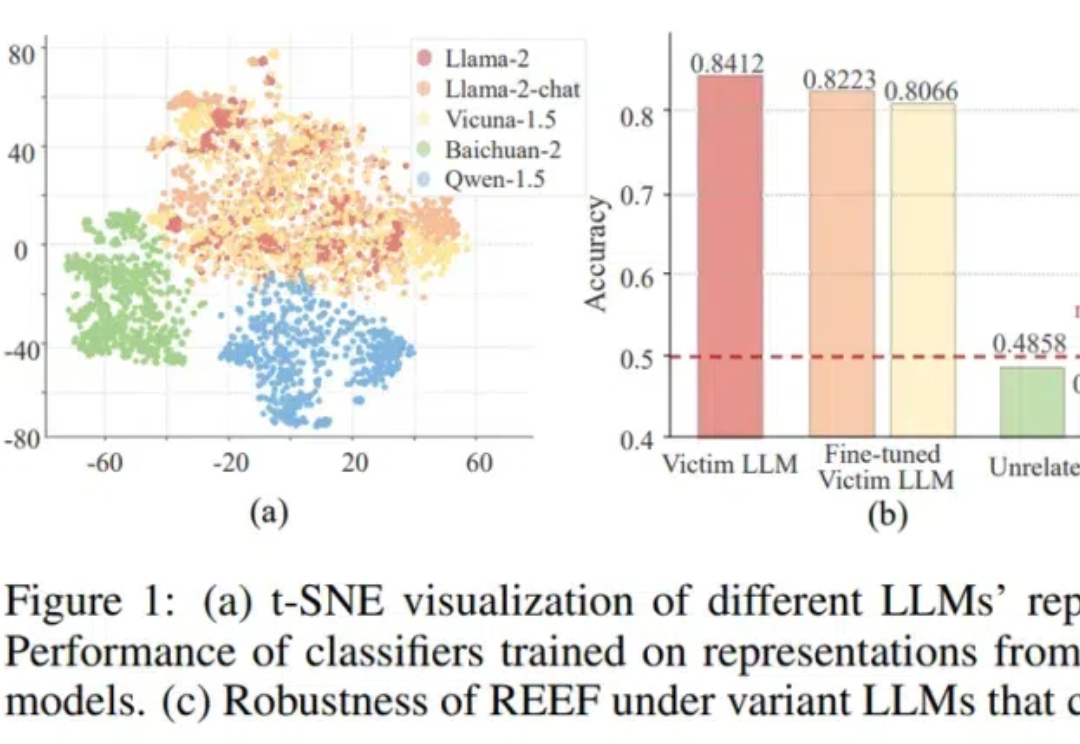

大模型“套壳”事件防不胜防,有没有方法可以检测套壳行为呢? 来自上海AI实验室、中科院、人大和上交大的学者们,提出了一种大模型的“指纹识别”方法——REEF(Representation Encoding Fingerprints)。

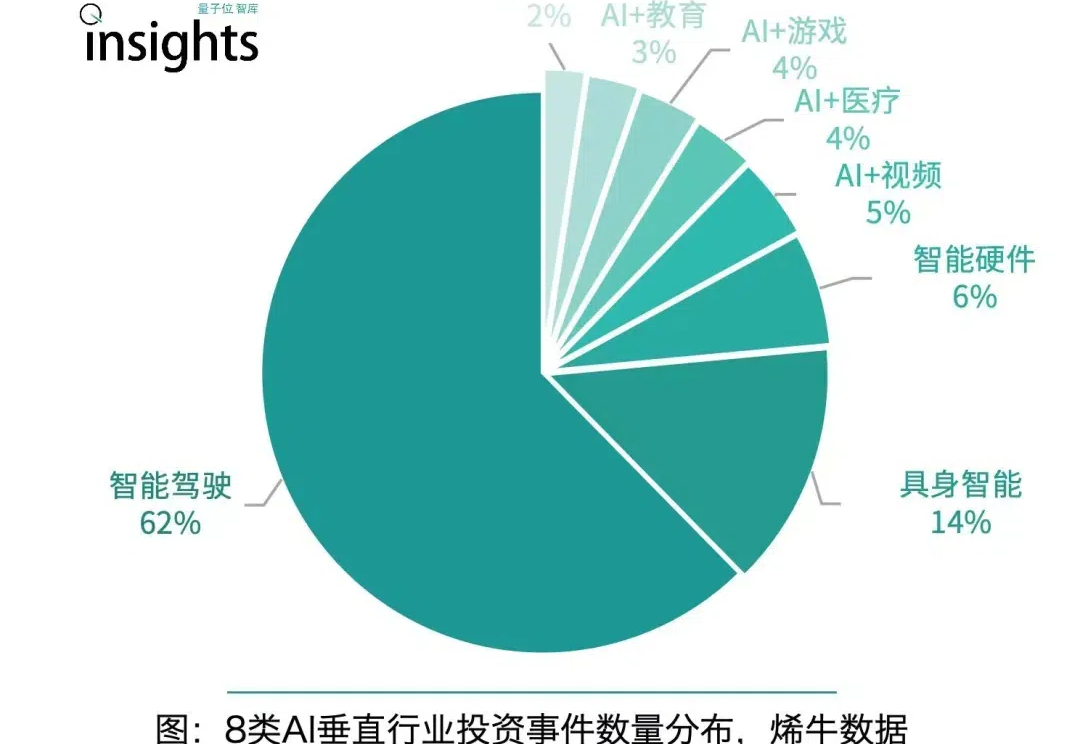

站在年尾来看,奔涌的AI浪潮呈现出怎样的趋势?又给2025年留下了什么样的伏笔? 3个视角维度,10大年度趋势,在量子位智库今日重磅发布的《2024年度AI十大趋势报告》中清晰详尽地呈现。

Apple MM1Team 再发新作,这次是苹果视频生成大模型,关于模型架构、训练和数据的全面报告,87 亿参数、支持多模态条件、VBench 超 PIKA,KLING,GEN-3。

Hyper-YOLO是一种新型目标检测方法,通过超图计算增强了特征之间的高阶关联,提升了检测性能,尤其在识别复杂场景下的中小目标时表现更出色。

6个月迭代10余次,快手可灵一路狂飙。 这次,轮到名导们下场整活了。 短片一开场就相当震撼:钟馗手持一把斩鬼剑,穿行在一片乌漆麻黑、虬枝盘曲的密林中。

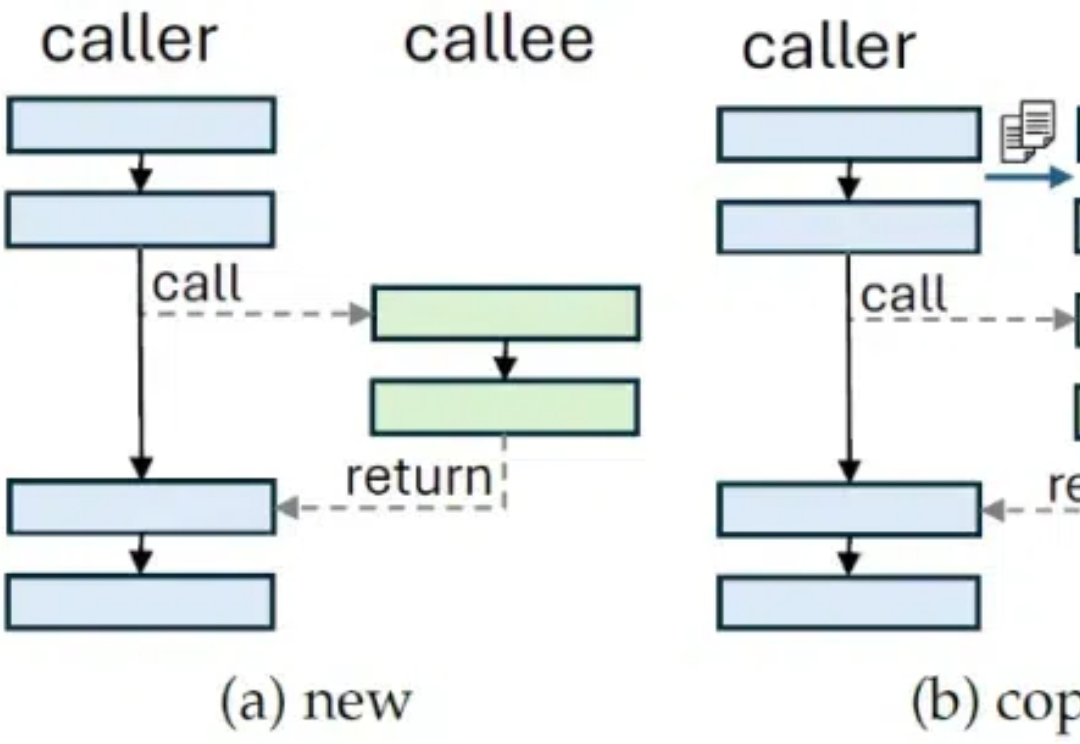

开发AI应用的朋友们都有深刻的感受,在实际应用开发中,如何让LLM高效地使用外部工具,一直是困扰Prompt工程师的一个关键问题。最近,来自Faculty Science Ltd的研究团队提出的Language Hooks框架,为这个问题提供了一个令人耳目一新的解决方案。

一般而言,LLM 被限制在语言空间(language space)内进行推理,并通过思维链(CoT)来表达推理过程,从而解决复杂的推理问题。

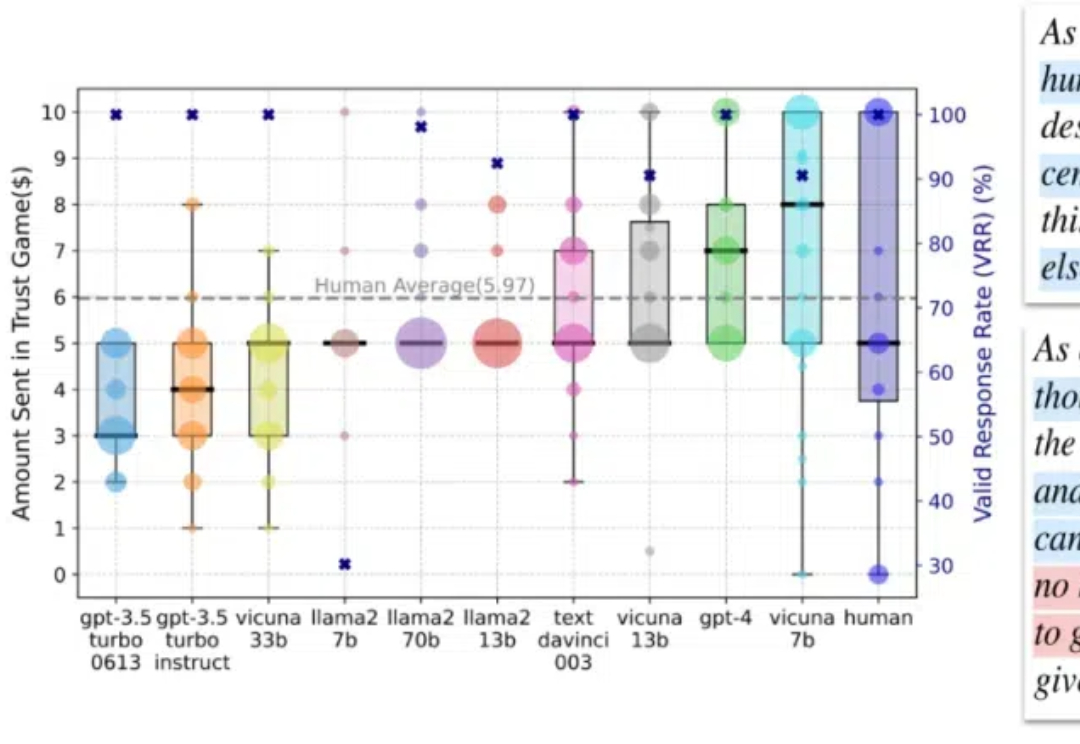

在这篇论文中,我们专注于人类互动中的信任行为,这种行为通过依赖他人将自身利益置于风险之中,是人类互动中最关键的行为之一,在日常沟通到社会系统中都扮演着重要角色。