向量模型的词序感知缺陷与优化策略

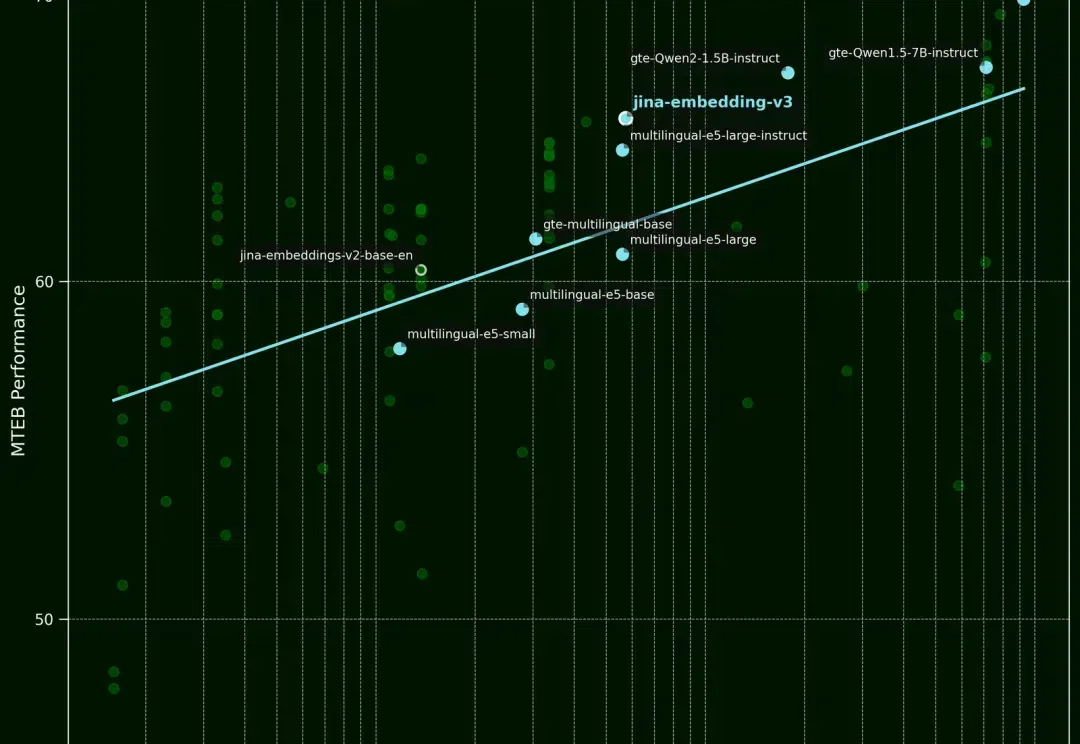

向量模型的词序感知缺陷与优化策略最近,LAION AI 的创始人 Christoph Schuhmann 分享了一个有趣的发现,他指出,文本向量模型似乎存在一个问题:即使句子词序被打乱,模型输出的向量与原句仍然高度相似。

最近,LAION AI 的创始人 Christoph Schuhmann 分享了一个有趣的发现,他指出,文本向量模型似乎存在一个问题:即使句子词序被打乱,模型输出的向量与原句仍然高度相似。

1637 年,费马在阅读丢番图《算术》拉丁文译本时,曾在第 11 卷第 8 命题旁写道:「将一个立方数分成两个立方数之和,或一个四次幂分成两个四次幂之和,或者一般地将一个高于二次的幂分成两个同次幂之和,这是不可能的。关于此,我确信我发现一种美妙的证法,可惜这里的空白处太小,写不下。」

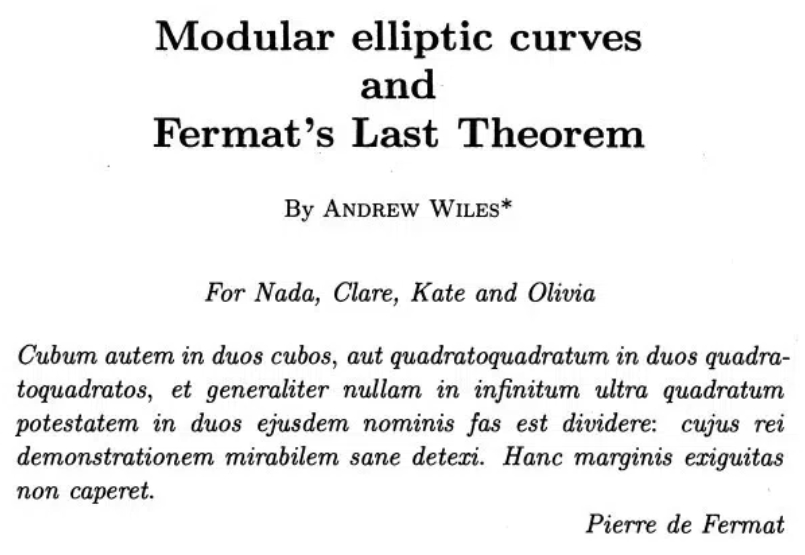

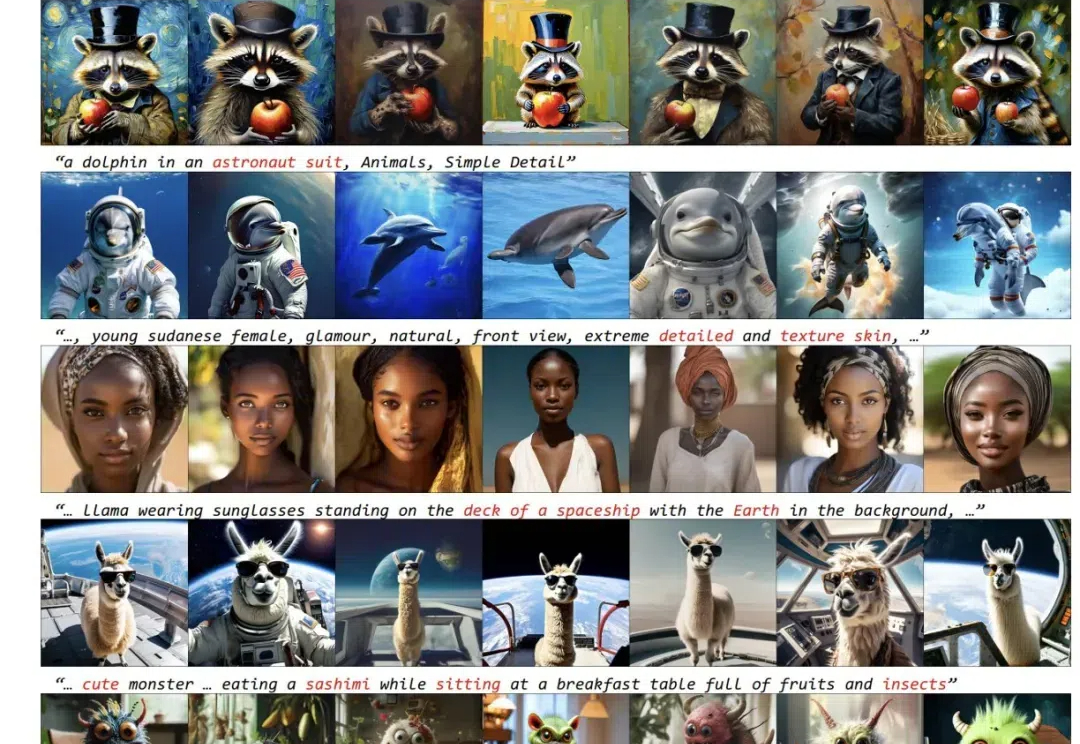

近年来许多论文研究了基于扩散模型的定制化生成,即通过给定一张或几张某个概念的图片,通过定制化学习让模型记住这个概念,并能够生成这个概念的新视角、新场景图片。

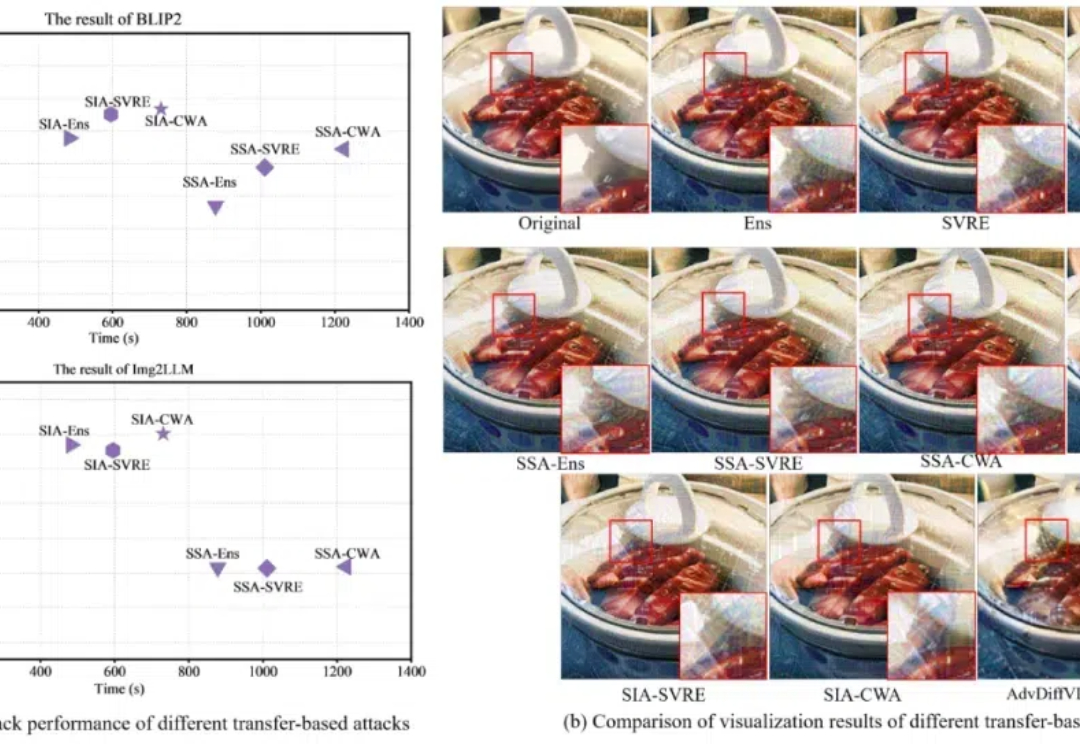

对抗攻击,特别是基于迁移的有目标攻击,可以用于评估大型视觉语言模型(VLMs)的对抗鲁棒性,从而在部署前更全面地检查潜在的安全漏洞。然而,现有的基于迁移的对抗攻击由于需要大量迭代和复杂的方法结构,导致成本较高

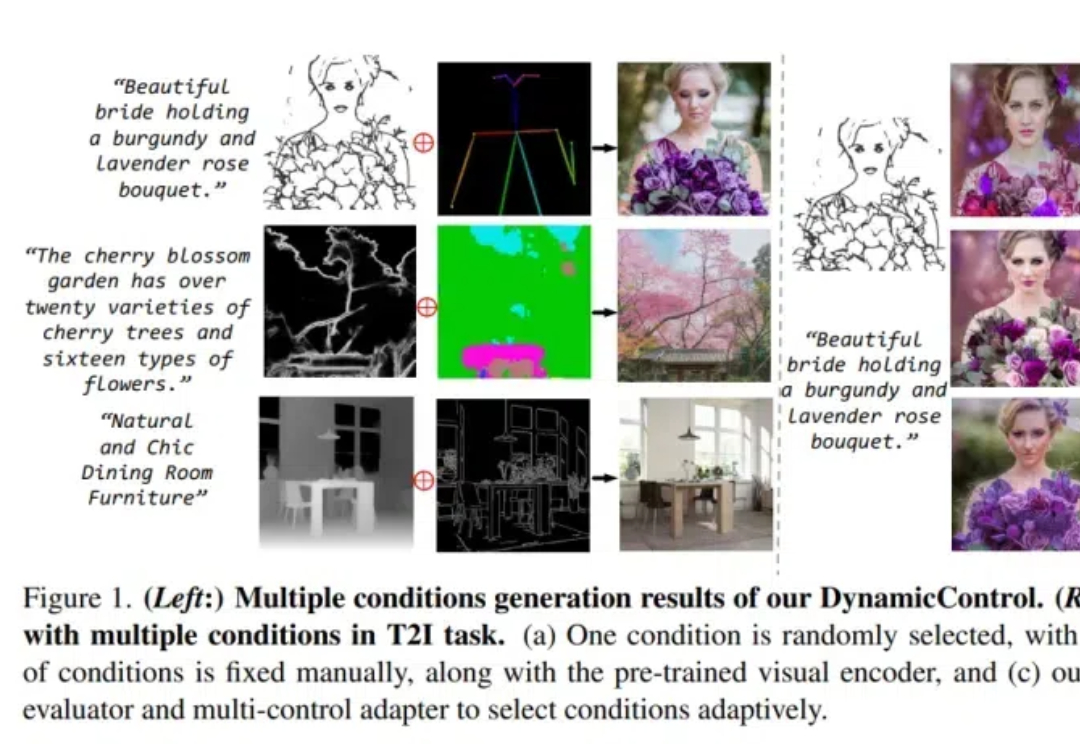

超越ControlNet++,让文生图更可控的新框架来了!

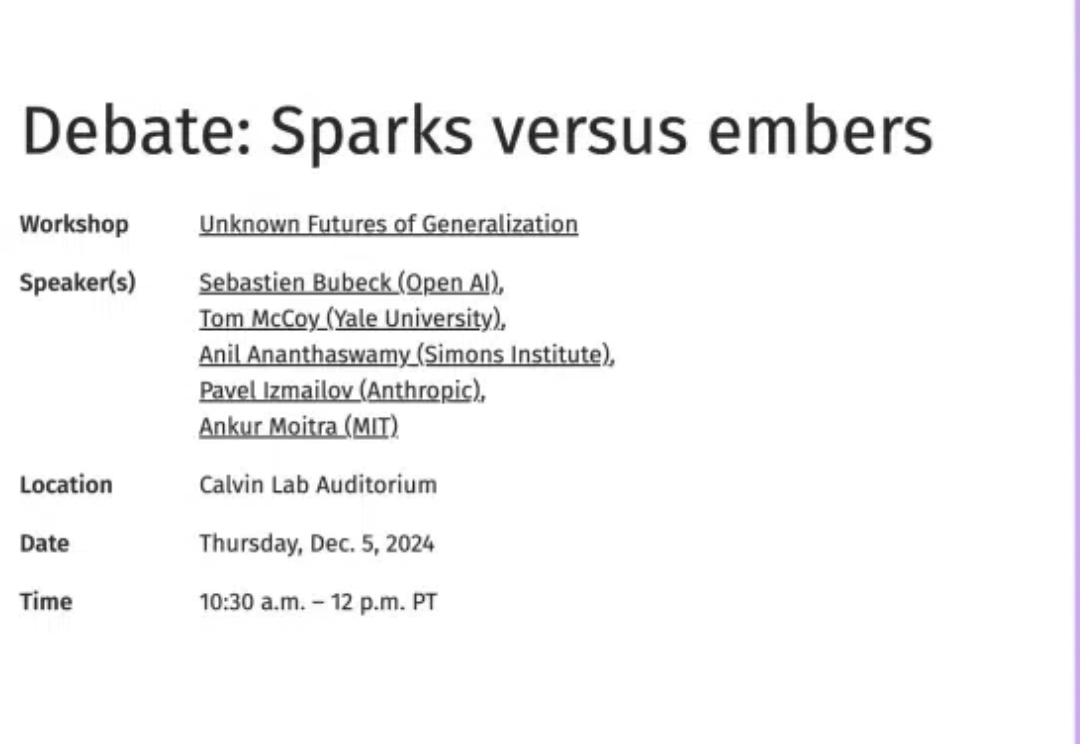

本月,OpenAI科学家就当前LLM的scaling方法论能否实现AGI话题展开深入辩论,认为将来AI至少与人类平分秋色;LLM scaling目前的问题可以通过后训练、强化学习、合成数据、智能体协作等方法得到解决;按现在的趋势估计,明年LLM就能赢得IMO金牌。

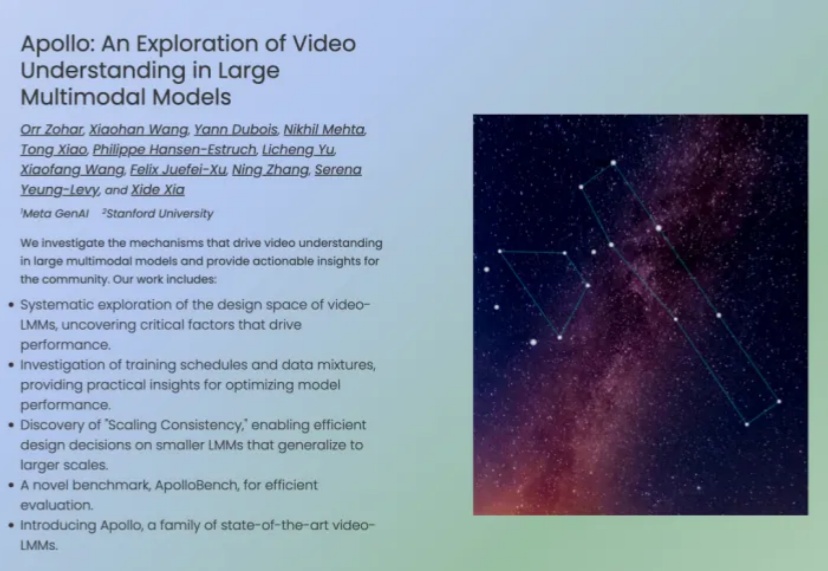

Orr Zohar的指导老师Serena Yeung-Levy教授于2018年获得斯坦福大学博士学位,师从李飞飞和Arnold Milstein。2017年至2019年期间,Serena Yeung-Levy曾与Justin Johnson和李飞飞共同教授斯坦福大学卷积神经网络课程。

一个全新的模型能力衡量指标诞生了?!

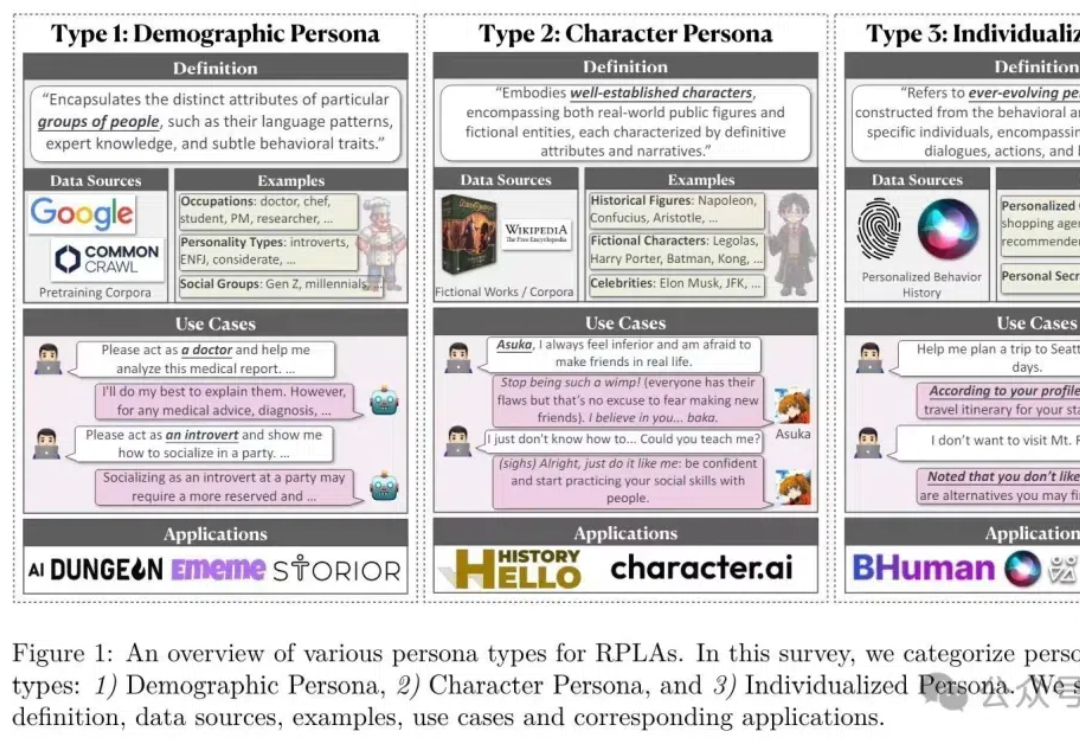

数字生命一直是人类几十年来的追求,反映了我们对技术与人类体验交汇的深层探索。近期,复旦大学发表了一篇综述论文,首次系统梳理了角色扮演AI(Role-Playing Language Agents,RPLAs)的研究现状,现已被机器学习顶级期刊TMLR接收。

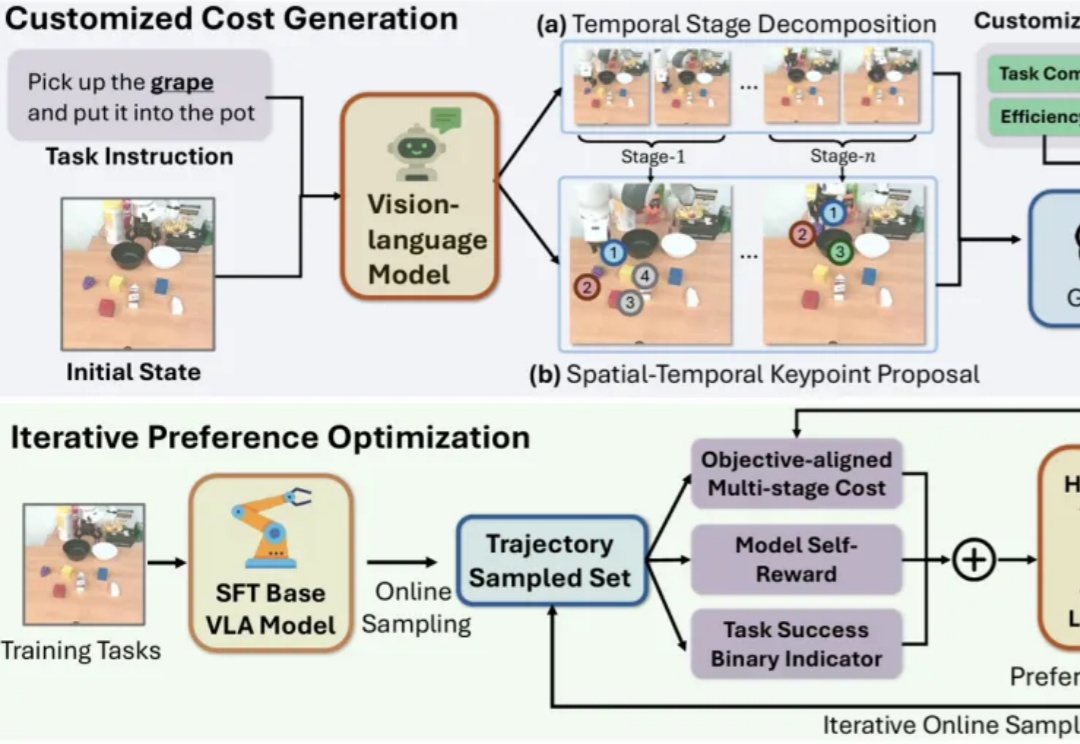

近年来,视觉-语言-动作模型(Vision-Language-Action, VLA)在诸多机器人任务上取得了显著的进展,但它们仍面临一些关键问题,例如由于仅依赖从成功的执行轨迹中进行行为克隆,导致对新任务的泛化能力较差。

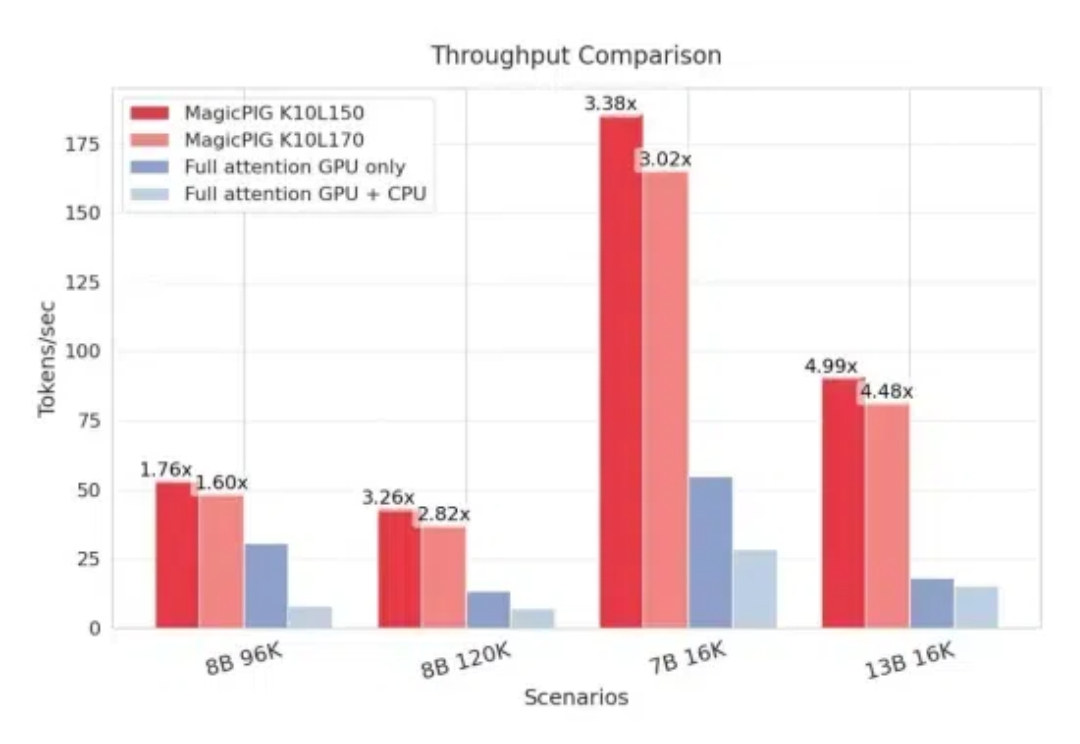

CPU+GPU,模型KV缓存压力被缓解了。 来自CMU、华盛顿大学、Meta AI的研究人员提出MagicPIG,通过在CPU上使用LSH(局部敏感哈希)采样技术,有效克服了GPU内存容量限制的问题。

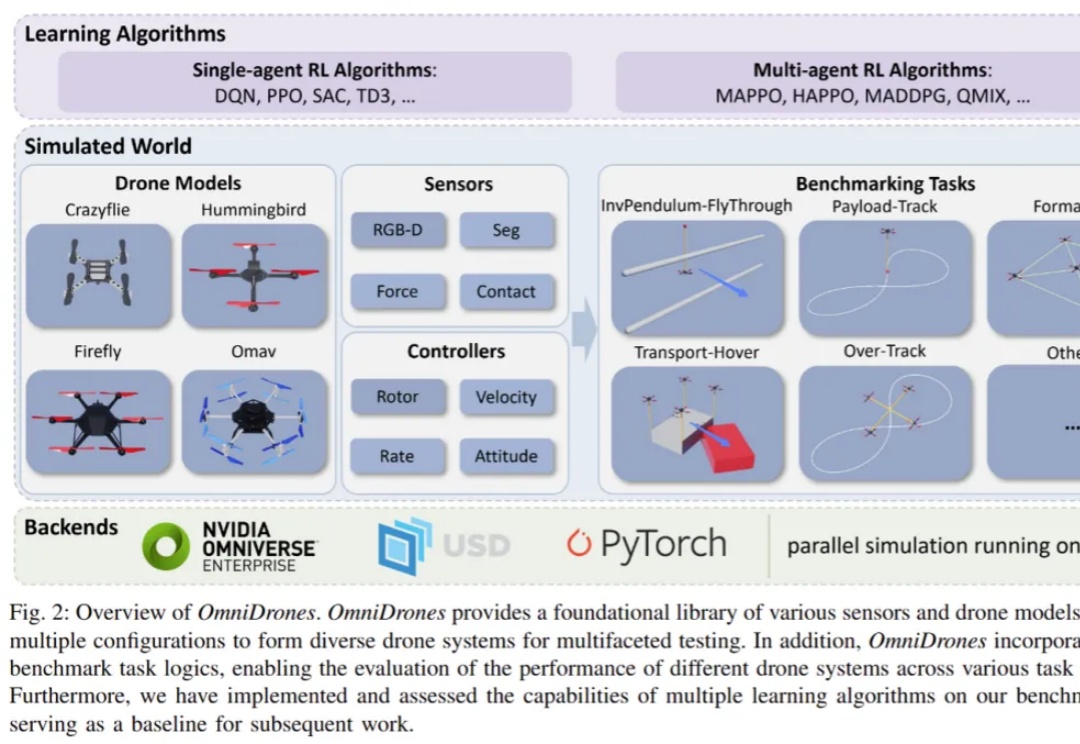

控制无人机执行敏捷、高机动性的行为是一项颇具挑战的任务。传统的控制方法,比如 PID 控制器和模型预测控制(MPC),在灵活性和效果上往往有所局限。而近年来,强化学习(RL)在机器人控制领域展现出了巨大的潜力。通过直接将观测映射为动作,强化学习能够减少对系统动力学模型的依赖。

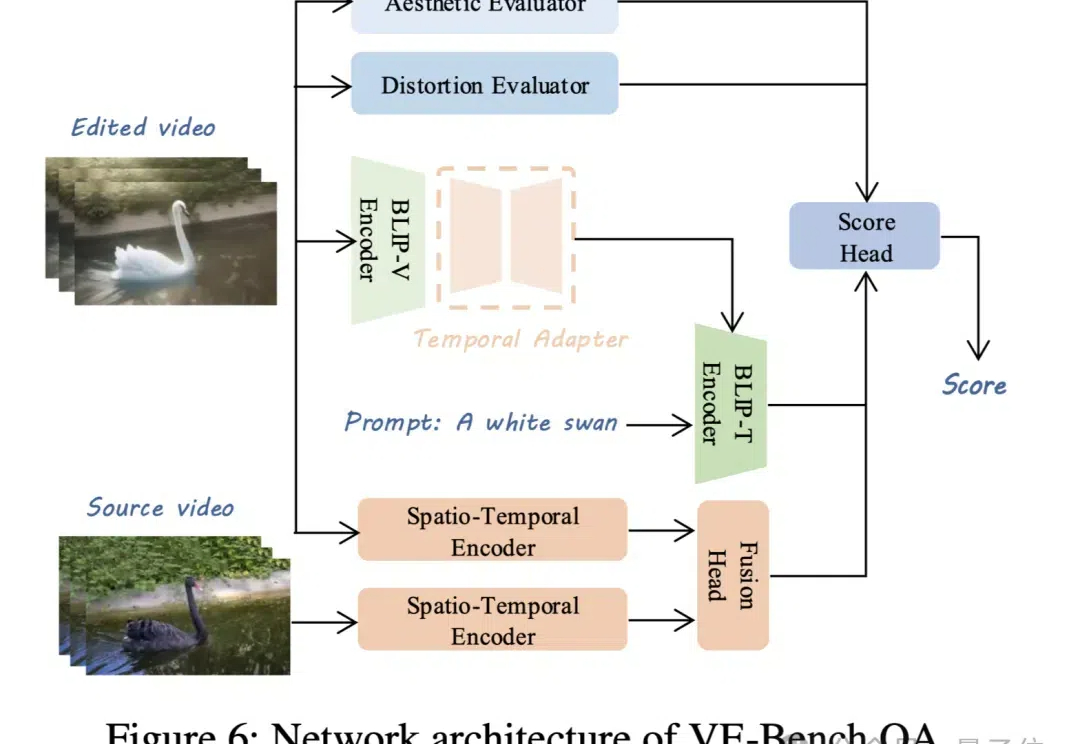

视频生成模型卷得热火朝天,配套的视频评价标准自然也不能落后。 现在,北京大学MMCAL团队开发了首个用于视频编辑质量评估的新指标——VE-Bench,相关代码与预训练权重均已开源。

DeepSeek新版模型正式发布,技术大佬们都转疯了! 延续便宜大碗特点的基础之上,DeepSeek V3发布即完全开源,直接用了53页论文把训练细节和盘托出的那种。

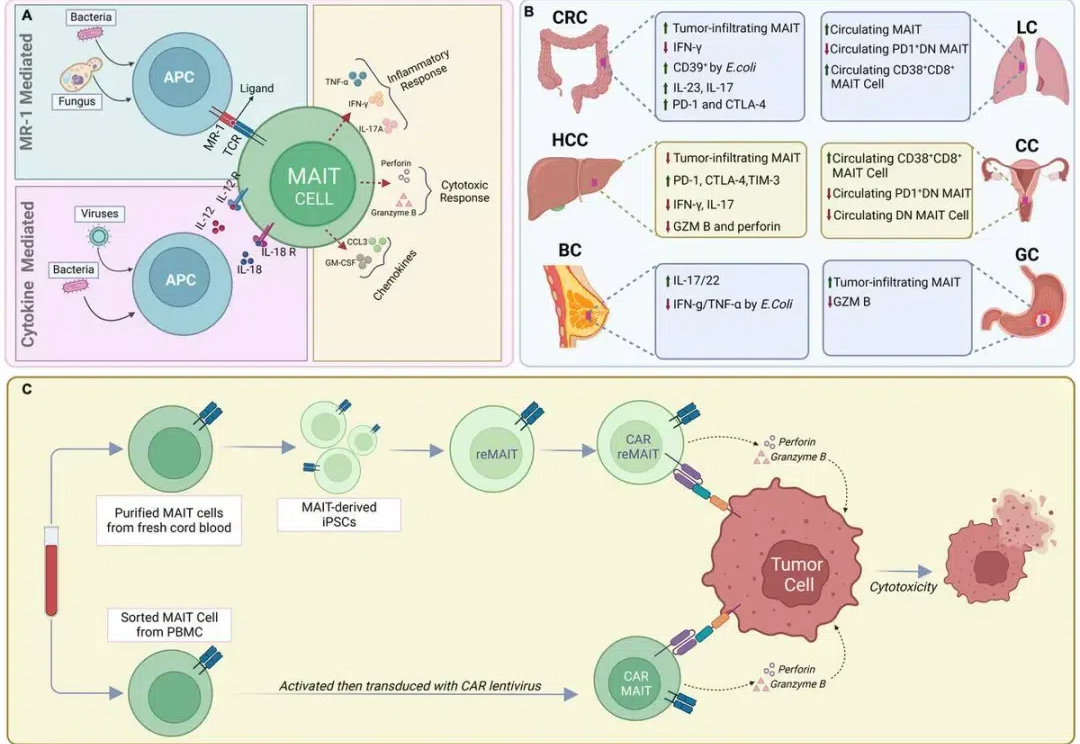

今天想跟大家聊一个科技圈和生物医学圈都值得关注的“炸裂”事件。一位顶尖的免疫学专家,Derya Unutmaz博士,刚刚分享了一段让他“震撼到情绪激动”的经历:他把自己和学生撰写的关于MAIT细胞的综述文章,交给o1-Pro进行评估,结果AI给出的评论和洞察碾压了他

就在OpenAI热闹的12天发布会刚刚落下帷幕,谷歌的火力全开新模型Voe2和Gemnini2吸引了全球AI开发者的眼球时,Meta作为三巨头之一则在筹划着一场静悄悄的革命。

1822 年,电学之父法拉第在日记中写到“既然通电能够产生磁力,为什么不能用磁铁产生电流呢?我一定要反过来试试!”。于是在 1831 年,第一台发电机被发明,推动了人类进入电气化时代。

最近,类 o1 模型的出现,验证了长思维链 (CoT) 在数学和编码等推理任务中的有效性。在长思考(long thought)的帮助下,LLM 倾向于探索、反思和自我改进推理过程,以获得更准确的答案。

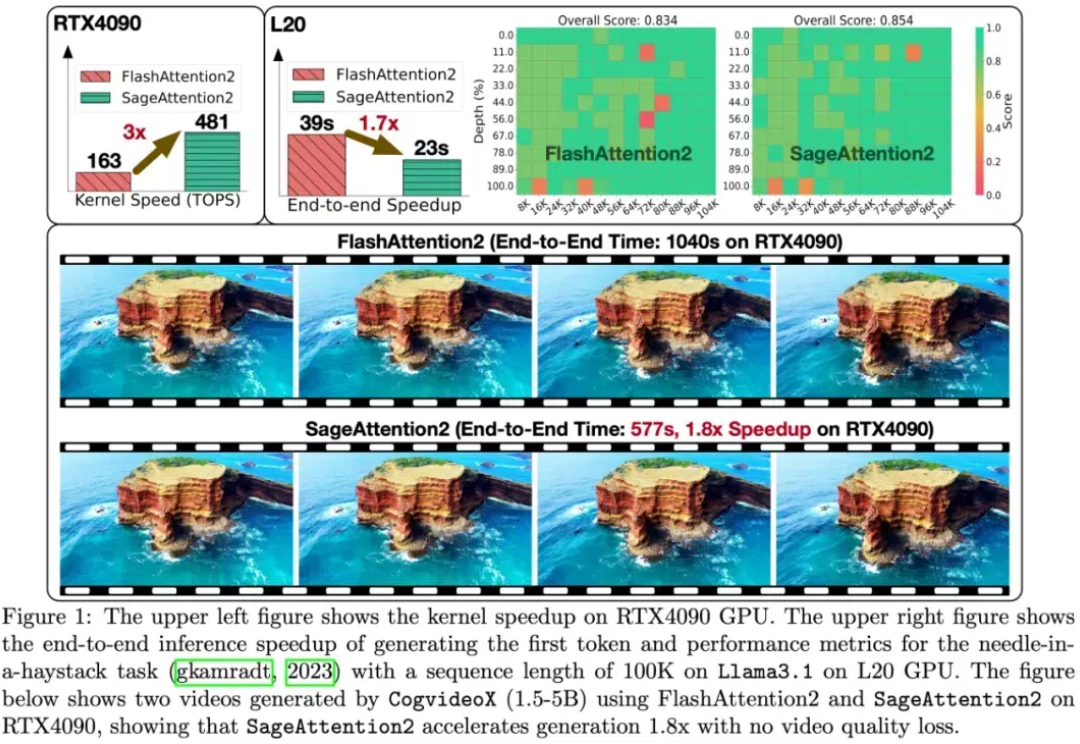

大模型中,线性层的低比特量化已经逐步落地。然而,对于注意力模块,目前几乎各个模型都还在用高精度(例如 FP16 或 FP32)的注意力运算进行训练和推理。并且,随着大型模型需要处理的序列长度不断增加,Attention(注意力运算)的时间开销逐渐成为主要开销。

Sora、Genie等模型会都用到的Tokenizer,微软下手了—— 开源了一套全能的Video Tokenizer,名为VidTok。

无需额外模型训练、即插即用,全新的视频生成增强算法——Enhance-A-Video来了!

2024年,AI Agent称得上最火热的概念。一方面,大模型赛道降温,并呈现出赢家通吃的局面;另一方面,AI Agent则是大模型应用落地的最佳形式,其能够解决LLMs在具体应用场景中的局限性。

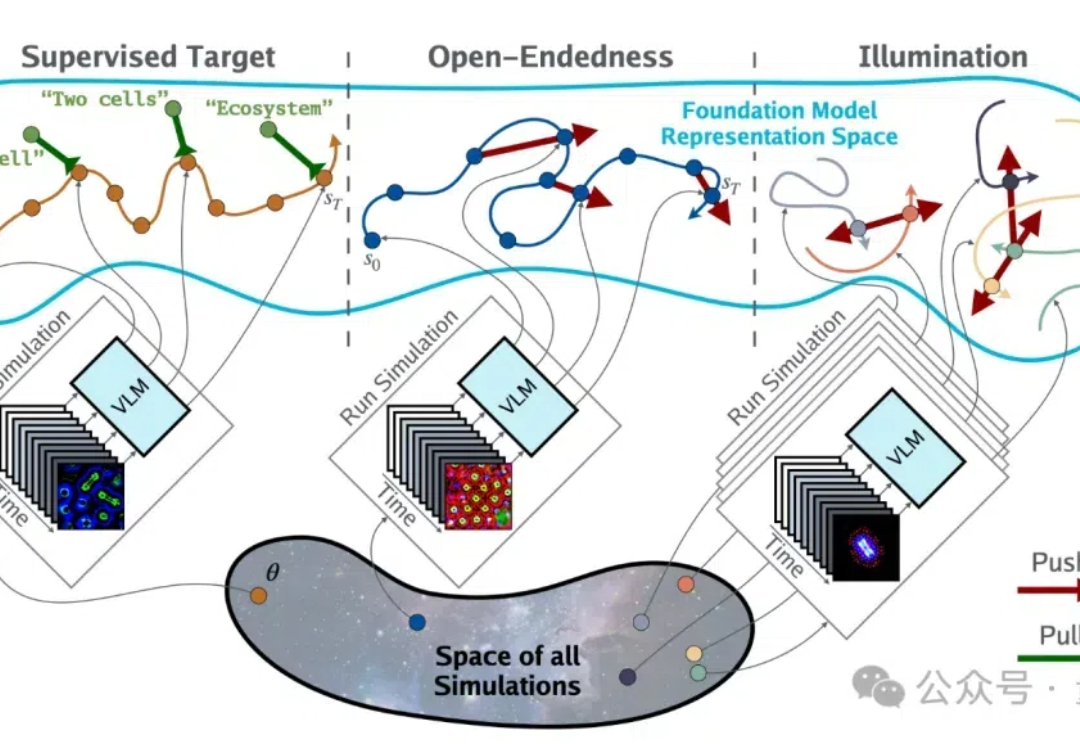

Sakana AI联合MIT、OpenAI等机构提出了全新算法,自动搜索人工生命再达新的里程碑!不需要繁琐手工设计,只通过描述,AI就能发现全新的人造生命体了。

智源最新研究成果BAAIWorm天宝,成功登上Nature子刊封面。它首次实现了秀丽线虫神经系统、身体与环境的闭环仿真,不仅填补生物智能模拟领域空白,还为具身智能发展和AI实际应用开辟了全新路径。

大模型版生命游戏来了。

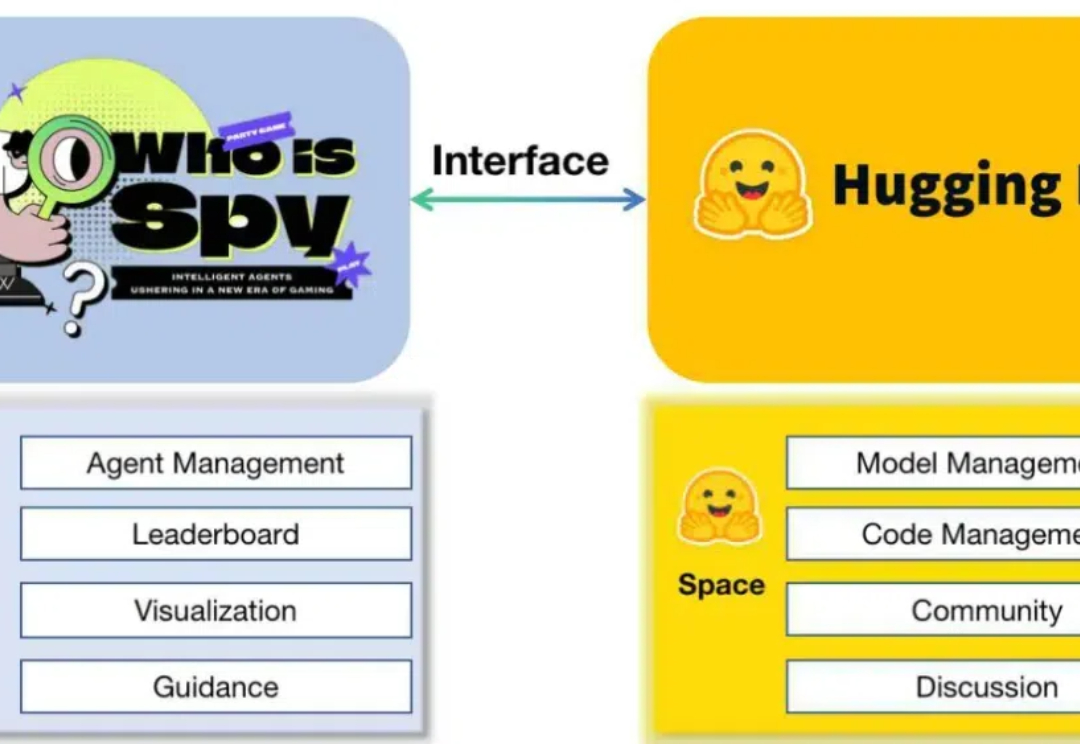

近年来,基于大型语言模型(LLMs)的多智能体系统(MAS)已成为人工智能领域的研究热点。

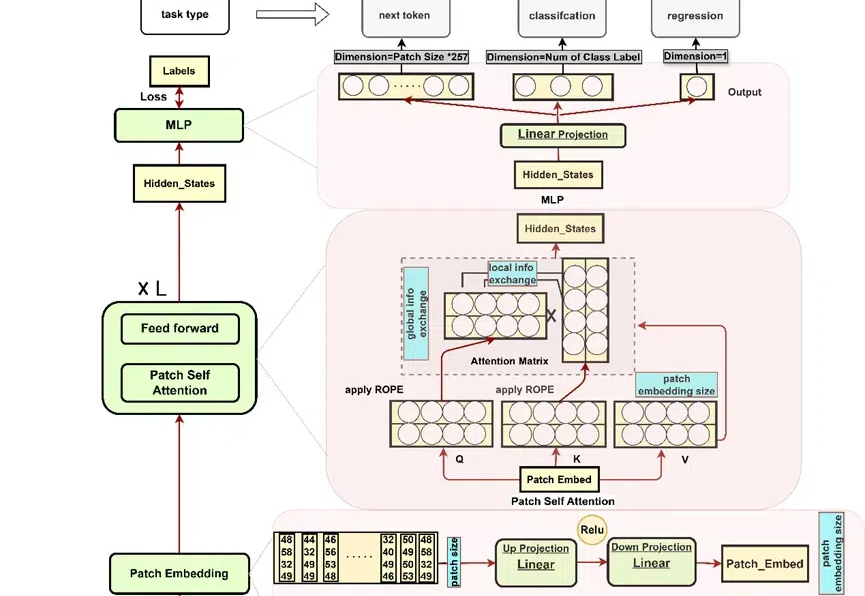

近些年来,以 Stable Diffusion 为代表的扩散模型为文生图(T2I)任务树立了新的标准,PixArt,LUMINA,Hunyuan-DiT 以及 Sana 等工作进一步提高了图像生成的质量和效率。然而,目前的这些文生图(T2I)扩散模型受限于模型尺寸和运行时间,仍然很难直接部署到移动设备上。

大语言模型能否解决传统大语言模型在大规模数值数据分析中的局限性问题,助力科学界大科学装置设计、高能物理领域科学计算?

想象这样一个场景:深夜 11 点,你已经忙碌了一天,正准备休息,却想起明天早上还得分享一篇经典论文《Attention Is All You Need》,需要准备幻灯片。这时,你突然想到了自己的 AI 助手 —— PC Agent。

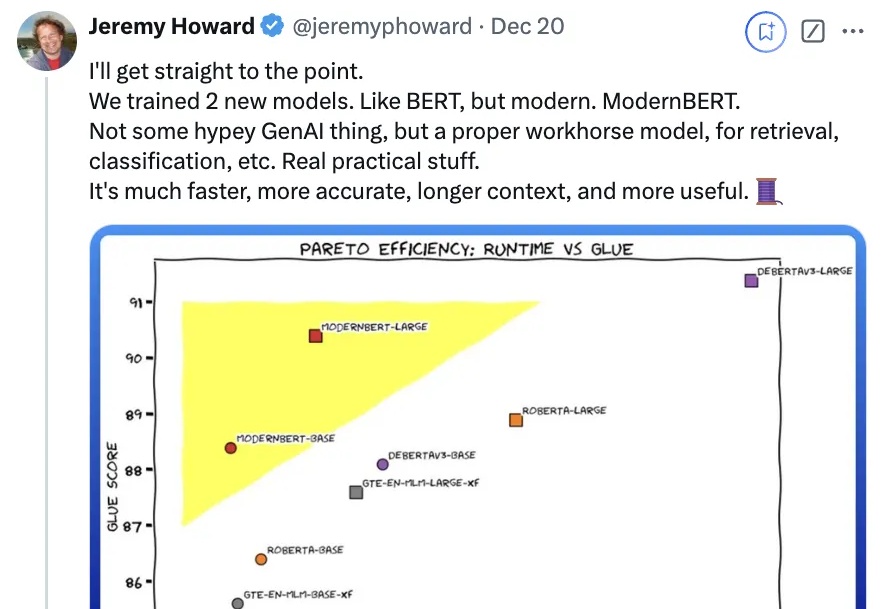

时隔6年,一度被认为濒死的“BERT”杀回来了——